(1)决策树ID3算法的信息论基础

熵在物理学中是度量分子运动的不确定性,分子运动不确定性越大熵越大。而在信息论中,熵度量事件的不确定性,越不确定的事件,熵越大。

离散随机变量X的熵: H ( X ) = − ∑ i = 1 n p i l o g p i H(X)=-\displaystyle\sum_{i=1}^{n}p_ilogp_i H(X)=−i=1∑npilogpi,其中n是离散随机变量的n种不同离散值, p i p_i pi是X取值为i时的概率,log时以2或者e为底的对数。

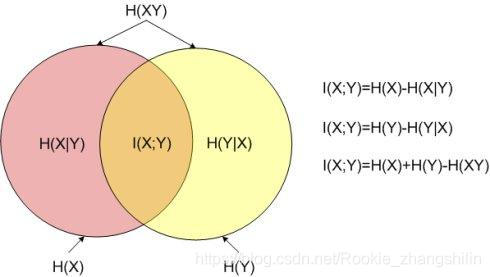

两个变量X和Y的联合熵: H ( X , Y ) = − ∑ i = 1 n p ( x i , y i ) l o g p ( x i , y i ) H(X,Y)=-\displaystyle\sum_{i=1}^{n}p(x_i,y_i)logp(x_i,y_i) H(X,Y)=−i=1∑np(xi,yi)logp(xi,yi)

两个变量X和Y的条件熵: H ( X ∣ Y ) = − ∑ i = 1 n p ( x i , y i ) l o g p ( x i ∣ y i ) = ∑ j = 1 n p ( y j ) H ( X ∣ y j ) H(X|Y)=-\displaystyle\sum_{i=1}^{n}p(x_i,y_i)logp(x_i|y_i)=\displaystyle\sum_{j=1}^{n}p(y_j)H(X|y_j) H(X∣Y)=−i=1∑np(xi,yi)logp(xi∣yi)=j=1∑np(yj)H(X∣yj)

互信息: I ( X , Y ) = H ( X ) − H ( X ∣ Y ) I(X,Y)=H(X)-H(X|Y) I(X,Y)=H(X)−H(X∣Y),意义是在确定变量Y的条件下,变量X不确定性减少的程度。

互信息在ID3中称为信息增益,可用来判断当前节点应用什么特征构建决策树,信息增益越大越适合分类。

知识补充点:

信息论中条件熵H(X|Y)的定义是Y给定条件下,X条件概率分布的熵对Y的数学期望,即

H ( X ∣ Y ) = p ( Y = y i ) H ( X ∣ Y = y i ) = ∑ y i ∈ Y p ( y i ) H (

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2177

2177

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?