安装时的常见问题及注意事项:

1. 一定要使用默认路径, 官方给出的说明要求是一定要用默认路径,且路径中不能带空格。若有空格的情况下,模型的编译和创建过程中有可能出现异常

2. 安装过程中全程梯子,无需多言,且梯子速度越快效率越高

3. 安装时不显示Llama模型

在安装选项中不显示Llama模型,无论是Option选择中,还是安装完成的界面中都没有显示Llama模块

原因时由于Llama模型的默认显存要求是15G,当显卡显存(无论RTX任何型号)未达到时,都在系统检查的时候就自动过滤掉了Llama模型

解决办法:

安装文件目录/ChatWithRTX_Offline_2_11_mistral_Llama\RAG\llama13b.nvi 用记事本打开,找到MinSupportedVRAMSize,将value改成7

然后重新运行安装程序就可以看到Llama模型

4. Chat With RTX模型可以安装成功,但是Mistral 7B INT4模型总是安装失败。

根据国外网友的若干经验推荐,安装过程中要关闭一切杀毒软件,包括Windows自带的“病毒和威胁防护”

5. Llama模型安装失败,同时Mistral模型无法进入安装过程

解决办法:

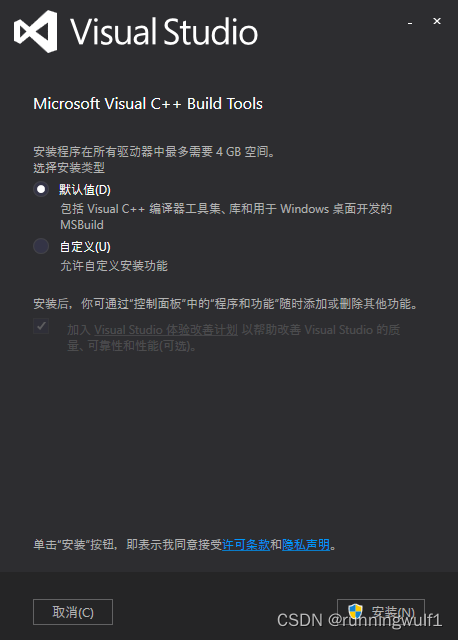

尝试1: 安装Visual C++ build tools,下载链接,此为在线安装包,下载运行后:

但在线安装一直有问题,有梯子也下不来安装包。

离线下载。

下载地址:链接:https://pan.baidu.com/s/1sZhuLOPC9nHOcRH6Or2LWA 提取码:z12e

最后的经验,多装几遍,碰碰运气

或者耐心等待NVIDIA发布更新稳定后的版本。

1772

1772

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?