Give Me Your Attention:

Dot-Product Attention Considered Harmful for Adversarial Patch Robustness

Lovisotto, Giulio, et al. "Give Me Your Attention: Dot-Product Attention Considered Harmful for Adversarial Patch Robustness." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.

1.abstract

基于注意力的神经架构(例如视觉转换器)正在彻底改变图像识别。它们的主要好处是注意力允许共同推理场景的所有部分。在本文中,作者展示了(缩放的)点积注意力的全局推理如何在面对对抗性补丁攻击时成为主要漏洞的来源。我们提供了对该漏洞的理论理解,并将其与攻击者将所有查询的注意力误导到对抗性补丁控制下的单个密钥令牌的能力联系起来。提出了新的对抗性目标,用于制作明确针对此漏洞的对抗性补丁。展示了所提出的补丁攻击对流行图像分类(ViTs 和 DeiTs)和目标检测模型(DETR)的有效性。作者发现,占输入 0.5% 的对抗性补丁可以导致 ImageNet 上 ViT 的鲁棒精度低至 0%,并将 MS COCO 上的 DETR 的 mAP 降低到 3% 以下。

2.正文

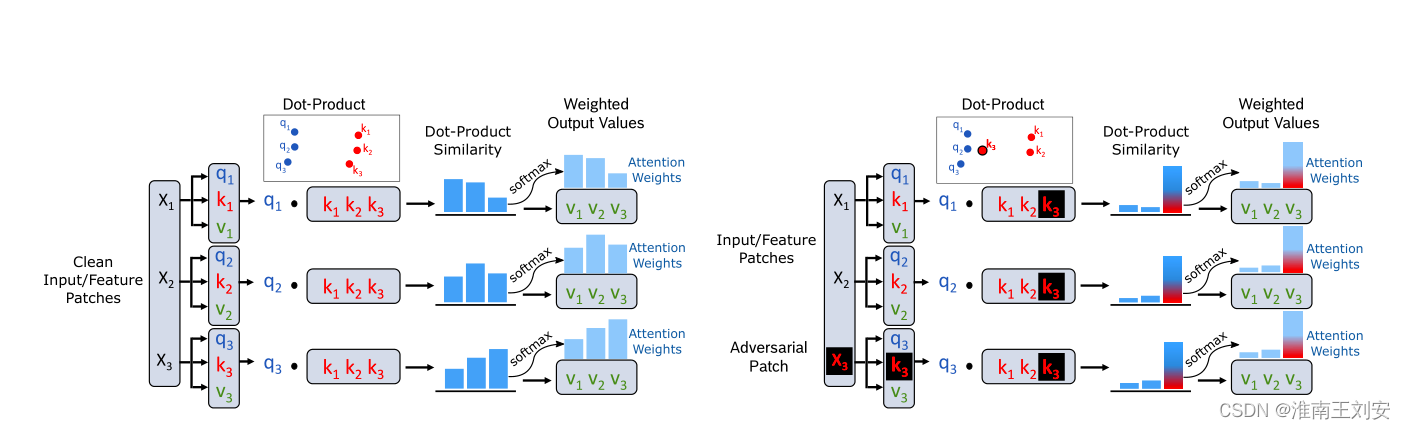

DETR 的干净和对抗性修补输入的比较。该补丁将目标键令牌转移到查询令牌集群(中间列)。对于点积注意力,这有效地将所有查询的注意力引导到恶意令牌上,并防止模型检测到剩余的对象。右列将查询的注意力权重与目标键(用红色框标记)在干净和修补的输入之间进行比较,并突出显示由该对抗键绘制的大注意力权重。

干净(左)和对抗性补丁攻击(右)设置的点积(自我)注意机制示例。这里,q、k 和 v 代表输入特征的投影查询、键和值标记。左:点积注意力计算查询与所有键的点积相似度,稍后使用 softmax 对其进行归一化以获得每个标记的注意力权重。这些与价值标记相乘以控制它们在注意力块中的贡献。右图:Attention-Fool loss 在 X3 处优化输入中的对抗性补丁,以最大化所有查询与键 k3(标记为红色/黑色)的点积相似度,这对应于将 k3 移近查询集群。使用 k3 的查询点积相似度的增加将模型的注意力从图像内容转移到对抗性补丁上。

作者通过论证常用的梯度攻击攻击ViT模型时候,会更关注补丁的内容,不关注对补丁序列的注意力权重,而他们通过实验认为,通过恶意攻击某个关键补丁提供该补丁的点积注意力可以篡改ViT模型的分类结果。

473

473

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?