Tensorflow加载预训练ResNet-50

之所以想搞这个,起因是想实现RCNN。因为电脑配置太差,自己预训练根本跑不起来,百度了解到官方是有提供预训练权重的,开开心心拿来用,特此记录。

一.核心代码

预处理,即预处理特征。我们可以把这个想象为一个黑盒子,我们把图片喂进去,这个盒子帮助我们提取并选择特征,我们把盒子的输出喂给全连接层来得到我们自己的需要的输出。

import tensorflow as tf

import tensorflow.contrib.slim as slim

from tensorflow.contrib.slim.nets import resnet_v1

def resnet(inputs, training):

net, endpoints = resnet_v1.resnet_v1_50(inputs, num_classes=None, is_training=training)

net = tf.squeeze(net, axis=[1, 2])

return net

net = resnet(input_images, training)

final_opt = tf.layers.dense(inputs=net, units=2)

那么为什么调用封装好的模型比我们自己训练要好呢?因为我们通过读取ckpt权重,规定了卷积层的初始化参数。正常训练的时候,我们是随机初始化满足高斯分布或其他分布的参数 ,通过随机梯度下降来更新参数寻求更好的模型效果。而在训练前规定初始化参数,相当于规定了一个大致的更新趋势,让我们的梯度下降收敛更快,也避免了梯度消失或爆炸等问题。

sess = tf.Session()

sess.run(tf.global_variables_initializer())

saver = tf.train.Saver()

variable_restore_op = slim.assign_from_checkpoint_fn('model/resnet_v1_50.ckpt',

slim.get_trainable_variables(),

ignore_missing_vars=True)# 一定要设置为True

variable_restore_op(sess)

二.问题总结

主要遇到了两个问题:

1.训练时正确率很快达到90%+,测试结果全部归为一类

经查阅,主要从以下几方面排查问题:

数据和标签是否匹配:

如果两者不匹配,网络根本不会收敛,但很明显网络有在收敛,只是学习发生了错误,所以此项排除。

梯度是否成功回传:

由于调用的都是封装好的函数,所以这个问题可能性很小,为确保不是,我在cifar-10数据集上跑了一下本模型,发现效果正常,所以此项排除。

调整参数,如learning_rate,batch_size:

调整后,仍很快达到90%+,且由于电脑性能不够,不能尝试更高的批次大小,此项排除。

数据是否不均衡,一个batch内是否都是一个类别:

猫狗均为12500张,数据肯定是均衡的。而二分类问题,由于数据未打乱或不够散,很容易发生一个batch都是一个类别的情况。改变数据喂入策略,对于一个batch(batch_size为64),拿出32张猫和32张狗,将这64张图片打乱后喂入。训练开始,正确率从50%开始稳步上升,问题解决了。

注:测试集也需要打乱,否则正确率仍不能有效的上升。

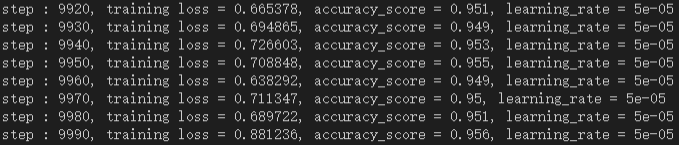

训练结果如下:

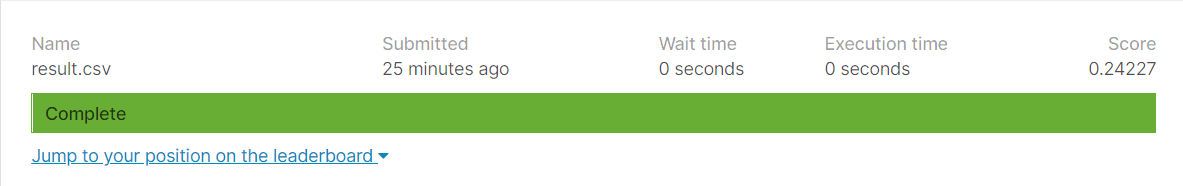

提交Kaggle评测得分如下:

(要求提交的是预测为狗的概率,所以Score为误差)

2.加载预训练模型报missing警告

问题出在这两段代码上:

# with slim.arg_scope(resnet_utils.resnet_arg_scope()):

net = resnet(input_images, training)

print(net.shape)

variable_restore_op = slim.assign_from_checkpoint_fn('model/resnet_v1_50.ckpt',

slim.get_trainable_variables(),

ignore_missing_vars=True)

是否加with那一行决定了是否会报警告,经查阅,加上with这一行代表加载所有权重里的参数,或者我们自己重写scope,则可以加载我们想要的参数。但是我们的模型是不需要那么多参数的,因此我们设置ignore_missing_vars=True,忽略缺失的参数,模型效果反而会更好,这也是为什么这个参数要设置为True的原因。

三.网络结构

X = tf.placeholder(tf.float32, shape = [None, input_size], name='x')

Y = tf.placeholder(tf.float32, shape = [None, num_classes], name='y')

training = tf.placeholder(tf.bool, name="training")

keep_prob = tf.placeholder(tf.float32, name="keep_prob")

input_images = tf.reshape(X, [-1, 112, 112, 3])

input_images = tf.image.per_image_standardization(input_images)

# with slim.arg_scope(resnet_utils.resnet_arg_scope()):

net = resnet(input_images, training)

print(net.shape)

net = tf.layers.dropout(inputs=net, rate=keep_prob)

final_opt = tf.layers.dense(inputs=net, units=2)

tf.add_to_collection('pred_network', final_opt)

print(net.shape)

print(final_opt.shape)

# 学习率衰减

global_step = tf.Variable(0, trainable=False)

boundaries = [2000, 4000, 6000, 8000]

values = [0.005, 0.001, 0.0005, 0.0001, 0.00005]

learning_rate = tf.train.piecewise_constant(global_step, boundaries, values)

# 对输出层计算交叉熵损失

loss = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(labels=Y, logits=final_opt))

l2_loss = weight_decay * tf.add_n([tf.nn.l2_loss(tf.cast(v, tf.float32)) for v in tf.trainable_variables()])

tf.summary.scalar('l2_loss', l2_loss)

loss = loss + l2_loss

# 定义优化器

optimizer = tf.train.MomentumOptimizer(learning_rate=learning_rate, momentum=0.9)

# optimizer = tf.train.AdamOptimizer(learning_rate=0.002)

update_ops = tf.get_collection(tf.GraphKeys.UPDATE_OPS)

with tf.control_dependencies(update_ops):

opt = optimizer.minimize(loss, global_step=global_step)

sess = tf.Session()

sess.run(tf.global_variables_initializer())

saver = tf.train.Saver()

variable_restore_op = slim.assign_from_checkpoint_fn('model/resnet_v1_50.ckpt',

slim.get_trainable_variables(),

ignore_missing_vars=True)

variable_restore_op(sess)

参考资料如下:

872

872

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?