Hadoop

Hadoop3.x在centos上的完全分布式部署(包括免密登录、集群测试、历史服务器、日志聚集、常用命令、群起脚本)

1. 环境准备

- 三台虚拟机,

192.168.68.101、192.168.68.102、192.168.68.103《win10下VMware15安装CentOS7虚拟机》 - JDK(自行准备)

- hadoop安装包(官网下载地址:https://hadoop.apache.org/releases.html)

2. 创建用户

1.创建hadoop用户,并修改hadoop用户的密码

[root@localhost hadoop-3.3.1]# useradd hadoop

[root@localhost hadoop-3.3.1]# passwd hadoop

2.vim /etc/sudoers配置 hadoop 用户具有 root 权限,方便后期加 sudo 执行 root 权限的命令,在 %whieel 这行下面添加一行,如下所示:

%wheel ALL=(ALL) ALL

hadoop ALL=(ALL) ALL

3.修改/data目录所有者和所属组

chown -R hadoop:hadoop /data/

4.三台虚拟机依次添加地址映射

vim /etc/hosts

将下面三行加入文件末尾

192.168.68.101 hadoop1

192.168.68.102 hadoop2

192.168.68.103 hadoop3

5.关闭防火墙(生产不能这么搞,生产开通几个指定端口即可)

firewall-cmd --state #查看防火墙状态

systemctl stop firewalld.service #停止firewalld服务

systemctl disable firewalld.service #开机禁用firewalld服务

3. 免密登录

- 到

/home/hadoop/.ssh/目录下,使用 hadoop 用户执行ssh-keygen -t rsa,然后回车三次,会生成两个文件 id_rsa(私钥)、id_rsa.pub(公钥) - 执行下面的命令将公钥拷贝到要免密登录的机器上,在另外两台机器上一次重复这两个步骤

ssh-copy-id 192.168.68.101

ssh-copy-id 192.168.68.102

ssh-copy-id 192.168.68.103

3现在三台机器的 hadoop 用户就可以免密登录了,再添加一个192.168.68.101的 root 用户免密登录到另外两台机器,用192.168.68.101的 root 用户,执行下面的命令

cd ~

cd .ssh

ssh-keygen -t rsa

ssh-copy-id 192.168.68.101

ssh-copy-id 192.168.68.102

ssh-copy-id 192.168.68.103

4..ssh文件夹下的文件功能解释

| 文件名 | 功能 |

|---|---|

| known_hosts | 记录ssh访问过计算机的公钥(public key) |

| id_rsa | 生成的私钥 |

| id_rsa.pub | 生成的公钥 |

| authorized_keys | 存放授权过的无密登录服务器公钥 |

4. 安装部署

- 将安装包分别上传到三台虚拟机

- 执行命令

tar -zxvf hadoop-3.3.1.tar.gz -C /data/解压到/data目录下

- 三台虚拟机依次添加环境变量,编辑

/etc/profile文件,添加以下内容,然后source /etc/profile保存,执行hadoop version命令检查是否添加成功

#HADOOP_HOME

export HADOOP_HOME=/data/hadoop-3.3.1

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

4.进入/data/hadoop-3.3.1/etc/hadoop路径,执行命令vim core-site.xml,编辑核心配置文件,添加以下内容:

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- 配置NameNode的URL -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.68.101:8020</value>

</property>

<!-- 指定hadoop数据的存储目录,是hadoop文件系统依赖的基本配置,默认位置在/tmp/{$user}下,是个临时目录,一旦因为断电等外在因素影响,/tmp/${user}下的所有东西都会丢失 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/data/hadoop-3.3.1/data/tmp</value>

</property>

<!-- 配置HDFS网页登录使用的静态用户为hadoop -->

<property>

<name>hadoop.http.staticuser.user</name>

<value>hadoop</value>

</property>

</configuration>

5.执行命令vim hdfs-site.xml,编辑 HDFS 配置文件,添加以下内容:

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- NameNode存储名称空间和事务日志的本地文件系统上的路径 -->

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/hadoop-3.3.1/data/namenode</value>

</property>

<!-- DataNode存储名称空间和事务日志的本地文件系统上的路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/hadoop-3.3.1/data/datanode</value>

</property>

<!-- NameNode web端访问地址-->

<property>

<name>dfs.namenode.http-address</name>

<value>192.168.68.101:9870</value>

</property>

<!-- SecondaryNameNode web端访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>192.168.68.103:9868</value>

</property>

</configuration>

6.执行命令vim yarn-site.xml编辑 YARN 配置文件,添加以下内容:

<?xml version="1.0"?>

<configuration>

<!-- 指定MR走shuffle -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定ResourceManager的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>192.168.68.102</value>

</property>

<!-- 为每个容器请求分配的最小内存限制资源管理器(512M) -->

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>512</value>

</property>

<!-- 为每个容器请求分配的最大内存限制资源管理器(4G) -->

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>4096</value>

</property>

<!-- 虚拟内存比例,默认为2.1,此处设置为4倍 -->

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>4</value>

</property>

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

</configuration>

7.执行命令vim mapred-site.xml编辑 MapReduce 配置文件,添加以下内容:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- 执行MapReduce的方式:yarn/local -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

8.在/data/hadoop-3.3.1/etc/hadoop路径下,执行命令vim workers配置 workers(注意:该文件中添加的内容结尾不允许有空格,文件中不允许有空行)

192.168.68.101

192.168.68.102

192.168.68.103

9.创建对应目录

mkdir /data/hadoop-3.3.1/data/datanode

mkdir /data/hadoop-3.3.1/data/tmp

10.执行以下命令将配置好的 hadoop 安装包分发到另外两台机器

scp -r hadoop-3.3.1 root@192.168.68.102:/data/

scp -r hadoop-3.3.1 root@192.168.68.103:/data/

11.集群第一次启动,需要在主节点格式化 NameNode(均使用 hadoop 用户)(**注意:**格式化 NameNode,会产生新的集群 id,导致 NameNode 和 DataNode 的集群 id 不一致,集群找不到已往数据。如果集群在运行过程中报错,需要重新格式化 NameNode 的话,一定要先停止 namenode 和 datanode 进程,并且要删除所有机器的 data 和 logs 目录,然后再进行格式化)

hdfs namenode -format

12.使用 hadoop 用户启动 HDFS

sbin/start-dfs.sh

13.在192.168.68.102上启动 YARN

sbin/start-yarn.sh

14.jps查看三台虚拟机的服务进程是否如下表所示

| 192.168.68.101 | 192.168.68.102 | 192.168.68.103 | |

|---|---|---|---|

| HDFS | NameNode DataNode | DataNode | SecondaryNameNode DataNode |

| Yarn | NodeManager | ResourceManager NodeManager | NodeManager |

15.Web 端查看 HDFS 的 NameNode(可以在Utilities=>Browse the file system查看 HDFS 目录结构)

16.Web 端查看 YARN 的 ResourceManager

5. 集群基本测试

- 上传文件到集群

[hadoop@localhost hadoop-3.3.1]$ hadoop fs -mkdir /input

[hadoop@localhost hadoop-3.3.1]$ hadoop fs -put /data/input/1.txt /input

2.前往 HDFS 文件存储路径,查看 HDFS 在磁盘存储文件的内容

[hadoop@localhost subdir0]$ pwd

/data/hadoop-3.3.1/data/dfs/data/current/BP-503073314-127.0.0.1-1641801366580/current/finalized/subdir0/subdir0

[hadoop@localhost subdir0]$ ls

blk_1073741825 blk_1073741825_1001.meta

[hadoop@localhost subdir0]$ cat blk_1073741825

hello hadoop

stream data

flink spark

3.下载文件

[hadoop@localhost hadoop-3.3.1]$ hadoop fs -get /input/1.txt /data/output/

[hadoop@localhost hadoop-3.3.1]$ ls /data/output/

1.txt

[hadoop@localhost hadoop-3.3.1]$ cat /data/output/1.txt

hello hadoop

stream data

flink spark

4.执行 wordcount 程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar wordcount /input /output

-----------------------------------------------------------------------------------------------------------

查看/output/下的文件内容(windows浏览器web页面拉取文件查看时,需在C:\Windows\System32\drivers\etc\hosts中添加 2.4 节说过的地址映射)

data 1

flink 1

hadoop 1

hello 1

spark 1

stream 1

5.计算圆周率(计算命令中 2 表示计算的线程数,50 表示投点数,该值越大,则计算的 pi 值越准确)

yarn jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar pi 2 50

-----------------------------------------------------------------------------------------------------------

Job Finished in 23.948 seconds

Estimated value of Pi is 3.20000000000000000000

6. 配置历史服务器

为了查看程序的历史运行情况,需要配置一下历史服务器。具体配置步骤如下:

vim mapred-site.xml编辑 MapReduce 配置文件,添加以下内容(三台虚拟机均需):

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>192.168.68.101:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>192.168.68.101:19888</value>

</property>

2.在192.168.68.101启动历史服务器

开启:mapred --daemon start historyserver

关闭:mapred --daemon stop historyserver

-----------------------------------------------------------------------------------------------------------

#jps

15299 DataNode

15507 NodeManager

15829 Jps

15769 JobHistoryServer

15132 NameNode

3.查看JobHistory

7. 配置日志的聚集

日志聚集概念:应用运行完成以后,将程序运行日志信息上传到 HDFS 系统上。

日志聚集功能好处:可以方便的查看到程序运行详情,方便开发调试。

vim yarn-site.xml配置 yarn-site.xml,添加下面的内容(三台均需):

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志聚集服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://192.168.68.101:19888/jobhistory/logs</value>

</property>

<!-- 设置日志保留时间为7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

<!-- 配置正在运行中的日志在hdfs上的存放路径 -->

<!--<property>

<name>mapreduce.jobhistory.intermediate-done-dir</name>

<value>/history/done_intermediate</value>

</property>-->

<!-- 配置运行过的日志存放在hdfs上的存放路径 -->

<!--<property>

<name>mapreduce.jobhistory.done-dir</name>

<value>/history/done</value>

</property>-->

2.重启服务,执行 wordcount 程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar wordcount /input /output

3.查看日志

8. 集群启动/停止命令总结

- 各个模块分开启动/停止(前提配置ssh)

- 整体启动/停止 HDFS

start-dfs.sh/stop-dfs.sh

2.整体启动/停止 YARN

start-yarn.sh/stop-yarn.sh

- 各个服务组件逐一启动/停止

- 分别启动/停止 HDFS 组件

hdfs --daemon start/stop namenode/datanode/secondarynamenode

2.启动/停止YARN

yarn --daemon start/stop resourcemanager/nodemanager

9. 集群群起脚本

vim myhadoop.sh添加下面内容并保存

#!/bin/bash

if [ $# -lt 1 ]

then

echo "No Args Input..."

exit ;

fi

case $1 in

"start")

echo " =================== 启动 hadoop集群 ==================="

echo " --------------- 启动 hdfs ---------------"

ssh 192.168.68.101 "/data/hadoop-3.3.1/sbin/start-dfs.sh"

echo " --------------- 启动 yarn ---------------"

ssh 192.168.68.102 "/data/hadoop-3.3.1/sbin/start-yarn.sh"

echo " --------------- 启动 historyserver ---------------"

ssh 192.168.68.101 "/data/hadoop-3.3.1/bin/mapred --daemon start historyserver"

;;

"stop")

echo " =================== 关闭 hadoop集群 ==================="

echo " --------------- 关闭 historyserver ---------------"

ssh 192.168.68.101 "/data/hadoop-3.3.1/bin/mapred --daemon stop historyserver"

echo " --------------- 关闭 yarn ---------------"

ssh 192.168.68.102 "/data/hadoop-3.3.1/sbin/stop-yarn.sh"

echo " --------------- 关闭 hdfs ---------------"

ssh 192.168.68.101 "/data/hadoop-3.3.1/sbin/stop-dfs.sh"

;;

*)

echo "Input Args Error..."

;;

esac

2.chmod +x myhadoop.sh赋予脚本执行权限

3.启动/停止集群

10. 常用端口号说明

| 端口名称 | Hadoop2.x | Hadoop3.x |

|---|---|---|

| NameNode内部通信端口 | 8020 / 9000 | 8020 / 9000 / 9820 |

| NameNode HTTP UI | 50070 | 9870 |

| MapReduce查看执行任务端口 | 8088 | 8088 |

| 历史服务器通信端口 | 19888 | 19888 |

Hadoop 详解

1. Hadoop概述

1.1Hadoop是什么

-

Hadoop 是一个由Apache基金会所开发的

分布式系统基础架构 -

主要解决海量数据的

存储和海量数据的分析计算问题 -

广义上来说,Hadoop 通常是指一个更广泛的概念——

Hadoop生态圈

1.2 Hadoop发展简史

Hadoop 是 Apache Lucene 创始人 Doug Cutting 创建的。最早起源于 Nutch,它是 Lucene 的子项目。Nutch 的设计目标是构建一个大型的全网搜索引擎,包括网页抓取、索引、查询等功能,但随着抓取网页数量的增加,遇到了严重的可扩展性问题:如何解决数十亿网页的存储和索引问题。

2003 年 Google 发表了一篇论文为该问题提供了可行的解决方案。论文中描述的是谷歌的产品架构,该架构称为:谷歌分布式文件系统(GFS),可以解决他们在网页爬取和索引过程中产生的超大文件的存储需求。

2004 年 Google 发表论文向全世界介绍了谷歌版的MapReduce系统。

同时期,以谷歌的论文为基础,Nutch 的开发人员完成了相应的开源实现 HDFS 和 MAPREDUCE,并从 Nutch 中剥离成为独立项目 HADOOP,到 2008 年 1 月,HADOOP 成为 Apache 顶级项目,迎来了它的快速发展期。

2006 年 Google 发表了论文是关于BigTable的,这促使了后来的 Hbase 的发展。

因此,Hadoop 及其生态圈的发展离不开 Google 的贡献。

1.2 Hadoop三大发行版本

Hadoop 三大发行版本:Apache、Cloudera、Hortonworks

- 免费开源版本 Apache,

Apache版本是最原始(最基础)的版本,对于入门学习最好——2006年- 优点:拥有全世界的开源贡献者,代码更新迭代版本比较快

- 缺点:版本的升级,版本的维护,版本的兼容性,版本的补丁都可能考虑不太周到

- 免费开源版本HortonWorks,Hortonworks 文档最好,对应产品

HDP(ambari)(Hortonworks 现已被 Cloudera 公司收购,推出新的品牌CDP)——2011年 - 软件收费版本 Cloudera,Cloudera 内部集成了很多大数据框架,对应产品

CDH——2008年- cloudera 主要是美国一家大数据公司在 apache 开源 hadoop 的版本上,通过自己公司内部的各种补丁,实现版本之间的稳定运行,大数据生态圈的各个版本的软件都提供了对应的版本,解决了版本的升级困难,版本兼容性等各种问题

1…Apache Hadoop

官网地址:http://hadoop.apache.org

下载地址:https://hadoop.apache.org/releases.html

2.Cloudera Hadoop

官网地址:https://www.cloudera.com/downloads/cdh

下载地址:https://docs.cloudera.com/documentation/enterprise/6/release-notes/topics/rg_cdh_6_download.html

3.Hortonworks Hadoop

官网地址:https://hortonworks.com/products/data-center/hdp/

下载地址:https://hortonworks.com/downloads/#data-platform

- cloudera 主要是美国一家大数据公司在 apache 开源 hadoop 的版本上,通过自己公司内部的各种补丁,实现版本之间的稳定运行,大数据生态圈的各个版本的软件都提供了对应的版本,解决了版本的升级困难,版本兼容性等各种问题

1.3 Hadoop优势

-

高可靠性: Hadoop 底层维护多个数据副本,所以即使 Hadoop 某个计算元素或存储出现故障,也不会导致数据的丢失。

-

高扩展性: 在集群间分配任务数据,可方便的扩展数以千计的节点。

-

高效性: 在 MapReduce 的思想下,Hadoop 是并行工作的,以加快任务处理速度。

-

高容错性: 能够自动将失败的任务重新分配。

-

成本低:Hadoop 通过普通廉价的机器组成服务器集群来分发以及处理数据,以至于成本很低。

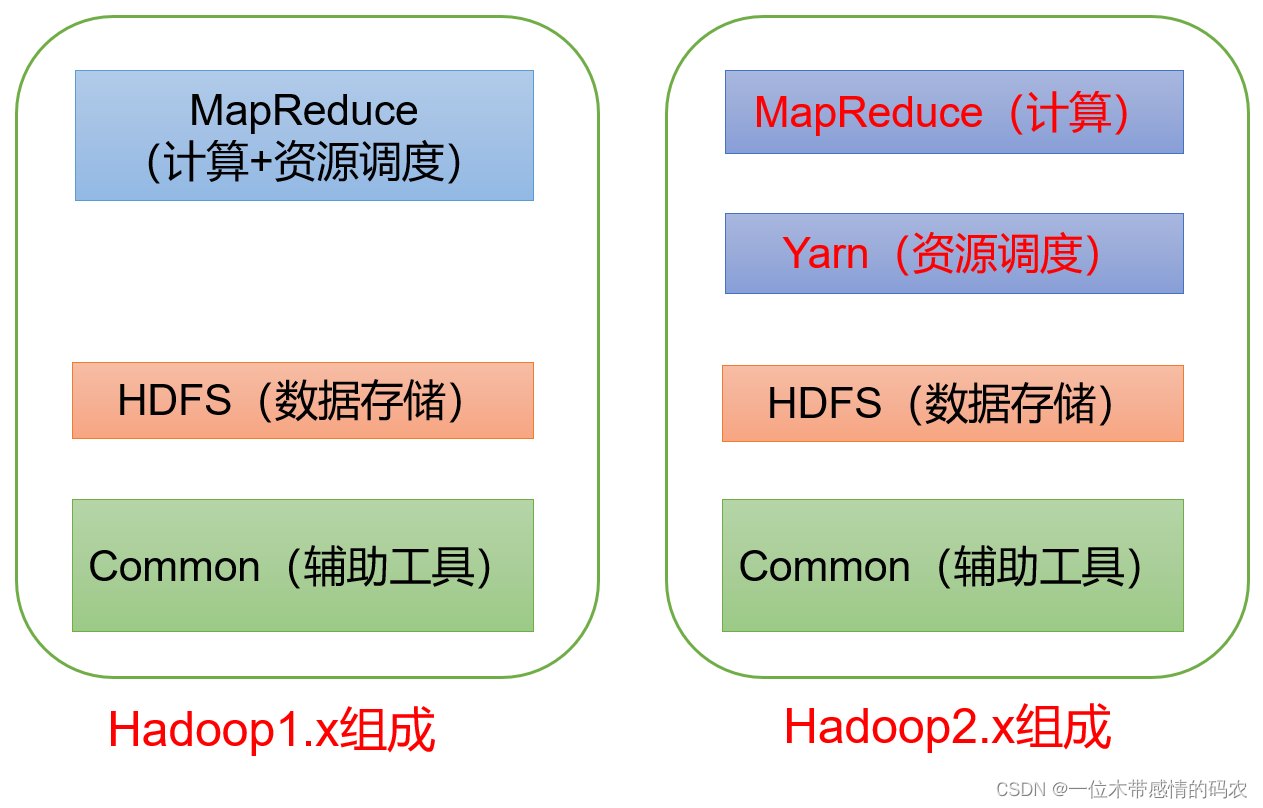

1.4 Hadoop的组成

1.4.1 Hadoop1.x、2.x、3.x区别

在 Hadoop1.x 时代,Hadoop 中的 MapReduce 同时处理业务逻辑运算和资源的调度,耦合性较大。

在 Hadoop2.x 时代,增加了 Yarn。Yarn 只负责资源的调度,MapReduce 只负责运算。

Hadoop3.x 在组成上没有变化(3.x 的新特性后面再开新章节单独说)。

1.4.3 YARN架构概述

Yet Another Resource Negotiator 简称YARN,另一种资源协调者,是Hadoop的资源管理器,用来解决资源任务调度的问题。

1.ResourceManager (RM):整个集群资源(内存、CPU等) 的老大。

2.NodeManager (NM):单个节点服务器资源老大。

3.ApplicationMaster (AM):单个任务运行的老大。

4.Container:容器,相当一台独立的服务器,里面封装了任务运行所需要的资源,如内存、CPU、 磁盘、网络等。

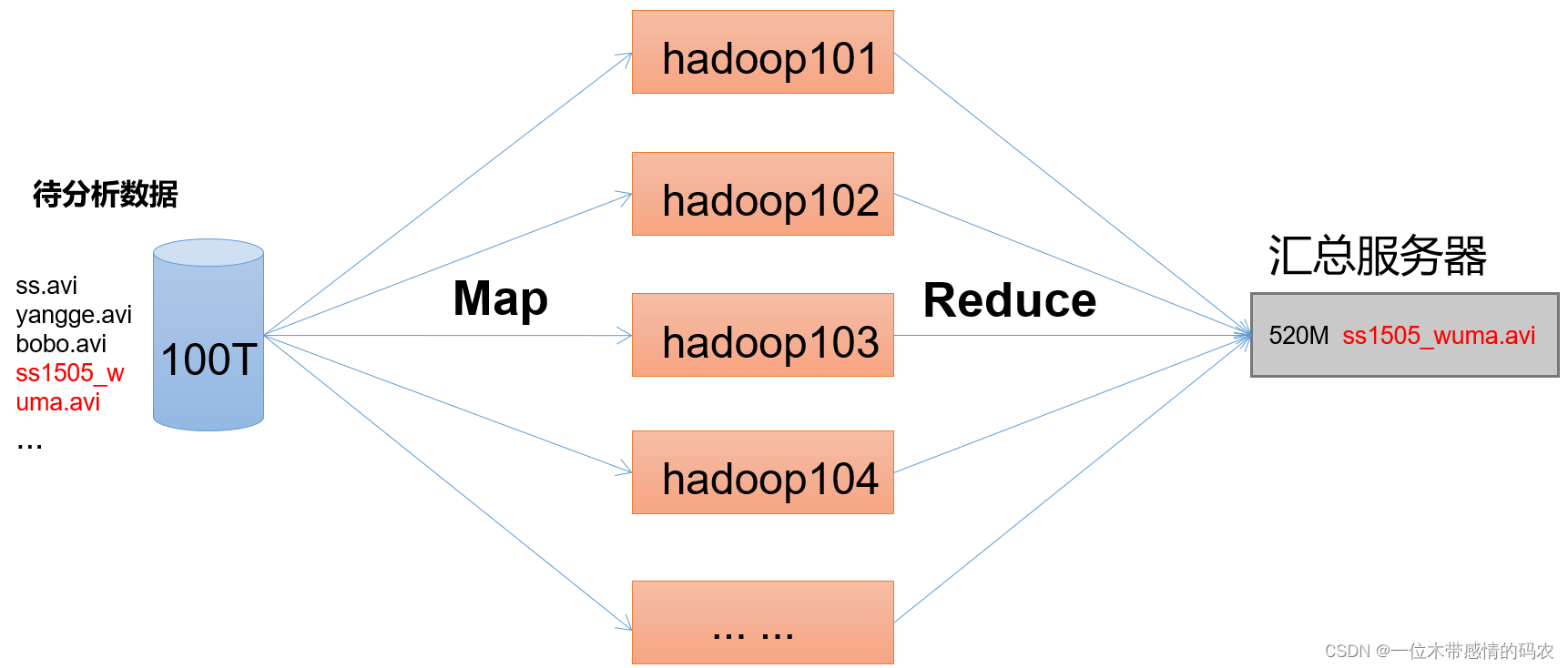

1.4.4 MapReduce架构概述

MapReduce 是一个分布式运算编程框架,将计算过程分为两个阶段:Map 和 Reduce,用来解决海量数据计算的问题。

1.Map 阶段并行处理输入数据。

2.Reduce 阶段对 Map 结果进行汇总。

1.4.5 HDFS、YARN、MapReduce三者关系

当下的 Hadoop 已经成长为一个庞大的体系,随着生态系统的成长,新出现的项目越来越多,其中不乏一些非 Apache 主管的项目,这些项目对 Hadoop 是很好的补充或者更高层的抽象。比如:

| 框架 | 用途 |

|---|---|

| HDFS | 分布式文件系统 |

| MapReduce | 分布式运算程序开发框架 |

| ZooKeeper | 分布式协调服务基础组件 |

| HIVE | 基于HADOOP的分布式数据仓库,提供基于SQL的查询数据操作 |

| FLUME | 日志数据采集框架 |

| oozie | 工作流调度框架 |

| Sqoop | 工作流调度框架 |

| Impala | 基于hive的实时sql查询分析 |

| Mahout | 基于mapreduce/spark/flink等分布式运算框架的机器学习算法库 |

东西比较多,博主后面再慢慢更新这些框架的详细介绍和用法。

1.5 Hadoop运行模式

Hadoop 运行模式包括:本地模式、伪分布式模式以及完全分布式模式。

本地模式(standalone mode): 单机运行,仅 1 个机器运行1个java进程,主要用于调试

伪分布式模式(Pseudo-Distributed mode): 也是单机运行,但是具备 Hadoop 集群的所有功能,一台服务器模拟一个分布式的环境,主要用于调试

完全分布式模式/集群模式(Cluster mode): 多台服务器组成分布式环境,生产环境使用

2.Hadoop的搭建

2.1 集群部署

完全分布式模式部署教程:《Hadoop3.x在centos上的完全分布式部署(包括免密登录、集群测试、历史服务器、日志聚集、常用命令、群起脚本)》

2.2 安装目录结构说明

| 目录 | 说明 |

|---|---|

| bin | Hadoop最基本的管理脚本和使用脚本的目录,这些脚本是sbin目录下管理脚本的基础实现,用户可以直接使用这些脚本管理和使用Hadoop。 |

| etc | Hadoop配置文件所在的目录,包括core-site,xml、hdfs-site.xml、mapred-site.xml等从Hadoop1.0继承而来的配置文件和yarn-site.xml等Hadoop2.0新增的配置文件。 |

| include | 对外提供的编程库头文件(具体动态库和静态库在lib目录中),这些头文件均是用C++定义的,通常用于C++程序访问HDFS或者编写MapReduce程序。 |

| lib | 该目录包含了Hadoop对外提供的编程动态库和静态库,与include目录中的头文件结合使用。 |

| libexec | 各个服务对用的shell配置文件所在的目录,可用于配置日志输出、启动参数(比如JVM参数)等基本信息。 |

| sbin | Hadoop管理脚本所在的目录,主要包含HDFS和YARN中各类服务的启动/关闭脚本。 |

| share | Hadoop各个模块编译后的jar包所在的目录,官方自带示例。 |

2.3 Hadoop配置文件详解

- hadoop-env.sh

- 文件中设置的是 Hadoop 运行时需要的环境变量。JAVA_HOME 是必须设置的,即使我们当前的系统中设置了 JAVA_HOME,它也是不认识的,因为 Hadoop 即使是在本机上执行,它也是把当前的执行环境当成远程服务器。

- core-site.xml

- Hadoop 的核心配置文件,有默认的配置项 core-default.xml。

- core-default.xml 与 core-site.xml 的功能是一样的,如果在 core-site.xml 里没有配置的属性,则会自动会获取 core-default.xml 里的相同属性的值。

- hdfs-site.xml

- HDFS 的核心配置文件,主要配置 HDFS 相关参数,有默认的配置项 hdfs-default.xml。

- hdfs-default.xml 与 hdfs-site.xml 的功能是一样的,如果在 hdfs-site.xml 里没有配置的属性,则会自动会获取 hdfs-default.xml 里的相同属性的值。

- mapred-site.xml

- MapReduce 的核心配置文件,Hadoop 默认只有一个模板文件 mapred-site.xml.template,需要使用该文件复制出来一份 mapred-site.xml 文件

- yarn-site.xml

- YARN 的核心配置文件

- workers

- workers文件里面记录的是集群主机名。一般有以下两种作用:

- 配合一键启动脚本如 start-dfs.sh、stop-yarn.sh 用来进行集群启动。这时候 slaves 文件里面的主机标记的就是从节点角色所在的机器

- 可以配合 hdfs-site.xml 里面 dfs.hosts 属性形成一种白名单机制。dfs.hosts 指定一个文件,其中包含允许连接到 NameNode 的主机列表。必须指定文件的完整路径名,那么所有在 workers中 的主机才可以加入的集群中。如果值为空,则允许所有主机。

- workers文件里面记录的是集群主机名。一般有以下两种作用:

3.HDFS基准测试

实际生产环境当中,Hadoop 的环境搭建完成之后,第一件事情就是进行压力测试,测试 Hadoop 集群的读取和写入速度,测试网络带宽是否足够等一些基准测试。

3.1 测试写入速度

向 HDFS 文件系统中写入数据,10 个文件,每个文件 10MB,文件存放到/benchmarks/TestDFSIO中。

1.执行下面命令,启动写入基准测试

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.3.1-tests.jar TestDFSIO -write -nrFiles 10 -fileSize 10MB

2.MapReduce程序运行成功后,就可以查看测试结果了

可以看到目前虚拟机的 IO 吞吐量为:3.92MB/s

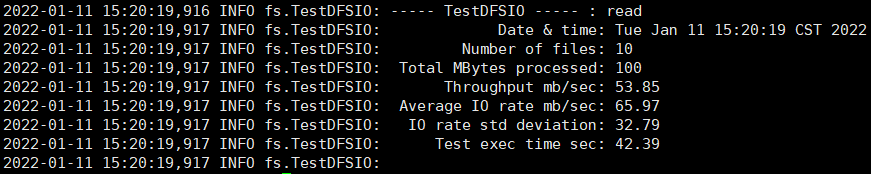

3.2 测试读取速度

测试 HDFS 的读取文件性能,在 HDFS 文件系统中读入 10 个文件,每个文件 10M。

1.执行下面命令,启动读取基准测试

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.3.1-tests.jar TestDFSIO -read -nrFiles 10 -fileSize 10MB

2.查看读取结果

可以看到读取的吞吐量为:53.85MB/s

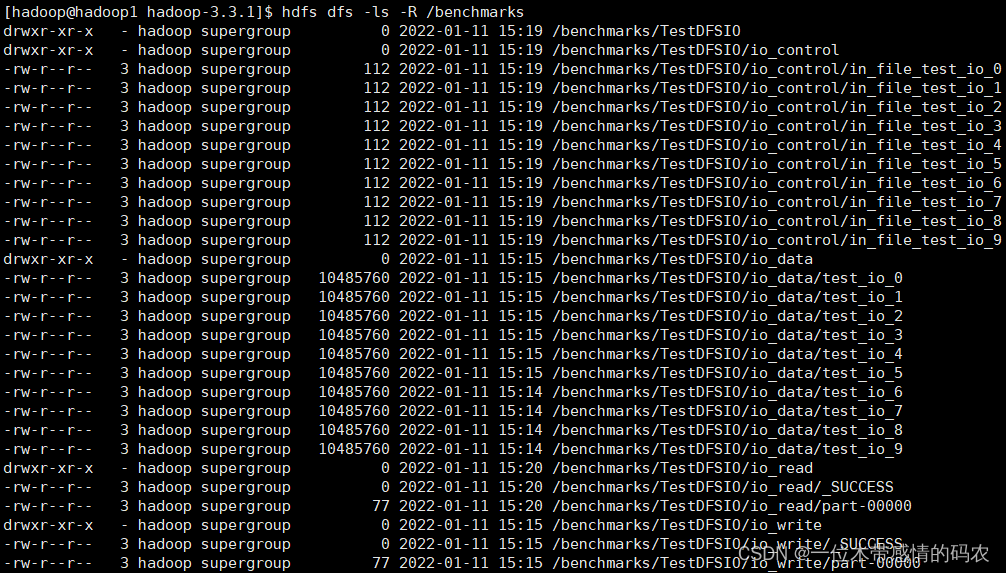

3.3清除测试数据

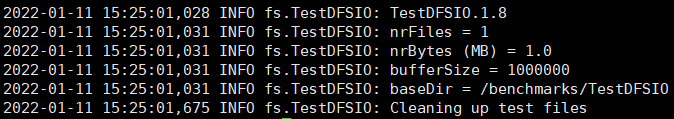

测试期间,会在 HDFS 集群上创建/benchmarks目录,测试完毕后,我们可以清理该目录。

1.hdfs dfs -ls -R /benchmarks

2.执行清理命令

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-3.3.1-tests.jar TestDFSIO -clean

3.删除命令会将/benchmarks目录中内容删除

Hadoop3.x报错[main] DEBUG [org.apache.hadoop.util.Shell] - Failed to find winutils.exe

在写Hadoop生态圈专栏的博客时,打算给自己的电脑装上 hadoop 环境,结果不出意外的报了[main] DEBUG [org.apache.hadoop.util.Shell] - Failed to find winutils.exe的错,这里记录一下,当做笔记使用,防止以后自己再百度。

之所以出现此报错是因为在 windows 环境下缺少 Hadoop 的一些支持,需要下载一些资源配置之后才能使用,下载地址:https://github.com/cdarlint/winutils

网速慢的可以去网盘下载,我这里的 hadoop 版本是 3.3.1

链接:https://pan.baidu.com/s/1XaZPUOo_Qdk4tHzyg4DsTw

提取码:6666

其中winutils.exe文件放在我们自己 hadoop 安装包的bin目录下,如下所示

hadoop.dll文件放在我们的C:\Windows\System32目录下,如下所示

之后重启 IDEA,再次执行程序,就能正常运行了

HDFS 操作详解

1.HDFS概述

1.1 HDFS产生背景及定义

1.1.1 HDFS产生背景

随着数据量越来越大,在一个操作系统存不下所有的数据,那么就分配到更多的操作系统管理的磁盘中,但是不方便管理和维护,迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管理系统。HDFS只是分布式文件管理系统中的一种。

1.1.2 HDFS定义

HDFS(Hadoop Distributed File System),它是一个文件系统,用于存储文件,通过目录树来定位文件;其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

HDFS的使用场景:适合一次写入,多次读出的场景。 一个文件经过创建、写入和关闭之后就不需要改变。

HDFS 主要适合去做批量数据出来,相对于数据请求时的反应时间,HDFS 更倾向于保障吞吐量。

1.1.3 HDFS发展史

1.Doug Cutting 在做 Lucene 的时候, 需要编写一个爬虫服务,这个爬虫写的并不顺利,遇到了一些问题, 诸如:如何存储大规模的数据,如何保证集群的可伸缩性,如何动态容错等。

2.2013 年,Google 发布了三篇论文,被称作为三驾马车,其中有一篇叫做 GFS。

3.GFS 是描述了 Google 内部的一个叫做 GFS 的分布式大规模文件系统,具有强大的可伸缩性和容错性。

4.Doug Cutting 后来根据 GFS 的论文,创造了一个新的文件系统,叫做 HDFS

1.2 HDFS优缺点

- 优点

- 高容错性

- 数据自动保存多个副本。它通过增加副本的形式,提

高容错性。 - 某一个副本丢失后,它可以自动恢复。

- 数据自动保存多个副本。它通过增加副本的形式,提

适合处理大数据- 数据规模:能够处理数据规模达到GB、TB甚至PB级别的数据。

- 文件规模:能够处理百万规模以上的文件数量,数量相当之大。

可构建在廉价机器上,通过多副本机制,提高可靠性。

- 高容错性

- 缺点

不适合处理低延时数据访问,比如毫秒级的存储数据,是做不到的。无法高效的对大量小文件进行存储- 存储大量小文件的话,它会占用 NameNode 大量的内存来存储文件目录和块信息。这样是不可取的,因为 NameNode 的内存总是有限的。

- 小文件存储的寻址时间会超过读取时间,它违反了 HDFS 的设计目标。

不支持并发写入、文件随机修改- 一个文件只能有一个写,不允许多个线程同时写。

- 仅支持数据 append,不支持文件的随机修改。

2.HDFS组成架构

NameNode: Master,它是一个主管、管理者。

管理 HDFS 的名称空间;

配置副本策略;

管理数据块(Block)映射信息;

处理客户端读取请求;

DataNode: Slave,NameNode赋值下达命令,DataNode执行实际的操作。

存储实际的数据块;

执行数据块的读/写操作;

Client: 客户端。

文件切分。文件上传 HDFS 的时候,Client 将文件切分成一个一个的Block,然后进行上传;

与 NameNode 交互,获取文件的位置信息;

与 DataNode 交互,读取或者写入数据;

Client 提供一些命令来管理 HDFS,比如对 NameNode 格式化;

Client 可以通过一些命令来访问 HDFS,比如对 HDFS 增删改查操作;

SecondaryNameNode: 并非 NameNode 的热备,当 NameNode 挂掉的时候,它并不能马上替换 NameNode 并提供服务。

辅助 NameNode,分担其工作量,比如定期合并 Fsimage 和 Edits,并推送给 NameNode;

在紧急情况下,可辅助恢复 NameNode;

3.HDFS的重要特性

3.1 主从架构

HDFS 采用 master/slave 架构。一般一个 HDFS 集群是有一个 Namenode 和一定数目的 Datanode 组成。Namenode是HDFS主节点,Datanode是HDFS从节点,两种角色各司其职,共同协调完成分布式的文件存储服务。

3.2分块机制

HDFS 中的文件在物理上是分块存储(block)的,块的大小可以通过配置参数来规定,参数位于 hdfs-default.xml 中:dfs.blocksize。默认大小在 Hadoop2.x/3.x 是128M(134217728),1.x 版本中是 64M。

3.2.1 HDFS文件块大小设置

HDFS 的块设置太小,会增加寻址时间,程序一直在找块的开始位置;

如果块设置的太大,从磁盘传输数据的时间会明显大于定位这个块开始位置所需的时间,导致程序在处理这块数据时,会非常慢。

总结:HDFS块的大小设置主要取决于磁盘传输速率。

3.3 副本机制

为了容错,文件的所有 block 都会有副本。每个文件的 block 大小(dfs.blocksize)和副本系数(dfs.replication)都是可配置的。应用程序可以指定某个文件的副本数目。副本系数可以在文件创建的时候指定,也可以在之后通过命令改变。

默认dfs.replication的值是3,也就是会额外再复制 2 份,连同本身总共 3 份副本。

3.4 Namespace

HDFS 支持传统的层次型文件组织结构。用户可以创建目录,然后将文件保存在这些目录里。文件系统名字空间的层次结构和大多数现有的文件系统类似:用户可以创建、删除、移动或重命名文件。

Namenode 负责维护文件系统的 namespace 名称空间,任何对文件系统名称空间或属性的修改都将被 Namenode 记录下来。

HDFS 会给客户端提供一个统一的抽象目录树,客户端通过路径来访问文件,形如:hdfs://namenode:port/dir-a/dir-b/dir-c/file.data。

3.5 元数据管理

在 HDFS 中,Namenode 管理的元数据具有两种类型:

文件自身属性信息

文件名称、权限,修改时间,文件大小,复制因子,数据块大小。

文件块位置映射信息

记录文件块和 DataNode 之间的映射信息,即哪个块位于哪个节点上。

3.6 数据块存储

文件的各个 block 的具体存储管理由 DataNode 节点承担。每一个 block 都可以在多个 DataNode 上存储。

4.HDFS的Shell操作

4.1基本语法

hadoop fs 具体命令 OR hdfs dfs 具体命令

4.2 上传

-moveFromLocal:从本地剪切粘贴到 HDFS

hadoop fs -moveFromLocal ./1.txt /test

-copyFromLocal:从本地文件系统中拷贝文件到 HDFS 路径去

hadoop fs -copyFromLocal ./1.txt /test

-put:等同于 copyFromLocal,生产环境更习惯用 put

hadoop fs -put ./1.txt /test

-appendToFile:追加一个文件到已经存在的文件末尾

hadoop fs -appendToFile ./1.txt /test/1.txt

4.3下载

-copyToLocal:从 HDFS 拷贝到本地

hadoop fs -copyToLocal /test/1.txt /output

-get:等同于 copyToLocal,生产环境更习惯用 get

hadoop fs -get /test/1.txt /output

4.4 HDFS直接操作

-

-ls:显示目录信息hadoop fs -ls /test -

-cat:显示文件内容hadoop fs -cat /test/1.txt -

-chgrp、-chmod、-chown:Linux 文件系统中的用法一样,修改文件所属权限hadoop fs -chmod 666 /test/1.txt hadoop fs -chown hadoop:hadoop /test/1.txt -

-mkdir:创建路径hadoop fs -mkdir /test -

-cp:从 HDFS 的一个路径拷贝到 HDFS 的另一个路径

hadoop fs -cp /test1/1.txt /test2

-mv:在 HDFS 目录中移动文件

hadoop fs -mv /test1/1.txt /test2

-tail:显示一个文件的末尾 1kb 的数据

hadoop fs -tail /test/1.txt

-rm:删除文件或文件夹

hadoop fs -rm /test/1.txt

-rm -r:递归删除目录及目录里面内容

hadoop fs -rm -r /test

-du:统计文件夹的大小信息

[hadoop@hadoop1 hadoop-3.3.1]$ hadoop fs -du -s -h /input/1.txt

37 111 /input/1.txt

[hadoop@hadoop1 hadoop-3.3.1]$ hadoop fs -du -h /input

37 111 /input/1.txt

5 15 /input/2.txt

# 37表示文件大小;111表示37*3个副本;/input表示查看的目录

-setrep:设置 HDFS 中文件的副本数量

hadoop fs -setrep 10 /input/1.txt

# 这里设置的副本数只是记录在NameNode的元数据中,是否真的会有这么多副本,还得看DataNode的数量。因为目前只有3台设备,最多也就3个副本,只有节点数的增加到10台时,副本数才能达到10。

5. HDFS的API操作

5.1 HDFS API介绍

涉及的主要类:

- Configuration: 该类的对象封转了客户端或者服务器的配置。

- FileSystem: 该类的对象是一个文件系统对象,可以用该对象的一些方法来对文件进行操作,通过 FileSystem 的静态方法 get 获得该对象。

FileSystem fs = FileSystem.get(conf);

get 方法从 conf 中的一个参数 fs.defaultFS 的配置值判断具体是什么类型的文件系统。如果我们的代码中没有指定 fs.defaultFS,并且工程 classpath 下也没有给定相应的配置,conf 中的默认值就来自于 hadoop 的 jar 包中的 core-default.xml,默认值为:file:///,则获取的将不是一个 DistributedFileSystem 的实例,而是一个本地文件系统的客户端对象。

Java API官方文档:https://hadoop.apache.org/docs/r3.3.1/api/index.html

5.2 环境配置

- 安装包解压在英文路径下

配置环境变量

IDEA 新建Maven项目,加入下面的 pom 依赖

<repositories>

<repository>

<id>cental</id>

<url>http://maven.aliyun.com/nexus/content/groups/public//</url>

<releases>

<enabled>true</enabled>

</releases>

<snapshots>

<enabled>true</enabled>

<updatePolicy>always</updatePolicy>

<checksumPolicy>fail</checksumPolicy>

</snapshots>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>3.3.1</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.1</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>3.3.1</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>3.3.1</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13</version>

</dependency>

<!-- Google Options -->

<dependency>

<groupId>com.github.pcj</groupId>

<artifactId>google-options</artifactId>

<version>1.0.0</version>

</dependency>

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>2.6</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.1</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>3.1.1</version>

<configuration>

</configuration>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<createDependencyReducedPom>false</createDependencyReducedPom>

<shadedArtifactAttached>true</shadedArtifactAttached>

<shadedClassifierName>jar-with-dependencies</shadedClassifierName>

<filters>

<filter>

<artifact>*:*</artifact>

<excludes>

<exclude>META-INF/*.SF</exclude>

<exclude>META-INF/*.DSA</exclude>

<exclude>META-INF/*.RSA</exclude>

</excludes>

</filter>

</filters>

<transformers>

<transformer

implementation="org.apache.maven.plugins.shade.resource.ServicesResourceTransformer"/>

<transformer

implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer">

<mainClass>cn.itcast.sentiment_upload.Entrance</mainClass>

</transformer>

</transformers>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>

在resources下新建log4j.properties,加入下面内容

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

再按照[Hadoop3.x报错[main] DEBUG 该博客教程上传文件即可。

5.3 HDFS创建目录

@Test

public void testMkdirs() throws IOException, URISyntaxException, InterruptedException {

Configuration configuration = new Configuration();

// FileSystem fs = FileSystem.get(new URI("hdfs://hadoop102:8020"), configuration);

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.68.101:8020"), configuration,"hadoop");

// 创建目录

fs.mkdirs(new Path("/hdfsapi"));

// 关闭资源

fs.close();

}

5.4 HDFS文件上传

@Test

public void testCopyFromLocalFile() throws IOException, InterruptedException, URISyntaxException {

// 获取文件系统

Configuration configuration = new Configuration();

configuration.set("dfs.replication", "2");

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.68.101:8020"), configuration, "hadoop");

// 上传文件

fs.copyFromLocalFile(new Path("D:/test.txt"), new Path("/input"));

// 关闭资源

fs.close();

}

5.5 HDFS文件下载

@Test

public void testCopyToLocalFile() throws IOException, InterruptedException, URISyntaxException{

// 获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.68.101:8020"), configuration, "hadoop");

// 执行下载操作

// boolean delSrc 指是否将原文件删除

// Path src 指要下载的文件路径

// Path dst 指将文件下载到的路径

// boolean useRawLocalFileSystem 是否开启文件校验

fs.copyToLocalFile(false, new Path("/input/1.txt"), new Path("D:/1.txt"), true);

// 关闭资源

fs.close();

}

5.6 HDFS文件更名和移动

@Test

public void testRename() throws IOException, InterruptedException, URISyntaxException{

// 获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.68.101:8020"), configuration, "hadoop");

// 修改文件名称

fs.rename(new Path("/input/test.txt"), new Path("/input/test1.txt"));

// 关闭资源

fs.close();

}

5.7 HDFS删除文件和目录

@Test

public void testDelete() throws IOException, InterruptedException, URISyntaxException{

// 获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.68.101:8020"), configuration, "hadoop");

// 执行删除

fs.delete(new Path("/output"), true);

// 关闭资源

fs.close();

}

5.8 HDFS文件详情查看

查看文件名称、权限、长度、块信息。

@Test

public void testListFiles() throws IOException, InterruptedException, URISyntaxException {

// 获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.68.101:8020"), configuration, "hadoop");

// 获取文件详情

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/"), true);

while (listFiles.hasNext()) {

LocatedFileStatus fileStatus = listFiles.next();

System.out.println("========" + fileStatus.getPath() + "=========");

System.out.println(fileStatus.getPermission());

System.out.println(fileStatus.getOwner());

System.out.println(fileStatus.getGroup());

System.out.println(fileStatus.getLen());

System.out.println(fileStatus.getModificationTime());

System.out.println(fileStatus.getReplication());

System.out.println(fileStatus.getBlockSize());

System.out.println(fileStatus.getPath().getName());

// 获取块信息

BlockLocation[] blockLocations = fileStatus.getBlockLocations();

System.out.println(Arrays.toString(blockLocations));

}

// 关闭资源

fs.close();

}

5.9 HDFS文件和文件夹判断

@Test

public void testListStatus() throws IOException, InterruptedException, URISyntaxException{

// 获取文件配置信息

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.68.101:8020"), configuration, "hadoop");

// 判断是文件还是文件夹

FileStatus[] listStatus = fs.listStatus(new Path("/input"));

for (FileStatus fileStatus : listStatus) {

// 如果是文件

if (fileStatus.isFile()) {

System.out.println("f:"+fileStatus.getPath().getName());

}else {

System.out.println("d:"+fileStatus.getPath().getName());

}

}

// 关闭资源

fs.close();

}

HDFS REST HTTP API

见Hadoop生态圈(三)- HDFS REST HTTP API_hdfs rest api-CSDN博客

Hadoop3.3.1编译安装部署教程

见Hadoop 3.1.1 分布式搭建文档

HDFS数据存储与数据管理

1. Hadoop常用文件存储格式

1.1 传统系统常见文件存储格式

在 Windows 有很多种文件格式,例如:JPEG 文件用来存储图片、MP3 文件用来存储音乐、DOC 文件用来存储 WORD 文档。每一种文件存储某一类的数据,例如:我们不会用文本来存储音乐、不会用文本来存储图片。Windows 上支持的存储格式是非常的多。

1.1.1 文件系统块大小

- 在服务器/电脑上,有多种块设备(Block Device),例如:硬盘、CDROM、软盘等等。

- 每个文件系统都需要将一个分区拆分为多个块,用来存储文件。不同的文件系统块大小不同。

例如:我们看到该文件系统的块大小为:4096字节 = 4KB。如果我们需要在磁盘中存储 5 个字节的数据,也会占据 4096 字节的空间。

1.2 Hadoop中文件存储格式

Hadoop 上的文件存储格式,肯定不会像 Windows 这么丰富,因为目前我们用 Hadoop 来存储、处理数据。我们不会用 Hadoop 来听歌、看电影、或者打游戏。

- 文件格式是定义数据文件系统中存储的一种方式,可以在文件中存储各种数据结构,特别是 Row、Map,数组以及字符串,数字等。

- 在 Hadoop 中,没有默认的文件格式,格式的选择取决于其用途。而选择一种优秀、适合的数据存储格式是非常重要的。

- 后续我们要讲的,使用 HDFS 的应用程序(例如 MapReduce 或 Spark、Flink)性能中的最大问题、瓶颈是在特定位置查找数据的时间和写入到另一个位置的时间,而且管理大量数据的处理和存储也很复杂(例如:数据的格式会不断变化,原来一行有 12 列,后面要存储 20 列)。

- Hadoop 文件格式发展了好一段时间,这些文件存储格式可以解决大部分问题。我们在开发大数据中,选择合适的文件格式可能会带来一些明显的好处:

- 可以保证写入的速度

- 可以保证读取的速度

- 文件是可被切分的

- 对压缩支持友好

- 支持schema的更改

- 某些文件格式是为通用设计的(如 MapReduce 或 Spark、Flink),而其他文件则是针对更特定的场景,有些在设计时考虑了特定的数据特征。因此,确实有很多选择。

1.3 BigData File Viewer工具

1.3.1 介绍

- 一个跨平台(Windows,MAC,Linux)桌面应用程序,用于查看常见的大数据二进制格式,例如 Parquet,ORC,AVRO 等。支持本地文件系统,HDFS,AWS S3 等。

**GitHub地址:**https://github.com/Eugene-Mark/bigdata-file-viewer

1.3.2 功能

- 打开并查看本地目录中的Parquet,ORC和AVRO,HDFS,AWS S3等。

- 将二进制格式的数据转换为文本格式的数据,例如CSV

- 支持复杂的数据类型,例如数组,映射,结构等

- 支持Windows,MAC和Linux等多种平台

- 代码可扩展以涉及其他数据格式

1.4 Hadoop丰富的存储格式

1.4.1 Text File

1.4.1.1 简介

- 文本文件在非 Hadoop 领域很常见,在 Hadoop 领域也很常见。

- 数据一行一行到排列,每一行都是一条记录。以典型的 UNIX 方式以换行符

\n终止。 - 文本文件是可以被切分的,但如果对文本文件进行压缩,则必须使用支持切分文件的压缩编解码器,例如 BZIP2。因为这些文件只是文本文件,压缩时会对所有内容进行编码。

- 可以将每一行成为 JSON 文档,可以让数据带有结构。

1.4.1.2 应用场景

仅在需要从 Hadoop 中直接提取数据,或直接从文件中加载大量数据的情况下,才建议使用纯文本格式或 CSV。

1.4.1.3 优缺点

- 优点

- 简单易读、轻量级

- 缺点

- 读写速度慢。

- 不支持块压缩,在 Hadoop 中对文本文件进行压缩/解压缩会有较高的读取成本,因为需要将整个文件全部压缩或者解压缩。

- 无法切分压缩文件(会导致较大的 map task)。

1.4.2 Sequence File

1.4.2.1 简介

- Sequence 最初是为 MapReduce 设计的,因此和 MapReduce 集成很好。

- 在 Sequence File 中,每个数据都是以一个 key 和一个 value 进行序列化存储,仅此而已。

- Sequence File 中的数据是以二进制格式存储,这种格式所需的存储空间小于文本的格式。与文本文件一样,Sequence File 内部也不支持对键和值的结构指定格式编码。

1.4.2.2 应用场景

通常把 Sequence file 作为中间数据存储格式。例如:将大量小文件合并放入到一个 SequenceFIle 中

1.4.2.3 结构

1.4.2.4 优缺点

- 优点

- 与文本文件相比更紧凑,支持块级压缩。

- 压缩文件内容的同时,支持将文件切分。

- 序列文件在 Hadoop 和许多其他支持 HDFS 的项目支持很好,例如:Spark。

- 它是让我们摆脱文本文件迈出第一步。

- 它可以作为大量小文件的容器。

- 与文本文件相比更紧凑,支持块级压缩。

- 缺点

- 对于具有 SQL 类型的 Hive 支持不好,需要读取和解压缩所有字段。

- 不存储元数据,并且对 schema 扩展中的唯一方式是在末尾添加新字段。

1.4.3 Avro File

1.4.3.1 简介

- Apache Avro 是与语言无关的序列化系统,由 Hadoop 创始人 Doug Cutting开发

- Avro 是基于行的存储格式,它在每个文件中都包含 JSON 格式的 schema 定义,从而提高了互操作性并允许 schema 的变化(删除列、添加列)。 除了支持可切分以外,还此次块压缩。

- Avro 是一种自描述格式,它将数据的 schema 直接编码存储在文件中,可以用来存储复杂结构的数据。

- Avro 可以进行快速序列化,生成的序列化数据也比较小。

1.4.3.2 应用场景

- 适合于一次性需要将大量的列(数据比较宽)、写入频繁的场景

- 随着更多存储格式的发展,常用于 Kafka 和 Druid 中

1.4.3.3 结构

直接将一行数据序列化在一个block中

1.4.3.4 优缺点

- 优点

- Avro 是与语言无关的数据序列化系统。

- Avro 将 schema 存储在 header 中,数据是自描述的。

- 序列化和反序列化速度很快。

- Avro 文件是可切分的、可压缩的,非常适合在 Hadoop 生态系统中进行数据存储。

- 缺点

- 如果我们只需要对数据文件中的少数列进行操作,行式存储效率较低。例如:我们读取 15 列中的 2 列数据,基于行式存储就需要读取数百万行的 15 列。而列式存储就会比行式存储方式高效

- 列式存储因为是将同一列(类)的数据存储在一起,压缩率要比方式存储高

1.4.4 RCFile

1.4.4.1 简介

- RCFile 是为基于 MapReduce 的数据仓库系统设计的数据存储结构。它结合了行存储和列存储的优点,可以满足快速数据加载和查询,有效利用存储空间以及适应高负载的需求。

- RCFile 是由二进制键/值对组成的flat文件,它与 sequence file 有很多相似之处。

- 在数仓中执行分析时,这种面向列的存储非常有用。当我们使用面向列的存储类型时,执行分析很容易。

注: 无法将数据直接加载到 RCFile 中。首先需要将数据加载到另一个表中,然后将其覆盖写入到新创建的 RCFile 中。

1.4.4.2 应用场景

- 常用在Hive中

1.4.4.3 结构

- RCFile 可将数据分为几组行,并且在其中将数据存储在列中。

- RCFile 首先将行水平划分为行拆分(Row Group),然后以列方式垂直划分每个行拆分(Columns)。

- RCFile 将行拆分的元数据存储为 record 的 key,并将行拆分的所有数据存储 value。

- 作为行存储,RCFile 保证同一行中的数据位于同一节点中。

- 作为列存储,RCFile 可以利用列数据压缩,并跳过不必要的列读取。

1.4.4.4 优缺点

- 优点

- 基于列式的存储,更好的压缩比。

- 利用元数据存储来支持数据类型。

- 支持 Split。

- 缺点

- RC 不支持 schema 扩展,如果要添加新的列,则必须重写文件,这会降低操作效率。

1.4.5 ORC File

1.4.5.1 简介

- Apache ORC(Optimized Row Columnar,优化行列)是 Apache Hadoop 生态系统面向列的开源数据存储格式,它与 Hadoop 环境中的大多数计算框架兼容。

- ORC 代表“优化行列”,它以比 RC 更为优化的方式存储数据,提供了一种非常有效的方式来存储关系数据,然后存储 RC 文件。

- ORC 将原始数据的大小最多减少 75%,数据处理的速度也提高了。

1.4.5.2 应用场景

- 常用在 Hive 中

1.4.5.3 结构

1.4.5.4 优缺点

- 优点

- 比 TextFile,Sequence File 和 RC File 具备更好的的性能。

- 列数据单独存储。

- 带类型的数据存储格式,使用类型专用的编码器。

- 轻量级索引。

- 缺点

- 与 RC 文件一样,ORC 也是不支持列扩展的。

1.4.6 Parquet File

1.4.6.1 简介

- Parquet File 是另一种列式存储的结构,来自于 Hadoop 的创始人 Doug Cutting 的 Trevni 项目。

- 和 ORCFile 一样,Parquet 也是基于列的二进制存储格式,可以存储嵌套的数据结构。

- 当指定要使用列进行操作时,磁盘输入/输出操效率很高。

- Parquet 与 Cloudera Impala 兼容很好,并做了大量优化。

- 支持块压缩。

- 与 RC 和 ORC 文件不同,Parquet serdes 支持有限的 schema 扩展。在 Parquet 中,可以在结构的末尾添加新列。

关于 Hive 对 Parquet 文件的支持的一个注意事项: Parquet 列名必须小写,这一点非常重要。如果 Parquet 文件包含大小写混合的列名,则 Hive 将无法读取该列。

1.4.6.2 结构

1.4.6.3 优缺点

- 优点

- 和 ORC 文件一样,它非常适合进行压缩,具有出色的查询性能,尤其是从特定列查询数据时,效率很高

- 缺点

- 与 RC 和 ORC 一样,Parquet 也具有压缩和查询性能方面的优点,与非列文件格式相比,写入速度通常较慢。

1.5 Parquet VS ORC

- ORC 文件格式压缩比 parquet 要高,parquet 文件的数据格式 schema 要比 ORC 复杂,占用的空间也就越高。

- ORC 文件格式的读取效率要比 parquet 文件格式高。

- 如果数据中有嵌套结构的数据,则 Parquet 会更好。

- Hive 对 ORC 的支持更好,对 parquet 支持不好,ORC 与 Hive 关联紧密。

- ORC 还可以支持 ACID、Update 操作等。

- Spark 对 parquet 支持较好,对 ORC 支持不好。

- 为了数据能够兼容更多的查询引擎,Parquet 也是一种较好的选择。

1.6 ProtoBuf和Thrift

由于 Protobuf 和 Thrift 是不可 split 的,因此它们在 HDFS 中并不流行。

1.7 扩展:Apache Arrow

1.7.1 Arrow简介

- Apache Arrow 是一个跨语言平台,是一种列式内存数据结构,主要用于构建数据系统。Apache Arrow 在 2016 年 2 月 17 日作为顶级 Apache 项目引入。

- Apache Arrow 发展非常迅速,并且在未来会有更好的发展空间。 它可以在系统之间进行高效且快速的数据交换,而无需进行序列化,而这些成本已与其他系统(例如 Thrift,Avro 和 Protocol Buffers)相关联。

- 每一个系统实现,它的方法(method)都有自己的内存存储格式,在开发中,70%-80%的时间浪费在了序列化和反序列化上。

- Arrow 促进了许多组件之间的通信。 例如,使用Python(pandas)读取复杂的文件并将其转换为Spark DataFrame。

1.7.2 Arrow是如何提升数据移动性能的

- 利用 Arrow 作为内存中数据表示的两个过程可以将数据从一种方法“重定向”到另一种方法,而无需序列化或反序列化。 例如,Spark 可以使用 Python 进程发送 Arrow 数据来执行用户定义的函数。

- 无需进行反序列化,可以直接从启用了 Arrow 的数据存储系统中接收 Arrow 数据。 例如,Kudu 可以将 Arrow 数据直接发送到 Impala 进行分析。

- Arrow 的设计针对嵌套结构化数据(例如在 Impala 或 Spark Data 框架中)的分析性能进行了优化。

2. 文件压缩格式

在 Hadoop 中,一般存储着非常大的文件,以及在存储 HDFS 块或运行 MapReduce 任务时,Hadoop 集群中节点之间的存在大量数据传输。 如果条件允许时,尽量减少文件大小,这将有助于减少存储需求以及减少网络上的数据传输。

2.1 Hadoop支持的压缩算法

Haodop对文件压缩均实现org.apache.hadoop.io.compress.CompressionCodec接口,所有的实现类都在org.apache.hadoop.io.compress包下。

2.1.1 压缩算法比较

有不少的压缩算法可以应用到 Hadoop 中,但不同压缩算法有各自的特点。

| 压缩格式 | 工具 | 算法 | 文件扩展名 | 是否可切分 | 对应的编码/解码器 |

|---|---|---|---|---|---|

| DEFAULT | 无 | DEFAULT | .deflate | 否 | org.apache.hadoop.io.compress.DefaultCodec |

| Gzip | gzip | DEFAULT | .gz | 否 | org.apache.hadoop.io.compress.GzipCodec |

| bzip2 | bzip2 | bzip2 | .bz2 | 是 | org.apache.hadoop.io.compress.BZip2Codec |

| LZO | lzop | LZO | .lzo | 是(索引) | com.hadoop.compression.lzo.LzopCodec |

| LZ4 | 无 | LZ4 | .lz4 | 否 | org.apache.hadoop.io.compress.Lz4Codec |

| Snappy | 无 | Snappy | .snappy | 否 | org.apache.hadoop.io.compress.SnappyCodec |

存放数据到 HDFS 中,可以选择指定的压缩方式,在 MapReduce 程序读取时,会根据扩展名自动解压。例如:如果文件扩展名为.snappy,Hadoop 框架将自动使用 SnappyCodec 解压缩文件。

通过上图,我们可以看到哪些压缩算法压缩比更高。整体排序如下:

Snappy < LZ4 < LZO < GZIP < BZIP2,但压缩比越高,压缩的时间也会更长。以下是部分参考数据:

| 压缩算法 | 压缩后占比 | 压缩 | 解压缩 |

|---|---|---|---|

| GZIP | 13.4% | 21 MB/s | 118 MB/s |

| LZO | 20.5% | 135 MB/s | 410 MB/s |

| Zippy/Snappy | 22.2% | 172 MB/s | 409 MB/s |

2.2 HDFS压缩如何抉择

既然压缩能够节省空间、而且可以提升 IO 效率,那么能否将所有数据都以压缩格式存储在 HDFS 中呢?例如:bzip2,而且文件是支持切分的。

如果选择 GZIP,就会出现以下情况:

- 如果文件是不可切分的,只有一个 CPU 在处理所有的文件,其他的 CPU 都是空闲的。如果 HDFS 中的 block 和文件大小差不多还好,一个文件、一个块、一个 CPU。如果是一个很大的文件就会出现问题了。

- bzip2 在压缩和解压缩数据方面实际上平均比 Gzip 差 3 倍,这对性能是有一定的影响的。如果我们需要频繁地查询数据,数据压缩一定会影响查询效率。

- 如果不关心查询性能(没有任何 SLA)并且很少选择此数据,则 bzip2 可能是不错的选择。最好是对自己的数据进行基准测试,然后再做决定。

3. HDFS存储类型和存储策略

3.1 介绍

- Archive 存储(档案存储)是一种将增长的存储容量与计算容量解耦的解决方案。

- 可以将一些需要存储、但计算需求很少的数据放在低成本的存储节点中,这些节点用于集群中冷数据的存储。

- 根据策略,热数据可以转移到冷节点存储。在冷区域中加入更多的节点可以使存储与集群中的计算容量无关。

- 异构存储和归档存储提供的框架将 HDFS 体系结构概括为包括其他类型的存储介质,包括:SSD 和内存。用户可以选择将数据存储在 SSD 或内存中以获得更好的性能。

3.2 存储类型和存储策略

3.2.1 多种多样的存储类型

大家考虑一个问题:我们可以将数据保存在什么样的存储类型中呢?

- 硬盘

- SSD

- SATA

- 内存

- NAS

3.2.2 速率对比

RAM 比 SSD 快几个数量级。普通的磁盘大致的速度为 30-150MB,比较快的 SSD 可以实现 500MB/秒 的实际写入速度。 RAM 的理论上最大速度可以达到 SSD 实际性能的 30 倍。

以下是一个实际对比图:

3.2.3 存储类型

之前在hdfs-site.xml中配置,是将数据保存在 Linux 中的本地磁盘。

<!-- DataNode存储名称空间和事务日志的本地文件系统上的路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/hadoop-3.3.1/data/datanode</value>

</property>

以上配置跟下面的配置是一样的:

<!-- DataNode存储名称空间和事务日志的本地文件系统上的路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>[DISK]:/data/hadoop-3.3.1/data/datanode</value>

</property>

在 HDFS 中,可以给不同的存储介质分配不同的存储类型:

- DISK:默认的存储类型,磁盘存储。

- ARCHIVE:具有存储密度高(PB级),但计算能力小的特点,可用于支持档案存储。

- SSD:固态硬盘。

- RAM_DISK:DataNode 中的内存空间。

3.2.4 存储策略介绍

HDFS 中提供热、暖、冷、ALL_SSD、One_SSD、Lazy_Persistence 等存储策略。为了根据不同的存储策略将文件存储在不同的存储类型中,引入了一种新的存储策略概念。HDFS 支持以下存储策略:

- 热(hot)

- 用于大量存储和计算。

- 当数据经常被使用,将保留在此策略中。

- 当 block 是 hot 时,所有副本都存储在磁盘中。

- 冷(cold)

- 仅仅用于存储,只有非常有限的一部分数据用于计算。

- 不再使用的数据或需要存档的数据将从热存储转移到冷存储中。

- 当 block 是 cold 时,所有副本都存储在 Archive 中。

- 温(warm)

- 部分热,部分冷。

- 当一个块是 warm 时,它的一些副本存储在磁盘中,其余的副本存储在 Archive 中。

- 全SSD

- 将所有副本存储在 SSD 中。

- 单SSD

- 在 SSD 中存储一个副本,其余的副本存储在磁盘中。

- 懒持久

- 用于编写内存中只有一个副本的块。副本首先写在 RAM_Disk 中,然后惰性地保存在磁盘中。

3.2.5 HDFS中的存储策略

HDFS存储策略由以下字段组成:

- 策略 ID(Policy ID)

- 策略名称(Policy Name)

- 块放置的存储类型列表(Block Placement)

- 用于创建文件的后备存储类型列表(Fallback storages for creation)

- 用于副本的后备存储类型列表(Fallback storages for replication)

当有足够的空间时,块副本将根据 #3 中指定的存储类型列表存储。当列表 #3 中的某些存储类型耗尽时,将分别使用 #4 和 #5 中指定的后备存储类型列表来替换空间外存储类型,以便进行文件创建和副本。

以下是一个典型的存储策略表格:

| Policy ID | Policy Name | Block Placement (n replicas) | Fallback storages for creation | Fallback storages for replication |

|---|---|---|---|---|

| 15 | Lazy_Persist | RAM_DISK: 1, DISK: n-1 | DISK | DISK |

| 12 | All_SSD | SSD: n | DISK | DISK |

| 10 | One_SSD | SSD: 1, DISK: n-1 | SSD, DISK | SSD, DISK |

| 7 | Hot (default) | DISK: n | - | ARCHIVE |

| 5 | Warm | DISK: 1, ARCHIVE: n-1 | ARCHIVE, DISK | ARCHIVE, DISK |

| 2 | Cold | ARCHIVE: n | - | - |

| 1 | Provided | PROVIDED: 1, DISK: n-1 | PROVIDED, DISK | PROVIDED, DISK |

注意事项:

- Lazy_Persistence 策略仅对单个副本块有用。对于具有多个副本的块,所有副本都将被写入磁盘,因为只将一个副本写入 RAM_Disk 并不能提高总体性能。

- 对于带条带的擦除编码文件,合适的存储策略是 ALL_SSD、HOST、CORD。因此,如果用户为 EC 文件设置除上述之外的策略,在创建或移动块时不会遵循该策略。

3.2.6 存储策略方案

- 创建文件或目录时,其存储策略为未指定状态。可以使用:

storagepolicies -setStoragePolicy命令指定 - 文件或目录的有效存储策略由以下规则解析:

- 如果使用存储策略指定了文件或目录,则返回该文件或目录。

- 对于未指定的文件或目录,如果是根目录,则返回默认存储策略。否则,返回其父级的有效存储策略

- 可以使用 storagepolicies –getStoragePolicy 命令获取有效的存储策略。

3.2.7 配置

-

dfs.storage.policy.enabled- 启用/禁用存储策略功能。默认值是 true

-

dfs.datanode.data.dir -

在每个数据节点上,应当用逗号分隔的存储位置标记它们的存储类型。这允许存储策略根据策略将块放置在不同的存储类型上。

注意:

- 磁盘上的 DataNode 存储位置

/grid/dn/disk0应该配置为[DISK]file:///grid/dn/disk0 - SSD 上的 DataNode 存储位置

/grid/dn/ssd0应该配置为[SSD]file:///grid/dn/ssd0 - 存档上的 DataNode 存储位置

/grid/dn/Archive0应该配置为[ARCHIVE]file:///grid/dn/archive0 - 将 RAM_磁盘上的 DataNode 存储位置

/grid/dn/ram0配置为[RAM_DISK]file:///grid/dn/ram0 - 如果 DataNode 存储位置没有显式标记存储类型,它的默认存储类型将是磁盘。

3.3 存储策略命令

3.3.1 列出存储策略

列出所有存储策略命令:

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs storagepolicies -listPolicies

Block Storage Policies:

BlockStoragePolicy{PROVIDED:1, storageTypes=[PROVIDED, DISK], creationFallbacks=[PROVIDED, DISK], replicationFallbacks=[PROVIDED, DISK]}

BlockStoragePolicy{COLD:2, storageTypes=[ARCHIVE], creationFallbacks=[], replicationFallbacks=[]}

BlockStoragePolicy{WARM:5, storageTypes=[DISK, ARCHIVE], creationFallbacks=[DISK, ARCHIVE], replicationFallbacks=[DISK, ARCHIVE]}

BlockStoragePolicy{HOT:7, storageTypes=[DISK], creationFallbacks=[], replicationFallbacks=[ARCHIVE]}

BlockStoragePolicy{ONE_SSD:10, storageTypes=[SSD, DISK], creationFallbacks=[SSD, DISK], replicationFallbacks=[SSD, DISK]}

BlockStoragePolicy{ALL_SSD:12, storageTypes=[SSD], creationFallbacks=[DISK], replicationFallbacks=[DISK]}

BlockStoragePolicy{LAZY_PERSIST:15, storageTypes=[RAM_DISK, DISK], creationFallbacks=[DISK], replicationFallbacks=[DISK]}

123456789

3.3.2 设置存储策略

为一个文件或目录设置存储策略:

hdfs storagepolicies -setStoragePolicy -path <path> -policy <policy>

1

| 参数名 | 说明 |

|---|---|

| -path | 引用目录或文件的路径 |

| -policy | 存储策略的名称 |

3.3.3 取消存储策略

取消文件或目录的存储策略。在执行 unset 命令之后,将应用当前目录最近的祖先存储策略,如果没有任何祖先的策略,则将应用默认的存储策略。

hdfs storagepolicies -unsetStoragePolicy -path <path>

| 参数名 | 说明 |

|---|---|

| -path | 引用目录或文件的路径 |

3.3.4 获取存储策略

获取文件或目录的存储策略:

hdfs storagepolicies -getStoragePolicy -path <path>

| 参数名 | 说明 |

|---|---|

| -path | 引用目录或文件的路径 |

3.4 冷热温三阶段数据存储

为了更加充分的利用存储资源,我们可以将数据分为冷、热、温三个阶段来存储。

| /data/hdfs-test/data_phase/hot | 热阶段数据 |

|---|---|

| /data/hdfs-test/data_phase/warm | 温阶段数据 |

| /data/hdfs-test/data_phase/cold | 冷阶段数据 |

3.4.1 配置DataNode存储目录

为了能够支撑不同类型的数据,我们需要在 hdfs-site.xml 中配置不同存储类型数据的位置。

- 进入到 Hadoop 配置目录,编辑

hdfs-site.xml

<!-- DataNode存储名称空间和事务日志的本地文件系统上的路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>[DISK]file:///data/hadoop-3.3.1/data/datanode,[ARCHIVE]file:///data/hadoop-3.3.1/data/archive</value>

<description></description>

</property>

- 分发到另外两个节点

scp hdfs-site.xml 192.168.68.102:$PWD

scp hdfs-site.xml 192.168.68.103:$PWD

- 重启 HDFS 集群

配置好后,我们在 WebUI 的 Datanodes 页面中点击任意一个 DataNode 节点:

可以看到,现在配置的是两个目录,一个 StorageType 为 ARCHIVE、一个 StorageType 为 DISK。

3.4.2 配置策略

- 创建测试目录结构

hdfs dfs -mkdir -p /data/hdfs-test/data_phase/hot

hdfs dfs -mkdir -p /data/hdfs-test/data_phase/warm

hdfs dfs -mkdir -p /data/hdfs-test/data_phase/cold

123

- 查看当前 HDFS 支持的存储策略

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs storagepolicies -listPolicies

Block Storage Policies:

BlockStoragePolicy{PROVIDED:1, storageTypes=[PROVIDED, DISK], creationFallbacks=[PROVIDED, DISK], replicationFallbacks=[PROVIDED, DISK]}

BlockStoragePolicy{COLD:2, storageTypes=[ARCHIVE], creationFallbacks=[], replicationFallbacks=[]}

BlockStoragePolicy{WARM:5, storageTypes=[DISK, ARCHIVE], creationFallbacks=[DISK, ARCHIVE], replicationFallbacks=[DISK, ARCHIVE]}

BlockStoragePolicy{HOT:7, storageTypes=[DISK], creationFallbacks=[], replicationFallbacks=[ARCHIVE]}

BlockStoragePolicy{ONE_SSD:10, storageTypes=[SSD, DISK], creationFallbacks=[SSD, DISK], replicationFallbacks=[SSD, DISK]}

BlockStoragePolicy{ALL_SSD:12, storageTypes=[SSD], creationFallbacks=[DISK], replicationFallbacks=[DISK]}

BlockStoragePolicy{LAZY_PERSIST:15, storageTypes=[RAM_DISK, DISK], creationFallbacks=[DISK], replicationFallbacks=[DISK]}

- 分别设置三个目录的存储策略

hdfs storagepolicies -setStoragePolicy -path /data/hdfs-test/data_phase/hot -policy HOT

hdfs storagepolicies -setStoragePolicy -path /data/hdfs-test/data_phase/warm -policy WARM

hdfs storagepolicies -setStoragePolicy -path /data/hdfs-test/data_phase/cold -policy COLD

- 查看三个目录的存储策略

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs storagepolicies -getStoragePolicy -path /data/hdfs-test/data_phase/hot

The storage policy of /data/hdfs-test/data_phase/hot:

BlockStoragePolicy{HOT:7, storageTypes=[DISK], creationFallbacks=[], replicationFallbacks=[ARCHIVE]}

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs storagepolicies -getStoragePolicy -path /data/hdfs-test/data_phase/warm

The storage policy of /data/hdfs-test/data_phase/warm:

BlockStoragePolicy{WARM:5, storageTypes=[DISK, ARCHIVE], creationFallbacks=[DISK, ARCHIVE], replicationFallbacks=[DISK, ARCHIVE]}

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs storagepolicies -getStoragePolicy -path /data/hdfs-test/data_phase/cold

The storage policy of /data/hdfs-test/data_phase/cold:

BlockStoragePolicy{COLD:2, storageTypes=[ARCHIVE], creationFallbacks=[], replicationFallbacks=[]}

3.4.3 上传测试

- 分别上传文件到三个目录中测试

hdfs dfs -put /etc/profile /data/hdfs-test/data_phase/hot

hdfs dfs -put /etc/profile /data/hdfs-test/data_phase/warm

hdfs dfs -put /etc/profile /data/hdfs-test/data_phase/cold

- 查看不同存储策略文件的 block 位置

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs fsck /data/hdfs-test/data_phase/hot/profile -files -blocks -locations

Connecting to namenode via http://192.168.68.101:9870/fsck?ugi=hadoop&files=1&blocks=1&locations=1&path=%2Fdata%2Fhdfs-test%2Fdata_phase%2Fhot%2Fprofile

FSCK started by hadoop (auth:SIMPLE) from /192.168.68.101 for path /data/hdfs-test/data_phase/hot/profile at Thu Jan 13 14:50:08 CST 2022

/data/hdfs-test/data_phase/hot/profile 1942 bytes, replicated: replication=3, 1 block(s): OK

3. BP-1344315299-192.168.68.101-1641871518751:blk_1073741967_1143 len=1942 Live_repl=3 [DatanodeInfoWithStorage[192.168.68.103:9866,DS-ba9340ea-d242-4cea-b005-74b64e34ac39,DISK], DatanodeInfoWithStorage[192.168.68.101:9866,DS-e9f568d7-2eac-43b7-aed0-683514a8c41c,DISK], DatanodeInfoWithStorage[192.168.68.102:9866,DS-f23db2c4-f076-49e0-a721-c4c0aff89e8d,DISK]]

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs fsck /data/hdfs-test/data_phase/warm/profile -files -blocks -locations

Connecting to namenode via http://192.168.68.101:9870/fsck?ugi=hadoop&files=1&blocks=1&locations=1&path=%2Fdata%2Fhdfs-test%2Fdata_phase%2Fwarm%2Fprofile

FSCK started by hadoop (auth:SIMPLE) from /192.168.68.101 for path /data/hdfs-test/data_phase/warm/profile at Thu Jan 13 14:52:18 CST 2022

/data/hdfs-test/data_phase/warm/profile 1942 bytes, replicated: replication=3, 1 block(s): OK

0. BP-1344315299-192.168.68.101-1641871518751:blk_1073741968_1144 len=1942 Live_repl=3 [DatanodeInfoWithStorage[192.168.68.103:9866,DS-c54b6721-9962-4f13-a472-bca18c495dd0,ARCHIVE], DatanodeInfoWithStorage[192.168.68.102:9866,DS-1e50ee7c-eca0-49a4-b453-e9890759f328,ARCHIVE], DatanodeInfoWithStorage[192.168.68.101:9866,DS-e9f568d7-2eac-43b7-aed0-683514a8c41c,DISK]]

[hadoop@hadoop1 hadoop-3.3.1]$ hdfs fsck /data/hdfs-test/data_phase/cold/profile -files -blocks -locations

Connecting to namenode via http://192.168.68.101:9870/fsck?ugi=hadoop&files=1&blocks=1&locations=1&path=%2Fdata%2Fhdfs-test%2Fdata_phase%2Fcold%2Fprofile

FSCK started by hadoop (auth:SIMPLE) from /192.168.68.101 for path /data/hdfs-test/data_phase/cold/profile at Thu Jan 13 14:53:05 CST 2022

/data/hdfs-test/data_phase/cold/profile 1942 bytes, replicated: replication=3, 1 block(s): OK

0. BP-1344315299-192.168.68.101-1641871518751:blk_1073741969_1145 len=1942 Live_repl=3 [DatanodeInfoWithStorage[192.168.68.102:9866,DS-1e50ee7c-eca0-49a4-b453-e9890759f328,ARCHIVE], DatanodeInfoWithStorage[192.168.68.103:9866,DS-c54b6721-9962-4f13-a472-bca18c495dd0,ARCHIVE], DatanodeInfoWithStorage[192.168.68.101:9866,DS-0f356fed-83d9-4dc9-9f3e-ac52ce649236,ARCHIVE]]

可以看到:

- hot目录中的block,3个block都在DISK磁盘

- warm目录中的block,1个block在DISK磁盘,另外两个在archive磁盘

- cold目录中的block,3个block都在archive磁盘

3.5 HDFS中的内存存储支持

3.5.1 介绍

- HDFS 支持写入由 DataNode 管理的堆外内存

- DataNode 异步地将内存中数据刷新到磁盘,从而减少代价较高的磁盘 IO 操作,这种写入称之为懒持久写入。

- HDFS 为懒持久化写做了较大的持久性保证。在将副本保存到磁盘之前,如果节点重新启动,有非常小的几率会出现数据丢失。应用程序可以选择使用懒持久化写,以减少写入延迟。

该特性从 Apache Hadoop 2.6.0 开始支持。

- 比较适用于,当应用程序需要往 HDFS 中以低延迟的方式写入相对较低数据量(从几GB到十几GB,取决于可用内存)的数据时。

- 内存存储适用于在集群内运行,且运行的客户端与 HDFS DataNode 处于同一节点的应用程序。使用内存存储可以减少网络传输的开销。

- 如果内存不足或未配置,使用懒持久化写入的应用程序将继续工作,会继续使用磁盘存储。

3.5.2 配置内存存储支持

3.5.2.1 设置能够使用的内存空间

确定用于存储在内存中的副本内存量

- 在指定 DataNode 的 hdfs-site.xml 设置 dfs.datanode.max.locked.memory

- DataNode 将确保懒持久化的内存不超过 dfs.datanode.max.locked.memory

- 例如,为内存中的副本预留 32 GB

<property>

<name>dfs.datanode.max.locked.memory</name>

<value>34359738368</value>

</property>

在设置此值时,请记住,还需要内存中的空间来处理其他事情,例如数据节点和应用程序 JVM 堆以及操作系统页缓存。如果在与数据节点相同的节点上运行 YARN 节点管理器进程,则还需要 YARN 容器的内存。

3.5.2.2 DataNode设置基于内存的存储

- 在每个 DataNode 节点上初始化一个 RAM 磁盘

- 通过选择 RAM 磁盘,可以在 DataNode 进程重新启动时保持更好的数据持久性

下面的设置可以在大多数 Linux 发行版上运行,目前不支持在其他平台上使用 RAM 磁盘。

3.5.3 选择tmpfs(VS ramfs)

- Linux 支持使用两种类型的 RAM 磁盘:tmpfs 和 ramfs

- tmpfs 的大小受 linux 内核的限制,而 ramfs 可以使用所有系统可用的内存

- tmpfs 可以在内存不足情况下交换到磁盘上。但是,许多对性能要求很高的应用运行时都禁用内存磁盘交换

- HDFS 当前支持 tmpfs 分区,而对 ramfs 的支持正在开发中

3.5.4 挂载RAM磁盘

- 使用 Linux 中的 mount 命令来挂载内存磁盘。例如:挂载32GB的tmpfs分区在 /mnt/dn-tmpfs

sudo mount -t tmpfs -o size=32g tmpfs /mnt/dn-tmpfs/ - 建议在

/etc/fstab创建一个入口,在 DataNode 节点重新启动时,将自动重新创建 RAM 磁盘 - 另一个可选项是使用

/dev/shm下面的子目录。这是 tmpfs 默认在大多数 Linux 发行版上都可以安装 - 确保挂载的大小大于或等于

dfs.datanode.max.locked.memory,或者写入到/etc /fstab - 不建议使用多个 tmpfs 对懒持久化写入的每个 DataNode 节点进行分区

3.5.5 设置RAM_DISK存储类型tmpfs标签

- 标记 tmpfs 目录中具有 RAM_磁盘存储类型的目录

- 在

hdfs-site.xml中配置dfs.datanode.data.dir。例如,在具有三个硬盘卷的 DataNode 上,/grid/0,/grid/1以及/grid/2和一个 tmpfs 挂载在/mnt/dn-tmpfs,dfs.datanode.data.dir必须设置如下:

<property>

<name>dfs.datanode.data.dir</name>

<value>/grid/0,/grid/1,/grid/2,[RAM_DISK]/mnt/dn-tmpfs</value>

</property>

- 这一步至关重要。如果没有 RAM_DISK 标记,HDFS 将把 tmpfs 卷作为非易失性存储,数据将不会保存到持久存储,重新启动节点时将丢失数据

3.5.6 确保启用存储策略

确保全局设置中的存储策略是已启用的。默认情况下,此设置是打开的。

3.5.7 使用懒持久化存储策略

- 指定 HDFS 使用 LAZY_PERSIST 策略,可以对文件使用懒持久化写入

可以通过以下三种方式之一进行设置:

3.5.7.1 在目录上执行hdfs storagepolicies命令

- 在目录上设置㽾策略,将使其对目录中的所有新文件生效

- 这个 HDFS 存储策略命令可以用于设置策略

hdfs storagepolicies -setStoragePolicy -path <path> -policy LAZY_PERSIST

3.5.7.2 在目录上执行setStoragePolicy方法

Apache Hadoop 2.8.0 后,应用程序可以通过编程方式将存储策略设置FileSystem.setStoragePolicy。

fs.setStoragePolicy(path, "LAZY_PERSIST");

3.5.7.3 创建文件的时候指定CreateFlag

当创建文件时,应用程序调用FileSystem.create方法,传递CreateFlag#LAZY_PERSIST实现。

FSDataOutputStream fos =

fs.create(

path,

FsPermission.getFileDefault(),

EnumSet.of(CreateFlag.CREATE, CreateFlag.LAZY_PERSIST),

bufferLength,

replicationFactor,

blockSize,

null);

HDFS数据迁移解决方案

1. HDFS数据迁移解决方案

数据迁移指的是一种大规模量级的数据转移,转移的过程中往往会跨机房、跨集群 ,数据迁移规模的不同会导致整个数据迁移的周期也不尽相同 。

在 HDFS 中,同样有许多需要数据迁移的场景,比如冷热数据集群之间的数据转化, 或者 HDFS 数据的双机房备份等等 。因为涉及跨机房 、跨集群,所以数据迁移不会是一个简单的操作。

1.1 数据迁移使用场景

- 冷热集群数据同步、分类存储

- 集群数据整体搬迁

- 当公司的业务迅速的发展,导致当前的服务器数量资源出现临时紧张的时候,为了更高效的利用资源,会将原 A 机房数据整体迁移到 B 机房的,原因可能是 B 机房机器多,而且 B 机房本身开销较 A 机房成本低些等;

- 数据的准实时同步

- 数据准实时同步的目的在于数据的双备份可用,比如某天 A 集群突然宣告不允许再使用了,此时可以将线上使用集群直接切向 B 的同步集群,因为 B 集群实时同步 A 集群数据,拥有完全一致的真实数据和元数据信息,所以对于业务方使用而言是不会受到任何影响的。

1.2 数据迁移要素考量

- Bandwidth——带宽

- 带宽用的多了,会影响到线上业务的任务运行,带宽用的少了又会导致数据同步过慢的问题。

- Performance——性能

- 是采用简单的单机程序?还是多线程的性能更佳的分布式程序?

- Data-Increment——增量同步

- 当 TB,PB 级别的数据需要同步的时候,如果每次以全量的方式去同步数据,结果一定是非常糟糕。如果仅针对变化的增量数据进行同步将会是不错的选择。可以配合 HDFS 快照等技术实现增量数据同步。

- Syncable——数据迁移的同步性

- 数据迁移的过程中需要保证周期内数据是一定能够同步完的,不能差距太大。比如 A 集群 7 天内的增量数据,我只要花半天就可以完全同步到 B 集群,然后我又可以等到下周再次进行同步。最可怕的事情在于 A 集群的 7 天内的数据,我的程序花了 7 天还同步不完,然后下一个周期又来了,这样就无法做到准实时的一致性。其实 7 天还是一个比较大的时间,最好是能达到按天同步。

1.3 HDFS分布式拷贝工具:DistCp

1.3.1 DsitCp介绍

DistCp 是 Apache Hadoop 中的一种流行工具,在 hadoop-tools 工程下,作为独立子工程存在。其定位就是用于数据迁移的,定期在集群之间和集群内部备份数据。(在备份过程中,每次运行 DistCp 都称为一个备份周期)尽管性能相对较慢,但它的普及程度已经越来越高。

DistCp底层使用MapReduce在群集之间或并行在同一群集内复制文件。执行复制的MapReduce只有mapper阶段。 它涉及两个步骤:

- 构建要复制的文件列表(称为复制列表)

- 运行 MapReduce 作业以复制文件,并以复制列表为输入。

1.3.2 DsitCp特性

- 带宽限流

- DistCp 可以通过命令参数 bandwidth 来为程序进行带宽限流。

- 增量数据同步

- 在 DistCp 中可以通过 update 、append 和 diff 这 3 个参数实现增量同步。

- Update 解决了新增文件、目录的同步;Append 解决己存在文件的增量更新同步;Diff 解决删除或重命名类型文件的同步。

| Update | 只拷贝不存在的文件或者目录 |

|---|---|

| Append | 追加写目标路径下己存在的文件 |

| Diff | 通过快照的diff对比信息来同步源端路径与目标路径 |

- 高效的性能:分布式特性

- DistCp 底层使用 MapReduce 执行数据同步,MapReduce 本身是一类分布式程序。

1.3.3 DistCp命令

# hadoop distcp

usage: distcp OPTIONS [source_path...] <target_path>

-append //拷贝文件时支持对现有文件进行追加写操作

-async //异步执行distcp拷贝任务

-bandwidth <arg> //对每个Map任务的带宽限速

-delete //删除相对于源端,目标端多出来的文件

-diff <arg> //通过快照diff信息进行数据的同步

-overwrite //以覆盖的方式进行拷贝,如果目标端文件已经存在,则直接覆盖

-p <arg> //拷贝数据时,扩展属性信息的保留,包括权限信息、块大小信息等等

-skipcrccheck //拷贝数据时是否跳过cheacksum的校验

-update //拷贝数据时,只拷贝相对于源端 ,目标端不存在的文件数据

其中 source_path 、target_path 需要带上地址前缀以区分不同的集群,例如 :hadoop distcp hdfs://nn1:8020/foo/a hdfs://nn2:8020/bar/foo

上面的命令表示从nn1集群拷贝/foo/a路径下的数据到nn2集群的/bar/foo路径下。

HDFS NAMENODE 安全模式

1. HDFS NAMENODE 安全模式

1.1 场景:安全模式探究

HDFS 集群在停机状态下,使用hdfs –daemon命令逐个进程启动集群,观察现象。

首先启动 namenode:hdfs --daemon start namenode,然后依次执行浏览文件系统和创建文件夹操作,现象如下,发现集群可以查看目录结构但是无法新增目录。

打开 HDFS 集群 web 页面可以发现如下提示:

提示说:已经汇报的数据块的比例没有达到阈值。阈值为总数量块的 0.999。

接下来,启动第一台机器上的 Datanode 进程:hdfs --daemon start datanode,继续查看页面提示信息。

此时执行创建文件夹操作,发现可以创建成功了。

可以发现在安全模式下,我们可以浏览文件系统目录层次结构,但是却无法创建文件夹,安全模式下的文件系统似乎处于一种可读不可下的特殊状态。

1.2 安全模式概述

Hadoop 中的安全模式safe mode是NameNode的维护状态,在此状态下 NameNode 不允许对文件系统进行任何更改,可以接受读数据请求。

在 NameNode 启动过程中,首先会从 fsimage 和 edits 日志文件加载文件系统状态。然后,等待 DataNodes 汇报可用的 block 信息。在此期间,NameNode 保持在安全模式。随着 DataNode 的 block 汇报持续进行,当整个系统达到安全标准时,HDFS 自动离开安全模式。在 NameNode Web 主页上会显示安全模式是打开还是关闭。

如果 HDFS 处于安全模式下,不允许 HDFS 客户端进行任何修改文件的操作,包括上传文件,删除文件,重命名,创建文件夹,修改副本数等操作。

1.3 安全模式自动进入离开

1.3.1 自动进入时间

HDFS 集群启动时,当 NameNode 启动成功之后,此时集群就会自动进入安全模式。

1.3.2 自动离开条件

安全模式相关的配置属性参数都在hdfs-default.xml中定义,如果需要覆盖任何值,请在hdfs-site.xml文件中重新覆盖定义。

-

dfs.replication- hdfs block 的副本数据,默认 3

-

dfs.replication.max- 最大块副本数,默认 512

-

dfs.namenode.replication.min- 最小块副本数,默认 1

-

dfs.namenode.safemode.threshold-pct- 已汇报可用数据块数量占整体块数量的百分比阈值。默认 0.999f。

小于或等于 0,则表示退出安全模式之前,不要等待特定百分比的块。大于 1 的值将使安全模式永久生效。

- 已汇报可用数据块数量占整体块数量的百分比阈值。默认 0.999f。

-

dfs.namenode.safemode.min.datanodes- 指在退出安全模式之前必须存活的 DataNode 数量,默认 0

-

dfs.namenode.safemode.extension- 达到阈值条件后持续扩展的时间。倒计时结束如果依然满足阈值条件,自动离开安全模式。默认 30000 毫秒

1.4 安全模式手动进入离开

1.4.1 手动获取安全模式状态信息

hdfs dfsadmin -safemode get

1.4.2 手动进入命令

hdfs dfsadmin -safemode enter

手动进入安全模式对于集群维护或者升级的时候非常有用,因为这时候 HDFS 上的数据是只读的。

1.4.3 手动离开命令

hdfs dfsadmin -safemode leave

HDFS优化方案

1. HDFS优化方案

1.1 短路本地读取:Short Circuit Local Reads

1.1.1 背景

在 HDFS 中,不管是 Local Reads(DFSClient 和 Datanode 在同一个节点)还是 Remote Reads(DFSClient 和 Datanode不在同一个节点),底层处理方式都是一样的,都是先由Datanode读取数据,然后再通过RPC(基于TCP)把数据传给DFSClient。这样处理是比较简单的,但是性能会受到一些影响,因为需要 Datanode 在中间做一次中转。

尤其 Local Reads 的时候,既然 DFSClient 和数据是在一个机器上面,那么很自然的想法,就是让 DFSClient 绕开 Datanode 自己去读取数据。

所谓的“短路”读取绕过了 DataNode,从而允许客户端直接读取文件。显然,这仅在客户端与数据位于同一机器的情况下才可行。短路读取为许多应用提供了显着的性能提升。

1.1.2 短路本地读取

在 HDFS-2246 这个 JIRA 中,工程师们的想法是既然读取数据 DFSClient 和数据在同一台机器上,那么 Datanode 就把数据在文件系统中的路径,从什么地方开始读(offset)和需要读取多少(length)等信息告诉 DFSClient,然后 DFSClient 去打开文件自己读取。想法很好,问题在于配置复杂以及安全问题。

首先是配置问题,因为是让DFSClient自己打开文件读取数据,那么就需要配置一个白名单,定义哪些用户拥有访问 Datanode 的数据目录权限。如果有新用户加入,那么就得修改白名单。需要注意的是,这里是允许客户端访问 Datanode 的数据目录,也就意味着,任何用户拥有了这个权限,就可以访问目录下其他数据,从而导致了安全漏洞。因此,这个实现已经不建议使用了。

1.1.3 短路本地读取安全性改进

在 HDFS-347 中,提出了一种新的解决方案,让短路本地读取数据更加安全。

在 Linux 中,有个技术叫做Unix Domain Socket。Unix Domain Socket 是一种进程间的通讯方式,它使得同一个机器上的两个进程能以Socket的方式通讯。它带来的另一大好处是,利用它两个进程除了可以传递普通数据外,还可以在进程间传递文件描述符。

假设机器上的两个用户 A 和 B,A 拥有访问某个文件的权限而 B 没有,而 B 又需要访问这个文件。借助 Unix Domain Socket,可以让 A 打开文件得到一个文件描述符,然后把文件描述符传递给 B,B 就能读取文件里面的内容了即使它没有相应的权限。在 HDFS 的场景里面,A 就是 Datanode,B 就是 DFSClient,需要读取的文件就是 Datanode 数据目录中的某个文件。

这个方案在安全上就比上一个方案上好一些,至少它只允许 DFSClient 读取它需要的文件。

1.1.4 短路本地读取配置

1.1.4.1 libhadoop.so

因为 Java 不能直接操作 Unix Domain Socket,所以需要安装 Hadoop 的 native 包 libhadoop.so。在编译 Hadoop 源码的时候可以通过编译 native 模块获取。可以用如下命令来检查 native 包是否安装好。

hadoop checknative

1.1.4.2 hdfs-site.xml

<property>

<name>dfs.client.read.shortcircuit</name>

<value>true</value>

</property>

<property>

<name>dfs.domain.socket.path</name>

<value>/var/lib/hadoop-hdfs/dn_socket</value>

</property>

dfs.client.read.shortcircuit是打开短路本地读取功能的开关。dfs.domain.socket.path是 DataNode 和DFSClient 之间沟通的 Socket 的本地路径。

注:/var/lib/hadoop-hdfs/dn_socket需要提前创建,但是只需要创建到/var/lib/hadoop-hdfs,后面的/dn_socket由 hadoop 自己创建,如果提前创建到这一步,DataNode 会启动失败。

1.2 makeHDFS Block负载平衡器:Balancer

1.2.1 背景

HDFS 数据可能并不总是在 DataNode 之间均匀分布。一个常见的原因是向现有群集中添加了新的 DataNode。HDFS 提供了一个 Balancer 程序,分析 block 放置信息并且在整个 DataNode 节点之间平衡数据,直到被视为平衡为止。

所谓的平衡指的是每个DataNode的利用率(节点上已用空间与节点总容量之比)与集群的利用率(集群上已用空间与集群总容量的比)相差不超过给定阈值百分比。 平衡器无法在单个 DataNode 上的各个卷之间进行平衡。

1.2.2 命令行配置和运行

-threshold 10 //集群平衡的条件,datanode间磁盘使用率相差阈值,区间选择:0~100

-policy datanode //平衡策略,默认为datanode, 如果datanode平衡,则集群已平衡。

-exclude -f /tmp/ip1.txt //默认为空,指定该部分ip不参与balance, -f:指定输入为文件

-include -f /tmp/ip2.txt //默认为空,只允许该部分ip参与balance,-f:指定输入为文件

-idleiterations 5 //迭代 5

1.2.2.1 设置平衡数据传输宽带

命令:hdfs dfsadmin -setBalancerBandwidth newbandwidth

其中newbandwidth是每个 DataNode 在平衡操作期间可以使用的最大网络带宽量,以每秒字节数为单位。

比如:hdfs dfsadmin -setBalancerBandwidth 104857600

1.2.2.2 默认运行balancer

命令:hdfs balancer

此时将会以默认参数进行数据块的平衡操作。

1.2.2.3 修改阈值运行balancer

命令:hdfs balancer -threshold 5

Balancer 将以阈值 5% 运行(默认值 10%),这意味着程序将确保每个 DataNode 上的磁盘使用量与群集中的总体使用量相差不超过 5%。例如,如果集群中所有 DataNode 的总体使用率是集群磁盘总存储容量的 40%,则程序将确保每个 DataNode 的磁盘使用率在该 DataNode 磁盘存储容量的 35% 至 45% 之间。

1.3 磁盘均衡器:HDFS Disk Balancer

1.3.1 背景

相比较于个人 PC,服务器一般可以通过挂载多块磁盘来扩大单机的存储能力。

在 Hadoop HDFS 中,DataNode 负责最终数据 block 的存储,在所在机器上的磁盘之间分配数据块。当写入新 block 时,DataNodes 将根据选择策略(循环策略或可用空间策略)来选择 block 的磁盘(卷)。

循环策略:它将新 block 均匀分布在可用磁盘上。默认此策略。

可用空间策略:此策略将数据写入具有更多可用空间(按百分比)的磁盘。

但是,在长期运行的群集中采用循环策略时,DataNode 有时会不均匀地填充其存储目录(磁盘/卷),从而导致某些磁盘已满而其他磁盘却很少使用的情况。发生这种情况的原因可能是由于大量的写入和删除操作,也可能是由于更换了磁盘。

另外,如果我们使用基于可用空间的选择策略,则每个新写入将进入新添加的空磁盘,从而使该期间的其他磁盘处于空闲状态。这将在新磁盘上创建瓶颈。

因此,需要一种Intra DataNode Balancing(DataNode内数据块的均匀分布)来解决 Intra-DataNode 偏斜(磁盘上块的不均匀分布),这种偏斜是由于磁盘更换或随机写入和删除而发生的。

因此,Hadoop 3.0 中引入了一个名为 Disk Balancer 的工具,该工具专注于在 DataNode 内分发数据。

1.3.2 HDFS Disk Balancer简介

HDFS disk balancer是 Hadoop 3 中引入的命令行工具,用于平衡 DataNode 中的数据在磁盘之间分布不均匀问题。 这里要特别注意,HDFS disk balancer 与 HDFS Balancer 是不同的:

HDFS disk balancer 针对给定的 DataNode 进行操作,并将块从一个磁盘移动到另一个磁盘,是 DataNode 内部数据在不同磁盘间平衡;

HDFS Balancer 平衡了 DataNode 节点之间的分布。

1.3.3 HDFS Disk Balancer功能

HDFS Disk balancer支持两个主要功能,即报告和平衡。

1.3.3.1 数据传播报告

为了定义一种方法来衡量集群中哪些计算机遭受数据分布不均的影响,HDFS 磁盘平衡器定义了 HDFS Volume Data Density metric(卷/磁盘数据密度度量标准)和 Node Data Density metric(节点数据密度度量标准)。

HDFS 卷数据密度度量标准能够比较数据在给定节点的不同卷上的分布情况。

节点数据密度度量允许在节点之间进行比较。

- Volume data density metric计算过程

假设有一台具有四个卷/磁盘的计算机:Disk1,Disk2,Disk3,Disk4,各个磁盘使用情况:

| Disk1 | Disk2 | Disk3 | Disk4 | |

|---|---|---|---|---|

| capacity | 200 GB | 300 GB | 350 GB | 500 GB |

| dfsUsed | 100 GB | 76 GB | 300 GB | 475 GB |

| dfsUsedRatio | 0.5 | 0.25 | 0.85 | 0.95 |

| volumeDataDensity | 0.20 | 0.45 | -0.15 | -0.24 |

Total capacity= 200 + 300 + 350 + 500 = 1350 GB

Total Used= 100 + 76 + 300 + 475 = 951 GB

因此,每个卷/磁盘上的理想存储为:

Ideal storage = total Used ÷ total capacity= 951÷1350 = 0.70

也就是每个磁盘应该保持在 70% 理想存储容量。

VolumeDataDensity = idealStorage – dfs Used Ratio

比如 Disk1 的卷数据密度= 0.70-0.50 = 0.20。其他 Disk 以此类推。

volumeDataDensity的正值表示磁盘未充分利用,而负值表示磁盘相对于当前理想存储目标的利用率过高。

- Node Data Density计算过程

Node Data Density(节点数据密度)= 该节点上所有卷/磁盘volume data density 绝对值的总和。

上述例子中的节点数据密度=|0.20|+|0.45|+|-0.15|+|-0.24| = 1.04

较低的 node Data Density 值表示该机器节点具有较好的扩展性,而较高的值表示节点具有更倾斜的数据分布。

一旦有了 volumeDataDensity 和 nodeDataDensity,就可以找到集群中数据分布倾斜的节点,或者可以获取给定节点的 volumeDataDensity。

1.3.3.2 磁盘平衡

当指定某个 DataNode 节点进行 disk 数据平衡,就可以先计算或读取当前的 volumeDataDensity(磁盘数据密度)。有了这些信息,我们可以轻松地确定哪些卷已超量配置,哪些卷已不足。为了将数据从一个卷移动到 DataNode 中的另一个卷,Hadoop 开发实现了基于 RPC 协议的 Disk Balancer。

1.3.4 HDFS Disk Balancer开启

HDFS Disk Balancer 通过创建计划进行操作,该计划是一组语句,描述应在两个磁盘之间移动多少数据,然后在 DataNode 上执行该组语句。计划包含多个移动步骤。计划中的每个移动步骤都具有目标磁盘,源磁盘的地址。移动步骤还具有要移动的字节数。该计划是针对可操作的 DataNode 执行的。

默认情况下,Hadoop 集群上已经启用了 Disk Balancer 功能。通过在hdfs-site.xml中调整dfs.disk.balancer.enabled参数值,选择在 Hadoop 中是否启用磁盘平衡器。

1.3.5 HDFS Disk Balancer相关命令

1.3.5.1 Plan计划

命令:hdfs diskbalancer -plan <datanode>

-out //控制计划文件的输出位置

-bandwidth //设置用于运行Disk Balancer的最大带宽。默认带宽10 MB/s。

–thresholdPercentage //定义磁盘开始参与数据重新分配或平衡操作的值。默认的thresholdPercentage值为10%,这意味着仅当磁盘包含的数据比理想存储值多10%或更少时,磁盘才用于平衡操作。

-maxerror //它允许用户在中止移动步骤之前为两个磁盘之间的移动操作指定要忽略的错误数。

-v //详细模式,指定此选项将强制plan命令在stdout上显示计划的摘要。

-fs //此选项指定要使用的NameNode。如果未指定,则Disk Balancer将使用配置中的默认NameNode。

1.3.5.2 Execute执行

命令:hdfs diskbalancer -execute <JSON file path>

execute 命令针对为其生成计划的 DataNode 执行计划。

1.3.5.3 Query查询

命令:hdfs diskbalancer -query <datanode>

query 命令从运行计划的 DataNode 获取 HDFS 磁盘平衡器的当前状态。

1.3.5.4 Cancel取消

命令:hdfs diskbalancer -cancel <JSON file path>

hdfs diskbalancer -cancel planID node <nodename>

cancel 命令取消运行计划。

1.3.5.5 Report执行

命令:hdfs diskbalancer -fs https://namenode.uri -report <file://>

1.4 纠删码技术:Erasure Coding

1.4.1 背景:3副本策略弊端

为了提供容错能力,HDFS 会根据 replication factor(复制因子)在不同的 DataNode 上复制文件块。默认复制因子为 3(注意这里的 3 指的是 1+2=3,不是额外 3 个),则原始块除外,还将有额外两个副本。每个副本使用 100% 的存储开销,因此导致 200% 的存储开销。这些副本也消耗其他资源,例如网络带宽。

在复制因子为N时,存在N-1个容错能力,但存储效率仅为1/N。

这种复制增加了存储开销,并且似乎很昂贵。因此,HDFS 使用 Erasure Coding(纠删码)代替复制,以提供相同级别的容错能力,并且存储开销不超过 50%。

Erasure Coding 文件的复制因子始终为 1,用户无法对其进行更改。

1.4.2 Erasure Coding(EC)简介

纠删码技术(Erasure coding) 简称 EC,是一种编码容错技术。最早用于通信行业,数据传输中的数据恢复。它通过对数据进行分块,然后计算出校验数据,使得各个部分的数据产生关联性。当一部分数据块丢失时,可以通过剩余的数据块和校验块计算出丢失的数据块。

Hadoop 3.0 之后引入了纠删码技术(Erasure Coding),它可以提高 50% 以上的存储利用率,并且保证数据的可靠性。

存储系统 RAID 使用纠删码。RAID通过striping(条带化) 实现纠删码,也就是说,将逻辑上连续的数据(例如文件)划分为较小的单位(bit,byte,or block),并将连续的单位存储在不同的磁盘上。

对于原始数据集的每个条带,都会根据纠删码算法来计算并存储一定数量的奇偶校验单元,该过程称为编码。

任何条带化单元中的错误都可以根据剩余数据和奇偶校验单元从计算中恢复,此过程称为解码。

1.4.3 Reed-Solomon(RS)码

1.4.3.1 RS码介绍

Reed-Solomon(RS)码是存储系统较为常用的一种纠删码,它有两个参数 k 和 m,记为 RS(k,m)。如下图所示,k 个数据块组成一个向量被乘上一个生成矩阵(Generator Matrix)GT 从而得到一个码字(codeword)向量,该向量由 k 个数据块和 m 个校验块构成。如果一个数据块丢失,可以用 (GT)-1 乘以码字向量来恢复出丢失的数据块。RS(k,m)最多可容忍 m 个块(包括数据块和校验块)丢失。

1.4.3.2 RS码通俗解释

比如有 7、8、9 三个原始数据,通过矩阵乘法,计算出来两个校验数据 50、122。这时原始数据加上校验数据,一共五个数据:7、8、9、50、122,可以任意丢两个,然后通过算法进行恢复。

1.4.4 Hadoop EC架构

为了支持纠删码,HDFS 体系结构进行了一些更改调整。

- Namenode扩展

- 条带化的 HDFS 文件在逻辑上由

block group(块组)组成,每个块组包含一定数量的内部块。这允许在块组级别而不是块级别进行文件管理。

- 条带化的 HDFS 文件在逻辑上由

- 客户端扩展

- 客户端的读写路径得到了增强,可以并行处理块组中的多个内部块。

- Datanode扩展

- DataNode 运行一个附加的 ErasureCodingWorker(ECWorker)任务,以对失败的纠删编码块进行后台恢复。 NameNode 检测到失败的 EC 块,然后 NameNode 选择一个 DataNode 进行恢复工作。

- 纠删编码策略

- 为了适应异构的工作负载,允许 HDFS 集群中的文件和目录具有不同的复制和纠删码策略。纠删码策略封装了如何对文件进行编码/解码。默认情况下启用

RS-6-3-1024k策略, RS 表示编码器算法 Reed-Solomon,6 、3 中表示数据块和奇偶校验块的数量,1024k 表示条带化单元的大小。 目录上还支持默认的REPLICATION方案。它只能在目录上设置,以强制目录采用 3 倍复制方案,而不继承其祖先的纠删码策略。此策略可以使 3x 复制方案目录与纠删码目录交错。REPLICATION 始终处于启用状态。- 此外也支持用户通过 XML 文件定义自己的 EC 策略,Hadoop conf 目录中有一个名为

user_ec_policies.xml.template的示例 EC 策略 XML 文件,用户可以参考该文件。

- 为了适应异构的工作负载,允许 HDFS 集群中的文件和目录具有不同的复制和纠删码策略。纠删码策略封装了如何对文件进行编码/解码。默认情况下启用

- Intel ISA-L

- 英特尔 ISA-L 代表英特尔智能存储加速库。 ISA-L 是针对存储应用程序而优化的低级功能的开源集合。它包括针对 Intel AVX 和 AVX2 指令集优化的快速块 Reed-Solomon 类型擦除代码。

HDFS纠删码可以利用ISA-L加速编码和解码计算。

- 英特尔 ISA-L 代表英特尔智能存储加速库。 ISA-L 是针对存储应用程序而优化的低级功能的开源集合。它包括针对 Intel AVX 和 AVX2 指令集优化的快速块 Reed-Solomon 类型擦除代码。

1.4.5 Erasure Coding部署方式

1.4.5.1 集群和硬件配置

编码和解码工作会消耗 HDFS 客户端和 DataNode 上的额外CPU。

纠删码文件也分布在整个机架上,以实现机架容错。这意味着在读写条带化文件时,大多数操作都是在机架上进行的。因此,网络带宽也非常重要。

对于机架容错,拥有足够数量的机架也很重要,每个机架所容纳的块数不超过 EC 奇偶校验块的数。

机架数量=(数据块+奇偶校验块)/奇偶校验块后取整。比如对于 EC 策略 RS(6,3),这意味着最少 3 个机架(由(6 + 3)/ 3 = 3 计算),理想情况下为 9 个或更多,以处理计划内和计划外的停机。对于机架数少于奇偶校验单元数的群集,HDFS 无法维持机架容错能力,但仍将尝试在多个节点之间分布条带化文件以保留节点级容错能力。因此,建议设置具有类似数量的 DataNode 的机架。

1.4.5.2 纠删码策略设置

纠删码策略由参数dfs.namenode.ec.system.default.policy指定,默认是 RS-6-3-1024k,其他策略默认是禁用的。可以通过hdfs ec [-enablePolicy -policy <policyName>]命令启用策略集。

1.4.5.3 启用英特尔ISA-L

默认 RS 编解码器的 HDFS 本机实现利用 Intel ISA-L 库来改善编码和解码计算。要启用和使用 Intel ISA-L,需要执行三个步骤。

建立 ISA-L 库;

使用 ISA-L 支持构建 Hadoop;

使用 -Dbundle.isal 将 isal.lib 目录的内容复制到最终的 tar 文件中。使用 tar 文件部署 Hadoop。确保 ISA-L 在 HDFS 客户端和 DataNode 上可用。

1.4.6 EC命令

HDFS 提供了一个 ec 子命令来执行与纠删码有关的管理命令。

-

-setPolicy -path <path> [-policy <policy>] [-replicate]- 在指定路径的目录上设置擦除编码策略。

path:HDFS 中的目录。这是必填参数。设置策略仅影响新创建的文件,而不影响现有文件。policy:用于此目录下文件的擦除编码策略。默认 RS-6-3-1024k 策略。-replicate在目录上应用默认的 REPLICATION 方案,强制目录采用 3x 复制方案。-replicate和-policy <policy>是可选参数。不能同时指定它们。

-

-getPolicy -path <path>- 获取指定路径下文件或目录的擦除编码策略的详细信息。

-

-unsetPolicy -path <path>- 取消设置先前对目录上的 setPolicy 的调用所设置的擦除编码策略。如果该目录从祖先目录继承了擦除编码策略,则 unsetPolicy 是 no-op。在没有显式策略集的目录上取消策略将不会返回错误。

-

-listPolicies- 列出在 HDFS 中注册的所有(启用,禁用和删除)擦除编码策略。只有启用的策略才适合与 setPolicy 命令一起使用。

-

-addPolicies -policyFile <文件>- 添加用户定义的擦除编码策略列表。

-

-listCodecs- 获取系统中支持的擦除编码编解码器和编码器的列表。

-

-removePolicy -policy <policyName>- 删除用户定义的擦除编码策略。

-

-enablePolicy -policy <policyName>- 启用擦除编码策略。

-

-disablePolicy -policy <policyName>- 禁用擦除编码策略。

ERROR org.apache.hadoop.hdfs.server.datanode.DataNode: Exception in secureMain

见ERROR org.apache.hadoop.hdfs.server.datanode.DataNode: Exception in secureMain-CSDN博客

HDFS动态节点管理

见Hadoop生态圈(八)- HDFS动态节点管理_hadoop集群刷新节点-CSDN博客

HDFS High Availability(HA)高可用集群

见Hadoop生态圈(九)- HDFS High Availability(HA)高可用集群_hadoop客户端无法识别高可用(ha)集群的逻辑名称访问-CSDN博客

HDFS Federation联邦机制

见Hadoop生态圈(十)- HDFS Federation联邦机制_ha ns2 联邦-CSDN博客

HDFS集群滚动升级

见Hadoop生态圈(十一)- HDFS集群滚动升级_hadoop rolling upgrade-CSDN博客

HDFS架构深入学习

1. HDFS架构剖析

1.1 HDFS整体概述

HDFS是 Hadoop Distribute File System 的简称,意为:Hadoop分布式文件系统。是 Hadoop 核心组件之一,作为大数据生态圈最底层的分布式存储服务而存在。HDFS解决的问题就是大数据如何存储,它是横跨在多台计算机上的文件存储系统并且具有高度的容错能力。

HDFS集群遵循主从架构。每个群集包括一个主节点和多个从节点。在内部,文件分为一个或多个块,每个块根据复制因子存储在不同的从节点计算机上。主节点存储和管理文件系统名称空间,即有关文件块的信息,例如块位置,权限等。从节点存储文件的数据块。主从各司其职,互相配合,共同对外提供分布式文件存储服务。当然内部细节对于用户来说是透明的。

1.2 角色介绍

1.2.1 概述

HDFS 遵循主从架构。每个群集包括一个主节点和多个从节点。其中:

NameNode是主节点,负责存储和管理文件系统元数据信息,包括 namespace 目录结构、文件块位置信息等;DataNode是从节点,负责存储文件具体的数据块。

两种角色各司其职,共同协调完成分布式的文件存储服务。

SecondaryNameNode是主角色的辅助角色,帮助主角色进行元数据的合并。

1.2.2 NameNode

NameNode是 Hadoop 分布式文件系统的核心,架构中的主角色。它维护和管理文件系统元数据,包括名称空间目录树结构、文件和块的位置信息、访问权限等信息。基于此,NameNode成为了访问HDFS的唯一入口。

内部通过内存和磁盘两种方式管理元数据。其中磁盘上的元数据文件包括 Fsimage 内存元数据镜像文件和 edits log(Journal)编辑日志。

在 Hadoop2 之前,NameNode 是单点故障。Hadoop 2 中引入的高可用性。Hadoop 集群体系结构允许在集群中以热备配置运行两个或多个 NameNode。

1.2.3 Datanode

DataNode是 Hadoop HDFS 中的从角色,负责具体的数据块存储。DataNode 的数量决定了 HDFS 集群的整体数据存储能力。通过和 NameNode 配合维护着数据块。

1.2.4 Secondarynamenode

除了 DataNode 和 NameNode 之外,还有另一个守护进程,它称为secondary NameNode。充当NameNode的辅助节点,但不能替代 NameNode。

当 NameNode 启动时,NameNode 合并 Fsimage 和 edits log 文件以还原当前文件系统名称空间。如果 edits log 过大不利于加载,Secondary NameNode 就辅助 NameNode 从 NameNode 下载Fsimage文件和edits log文件进行合并。

1.3 HDFS重要特性

1.3.1 主从架构

HDFS 采用 master/slave 架构。一般一个 HDFS 集群是有一个 Namenode 和一定数目的 Datanode 组成。Namenode是HDFS主节点,Datanode是HDFS从节点,两种角色各司其职,共同协调完成分布式的文件存储服务。

1.3.2 分块机制

HDFS 中的文件在物理上是分块存储(block)的,块的大小可以通过配置参数来规定,参数位于 hdfs-default.xml 中:dfs.blocksize。默认大小在 Hadoop2.x/3.x 是128M(134217728),1.x 版本中是 64M。

1.3.3 副本机制

为了容错,文件的所有 block 都会有副本。每个文件的 block 大小(dfs.blocksize)和副本系数(dfs.replication)都是可配置的。应用程序可以指定某个文件的副本数目。副本系数可以在文件创建的时候指定,也可以在之后通过命令改变。

默认dfs.replication的值是3,也就是会额外再复制 2 份,连同本身总共 3 份副本。

1.3.4 Namespace

HDFS 支持传统的层次型文件组织结构。用户可以创建目录,然后将文件保存在这些目录里。文件系统名字空间的层次结构和大多数现有的文件系统类似:用户可以创建、删除、移动或重命名文件。

Namenode 负责维护文件系统的 namespace 名称空间,任何对文件系统名称空间或属性的修改都将被 Namenode 记录下来。

HDFS 会给客户端提供一个统一的抽象目录树,客户端通过路径来访问文件,形如:hdfs://namenode:port/dir-a/dir-b/dir-c/file.data。

1.3.5 元数据管理

在 HDFS 中,Namenode 管理的元数据具有两种类型:

-

文件自身属性信息- 文件名称、权限,修改时间,文件大小,复制因子,数据块大小。

-

文件块位置映射信息- 记录文件块和 DataNode 之间的映射信息,即哪个块位于哪个节点上。

1.3.6 数据块存储

文件的各个 block 的具体存储管理由 DataNode 节点承担。每一个 block 都可以在多个 DataNode 上存储。

2. HDFS Web Interfaces

2.1 Web Interfaces介绍

除了命令行界面之外,Hadoop 还为 HDFS 提供了 Web 用户界面。用户可以通过 Web 界面操作文件系统并且获取和 HDFS 相关的状态属性信息。

HDFS Web 地址是 http://nn_host:port/,默认端口号9870。

2.2 模块功能解读

2.2.1 Overview

Overview 是总揽模块,默认的主页面。展示了 HDFS 一些最核心的信息。

2.2.1.1 Summary

2.2.1.2 NameNode Journal Status

2.2.1.3 NameNode Storage

2.2.1.4 DFS Storage Types

2.2.2 Datanodes

Datanodes 模块主要记录了 HDFS 集群中各个 DataNode 的相关状态信息。

2.2.3 Datanode Volume Failures

此模块记录了 DataNode 卷故障信息。

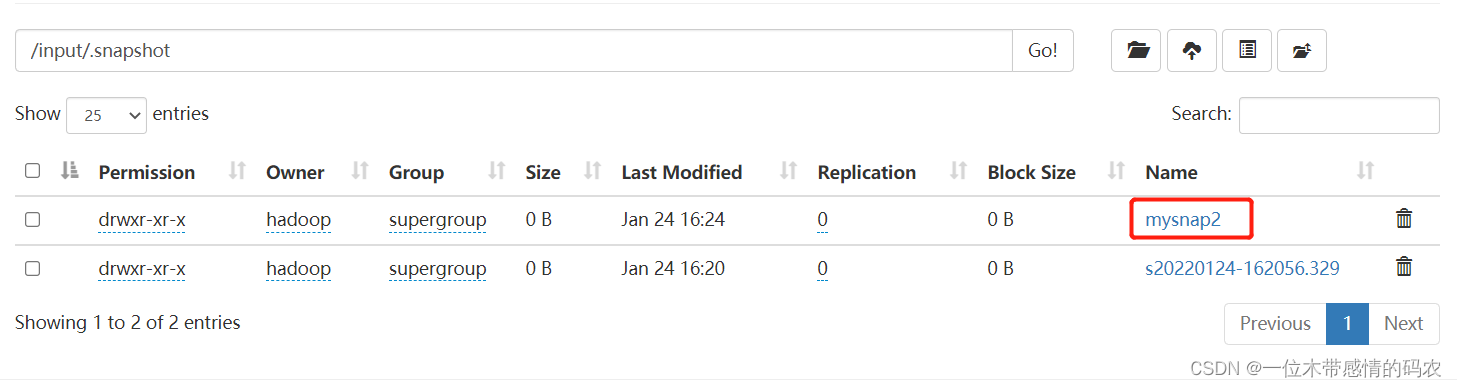

2.2.4 Snapshot

Snapshot模块记录 HDFS 文件系统的快照相关信息,包括哪些文件夹创建了快照和总共有哪些快照。

2.2.5 Satartup progress

2.2.6 Utilities

Utilities模块算是用户使用最多的模块了,里面包括了文件浏览、日志查看、配置信息查看等核心功能。

2.2.6.1 Browse the file system

该模块可以说是我们在开发使用 HDFS 过程中使用最多的模块了,提供了一种Web页面浏览操作文件系统的能力,在某些场合下,比使用命令操作更加直观方便。

2.2.6.2 Logs、Log Level

2.2.6.3 Configruation

该模块可以列出当前集群成功加载的所谓配置文件属性,可以从这里来进行判断用户所设置的参数属性是否成功加载生效,如果此处没有,需要检查配置文件或者重启集群加载。

3. HDFS读写流程

因为 namenode 维护管理了文件系统的元数据信息,这就造成了不管是读还是写数据都是基于 NameNode 开始的,也就是说NameNode成为了HDFS访问的唯一入口。入口地址是:http://nn_host:8020。

3.1 写数据流程

3.1.1 Pipeline管道、ACK应答响应

Pipeline,中文翻译为管道。这是 HDFS 在上传文件写数据过程中采用的一种数据传输方式。客户端将数据块写入第一个数据节点,第一个数据节点保存数据之后再将块复制到第二个数据节点,后者保存后将其复制到第三个数据节点。通俗描述 pipeline 的过程就是:Client→ \rightarrow→A→ \rightarrow→B→ \rightarrow→C。

为什么 datanode 之间采用 pipeline线性传输,而不是一次给三个 datanode 拓扑式传输呢?因为数据以管道的方式,顺序的沿着一个方向传输,这样能够充分利用每个机器的带宽,避免网络瓶颈和高延迟时的连接,最小化推送所有数据的延时。在线性推送模式下,每台机器所有的出口宽带都用于以最快的速度传输数据,而不是在多个接受者之间分配宽带。

ACK (Acknowledge character)即是确认字符,在数据通信中,接收方发给发送方的一种传输类控制字符。表示发来的数据已确认接收无误。在 pipeline 管道传输数据的过程中,传输的反方向会进行 ACK 校验,确保数据传输安全。

3.1.2 具体流程

- HDFS 客户端通过对 DistributedFileSystem 对象调用

create()请求创建文件。 - DistributedFileSystem 对 namenode进行

RPC调用,请求上传文件。namenode执行各种检查判断:目标文件是否存在、父目录是否存在、客户端是否具有创建该文件的权限。检查通过,namenode 就会为创建新文件记录一条记录。否则,文件创建失败并向客户端抛出一个 IOException。 - DistributedFileSystem 为客户端返回 FSDataOutputStream 输出流对象。由此客户端可以开始写入数据。FSDataOutputStream 是一个包装类,所

包装的是DFSOutputStream。 - 在客户端写入数据时,DFSOutputStream 将它分成一个个数据包(

packet默认 64kb),并写入一个称之为数据队列(data queue)的内部队列。DFSOutputStream 有一个内部类做 DataStreamer,用于请求 NameNode 挑选出适合存储数据副本的一组 DataNode。这一组 DataNode 采用pipeline机制做数据的发送。默认是 3 副本存储。 - DataStreamer 将数据包流式传输到 pipeline 的第一个 datanode,该 DataNode 存储数据包并将它发送到 pipeline 的第二个 DataNode。同样,第二个 DataNode 存储数据包并且发送给第三个(也是最后一个)DataNode。

- DFSOutputStream 也维护着一个内部数据包队列来等待 DataNode 的收到确认回执,称之为

确认队列(ack queue),收到 pipeline 中所有 DataNode 确认信息后,该数据包才会从确认队列删除。 - 客户端完成数据写入后,将在流上调用 close() 方法关闭。该操作将剩余的所有数据包写入 DataNode pipeline,并在联系到 NameNode 告知其文件写入完成之前,等待确认。

- 因为 namenode 已经知道文件由哪些块组成(DataStream 请求分配数据块),因此它仅需等待最小复制块即可成功返回。

- 数据块最小复制是由参数

dfs.namenode.replication.min指定,默认是1。

3.1.3 默认3副本存储策略

默认副本存储策略是由BlockPlacementPolicyDefault指定。策略如下:

3.1.4 网络拓扑——节点距离计算

在 HDFS 写数据的过程中,NameNode 会选择距离待上传数据最近距离的 DataNode 接收数据。那么这个最近距离怎么计算呢?

节点距离:两个节点到达最近的共同祖先的距离总和。

例如,假设有数据中心 d1 机架 r1 中的节点 n1。该节点可以表示为 /d1/r1/n1。利用这种标记,这里给出四种距离描述。

3.2 读数据流程

3.2.1 具体流程

- 客户端通过调用 DistributedFileSystem 对象上的 open() 来打开希望读取的文件。

- DistributedFileSystem 使用

RPC调用namenode 来确定文件中前几个块的块位置。对于每个块,namenode 返回具有该块副本的 datanode 的地址,并且 datanode 根据块与客户端的距离进行排序。注意此距离指的是网络拓扑中的距离。比如客户端的本身就是一个 DataNode,那么从本地读取数据明显比跨网络读取数据效率要高。 - DistributedFileSystem 将

FSDataInputStream(支持文件seek定位读的输入流)返回到客户端以供其读取数据。FSDataInputStream 类转而封装为 DFSInputStream 类,DFSInputStream 管理着 datanode 和 namenode 之间的 IO。 - 客户端在流上调用 read() 方法。然后,已存储着文件前几个块 DataNode 地址的 DFSInputStream 随即连接到文件中第一个块的最近的 DataNode 节点。通过对数据流反复调用 read() 方法,可以将数据从 DataNode 传输到客户端。

- 当该块快要读取结束时,DFSInputStream 将关闭与该 DataNode 的连接,然后寻找下一个块的最佳 datanode。这些操作对用户来说是透明的。所以用户感觉起来它一直在读取一个连续的流。

- 客户端从流中读取数据时,块是按照打开 DFSInputStream 与 DataNode 新建连接的顺序读取的。它也会根据需要询问 NameNode 来检索下一批数据块的 DataNode 位置信息。一旦客户端完成读取,就对 FSDataInputStream 调用 close() 方法。

- 如果 DFSInputStream 与 DataNode 通信时遇到错误,它将尝试该块的下一个最接近的 DataNode 读取数据。并将记住发生故障的 DataNode,保证以后不会反复读取该 DataNode 后续的块。此外,DFSInputStream 也会通过校验和(checksum)确认从 DataNode 发来的数据是否完整。如果发现有损坏的块,DFSInputStream 会尝试从其他 DataNode 读取该块的副本,也会将被损坏的块报告给 namenode 。

3.3 角色职责概述

3.3.1 Namenode职责

- NameNode 是 HDFS 的核心,集群的主角色,被称为 Master。

- NameNode 仅存储管理 HDFS 的元数据:文件系统 namespace 操作维护目录树,文件和块的位置信息。

- NameNode 不存储实际数据或数据集。数据本身实际存储在 DataNodes 中。

- NameNode 知道 HDFS 中任何给定文件的块列表及其位置。使用此信息 NameNode 知道如何从块中构建文件。

- NameNode 并不持久化存储每个文件中各个块所在的 DataNode 的位置信息,这些信息会在系统启动时从 DataNode 汇报中重建。

- NameNode 对于 HDFS 至关重要,当 NameNode 关闭时,HDFS / Hadoop 集群无法访问。

- NameNode 是 Hadoop 集群中的单点故障。

- NameNode 所在机器通常会配置有大量内存(RAM)。

3.3.2 Datanode职责

- DataNode 负责将实际数据存储在 HDFS 中。是集群的从角色,被称为 Slave。

- DataNode 启动时,它将自己发布到 NameNode 并汇报自己负责持有的块列表。

- 根据 NameNode 的指令,执行块的创建、复制、删除操作。

- DataNode 会定期(

dfs.heartbeat.interval配置项配置,默认是 3 秒)向 NameNode 发送心跳,如果 NameNode 长时间没有接受到 DataNode 发送的心跳, NameNode 就会认为该 DataNode 失效。 - DataNode 会定期向 NameNode 进行自己持有的数据块信息汇报,汇报时间间隔取参数

dfs.blockreport.intervalMsec,参数未配置的话默认为 6 小时。 - DataNode 所在机器通常配置有大量的硬盘空间。因为实际数据存储在 DataNode 中。

Namenode元数据管理及各组件工作机制

1. Namenode元数据管理

1.1 元数据是什么

元数据(Metadata),又称中介数据,为描述数据的数据(data about data),主要是描述数据属性(property)的信息,用来支持如指示存储位置、历史数据、资源查找、文件记录等功能。

在 HDFS 中,元数据主要指的是文件相关的元数据,由 NameNode 管理维护。从广义的角度来说,因为 NameNode 还需要管理众多 DataNode 节点,因此 DataNode 的位置和健康状态信息也属于元数据。

1.2 元数据管理概述

在 HDFS 中,文件相关元数据具有两种类型:

- 文件自身属性信息

- 文件名称、权限,修改时间,文件大小,复制因子,数据块大小。

- 文件名称、权限,修改时间,文件大小,复制因子,数据块大小。

- 文件块位置映射信息

- 记录文件块和 DataNode 之间的映射信息,即哪个块位于哪个节点上。

- 按存储形式分为内存元数据和元数据文件两种,分别存在内存和磁盘上。

1.2.1 内存元数据

为了保证用户操作元数据交互高效,延迟低,NameNode 把所有的元数据都存储在内存中,我们叫做内存元数据。内存中的元数据是最完整的,包括文件自身属性信息、文件块位置映射信息。

但是内存的致命问题是,断点数据丢失,数据不会持久化。因此 NameNode 又辅佐了元数据文件来保证元数据的安全完整。

1.2.2 磁盘元数据

1.2.2.1 fsimage内存镜像文件