摘要

在本文中,一个新的通信效率联邦学习(FL)框架,启发矢量量化压缩感知。所提出的框架的基本策略是压缩本地模型更新在每个设备应用降维,然后由矢量量化。随后,通过将稀疏信号恢复算法应用于压缩的局部模型更新的聚合,在参数服务器处重构全局模型更新。通过利用降维和矢量量化的好处,所提出的框架有效地减少了本地更新传输的通信开销。矢量量化器的设计和压缩的关键参数进行了优化,以最小化的全局模型更新的无线链路容量的约束下的重建误差。 通过考虑重构误差,对非凸损失函数的收敛速度进行了分析。MNIST和CIFAR-10数据集上的仿真结果表明,所提出的框架提供了超过2.5的分类精度相比,国家的最先进的FL框架时,本地模型更新传输的通信开销小于0.1比特每个本地模型条目。

一、引言

联邦学习(FL)是一种分布式机器学习技术,其旨在通过与分布式无线设备协作在参数服务器(PS)上训练全局模型,每个设备都具有自己的本地训练数据集[ 1,2,3,4,5]。在典型的FL框架中,每个设备基于本地训练数据集更新其本地模型,然后向PS发送本地模型更新[ 2]。在来自设备的传输之后,PS通过聚合由设备发送的本地模型更新来更新其全局模型,然后将更新的全局模型分发给设备。该两步训练过程继续进行,直到PS处的全局模型收敛。上述FL框架可以帮助保护由设备生成的数据的隐私。因此,它作为集中式机器学习的隐私保护替代方案引起了极大的关注[3,4,5,6,7,2]。 虽然FL在数据隐私方面提供了重要的好处,但将这项技术引入到现实世界的应用中也面临着一些挑战。一个主要的这样的挑战是将本地模型更新从无线设备传输到PS所需的显著通信开销,因为连接它们的无线链路在实际通信系统中可能具有有限的容量。当本地模型更新的维度比无线链路的容量大得多时,这个挑战变得至关重要。例如,当无线链路容量是Mbps时,发送本地模型更新以利用可训练参数训练ResNet-in[ 8]的时间花费大约几秒,这对于通常必须以低得多的延迟操作的实际无线FL用例可能是不可接受的。

为了解决上述挑战,在[ 9,10,11,12,13,14,15]中广泛研究了经由局部模型更新压缩的通信高效FL。在这些现有工作中的基本思想是将有损压缩应用于本地模型更新,以便减少传输这些更新所需的通信开销。该方向上的代表性方法是在[ 9,10,11,12]中研究的标量量化方法,其中局部模型更新的条目由标量量化器独立量化。通过扩展该方法,在[13,14,15]中还研究了用于通信高效FL的矢量量化方法。在该方法中,每个局部模型更新的分区由向量量化器量化。仅量化方法的共同局限性。当本地模型更新传输通信开销必须小于每个本地模型条目一比特时,显著的量化误差是不可避免的。

最近,为了克服仅量化方法的限制,在[16,17,18]中已经探索了经由量化压缩感知(QCS)的通信高效FL。这种方法的一个关键动机是局部模型更新的稀疏性,自然地或通过应用稀疏化获得[ 19,20,21,22,23,24]。为了利用这种稀疏性,QCS方法的基本前提是将局部模型更新投影到较低维空间上,如在压缩感知(CS)中,然后再量化它们。由于随后的维数降低,当与仅量化方法相比时,该方法可以进一步降低本地更新传输的通信开销。在[ 16]和[ 17]中研究了具有一位量化的基于QCS的压缩方法,其中,通过一位标量量化器对降维后的局部模型更新的条目进行独立量化。 该方法在[ 18]中被扩展到具有多比特量化的压缩,这允许关于标量量化比特的数量的更大灵活性。[ 18]中的工作表明,与一位量化[ 18]相比,多位量化的使用在通信效率和FL性能之间提供了更好的折衷。然而,现有的基于QCS的压缩方法仅考虑标量量化,其在量化误差方面通常劣于矢量量化[ 32];因此,随着压缩级别的增加,这些方法的压缩误差变得有问题。据我们所知,利用矢量量化和降维的好处的本地模型更新压缩从来没有被研究过,尽管它的潜力,提高FL的通信效率和减轻本地模型更新的压缩错误。

本文的主要贡献是一个新的通信高效FL框架,利用,第一次,矢量量化和CS为基础的降维压缩本地模型更新在无线设备。我们还提出了一个有前途的策略,用于重建全局模型更新在PS从压缩的本地模型更新。更重要的是,我们通过优化矢量量化器的设计和压缩的关键参数,最大限度地减少重建误差,然后,我们分析了我们的框架的收敛速度,考虑到重建误差。总之,我们的主要贡献包括:

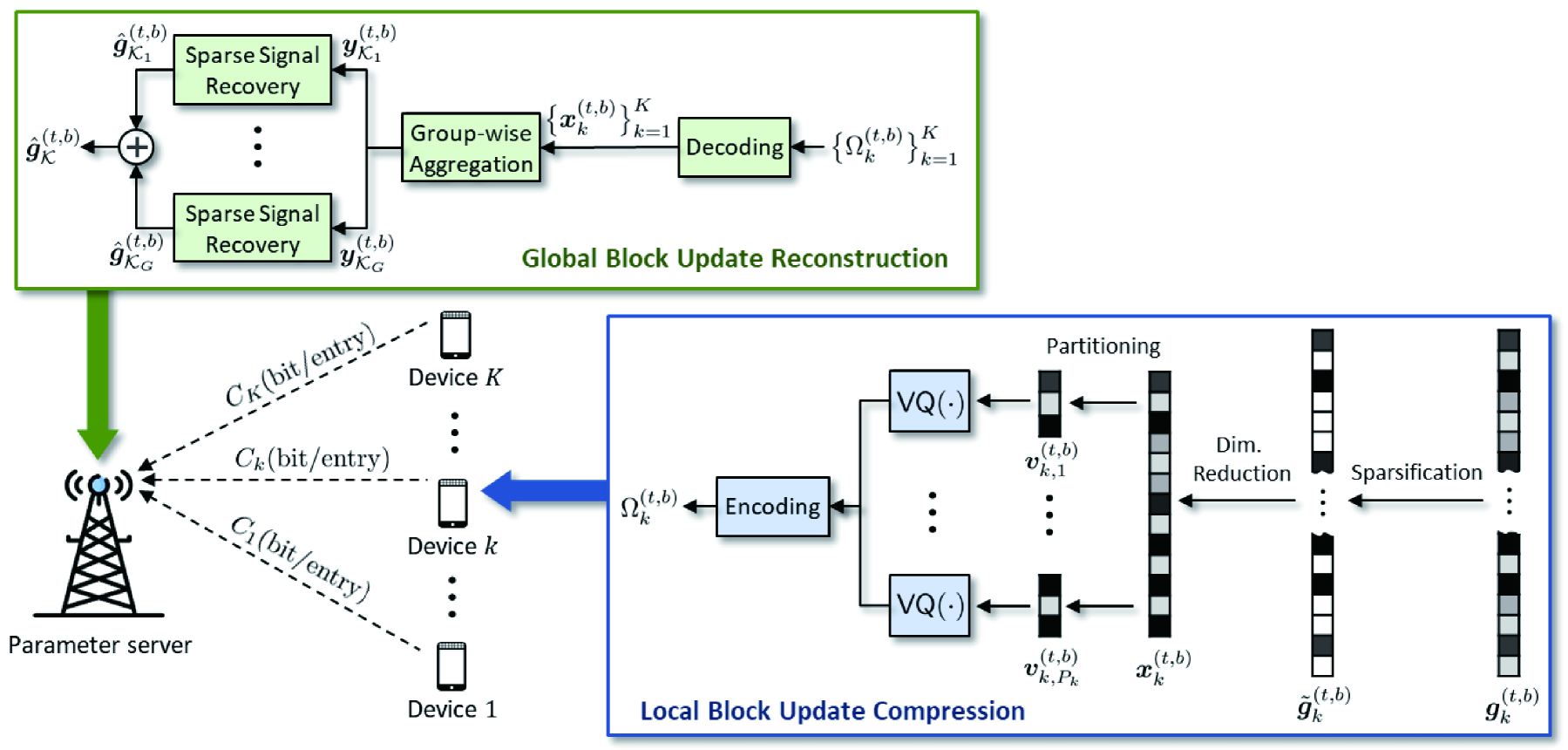

·我们通过矢量量化压缩感知(VQCS)提出了一个通信高效的FL框架,称为FedVQCS。在这个框架中,我们压缩每个本地模型更新,通过降低其维数CS的基础上,然后,量化低维的本地模型更新使用矢量量化器。为了在PS处准确但高效地重建全局模型更新,我们聚合一组压缩的本地模型更新,然后,通过应用稀疏信号恢复算法估计聚合模型更新。通过利用降维和矢量量化两者的好处,FedVQCS显著降低了在无线设备处传输本地模型更新所需的通信开销。

·优化了用于FedVQCS局部更新压缩策略的矢量量化器的设计。我们的压缩策略的一个关键特点是,局部模型更新后,CS基于降维,可以建模为一个独立的和同分布(IID)高斯随机向量的中心极限定理。通过利用该特征,我们分别基于Lloyd-Max算法[ 25]和Grassmanian码本[ 26]推导出IID高斯随机向量的最佳形状和增益量化器。我们还推导出形状和增益量化器之间的最佳位分配,通过表征这些量化器的均方误差(MSE)性能。

·我们优化了FedVQCS的局部更新压缩策略的关键设计参数,包括:(i)量化比特数,(ii)稀疏水平,和(iii)降维比。特别是,我们确定这些参数的最佳集合,用于在容量约束下使PS处的全局模型更新的重构误差最小化。我们的参数优化的一个突出特点是,它可以在本地执行在每个设备之间没有信息交换的设备。

·我们分析了FedVQCS在考虑全局模型更新在PS处的重建误差的情况下的收敛速度。我们的分析表明,FedVQCS是保证收敛到一个平稳点的光滑损失函数的速率,其中是随机梯度下降(SGD)算法的总迭代次数。我们的分析还表明,收敛速度的上限随着在PS处重建的全局模型更新的MSE减小而减小,这意味着我们的参数优化有助于提高FL的收敛速度。

·使用模拟,我们证明了FedVQCS在使用MNIST数据集[ 27]和CIFAR-10数据集[ 28]的图像分类任务中优于最先进的FL框架。我们的模拟结果表明,FedVQCS提供了超过2.5的分类精度相比,国家的最先进的FL框架时,本地模型更新传输的通信开销小于0.1位每个本地模型条目。同时,MNIST数据集的结果表明,FedVQCS与0.1比特的开销,每个本地模型条目产生只有2的分类精度下降时,与执行本地更新压缩的情况相比。FedVQCS参数优化的有效性也从分类精度方面进行了验证。

二、系统模型

考虑无线FL系统,其中PS通过在具有有限容量的无线链路上与一组无线设备协作来训练全局模型。假设用于训练全局模型的数据样本仅分布在无线设备上,而PS不直接访问它们。设为设备处可用的本地训练数据集。假设PS处的全局模型由参数向量表示,其中是全局模型参数的数量。FL的目标是找到最小化全局损失函数的最佳参数向量,定义为

(1)中的全局损失函数可以重写为

II-A典型FL框架

用于最小化(2)中的全局损失函数的典型FL方法涉及在每个通信回合中在无线设备处的局部模型更新和PS处的全局模型更新之间交替,如[ 2]中所解释的。

II-A1无线设备的本地模型更新

在本地模型更新过程中,每个无线设备基于其自己的本地训练数据集来更新本地参数向量。则每个设备发送本地模型更新(即,局部更新之前和之后的参数向量之间的差)到PS。设为在通信轮中由设备共享的参数向量,其中为通信轮的总数。假设每个设备采用具有局部迭代的小批量SGD算法来更新参数向量。然后,在局部迭代之后在设备处的更新的参数向量由下式给出:

![]()

其中, η是局部学习率,

由设备轮中发送的本地模型更新被确定为

II-A2 PS的全球模型更新

在全局模型更新过程中,PS通过聚合由设备发送的本地模型更新来更新全局参数向量。然后,PS向这些设备广播更新的参数向量。在局部模型更新的完美接收的假设下,PS可以重构全局模型更新,定义为

其中在每个通信回合中是不变的。如果PS采用SGD算法来更新参数向量,则轮中更新的参数向量将由下式给出

![]()

其中γ是全局学习率。然后,PS向无线设备广播w,这触发了本地模型更新过程的t+1轮开始。

II—B 无线FL关键挑战

在实现FL框架中的一个主要挑战。II-A是将本地模型更新从无线设备传输到PS所需的显著通信开销,因为连接它们的无线链路在实际通信系统中可能具有有限的容量。该挑战可以通过将有损压缩应用于局部模型更新来缓解,但是这样的压缩方法导致在PS处重构的全局模型更新中不可避免的错误。此外,通常,无线设备处的压缩水平越高,PS处的重构误差越大。因此,它是必要的,开发一个严格的压缩策略本地模型更新,提供了一个相当大的减少通信开销,同时也最小化重建误差在PS。

三、拟议的FedVQCS框架

在本节中,我们提出了一个通信高效的FL框架,称为FedVQCS,它可以减少用于在无线设备处传输本地模型更新的通信开销,同时还能够在PS处准确重建全局模型更新。

图1:当部署在无线网络上时,所提出的FL框架内的单个通信回合的图示。

III-A FedVQCS概述

III-A1本地模型更新的压缩

在每个通信轮中,每个设备将其本地模型更新划分为块,每个块的长度为。设为的第_块,并且我们将该向量称为轮中设备的第_局部块更新。每个设备通过应用由函数表示的本地块压缩过程来并行地压缩这些本地块更新。这种逐块压缩背后的动机是降低在PS处重建全局模型更新的计算复杂度,如[ 18]中所考虑的。压缩的本地块更新被编码成数字比特,然后通过无线链路发送到PS。

III-A2全球模型更新的重建

在每个通信回合中,PS根据由无线设备发送的压缩的本地模型更新来重构全局模型更新。

III-A3总结

FedVQCS的整个过程总结在过程1中,而局部块压缩和全局块重建过程分别总结在过程2和过程3中。在本节的剩余部分中,我们详细说明了局部块压缩过程(参见第2节)。III-B)和全局块重建过程(参见第III-C)。在随后的部分中,我们将解释如何设计用于局部块压缩过程的矢量量化器(参见第2节)。IV-A)以及如何优化该压缩过程的设计参数(参见第二节。IV-B)。我们还将分析FedVQCS的收敛速度。IV-C。最后,我们将证明FedVQCS优于现有的FL框架在第二。五、

1411

1411

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?