个人觉得讲的蛮好的入门资料,用笔记总结一下。

基本概念

(1)随机变量 Random Variable

大写字母:随机变量 小写字母:观测值

(2) Randomness in RL:

Actions have randomness.

States transitions have randomness.

(3)Return

(3)Return

Return

U

t

U_{t}

Ut: cumulative future reward

Given

s

t

s_{t}

st, the return

U

t

U_{t}

Ut依赖于随机变量

A

t

A_{t}

At … and

S

t

+

1

S_{t+1}

St+1 …

Given

s

t

s_{t}

st, the return

U

t

U_{t}

Ut依赖于随机变量

A

t

A_{t}

At … and

S

t

+

1

S_{t+1}

St+1 …

(4)Value Functions

把

U

t

U_{t}

Ut 当作未来所有动作a和状态s的函数,动作a和状态s都有随机性

-动作a的概率密度函数是policy function

π

(

a

∣

s

)

\pi(a|s)

π(a∣s)

-状态s是状态转移函数State transition function

p

(

s

′

∣

s

,

a

)

p(s'|s,a)

p(s′∣s,a)

- Action Value Function

对 U t U_{t} Ut 求期望,将随机性用积分积掉(除了 s t s_{t} st 和 a t a_{t} at 其余随机变量都被积掉),得到动作-价值函数

动作-价值函数

Q

π

(

s

t

,

a

t

)

Q_{\pi}(s_{t},a_{t})

Qπ(st,at)依赖于

s

t

s_{t}

st 和

a

t

a_{t}

at,还与policy函数

π

\pi

π有关。不同的policy函数

π

\pi

π会有不同的

Q

π

Q_{\pi}

Qπ。

直观意义是:如果用policy函数

π

\pi

π, 在状态

s

t

s_{t}

st下做动作

a

t

a_{t}

at是好还是坏。已知policy函数

π

\pi

π,

Q

π

(

s

t

,

a

t

)

Q_{\pi}(s_{t},a_{t})

Qπ(st,at)会给当前状态下所有action打分。

- Optimal action-value function

Q

∗

(

s

t

,

a

t

)

Q^{*}(s_{t},a_{t})

Q∗(st,at)

把 π \pi π去掉的方法: Q π ( s t , a t ) Q_{\pi}(s_{t},a_{t}) Qπ(st,at)最大化,取得使 Q π ( s t , a t ) Q_{\pi}(s_{t},a_{t}) Qπ(st,at)最大化的 π \pi π

Q ∗ ( s t , a t ) Q^{*}(s_{t},a_{t}) Q∗(st,at)与policy π \pi π无关,在状态 s t s_{t} st的情况下,对动作 a t a_{t} at作评价

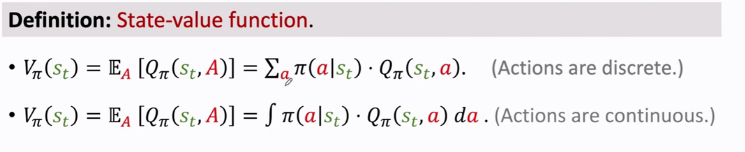

- State-Value Function V ( s ) V(s) V(s)

状态价值函数

V

(

s

)

V(s)

V(s)是对

Q

π

(

s

t

,

a

t

)

Q_{\pi}(s_{t},a_{t})

Qπ(st,at)求期望,A作为随机变量,对A求期望,把A消掉得到

V

π

(

s

t

)

V_{\pi}(s_{t})

Vπ(st),只与

π

\pi

π和

s

t

s_{t}

st有关。

V

π

(

s

t

)

V_{\pi}(s_{t})

Vπ(st)的直观意义:用于评价当前局势好坏。

对A求期望,A的概率密度是

π

(

⋅

∣

s

t

)

\pi( \cdot |s_{t})

π(⋅∣st),根据期望的定义,可以把期望写成连加(动作离散)或积分(动作连续)的形式。

对A求期望,A的概率密度是

π

(

⋅

∣

s

t

)

\pi( \cdot |s_{t})

π(⋅∣st),根据期望的定义,可以把期望写成连加(动作离散)或积分(动作连续)的形式。

小结:

小结:

(5)How does AI control the agent:

(5)How does AI control the agent:

Two methods:

Policy-Based Learning 策略学习 v.s. Value-Based Learning价值学习

-

Summary

[1] https://www.bilibili.com/video/BV1BE411W7TA?t=864

406

406

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?