第59课:使用Java和Scala在IDE中实战RDD和DataFrame转换操作’学习笔记

本期内容:

1 RDD与DataFrame转换的重大意义

2 使用Java实战RDD与DaraFrame转换

3 使用Scala实战RDD与DataFrame转换

一. RDD与DataFrame转换的重大意义

在Spark中RDD可以直接转换成DataFrame。SparkCore的核心是RDD,所有的调度都是基于RDD完成的,对RDD的操作都可以转换成基于DataFrame使用SparkSQL来操作。RDD可能接上数据库,接上NoSQL,其他文件系统等各种数据来源,然后将数据转换为DataFrame,

极大简化了大数据的开发,原来写Scala\Java,现在只需要写SparkSQL。

同时对DataFrame的操作又可以转换成RDD,基于DataFrame对数据进行SQL或机器学习等操作后又可以转换为RDD,这对于保存数据、格式化非常方便。

RDD变DataFrame有两种方式:

1.通过反射,推断RDD元素中的元数据。

RDD中的数据本身是没有元数据的,例如一个Person的信息里有id/name/age,RDD的Record不知道id/name/age这些信息,但如果变成DataFrame的话,DataFrame必须知道这些信息。如何在RDD和DataFrame转换时拥有这些元数据信息呢?最简单的就是通过反射。

在Scala中就是Case Class映射。写一个Case Class,描述RDD中不同列的元数据是什么。

在Java中就是通过JavaBean。

Scala:case class映射。

Java:Bean(但不能支持嵌套的JavaBean,也不能有List/Map等复杂的数据结构。只能用简单的数据类型:String/Int等。Scala就没有这些限制)

使用反射的前提:已经知道元数据信息了(静态的)。但有些场景下只有在运行时才能知道元数据信息(动态的)

2. 创建DataFrame时事先不知道元数据信息,只能在运行时动态构建元数据。然后再把这些元数据信息应用于RDD上。这种情况是比较常见的情况,即动态获取Schema。

class Person{

private int id;

private String name;

private int age;

}

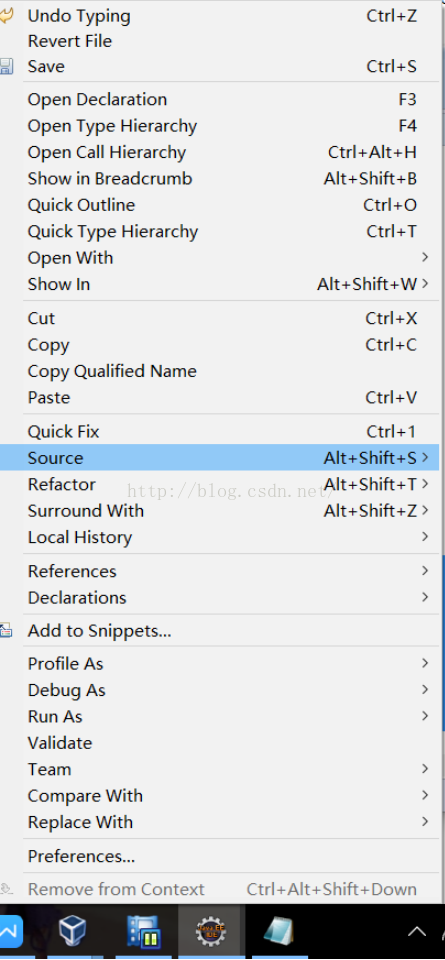

点击右键,选择source -> Generate Getters and Setters

选择age、id、name后点击OK。

本文介绍了在Spark中RDD到DataFrame转换的重要性,包括简化大数据开发和便于数据处理。通过Java和Scala的示例展示了如何使用反射和DataFrame API将RDD转换为DataFrame,并实现数据过滤操作。文章还提到了转换过程中可能遇到的权限和序列化问题及其解决方案。

本文介绍了在Spark中RDD到DataFrame转换的重要性,包括简化大数据开发和便于数据处理。通过Java和Scala的示例展示了如何使用反射和DataFrame API将RDD转换为DataFrame,并实现数据过滤操作。文章还提到了转换过程中可能遇到的权限和序列化问题及其解决方案。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1185

1185

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?