Spark主要是内容:

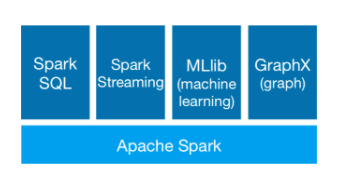

通过一张图来看spark的主要内容如下:

由此可以看出,学习spark其实就是学习以上五个部分内容:

一、Spark Core (Apache Spark)

内核,是Spark中最重要的内容,相当于MapReduce, 都是进行离线计算,Spark Core的核心是:RDD(弹性分布式数据集),由分区组成。

二、Spark SQL

相当于Hive、Pig 支持SQL和DSL语句,其本质上将SQL语句转化成Spark任务(RDD)提交到集群上运行。

三、Spark Streaming

相当于Storm,实现流式计算,其本质就是RDD,把连续的数据 变成不连续的数据DStream(离散流),然后进行计算而已。

四、MLLib

机器学习领域的,类似于mahout。

五、GraphX

图计算,一种对图的计算技术。

434

434

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?