关于线性回归

线性回归一直是最广泛使用的回归方法之一,也是统计学中基本的分析方法。它在今天仍然被广泛使用,是因为线性关系比非线性关系更容易建模,所得模型解释也更容易。

简单线性回归

例如使用UCI波士顿房屋数据集,这个数据集数量比较小,并不代表大数据问题,但是可以拿来说明算法。

数据集包含了波士顿郊区的自住住房的平均值,以及可用于预测房屋价值的13个特征,包括犯罪率、住宅的房间数量、高速公路的可达性等。如上图所示,x轴代表平均房间数量,y轴代表平均价格,两个变量之间显然有相关性。线性回归使用户能够找到通过这些数据点中间的一条线,并以此估算出它们的这种相关性。

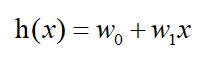

要在二维空间中绘制一条线需要两个值:线的斜率和线与y轴相交的值,也就是截距。如果房间数量为x,房价为h,以及截距和斜率分别为w0和w1,则用下面的公式描述:

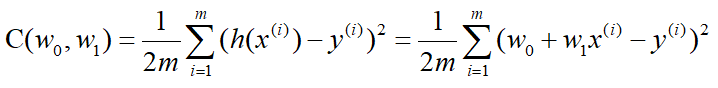

目标是找到最合适数据的权重w0和w1,方法是最小化cost function。cost function如下:

这是所使用的数据集中所有m个实例的目标值域实际值之间的二次方差的平均值(均方误差)。如果基w0,w1绘制cost function,则它在三维空间中形成一个曲面,如下图所示:

将模型扩展到多元线性回归

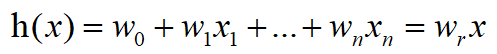

有一个很好的方法来找到cost function的最小值,但是需要先扩展模型以使用多元线性回归。将剩余的12个维度添加到数据集后,函数就变成

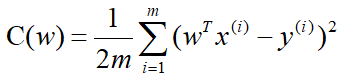

重写多元线性回归模型的cost function如下:

使用正则方程法找到最小值

关于权重w0至wn的成本函数最小化的问题的向量化解由正则方程式给出:

使用梯度下降求最小值

前面的公式直接求解这个方程可能需要花费大量的资源,特别是如果数据集中有大量的维度,那么最常用的方法是梯度下降法。

梯度下降算法迭代工作,它从某一点开始,代表权重参数的猜测,并且对于每个权重参数wj计算相对于该权重参数的cost function的偏导数。偏导数告诉算法如何更改有问题的权重参数,以尽可能快的降到成本函数的最小值,如下图所示:

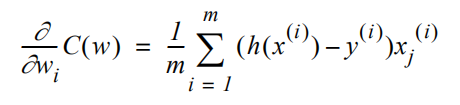

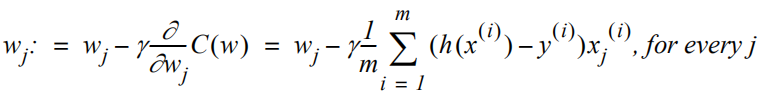

对于任何权重参数wj,cost function的偏导数如下

可以使用此值来更新权重参数wj以降低cost function的值。更新权重的方法如下

1289

1289

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?