来源:专知

本文约1000字,建议阅读5分钟我们提出了一种新颖的内存增强的高频交易情境感知强化学习方法。

MacroHFT:内存增强的高频交易情境感知强化学习

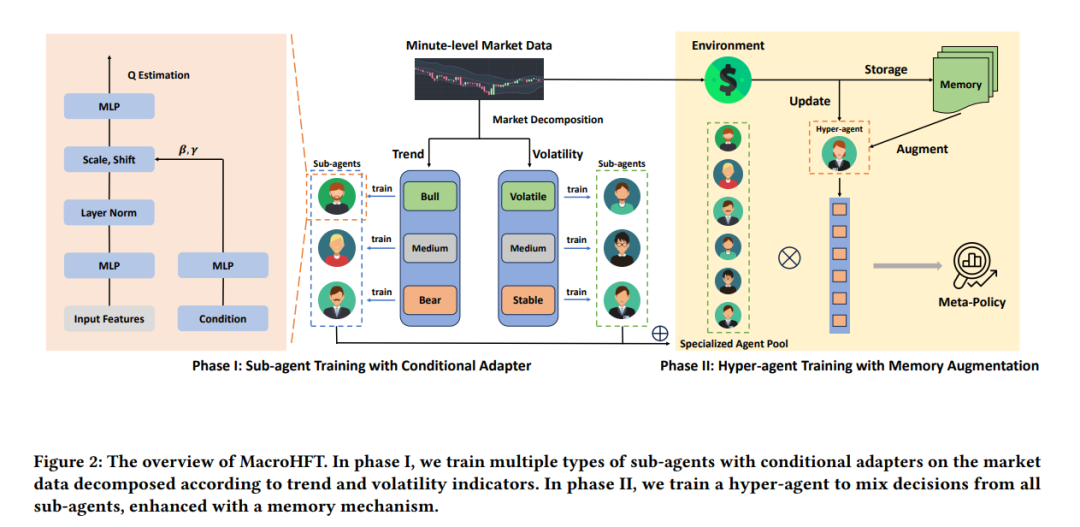

高频交易(HFT)在短时间尺度内执行算法交易,近年来已占据了加密货币市场的大部分份额。除了传统的量化交易方法外,强化学习(RL)由于其处理高维金融数据和解决复杂的序列决策问题的能力,成为HFT的另一种有吸引力的方法。例如,分层强化学习(HRL)通过训练一个路由器从代理池中选择一个子代理来执行当前交易,展示了其在秒级HFT中的出色表现。然而,现有的用于HFT的RL方法仍然存在一些缺陷:1)标准的基于RL的交易代理存在过拟合问题,无法根据金融背景进行有效的策略调整;2)由于市场条件的快速变化,由单个代理做出的投资决策通常是片面的和高度偏颇的,这可能导致在极端市场中产生重大损失。为了解决这些问题,我们提出了一种新颖的内存增强的高频交易情境感知强化学习方法,简称MacroHFT,包括两个训练阶段:1)我们首先根据市场趋势和波动等各种金融指标分解市场数据,训练多种类型的子代理,每个代理都拥有一个条件适配器,以根据市场条件调整其交易策略;2)然后我们训练一个超级代理来混合这些子代理的决策,并输出一个一致盈利的元策略以应对快速的市场波动,并配备内存机制以增强决策能力。对各种加密货币市场的广泛实验表明,MacroHFT可以在分钟级交易任务中实现最先进的性能。代码已在[此处](https://github.com/ZONG0004/MacroHFT)发布。

关键词:高频交易,强化学习,分层强化学习,内存增强,市场波动,金融数据

关于我们

数据派THU作为数据科学类公众号,背靠清华大学大数据研究中心,分享前沿数据科学与大数据技术创新研究动态、持续传播数据科学知识,努力建设数据人才聚集平台、打造中国大数据最强集团军。

新浪微博:@数据派THU

微信视频号:数据派THU

今日头条:数据派THU

77

77

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?