- 题目:Efficient Quantization for Neural Networks with Binary Weights and Low Bitwidth Activations

- 时间:2019

- 会议:AAAI

- 研究机构:上海交大倪冰冰

1 abstract & introduction

本篇论文的主要贡献:

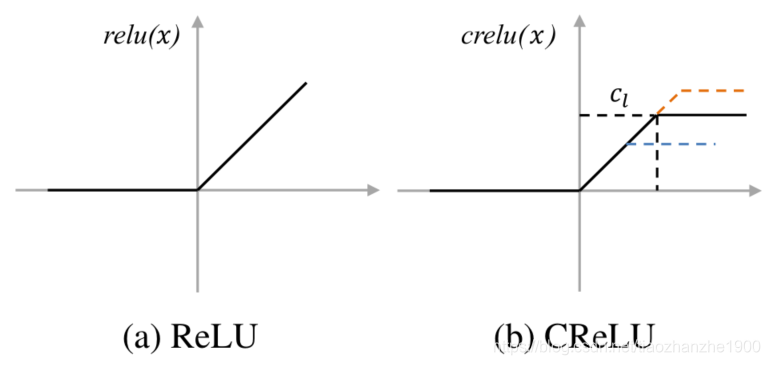

- 设计了一个新的激活函数CReLU

- 提出了多层二值化和线性/对数量化方法

- 最终的结果可以实现二值化的权重效果超过全精度模型

2 Clamping Rectified Linear Unit

过去有很多二值化网络的工作,他对之前的工作进行了总结,发现二值化网络的一些特性制约了行动

unbounded characteristic is disadvantageous for quantization since some outliers on the tail of distribution can lead to large quantization errors

无界特性不利于量化,因为分布尾部的一些异常值会导致较大的量化误差

于是提出了带上界的ReLU

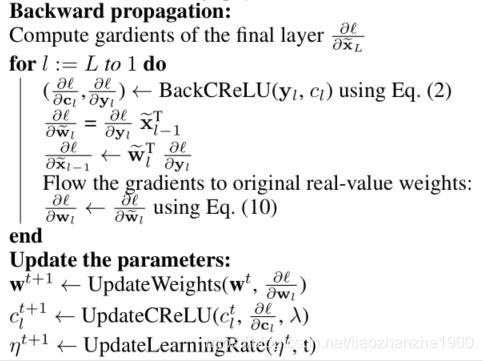

后向传播是

损失函数是:

其中C是原来网络的损失函数,后面加一项就好了,g表示一次范式或二次范式

3 量化方法

3.1 前向近似

本质就是用二值化的数拟合训练好的权重,设

b

i

b_i

bi表示第i个kernel,加粗表示是个向量,

α

i

\alpha_i

αi表示第i个kernel的缩放值scale:

最小化二者之间的残差,这是NP难问题,他用贪心法解决

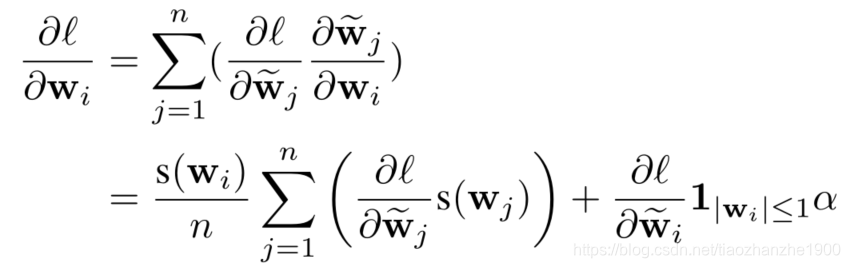

3.2 后向近似

w带波浪线的表示量化之后的数值,s表示符号函数

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?