概述

使用Scrapy框架爬取参考消息网“整站”新闻

(其实只是爬取了六大类中的所有新闻,因为其它页面中的url链接有点乱,需要单独处理,这里只是为了练习整站爬虫的思路)

代码逻辑如下:

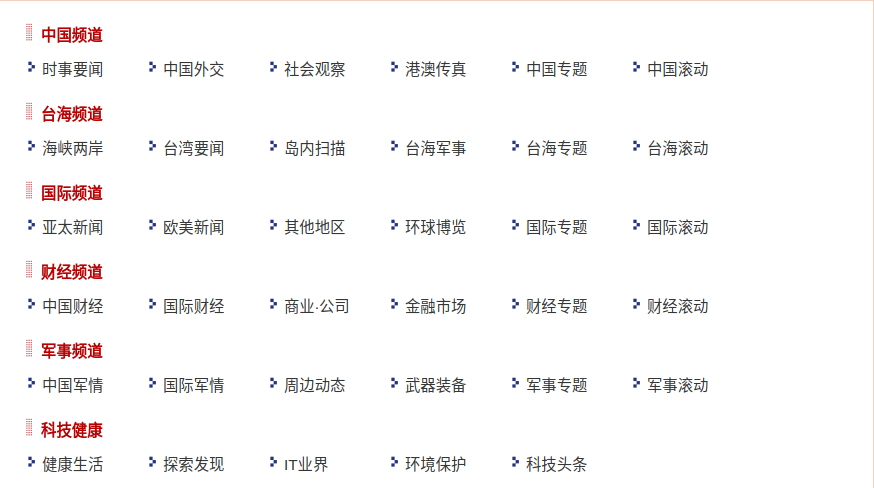

1. 先从网站导航页面提取分类信息(一级分类和二级分类);

2.然后根据二级分类中的链接跳转到新闻列表页面,爬取每一条新闻的链接

3. 根据新闻条目链接,跳转到新闻详情页,爬取最终需要的信息

遇到的问题及其解决办法:

1.编码问题。在爬取到数据后,拼接文件保存路径时,总是报编码错误(编码很重要)

最后才意识到,因为Scrapy返回的数据经过extract()方法处理为Unicode格式,而PYthon默认格式为UTF-8。

所以,解决办法就是把自己写的字符串解码为Unicode格式,如下:

news_dir=u"{}{}{}{}".format(b_dir,'/'.decode(),news_title,'.txt'.decode())

每一条新闻都有自己所属的分类(一级分类和二级分类),但是它们的路径需要通过方法进行传递。

传递时机,决定了最后的真实保存路径。经过分

本文介绍了如何使用Scrapy框架爬取参考消息网的新闻。首先从导航页面抓取分类信息,接着根据二级分类爬取新闻列表页的链接,并进一步获取新闻详情页的内容。在爬取过程中,解决了编码问题和页码自增的处理。文章提供了items.py, cankaoxiaoxi_spider.py, pipelines.py和settings.py等关键源码。"

82720430,7935040,D型主从触发器的电路结构分析,"['FPGA', '数字电路', '触发器', '逻辑设计', '电路分析']

本文介绍了如何使用Scrapy框架爬取参考消息网的新闻。首先从导航页面抓取分类信息,接着根据二级分类爬取新闻列表页的链接,并进一步获取新闻详情页的内容。在爬取过程中,解决了编码问题和页码自增的处理。文章提供了items.py, cankaoxiaoxi_spider.py, pipelines.py和settings.py等关键源码。"

82720430,7935040,D型主从触发器的电路结构分析,"['FPGA', '数字电路', '触发器', '逻辑设计', '电路分析']

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

381

381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?