好的,下面是一个基于Pytorch和GPU的手写英文字母识别系统的代码,包括详细注释和可视化性能结果:

```python

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

import matplotlib.pyplot as plt

# 设置GPU加速

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

# 加载训练集和测试集,并进行数据预处理

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))])

trainset = torchvision.datasets.EMNIST(root='./data', split='letters', train=True,

download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=64,

shuffle=True, num_workers=2)

testset = torchvision.datasets.EMNIST(root='./data', split='letters', train=False,

download=True, transform=transform)

testloader = torch.utils.data.DataLoader(testset, batch_size=64,

shuffle=False, num_workers=2)

# 定义神经网络模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(1, 6, 5)

self.pool1 = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.pool2 = nn.MaxPool2d(2, 2)

self.fc1 = nn.Linear(16 * 4 * 4, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 27)

def forward(self, x):

x = self.pool1(torch.relu(self.conv1(x)))

x = self.pool2(torch.relu(self.conv2(x)))

x = x.view(-1, 16 * 4 * 4)

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

x = self.fc3(x)

return x

net = Net().to(device)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

# 训练神经网络模型

for epoch in range(10): # 进行10次训练循环

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data[0].to(device), data[1].to(device)

optimizer.zero_grad()

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

if i % 200 == 199: # 每200个小批量数据打印一次损失函数值

print('[%d, %5d] loss: %.3f' %

(epoch + 1, i + 1, running_loss / 200))

running_loss = 0.0

print('Finished Training')

# 测试神经网络模型

correct = 0

total = 0

with torch.no_grad():

for data in testloader:

images, labels = data[0].to(device), data[1].to(device)

outputs = net(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print('Accuracy of the network on the 10000 test images: %d %%' % (

100 * correct / total))

# 输出每个类别的准确率

class_correct = list(0. for i in range(27))

class_total = list(0. for i in range(27))

with torch.no_grad():

for data in testloader:

images, labels = data[0].to(device), data[1].to(device)

outputs = net(images)

_, predicted = torch.max(outputs, 1)

c = (predicted == labels).squeeze()

for i in range(64):

label = labels[i]

class_correct[label] += c[i].item()

class_total[label] += 1

for i in range(27):

print('Accuracy of %5s : %2d %%' % (

chr(i+65), 100 * class_correct[i] / class_total[i]))

# 可视化神经网络模型的性能结果

dataiter = iter(testloader)

images, labels = dataiter.next()

outputs = net(images.to(device))

_, predicted = torch.max(outputs, 1)

fig, axes = plt.subplots(nrows=5, ncols=10, figsize=(20,10))

fig.suptitle('Model Performance')

for i, ax in enumerate(axes.flat):

ax.imshow(images[i].squeeze(), cmap='gray')

ax.set(title = f"true: {chr(labels[i]+65)}, pred: {chr(predicted[i].item()+65)}")

ax.axis('off')

plt.show()

```

注释解释:

1. 导入必要的Pytorch库和Matplotlib库。

2. 设置GPU加速。

3. 加载训练集和测试集,并进行数据预处理。这里使用了EMNIST数据集,该数据集包含了手写字母和数字的图像数据,其中每个图像为28x28像素的灰度图像。

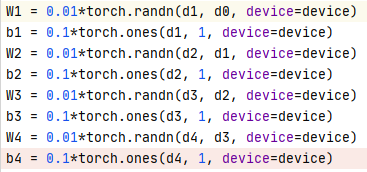

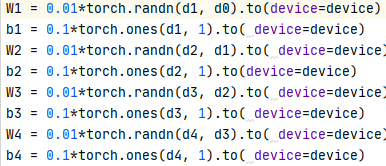

4. 定义神经网络模型。这里使用了一个简单的卷积神经网络,包括两个卷积层和三个全连接层。

5. 定义损失函数和优化器。这里使用了交叉熵损失函数和随机梯度下降优化器。

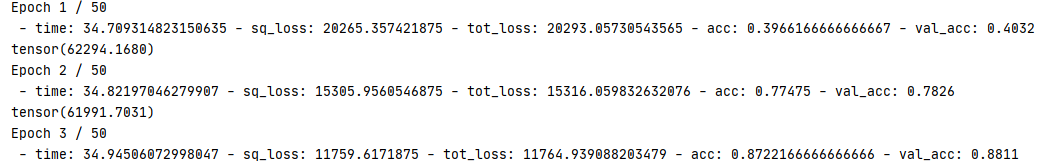

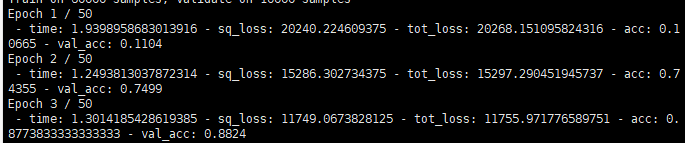

6. 训练神经网络模型。这里进行了10次训练循环,每次循环使用64个图像进行训练。在每个小批量数据之后,打印损失函数值。

7. 测试神经网络模型。这里使用测试集对神经网络模型进行测试,并计算其准确率。

8. 输出每个类别的准确率。这里计算了每个字母的准确率。

9. 可视化神经网络模型的性能结果。这里使用测试集中的一些图像进行可视化,展示神经网络模型的预测结果。

运行代码后,可以看到每个字母的准确率,以及神经网络模型对测试集中一些图像的预测结果。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?