由于输入参数过多,引入卷积神经网络。

卷积计算可认为是一种有效提取图像特征的方法。一般会用一个正方形(体),指定步长,在输入特征图上滑动,遍历输入特征图上的每个像素点。每一个步长,卷积核会与输入特征图出现重合的区域,重合区域对应元素相乘、求和再加上偏置项得到输入特征的一个像素点。

若输入图片是3通道的彩色图,那么卷积核的通道数也是3。

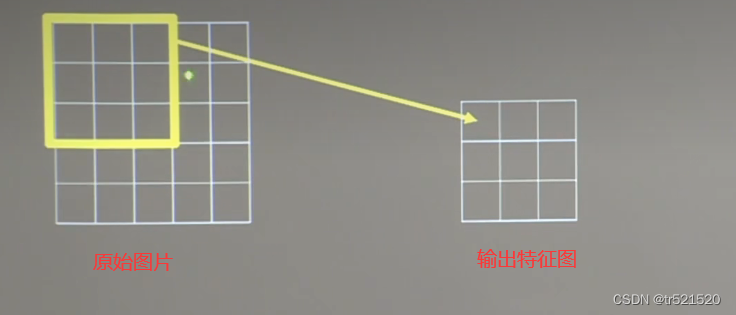

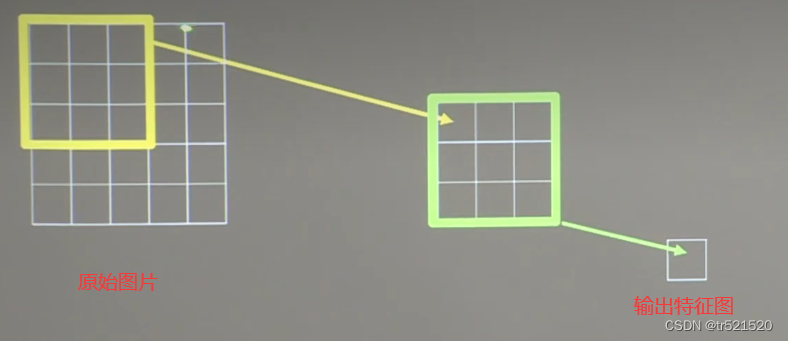

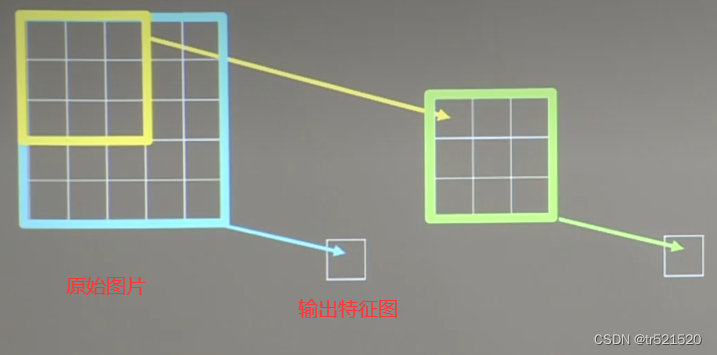

感受野

卷积神经网络各输出特征图中的每个像素点,在原始输入图片上映射区域的大小。

这个输出特征图的每个特征点映射到原始特征图是3*3的区域,所以它的感受野为3。

这个输出特征图的每个特征点映射到原始特征图是5*5的区域,所以它的感受野为5。

这个输出特征图的每个特征点映射到原始特征图是5*5的区域,所以它的感受野为5。

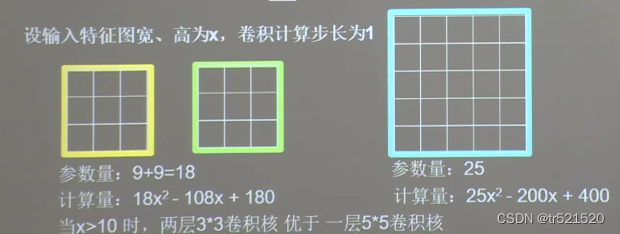

由于两层3*3卷积核和一层5*5卷积核得到的均为5*5的感受野,所以特征提取能力是一样的。

3²(x-3+1*)²+3²(x-3+1-3+1)² = 18x²-108x+180 5²(x-5+1)²+5²(x-5+1-5+1)²=25x²-200x+400

公式思想:都视为两层卷积核,3²表示一次卷积过程需要计算的次数,x-3+1表示横向和纵向需要移动次数(也是输出特征图大小的计算公式),所以(x-3+1*)²是第一次卷积时计算次数。第二个括号里第一次x-3+1指第一次卷积之后输出特征图的大小,第二个-3+1是计算横向移动次数。同理可计算卷积核大小为5的计算量

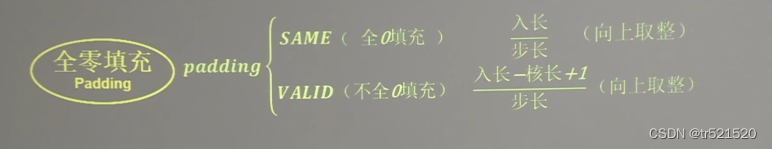

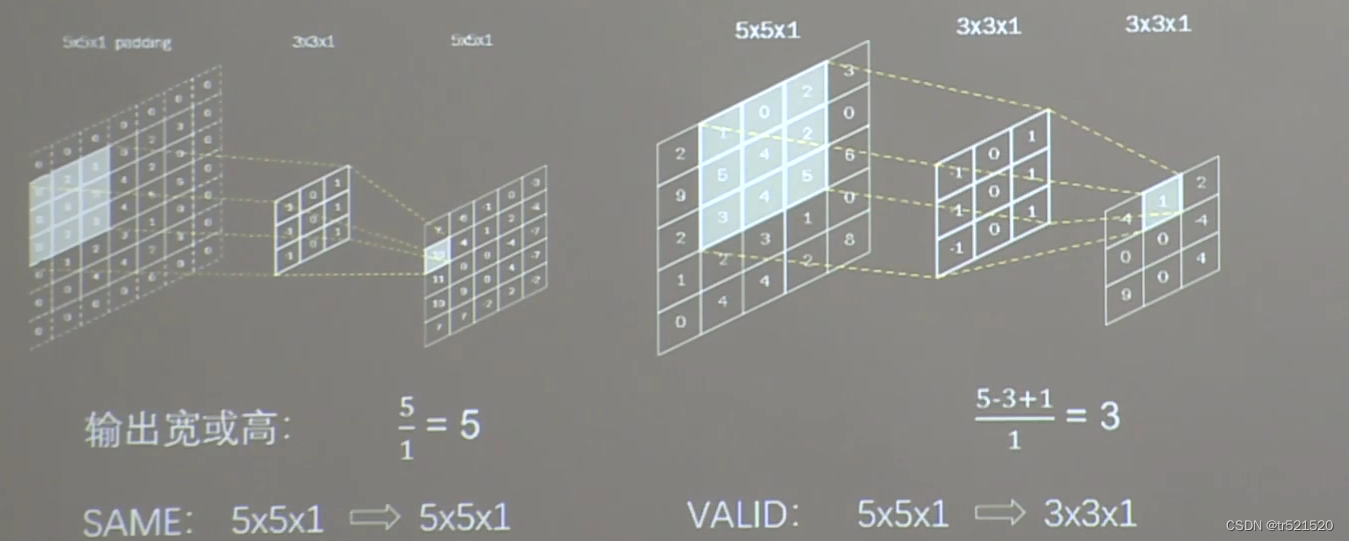

全0填充

TF描述全0填充

用参数padding="SAME" 或 padding="VALID"表示

TF描述卷积层

tf.keras.layers.Conv2D(

filter = 卷积核个数,

kernel_size = 卷积核尺寸,或者元组形式给出高和宽

strides = 滑动步长,

padding = "same" or "valid",

activation = "relu" or "sigmoid" or "tanh" or "softmax"等,

input_shape = (高,宽,通道数)

)

model = tf.keras.models.Sequential([

Conv2D(6, 5, padding="valid", activation="sigmoid"),

MaxPool2D(2, 2),

Conv2D(6, (5, 5), padding="valid", activation="sigmoid"),

MaxPool2D(2, (2, 2)),

Conv2D(filters=6, kernel_size=(5, 5), padding="valid", activation="sigmoid"),

MaxPool2D(pool_size=(2, 2), strides=2),

Flatten()

Dense(10, activation="softmax")

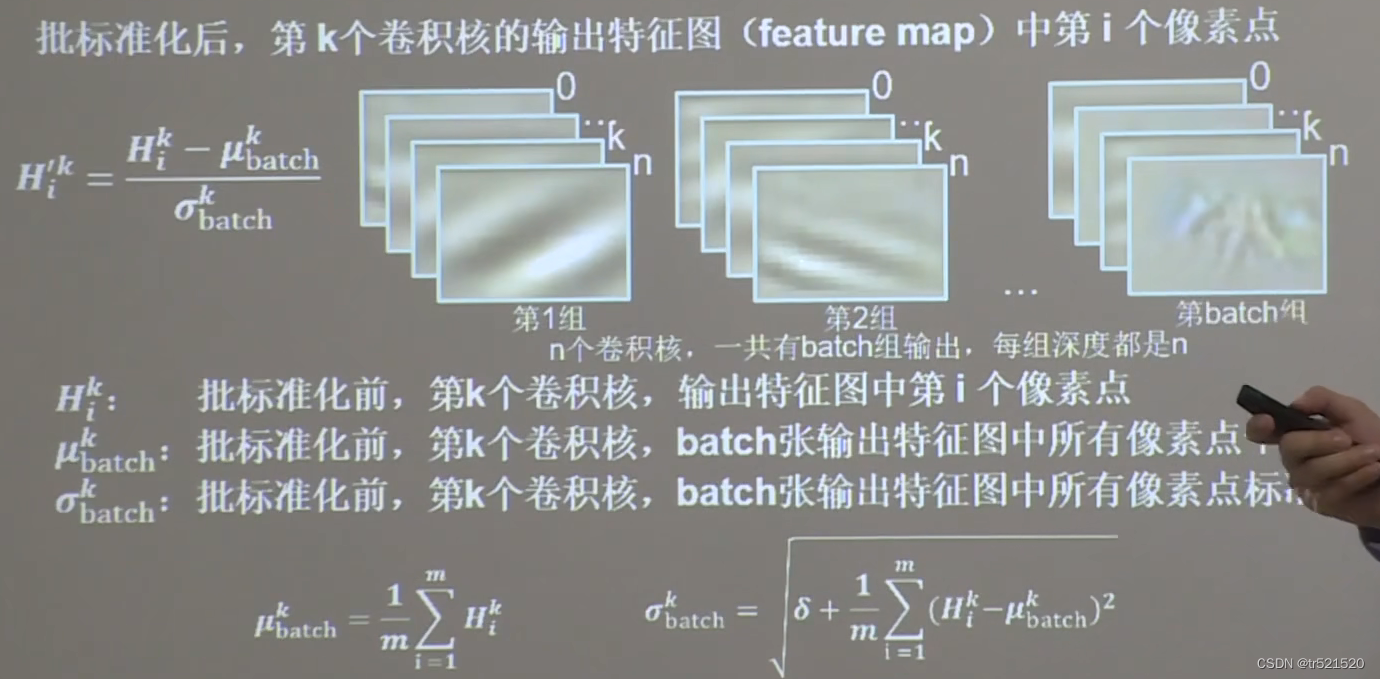

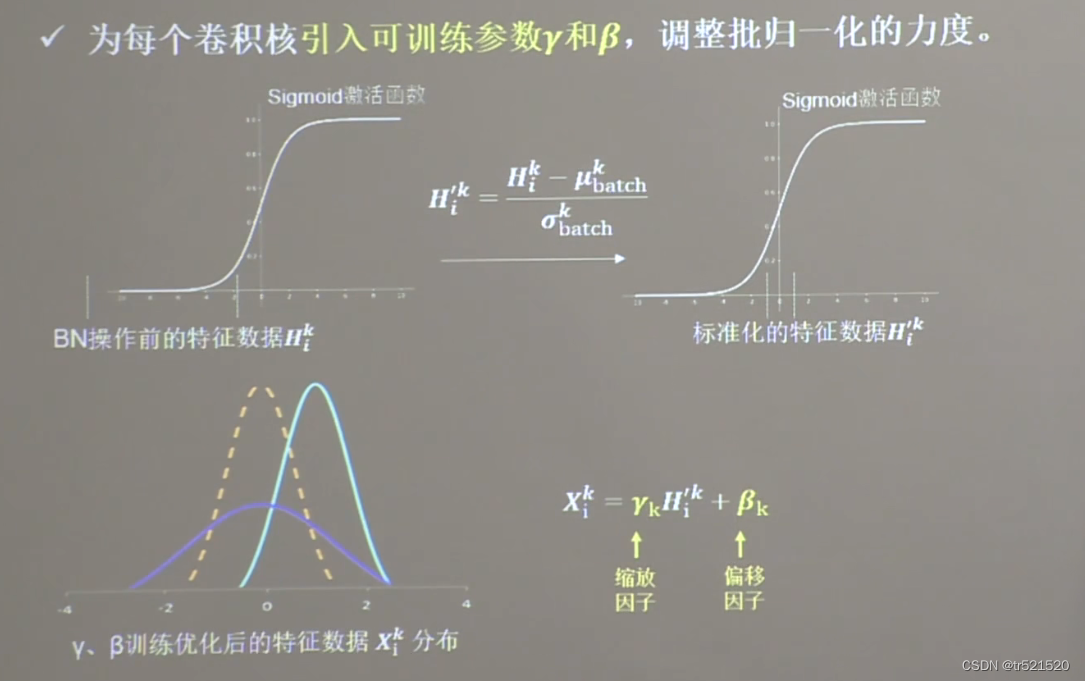

])批标准化

神经网络对0附近的数据更敏感,但是随着网络层数的增加,特征数据会出现偏离0均值的情况。

标准化:是数据符合0为均值,1为标准差的分布

批标准化:对一小批数据(batch),做标准化处理

批标准化在卷积层之后,激活层之前

model = tf.keras.models.Sequential([

Conv2D(filters=6, kernel_size=(5, 5), padding="same"),

BatchNormalization(),

Activation("relu"),

MaxPool2D(pool_size=(2, 2), strides=2, padding="same"),

Dropout(0.2)

])

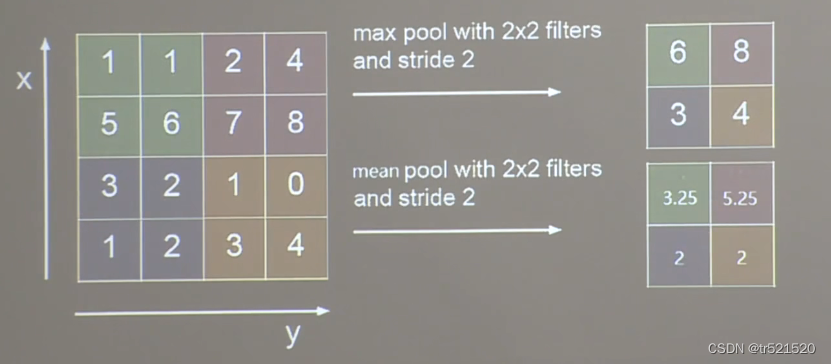

池化

用于减少特征数据量。

最大值化可提取图片纹理,均值池化可保持背景特征。

tf.keras.layers.MaxPool2D(

pool_size=池化尺寸,或者元组形式给出高和宽

stride=池化步长,或者(纵向h,横向w),默认为pool_size

padding="valid" or "same"

)

tf.keras.layers.AveragePooling2D(

pool_size=池化尺寸,或者元组形式给出高和宽

stride=池化步长,或者(纵向h,横向w),默认为pool_size

padding="valid" or "same"

)

model = tf.keras.models.Sequential([

Conv2D(filters=6, kernel_size=(5, 5), padding="same"),

BatchNormalization(),

Activation("relu"),

MaxPool2D(pool_size=(2, 2), strides=2, padding="same"),

Dropout(0.2)

])

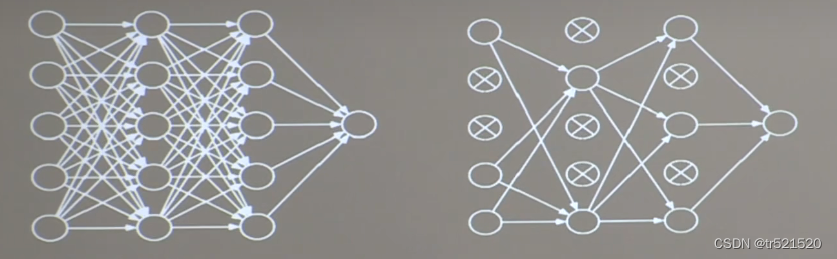

舍弃

在神经网络训练时,为了防止过拟合,通常将一部分神经元按照一定概率从神经网络中暂时舍弃。神经网络使用时,被舍弃的神经元恢复链接。

tf.keras.layers.Dropout( 舍弃的概率 )

model = tf.keras.models.Sequential([

Conv2D(filters=6, kernel_size=(5, 5), padding="same"),

BatchNormalization(),

Activation("relu"),

MaxPool2D(pool_size=(2, 2), strides=2, padding="same"),

Dropout(0.2)

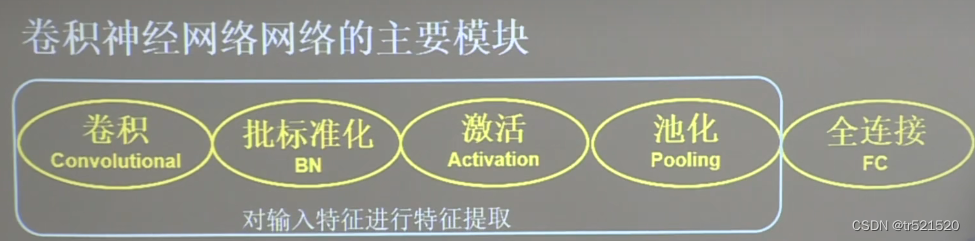

])卷积神经网络

借助卷积核提取特征后,送入全连接网络

卷积是什么?卷积就是特征提取器,就是CBAPD

model = tf.keras.models.Sequential([

C Conv2D(filters=6, kernel_size=(5, 5), padding="same"),

B BatchNormalization(), # BN层

A Activation("relu"), # 激活层

P MaxPool2D(pool_size=(2, 2), strides=2, padding="same"),

D Dropout(0.2) # Droupout层

])

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?