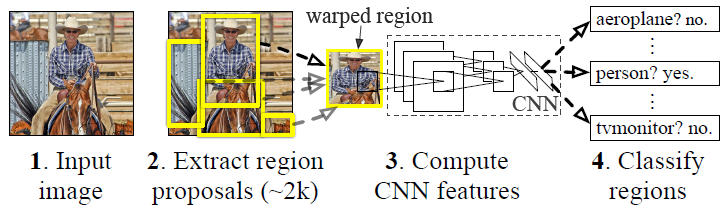

Rcnn流程:

(1) 使用Selective Search生成大约2000个候选框

(2) 将每个候选框送入CNN提取特征

(3) 将提取到的特征送入SVM分类

Selective Search:

(1) 使用一种过分割手段,将图像分割成小区域

(2) 查看现有小区域,合并可能性最高的两个区域。重复直到整张图像合并成一个区域位置

(3) 输出所有曾经存在过的区域,所谓候选区域

候选区域生成和后续步骤相对独立,实际可以使用任意算法进行。

合并规则

优先合并以下四种区域:

- 颜色(颜色直方图)相近的

- 纹理(梯度直方图)相近的

- 合并后总面积小的

- 合并后,总面积在其BBOX中所占比例大的

保证合并操作的尺度较为均匀,避免一个大区域陆续“吃掉”其他小区域。

例:设有区域a-b-c-d-e-f-g-h。较好的合并方式是:ab-cd-ef-gh -> abcd-efgh -> abcdefgh。

不好的合并方法是:ab-c-d-e-f-g-h ->abcd-e-f-g-h ->abcdef-gh -> abcdefgh。

保证合并后形状规则。

上述规则只涉及区域的颜色直方图、纹理直方图、面积和位置。合并后的区域特征可以直接由子区域特征计算而来,速度较快。

多样化与后处理

为尽可能不遗漏候选区域,上述操作在多个颜色空间中同时进行(RGB,HSV,Lab等)。在一个颜色空间中,使用上述四条规则的不同组合进行合并。所有颜色空间与所有规则的全部结果,在去除重复后,都作为候选区域输出。

Rcnn会对2000个候选框重复使用CNN提取特征,在实际应用时很耗时。

Sppnet:

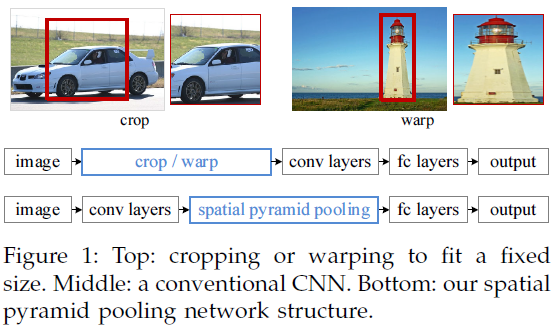

CNN在接受图像输入时由于后面FC层需要固定长度的输入所以也需要将输入的图像归一到固定的大小,但是不管是crop或者wrap都会造成图像信息的缺失或者扭曲,这会导致最终的训练结果不好

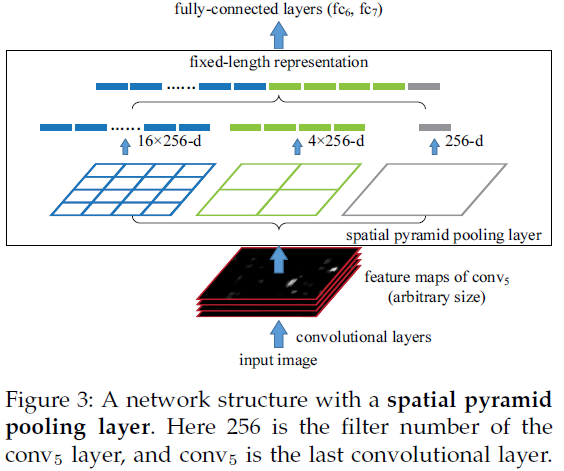

Sppnet在最后一层conv和fc层之间添加了金字塔式池化层,金字塔式池化的size和stride都是根据feature map的大小而变化的,假设feature map的大小是x×x,池化有n×n个bins(即需要把feature map分成n×n块),则窗口尺寸为size=⌈x/n⌉,步长为str=⌊x/n⌋,参考下图

图中金字塔式池化有三层,分别是4×4,2×2,1×1,分别把feature map分为16,4,1块池化

Sppnet的训练有两种一种式single-size一种式multi-size,single-size使用归一的图像大小,而multi-size使用不同的图像大小,论文中multi-size的训练使用224×224,和180×180的大小,两种大小的图片仅是分辨率不同,实验证明multi-size对于尺度有更好的鲁棒性。

Sppnet从feature map到原图的映射

原文中说道,由于conv层和pool层的padding所以映射很复杂,为了简化映射,我们假定如果size=p我们的padding=⌊p/2⌋,在ZF模型中对于conv5中的点(x,y)映射回原图的感受野的中心(x’,y’)=(Sx,Sy),这里S是前面所有层的stride的乘积,那么从原图向conv5映射时,左上边界x’=⌊x/S⌋+1,右下边界x’=⌈x/S⌉-1,这里如果padding不是⌊p/2⌋的话,需要给x加上一个偏置,这里的映射可能并不是很精确,没关系我们还有边框回归。Sppnet相对于Rcnn速度提升很大,因为Sppnet不会重复用CNN提取特征,Sppnet提取整张图的特征,再利用映射找到原图中候选框在feature map中的位置。

RCNN

RCNN的所由计算都是不共享的,并且候选框用ss方法生成,所以速度最慢

SPPnet 和 fast rcnn

Sppnet和fast rcnn把候选框映射到最后一层conv层,所以前面的cnn是共享的只有后面的fc层是不共享的,速度比之RCNN更快

faster rcnn

faster rcnn相对于fast rcnn把ss换成rpn网络进一步加快了速度

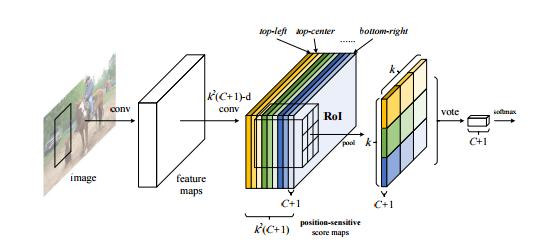

R-FCN

考虑到faster rcnn的fc层依然很耗时,作者在fast rcnn前增加一个conv提取空间位置信息,把最后的fc层换位avg pooling,使R-FCN得速度大大提升,并且精度没有降低多少。

position-sensitive pooling:最后一层conv生成k*k*(c+1)通道的feature map,论文中k=3, 也就是把roi分成3*3的区域,分别是左上,左中,左右。。等等,每一个位置对应一个通道的feature map,c代表分类类别,所以一共3*3(9个不同的位置)*21(类别)个通道,pspooling对每一类的9个不同位置pooling输出一个3*3的feature map,一共21类所以输出21通道的3*3的feature map,再对每一个通道的feature map求均值转换为21维向量送入softmax分类

更新:关于YOLO损失函数的理解

在YOLO的损失函数中,w和h的平方误差都是按照

w−−√

和

h√

来算的,这样在计算梯度的时候后在原有梯度上乘上

w−−√

和

h√

的梯度也就是

12w−12

和

12h−12

当w和h小于0.25时

12w−12

和

12h−12

大于1也就是对于小目标来说我们更关注w和h的损失

本文介绍了目标检测技术的发展,从Rcnn开始,通过Selective Search生成候选框,再到Sppnet引入金字塔池化提高效率,接着Fast R-CNN优化了特征提取,Faster R-CNN引入RPN网络加速,R-FCN通过位置敏感池化减少计算,最后讨论了Yolo的损失函数设计,尤其关注小目标的检测。

本文介绍了目标检测技术的发展,从Rcnn开始,通过Selective Search生成候选框,再到Sppnet引入金字塔池化提高效率,接着Fast R-CNN优化了特征提取,Faster R-CNN引入RPN网络加速,R-FCN通过位置敏感池化减少计算,最后讨论了Yolo的损失函数设计,尤其关注小目标的检测。

644

644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?