相关阅读:

在Ubuntu 12.10 上安装部署Openstack http://www.linuxidc.com/Linux/2013-08/88184.htm

Ubuntu 12.04 OpenStack Swift单节点部署手册 http://www.linuxidc.com/Linux/2013-08/88182.htm

在Ubuntu上安装OpenStack的Swift组件-installing openstack object storage http://www.linuxidc.com/Linux/2013-08/88180.htm

OpenStack Hands on lab系列 http://www.linuxidc.com/Linux/2013-08/88170.htm

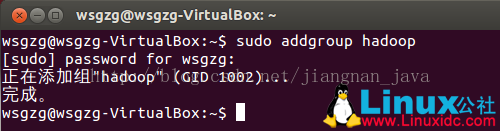

1. 创建hadoop用户组和用户

a. 创建hadoop用户组

sudo addgroup hadoop

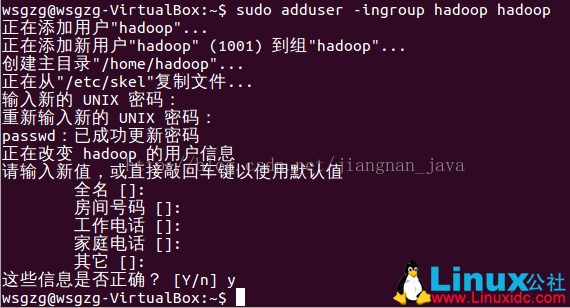

b. 创建hadoop用户

sudo adduser –ingroup hadoop hadoop

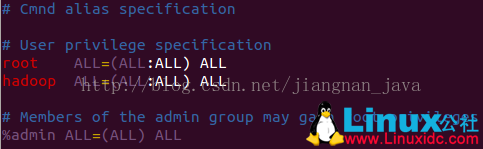

c. 编辑/etc/sudoers文件,为hadoop用户添加权限

sudo vim /etc/sudoers

给hadoop用户赋予root相同的权限

hadoop ALL=(ALL:ALL) ALL

注意:/etc/sudoers文件可能为readonly文件,修改后使用“:wq!”保存

2. 安装JDK

安装JDK的教程网上资料非常多,故省略

注意:不要安装OpenJDK,在Oracle官网上下载JDK(Oracle JDK不能使用apt-get install安装)

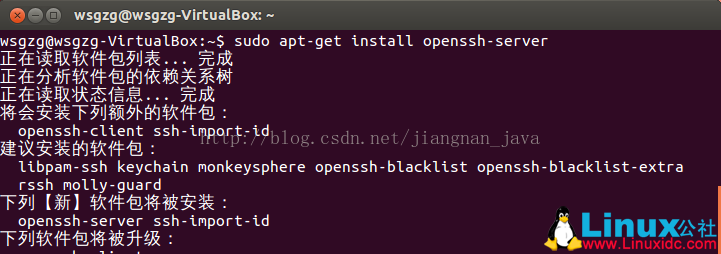

3. 安装ssh服务

sudo apt-get install openssh-server

4. 设置ssh无密码登录

执行su –命令切换到hadoop用户

su – hadoop

ssh生成密钥有rsa和dsa两种,默认采用rsa方式

a. 创建ssh-key(采用rsa方式)

ssh-keygen -t rsa -P ""

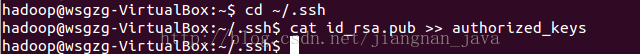

b. 进入~/.ssh/目录下,将id_rsa.pub追加到authorized_keys授权文件中

- cd ~/.ssh

- cat id_rsa.pub >> authorized_keys

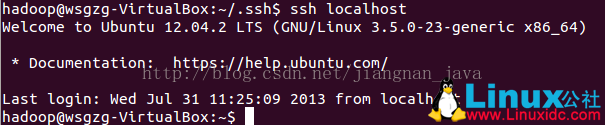

c. 无密码登录localhost

ssh localhost

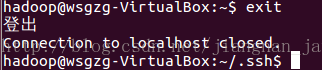

d. 退出ssh连接

- exit

5. 安装Hadoop

a. 复制hadoop文件至/usr/local

- sudo cp sf_share/HadoopDatabase/hadoop-1.1.2.tar.gz/usr/local/

b. 解压.tar.gz文件

- cd /usr/local/

- sudo tar -zxvf hadoop-1.1.2.tar.gz

c. 修改文件名为hadoop

- sudo mv hadoop-1.1.2 hadoop

d. 将hadoop文件夹的属主用户设为hadoop

- sudo chown -R hadoop:hadoop hadoop

e. 修改配置文件conf/hadoop-env.sh的JDK路径

- sudo vim hadoop/conf/hadoop-env.sh

- export JAVA_HOME=/usr/local/jvm/jdk1.6.0_45

f. 修改conf/core-site.xml文件

- sudo vimhadoop/conf/core-site.xml

配置文件如下所示:

- <?xmlversion="1.0"?>

- <?xml-stylesheettypexml-stylesheettype="text/xsl"href="configuration.xsl"?>

- <!-- Put site-specific property overridesin this file. -->

- <configuration>

- <property>

- <name>fs.default.name</name>

- <value>hdfs://localhost:9000</value>

- </property>

- </configuration>

g. 修改conf/mapred-site.xml文件

- sudo vimhadoop/conf/mapred-site.xml

配置文件如下所示:

- <?xmlversion="1.0"?>

- <?xml-stylesheettypexml-stylesheettype="text/xsl"href="configuration.xsl"?>

- <!-- Put site-specific property overridesin this file. -->

- <configuration>

- <property>

- <name>mapred.job.tracker</name>

- <value>localhost:9001</value>

- </property>

- </configuration>

h. 修改conf/hdfs-site.xml文件

- sudo vimhadoop/conf/hdfs-site.xml

配置文件如下所示:

- <?xmlversion="1.0"?>

- <?xml-stylesheettypexml-stylesheettype="text/xsl"href="configuration.xsl"?>

- <!-- Put site-specific property overridesin this file. -->

- <configuration>

- <property>

- <name>dfs.name.dir</name>

- <value>/usr/local/hadoop/datalog1,/usr/local/hadoop/datalog2</value>

- </property>

- <property>

- <name>dfs.data.dir</name>

- <value>/usr/local/hadoop/data1,/usr/local/hadoop/data2</value>

- </property>

- <property>

- <name>dfs.replication</name>

- <value>2</value>

- </property>

- </configuration>

i. 编辑配置文件conf/masters,添���作为secondarynamenode的主机名(单机版仅localhost即可)

- sudo vimhadoop/conf/masters

j. 编辑配置文件conf/slaves,添加作为slave的主机名(单机版仅localhost即可)

- sudo vimhadoop/conf/slaves

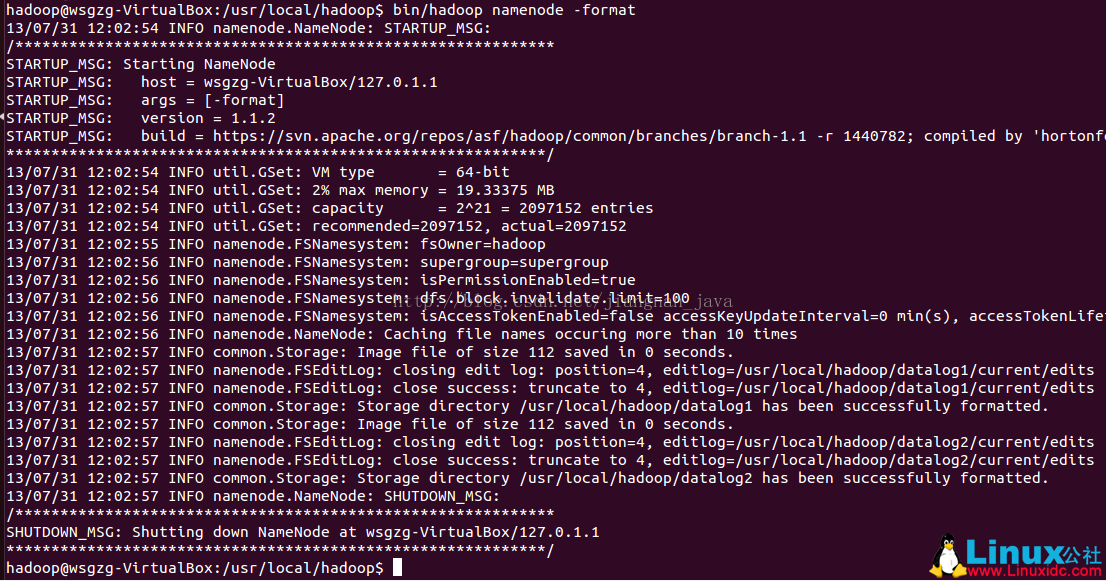

6. 运行单机版hadoop

a. 进入hadoop目录,格式化hdfs文件系统(初次运行必做操作)

- bin/hadoop namenode –format

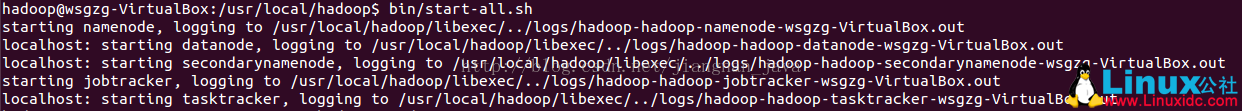

b. 启动hadoop

- bin/start-all.sh

c. 查看hadoop是否运行成功

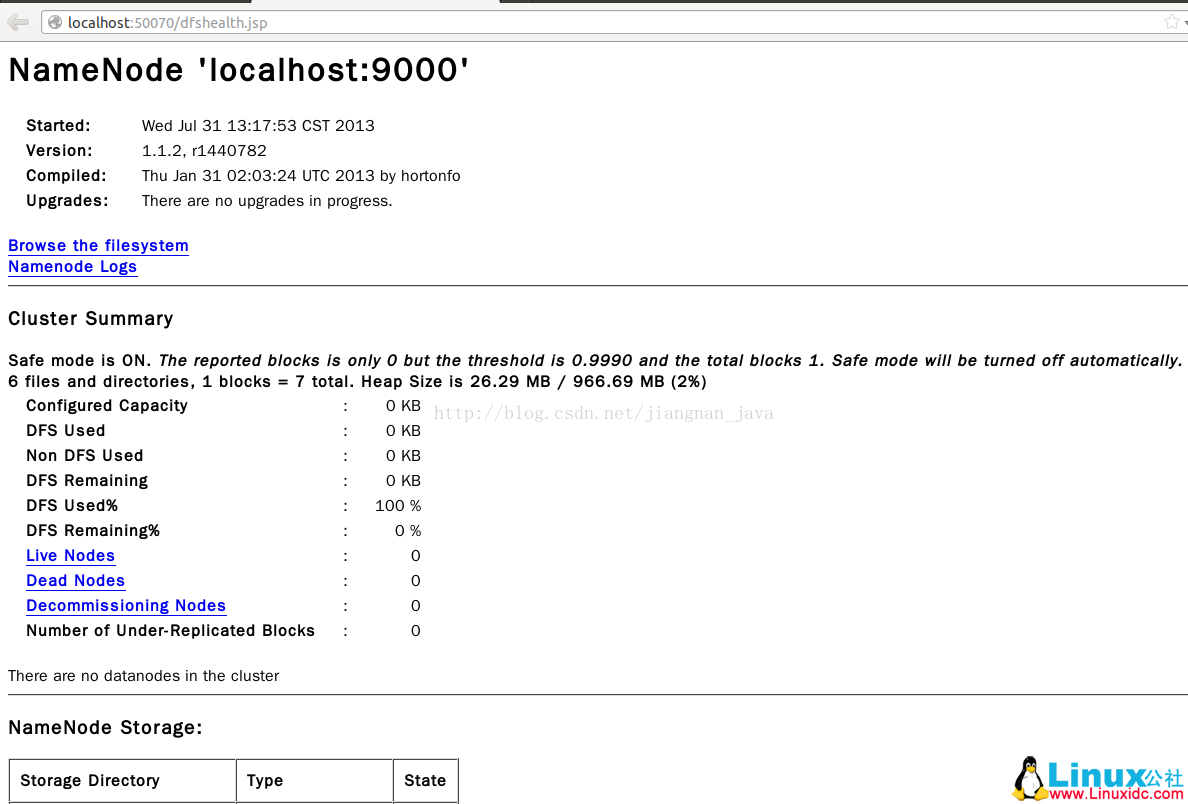

浏览器中输入http://localhost:50070/查看NameNode

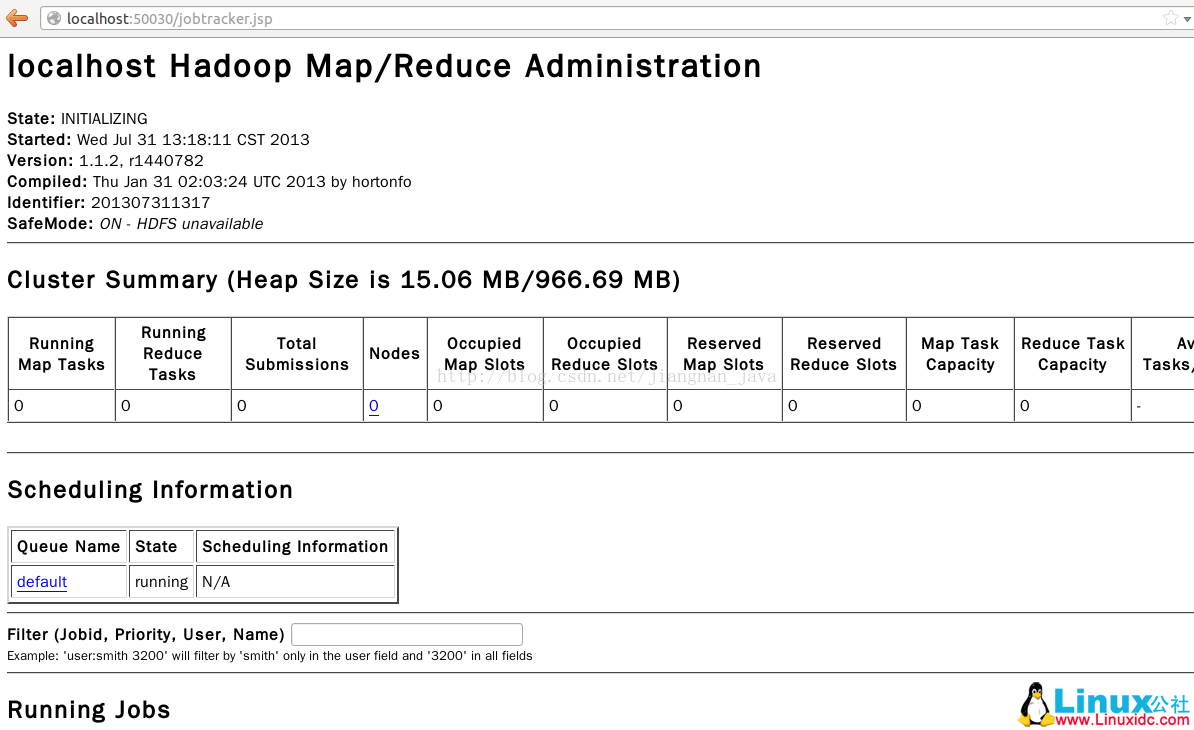

浏览器中输入http://localhost:50030/查看JobTracker

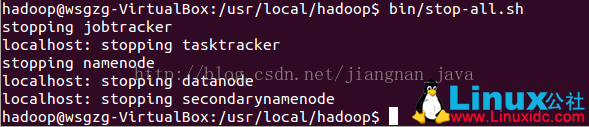

d. 停止hadoop

- bin/stop-all.sh

转载自:http://www.linuxidc.com/Linux/2013-08/88187p2.htm

3464

3464

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?