<!-- TOC -->

- [Java](#java)

- [基础](#基础)

- [并发](#并发)

- [JVM](#jvm)

- [Java8 新特性](#java8-新特性)

- [代码优化](#代码优化)

- [网络](#网络)

- [操作系统](#操作系统)

- [数据结构与算法](#数据结构与算法)

- [数据库](#数据库)

- [系统设计](#系统设计)

- [设计模式](#设计模式)

- [常用框架](#常用框架)

- [网站架构](#网站架构)

- [软件底层](#软件底层)

- [其他](#其他)

<!-- /TOC -->

## Java

### 基础

- [《Head First Java》](https://book.douban.com/subject/2000732/)(推荐,豆瓣评分 8.7,1.0K+人评价): 可以说是我的 Java 启蒙书籍了,特别适合新手读当然也适合我们用来温故 Java 知识点。

- [《Java 核心技术卷 1+卷 2》](https://book.douban.com/subject/25762168/)(推荐): 很棒的两本书,建议有点 Java 基础之后再读,介绍的还是比较深入的,非常推荐。这两本书我一般也会用来巩固知识点,是两本适合放在自己身边的好书。

- [《JAVA 网络编程 第 4 版》](https://book.douban.com/subject/26259017/): 可以系统的学习一下网络的一些概念以及网络编程在 Java 中的使用。

- [《Java 编程思想 (第 4 版)》](https://book.douban.com/subject/2130190/)(推荐,豆瓣评分 9.1,3.2K+人评价):大部分人称之为Java领域的圣经,但我不推荐初学者阅读,有点劝退的味道。稍微有点基础后阅读更好。

- [《Java性能权威指南》](https://book.douban.com/subject/26740520/)(推荐,豆瓣评分 8.2,0.1K+人评价):O'Reilly 家族书,性能调优的入门书,我个人觉得性能调优是每个 Java 从业者必备知识,这本书的缺点就是太老了,但是这本书可以作为一个实战书,尤其是 JVM 调优!不适合初学者。前置书籍:《深入理解 Java 虚拟机》

### 并发

- [《Java 并发编程之美》](<https://book.douban.com/subject/30351286/>) (推荐):2018 年 10 月出版的一本书,个人感觉非常不错,对每个知识点的讲解都很棒。

- [《Java 并发编程的艺术》](https://book.douban.com/subject/26591326/)(推荐,豆瓣评分 7.2,0.2K+人评价): 这本书不是很适合作为 Java 并发入门书籍,需要具备一定的 JVM 基础。我感觉有些东西讲的还是挺深入的,推荐阅读。

- [《实战 Java 高并发程序设计》](https://book.douban.com/subject/26663605/)(推荐,豆瓣评分 8.3): 书的质量没的说,推荐大家好好看一下。

- [《Java 高并发编程详解》](https://book.douban.com/subject/30255689/)(豆瓣评分 7.6): 2018 年 6 月出版的一本书,内容很详细,但可能又有点过于啰嗦,不过这只是我的感觉。

### JVM

- [《深入理解 Java 虚拟机(第 2 版)周志明》](https://book.douban.com/subject/24722612/)(推荐,豆瓣评分 8.9,1.0K+人评价):建议多刷几遍,书中的所有知识点可以通过 JAVA 运行时区域和 JAVA 的内存模型与线程两个大模块罗列完全。

- [《实战 JAVA 虚拟机》](https://book.douban.com/subject/26354292/)(推荐,豆瓣评分 8.0,1.0K+人评价):作为入门的了解 Java 虚拟机的知识还是不错的。

### Java8 新特性

- [《Java 8 实战》](https://book.douban.com/subject/26772632/) (推荐,豆瓣评分 9.2 ):面向 Java 8 的技能升级,包括 Lambdas、流和函数式编程特性。实战系列的一贯风格让自己快速上手应用起来。Java 8 支持的 Lambda 是精简表达在语法上提供的支持。Java 8 提供了 Stream,学习和使用可以建立流式编程的认知。

- [《Java 8 编程参考官方教程》](https://book.douban.com/subject/26556574/) (推荐,豆瓣评分 9.2):也还不错吧。

### 代码优化

- [《重构_改善既有代码的设计》](https://book.douban.com/subject/4262627/)(推荐):豆瓣 9.1 分,重构书籍的开山鼻祖。

- [《Effective java 》](https://book.douban.com/subject/3360807/)(推荐,豆瓣评分 9.0,1.4K+人评价):本书介绍了在 Java 编程中 78 条极具实用价值的经验规则,这些经验规则涵盖了大多数开发人员每天所面临的问题的解决方案。通过对 Java 平台设计专家所使用的技术的全面描述,揭示了应该做什么,不应该做什么才能产生清晰、健壮和高效的代码。本书中的每条规则都以简短、独立的小文章形式出现,并通过例子代码加以进一步说明。本书内容全面,结构清晰,讲解详细。可作为技术人员的参考用书。

- [《代码整洁之道》](https://book.douban.com/subject/5442024/)(推荐,豆瓣评分 9.1):虽然是用 Java 语言作为例子,全篇都是在阐述 Java 面向对象的思想,但是其中大部分内容其它语言也能应用到。

- **阿里巴巴 Java 开发手册(详尽版)** [https://github.com/alibaba/p3c/blob/master/阿里巴巴 Java 开发手册(详尽版).pdf](https://github.com/alibaba/p3c/blob/master/%E9%98%BF%E9%87%8C%E5%B7%B4%E5%B7%B4Java%E5%BC%80%E5%8F%91%E6%89%8B%E5%86%8C%EF%BC%88%E8%AF%A6%E5%B0%BD%E7%89%88%EF%BC%89.pdf)

- **Google Java 编程风格指南:** <http://www.hawstein.com/posts/google-java-style.html>

## 网络

- [《图解 HTTP》](https://book.douban.com/subject/25863515/)(推荐,豆瓣评分 8.1 , 1.6K+人评价): 讲漫画一样的讲 HTTP,很有意思,不会觉得枯燥,大概也涵盖也 HTTP 常见的知识点。因为篇幅问题,内容可能不太全面。不过,如果不是专门做网络方向研究的小伙伴想研究 HTTP 相关知识的话,读这本书的话应该来说就差不多了。

- [《HTTP 权威指南》](https://book.douban.com/subject/10746113/) (推荐,豆瓣评分 8.6):如果要全面了解 HTTP 非此书不可!

## 操作系统

- [《鸟哥的 Linux 私房菜》](https://book.douban.com/subject/4889838/)(推荐,,豆瓣评分 9.1,0.3K+人评价):本书是最具知名度的 Linux 入门书《鸟哥的 Linux 私房菜基础学习篇》的最新版,全面而详细地介绍了 Linux 操作系统。全书分为 5 个部分:第一部分着重说明 Linux 的起源及功能,如何规划和安装 Linux 主机;第二部分介绍 Linux 的文件系统、文件、目录与磁盘的管理;第三部分介绍文字模式接口 shell 和管理系统的好帮手 shell 脚本,另外还介绍了文字编辑器 vi 和 vim 的使用方法;第四部分介绍了对于系统安全非常重要的 Linux 账号的管理,以及主机系统与程序的管理,如查看进程、任务分配和作业管理;第五部分介绍了系统管理员 (root) 的管理事项,如了解系统运行状况、系统服务,针对登录文件进行解析,对系统进行备份以及核心的管理等。

## 数据结构与算法

- [《大话数据结构》](https://book.douban.com/subject/6424904/)(推荐,豆瓣评分 7.9 , 1K+人评价):入门类型的书籍,读起来比较浅显易懂,适合没有数据结构基础或者说数据结构没学好的小伙伴用来入门数据结构。

- [《数据结构与算法分析:C 语言描述》](https://book.douban.com/subject/1139426/)(推荐,豆瓣评分 8.9,1.6K+人评价):本书是《Data Structures and Algorithm Analysis in C》一书第 2 版的简体中译本。原书曾被评为 20 世纪顶尖的 30 部计算机著作之一,作者 Mark Allen Weiss 在数据结构和算法分析方面卓有建树,他的数据结构和算法分析的著作尤其畅销,并受到广泛好评.已被世界 500 余所大学用作教材。

- [《算法图解》](https://book.douban.com/subject/26979890/)(推荐,豆瓣评分 8.4,0.6K+人评价):入门类型的书籍,读起来比较浅显易懂,适合没有算法基础或者说算法没学好的小伙伴用来入门。示例丰富,图文并茂,以让人容易理解的方式阐释了算法.读起来比较快,内容不枯燥!

- [《算法 第四版》](https://book.douban.com/subject/10432347/)(推荐,豆瓣评分 9.3,0.4K+人评价):Java 语言描述,算法领域经典的参考书,全面介绍了关于算法和数据结构的必备知识,并特别针对排序、搜索、图处理和字符串处理进行了论述。书的内容非常多,可以说是 Java 程序员的必备书籍之一了。

## 数据库

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)(推荐,豆瓣评分 9.3,0.4K+人评价):mysql 领域的经典之作,拥有广泛的影响力。不但适合数据库管理员(dba)阅读,也适合开发人员参考学习。不管是数据库新手还是专家,相信都能从本书有所收获。

- [《Redis 实战》](https://book.douban.com/subject/26612779/):如果你想了解 Redis 的一些概念性知识的话,这本书真的非常不错。

- [《Redis 设计与实现》](https://book.douban.com/subject/25900156/)(推荐,豆瓣评分 8.5,0.5K+人评价):也还行吧!

- [《MySQL 技术内幕-InnoDB 存储引擎》](<https://book.douban.com/subject/24708143/>)(推荐,豆瓣评分 8.7):了解 InnoDB 存储引擎底层原理必备的一本书,比较深入。

## 系统设计

### 设计模式

- [《设计模式 : 可复用面向对象软件的基础》](https://book.douban.com/subject/1052241/) (推荐,豆瓣评分 9.1):设计模式的经典!

- [《Head First 设计模式(中文版)》](https://book.douban.com/subject/2243615/) (推荐,豆瓣评分 9.2):相当赞的一本设计模式入门书籍。用实际的编程案例讲解算法设计中会遇到的各种问题和需求变更(对的,连需求变更都考虑到了!),并以此逐步推导出良好的设计模式解决办法。

- [《大话设计模式》](https://book.douban.com/subject/2334288/) (推荐,豆瓣评分 8.3):本书通篇都是以情景对话的形式,用多个小故事或编程示例来组织讲解GOF(即《设计模式 : 可复用面向对象软件的基础》这本书)),但是不像《设计模式 : 可复用面向对象软件的基础》难懂。但是设计模式只看书是不够的,还是需要在实际项目中运用,结合[设计模式](docs/system-design/设计模式.md)更佳!

### 常用框架

- [《深入分析 Java Web 技术内幕》](https://book.douban.com/subject/25953851/): 感觉还行,涉及的东西也蛮多。

- [《Netty 实战》](https://book.douban.com/subject/27038538/)(推荐,豆瓣评分 7.8,92 人评价):内容很细,如果想学 Netty 的话,推荐阅读这本书!

- [《从 Paxos 到 Zookeeper》](https://book.douban.com/subject/26292004/)(推荐,豆瓣评分 7.8,0.3K 人评价):简要介绍几种典型的分布式一致性协议,以及解决分布式一致性问题的思路,其中重点讲解了 Paxos 和 ZAB 协议。同时,本书深入介绍了分布式一致性问题的工业解决方案——ZooKeeper,并着重向读者展示这一分布式协调框架的使用方法、内部实现及运维技巧,旨在帮助读者全面了解 ZooKeeper,并更好地使用和运维 ZooKeeper。

- [《Spring 实战(第 4 版)》](https://book.douban.com/subject/26767354/)(推荐,豆瓣评分 8.3,0.3K+人评价):不建议当做入门书籍读,入门的话可以找点国人的书或者视频看。这本定位就相当于是关于 Spring 的新华字典,只有一些基本概念的介绍和示例,涵盖了 Spring 的各个方面,但都不够深入。就像作者在最后一页写的那样:“学习 Spring,这才刚刚开始”。

- [《RabbitMQ 实战指南》](https://book.douban.com/subject/27591386/):《RabbitMQ 实战指南》从消息中间件的概念和 RabbitMQ 的历史切入,主要阐述 RabbitMQ 的安装、使用、配置、管理、运维、原理、扩展等方面的细节。如果你想浅尝 RabbitMQ 的使用,这本书是你最好的选择;如果你想深入 RabbitMQ 的原理,这本书也是你最好的选择;总之,如果你想玩转 RabbitMQ,这本书一定是最值得看的书之一

- [《Spring Cloud 微服务实战》](https://book.douban.com/subject/27025912/):从时下流行的微服务架构概念出发,详细介绍了 Spring Cloud 针对微服务架构中几大核心要素的解决方案和基础组件。对于各个组件的介绍,《Spring Cloud 微服务实战》主要以示例与源码结合的方式来帮助读者更好地理解这些组件的使用方法以及运行原理。同时,在介绍的过程中,还包含了作者在实践中所遇到的一些问题和解决思路,可供读者在实践中作为参考。

- [《第一本 Docker 书》](https://book.douban.com/subject/26780404/):Docker 入门书籍!

- [《Spring Boot编程思想(核心篇)》](https://book.douban.com/subject/33390560/)(推荐,豆瓣评分 6.2):SpringBoot深入书,不适合初学者。书尤其的厚,评分低的的理由是书某些知识过于拖沓,评分高的理由是书中对SpringBoot内部原理讲解很清楚。作者小马哥:Apache Dubbo PMC、Spring Cloud Alibaba项目架构师。B站作者地址:https://space.bilibili.com/327910845?from=search&seid=17095917016893398636。

### 网站架构

- [《大型网站技术架构:核心原理与案例分析+李智慧》](https://book.douban.com/subject/25723064/)(推荐):这本书我读过,基本不需要你有什么基础啊~读起来特别轻松,但是却可以学到很多东西,非常推荐了。另外我写过这本书的思维导图,关注我的微信公众号:“Java 面试通关手册”回复“大型网站技术架构”即可领取思维导图。

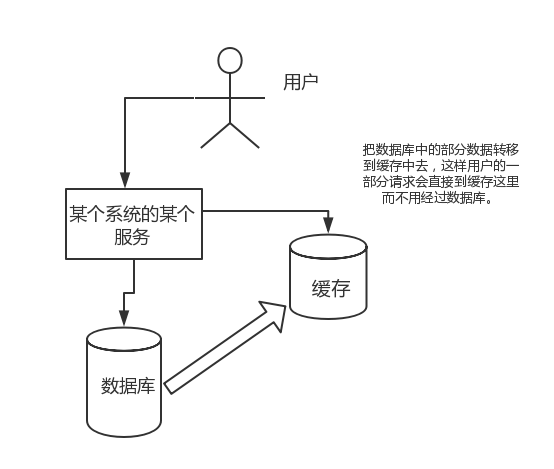

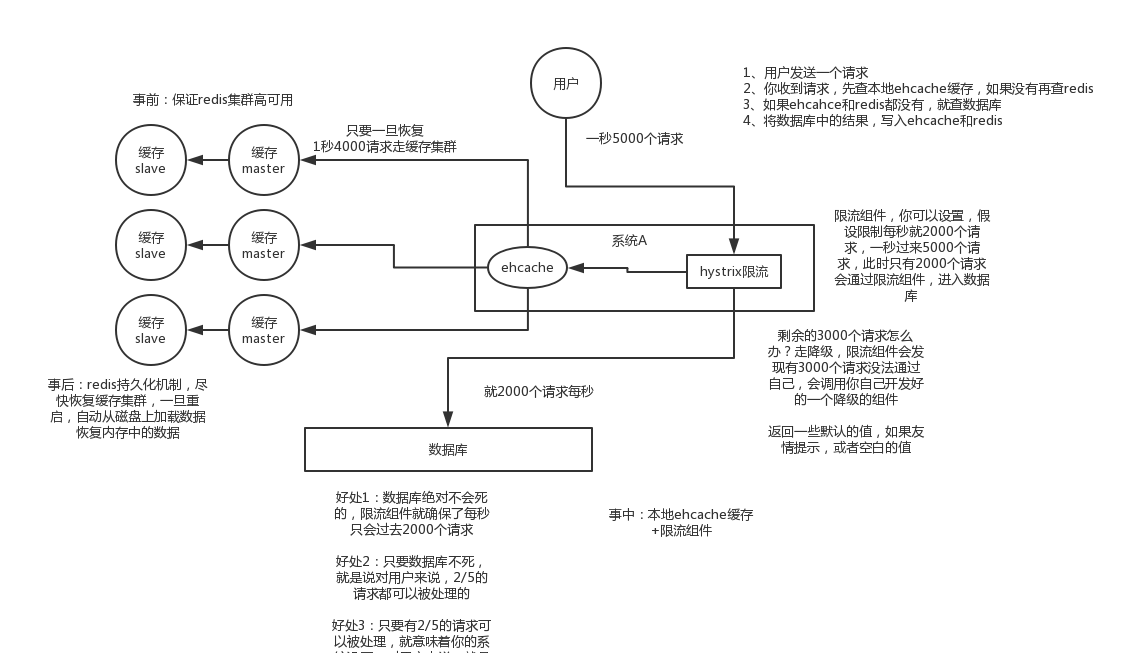

- [《亿级流量网站架构核心技术》](https://book.douban.com/subject/26999243/)(推荐):一书总结并梳理了亿级流量网站高可用和高并发原则,通过实例详细介绍了如何落地这些原则。本书分为四部分:概述、高可用原则、高并发原则、案例实战。从负载均衡、限流、降级、隔离、超时与重试、回滚机制、压测与预案、缓存、池化、异步化、扩容、队列等多方面详细介绍了亿级流量网站的架构核心技术,让读者看后能快速运用到实践项目中。

### 软件底层

- [《深入剖析 Tomcat》](https://book.douban.com/subject/10426640/)(推荐,豆瓣评分 8.4,0.2K+人评价):本书深入剖析 Tomcat 4 和 Tomcat 5 中的每个组件,并揭示其内部工作原理。通过学习本书,你将可以自行开发 Tomcat 组件,或者扩展已有的组件。 读完这本书,基本可以摆脱背诵面试题的尴尬。

- [《深入理解 Nginx(第 2 版)》](https://book.douban.com/subject/26745255/):作者讲的非常细致,注释都写的都很工整,对于 Nginx 的开发人员非常有帮助。优点是细致,缺点是过于细致,到处都是代码片段,缺少一些抽象。

## 其他

- [《黑客与画家》](https://read.douban.com/ebook/387525/?dcs=subject-rec&dcm=douban&dct=2243615):这本书是硅谷创业之父,Y Combinator 创始人 Paul Graham 的文集。之所以叫这个名字,是因为作者认为黑客(并非负面的那个意思)与画家有着极大的相似性,他们都是在创造,而不是完成某个任务。

- [《图解密码技术》](https://book.douban.com/subject/26265544/)(推荐,豆瓣评分 9.1,0.3K+人评价):本书以**图配文**的形式,第一部分讲述了密码技术的历史沿革、对称密码、分组密码模式(包括ECB、CBC、CFB、OFB、CTR)、公钥、混合密码系统。第二部分重点介绍了认证方面的内容,涉及单向散列函数、消息认证码、数字签名、证书等。第三部分讲述了密钥、随机数、PGP、SSL/TLS 以及密码技术在现实生活中的应用。关键字:JWT 前置知识、区块链密码技术前置知识。属于密码知识入门书籍。

最近经常被读者问到有没有 Spring Boot 实战项目可以学习,于是,我就去 Github 上找了 10 个我觉得还不错的实战项目。对于这些实战项目,有部分是比较适合 Spring Boot 刚入门的朋友学习的,还有一部分可能要求你对 Spring Boot 相关技术比较熟悉。需要的朋友可以根据个人实际情况进行选择。如果你对 Spring Boot 不太熟悉的话,可以看我最近开源的 springboot-guide:https://github.com/Snailclimb/springboot-guide 入门(还在持续更新中)。

### mall

- **Github地址**: [https://github.com/macrozheng/mall](https://github.com/macrozheng/mall)

- **star**: 22.9k

- **介绍**: mall项目是一套电商系统,包括前台商城系统及后台管理系统,基于SpringBoot+MyBatis实现。 前台商城系统包含首页门户、商品推荐、商品搜索、商品展示、购物车、订单流程、会员中心、客户服务、帮助中心等模块。 后台管理系统包含商品管理、订单管理、会员管理、促销管理、运营管理、内容管理、统计报表、财务管理、权限管理、设置等模块。

### jeecg-boot

- **Github地址**:[https://github.com/zhangdaiscott/jeecg-boot](https://github.com/zhangdaiscott/jeecg-boot)

- **star**: 6.4k

- **介绍**: 一款基于代码生成器的JAVA快速开发平台!采用最新技术,前后端分离架构:SpringBoot 2.x,Ant Design&Vue,Mybatis,Shiro,JWT。强大的代码生成器让前后端代码一键生成,无需写任何代码,绝对是全栈开发福音!! JeecgBoot的宗旨是提高UI能力的同时,降低前后分离的开发成本,JeecgBoot还独创在线开发模式,No代码概念,一系列在线智能开发:在线配置表单、在线配置报表、在线设计流程等等。

### eladmin

- **Github地址**:[https://github.com/elunez/eladmin](https://github.com/elunez/eladmin)

- **star**: 3.9k

- **介绍**: 项目基于 Spring Boot 2.1.0 、 Jpa、 Spring Security、redis、Vue的前后端分离的后台管理系统,项目采用分模块开发方式, 权限控制采用 RBAC,支持数据字典与数据权限管理,支持一键生成前后端代码,支持动态路由。

### paascloud-master

- **Github地址**:[https://github.com/paascloud/paascloud-master](https://github.com/paascloud/paascloud-master)

- **star**: 5.9k

- **介绍**: spring cloud + vue + oAuth2.0全家桶实战,前后端分离模拟商城,完整的购物流程、后端运营平台,可以实现快速搭建企业级微服务项目。支持微信登录等三方登录。

### vhr

- **Github地址**:[https://github.com/lenve/vhr](https://github.com/lenve/vhr)

- **star**: 10.6k

- **介绍**: 微人事是一个前后端分离的人力资源管理系统,项目采用SpringBoot+Vue开发。

### One mall

- **Github地址**:[https://github.com/YunaiV/onemall](https://github.com/YunaiV/onemall)

- **star**: 1.2k

- **介绍**: mall 商城,基于微服务的思想,构建在 B2C 电商场景下的项目实战。核心技术栈,是 Spring Boot + Dubbo 。未来,会重构成 Spring Cloud Alibaba 。

### Guns

- **Github地址**:[https://github.com/stylefeng/Guns](https://github.com/stylefeng/Guns)

- **star**: 2.3k

- **介绍**: Guns基于SpringBoot 2,致力于做更简洁的后台管理系统,完美整合springmvc + shiro + mybatis-plus + beetl!Guns项目代码简洁,注释丰富,上手容易,同时Guns包含许多基础模块(用户管理,角色管理,部门管理,字典管理等10个模块),可以直接作为一个后台管理系统的脚手架!

### SpringCloud

- **Github地址**:[https://github.com/YunaiV/onemall](https://github.com/YunaiV/onemall)

- **star**: 1.2k

- **介绍**: mall 商城,基于微服务的思想,构建在 B2C 电商场景下的项目实战。核心技术栈,是 Spring Boot + Dubbo 。未来,会重构成 Spring Cloud Alibaba 。

### SpringBoot-Shiro-Vue

- **Github地址**:[https://github.com/Heeexy/SpringBoot-Shiro-Vue](https://github.com/Heeexy/SpringBoot-Shiro-Vue)

- **star**: 1.8k

- **介绍**: 提供一套基于Spring Boot-Shiro-Vue的权限管理思路.前后端都加以控制,做到按钮/接口级别的权限。

### newbee-mall

最近开源的一个商城项目。

- **Github地址**:[https://github.com/newbee-ltd/newbee-mall](https://github.com/newbee-ltd/newbee-mall)

- **star**: 50

- **介绍**: newbee-mall 项目是一套电商系统,包括 newbee-mall 商城系统及 newbee-mall-admin 商城后台管理系统,基于 Spring Boot 2.X 及相关技术栈开发。 前台商城系统包含首页门户、商品分类、新品上线、首页轮播、商品推荐、商品搜索、商品展示、购物车、订单结算、订单流程、个人订单管理、会员中心、帮助中心等模块。 后台管理系统包含数据面板、轮播图管理、商品管理、订单管理、会员管理、分类管理、设置等模块。

点击关注[公众号](#公众号)及时获取笔主最新更新文章,并可免费领取本文档配套的《Java面试突击》以及Java工程师必备学习资源。

- [书籍推荐](#书籍推荐)

- [文字教程推荐](#文字教程推荐)

- [视频教程推荐](#视频教程推荐)

- [常见问题总结](#常见问题总结)

- [什么是MySQL?](#什么是mysql)

- [存储引擎](#存储引擎)

- [一些常用命令](#一些常用命令)

- [MyISAM和InnoDB区别](#myisam和innodb区别)

- [字符集及校对规则](#字符集及校对规则)

- [索引](#索引)

- [查询缓存的使用](#查询缓存的使用)

- [什么是事务?](#什么是事务)

- [事物的四大特性(ACID)](#事物的四大特性acid)

- [并发事务带来哪些问题?](#并发事务带来哪些问题)

- [事务隔离级别有哪些?MySQL的默认隔离级别是?](#事务隔离级别有哪些mysql的默认隔离级别是)

- [锁机制与InnoDB锁算法](#锁机制与innodb锁算法)

- [大表优化](#大表优化)

- [1. 限定数据的范围](#1-限定数据的范围)

- [2. 读/写分离](#2-读写分离)

- [3. 垂直分区](#3-垂直分区)

- [4. 水平分区](#4-水平分区)

- [一条SQL语句在MySQL中如何执行的](#一条sql语句在mysql中如何执行的)

- [MySQL高性能优化规范建议](#mysql高性能优化规范建议)

- [一条SQL语句执行得很慢的原因有哪些?](#一条sql语句执行得很慢的原因有哪些)

<!-- /TOC -->

## 书籍推荐

- 《SQL基础教程(第2版)》 (入门级)

- 《高性能MySQL : 第3版》 (进阶)

## 文字教程推荐

- [SQL Tutorial](https://www.w3schools.com/sql/default.asp) (SQL语句学习,英文)、[SQL Tutorial](https://www.w3school.com.cn/sql/index.asp)(SQL语句学习,中文)、[SQL语句在线练习](https://www.w3schools.com/sql/exercise.asp) (非常不错)

- [Github-MySQL入门教程(MySQL tutorial book)](https://github.com/jaywcjlove/mysql-tutorial) (从零开始学习MySQL,主要是面向MySQL数据库管理系统初学者)

- [官方教程](https://dev.mysql.com/doc/refman/5.7/)

- [MySQL 教程(菜鸟教程)](http://www.runoob.com/MySQL/MySQL-tutorial.html)

## 相关资源推荐

- [中国5级行政区域mysql库](https://github.com/kakuilan/china_area_mysql)

## 视频教程推荐

**基础入门:** [与MySQL的零距离接触-慕课网](https://www.imooc.com/learn/122)

**MySQL开发技巧:** [MySQL开发技巧(一)](https://www.imooc.com/learn/398) [MySQL开发技巧(二)](https://www.imooc.com/learn/427) [MySQL开发技巧(三)](https://www.imooc.com/learn/449)

**MySQL5.7新特性及相关优化技巧:** [MySQL5.7版本新特性](https://www.imooc.com/learn/533) [性能优化之MySQL优化](https://www.imooc.com/learn/194)

[MySQL集群(PXC)入门](https://www.imooc.com/learn/993) [MyCAT入门及应用](https://www.imooc.com/learn/951)

## 常见问题总结

### 什么是MySQL?

MySQL 是一种关系型数据库,在Java企业级开发中非常常用,因为 MySQL 是开源免费的,并且方便扩展。阿里巴巴数据库系统也大量用到了 MySQL,因此它的稳定性是有保障的。MySQL是开放源代码的,因此任何人都可以在 GPL(General Public License) 的许可下下载并根据个性化的需要对其进行修改。MySQL的默认端口号是**3306**。

### 存储引擎

#### 一些常用命令

**查看MySQL提供的所有存储引擎**

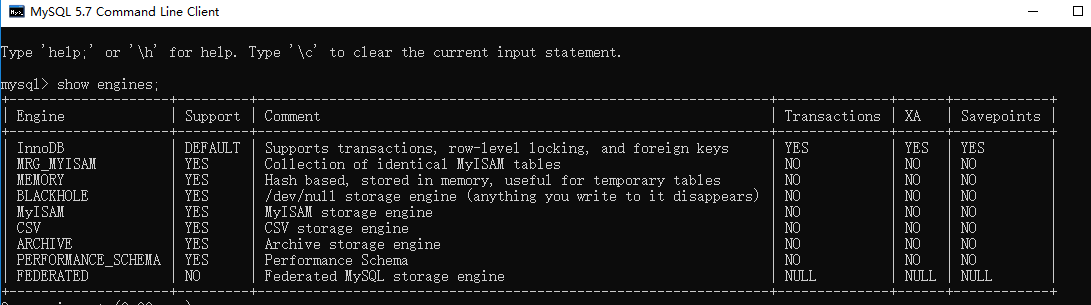

```sql

mysql> show engines;

```

从上图我们可以查看出 MySQL 当前默认的存储引擎是InnoDB,并且在5.7版本所有的存储引擎中只有 InnoDB 是事务性存储引擎,也就是说只有 InnoDB 支持事务。

**查看MySQL当前默认的存储引擎**

我们也可以通过下面的命令查看默认的存储引擎。

```sql

mysql> show variables like '%storage_engine%';

```

**查看表的存储引擎**

```sql

show table status like "table_name" ;

```

#### MyISAM和InnoDB区别

MyISAM是MySQL的默认数据库引擎(5.5版之前)。虽然性能极佳,而且提供了大量的特性,包括全文索引、压缩、空间函数等,但MyISAM不支持事务和行级锁,而且最大的缺陷就是崩溃后无法安全恢复。不过,5.5版本之后,MySQL引入了InnoDB(事务性数据库引擎),MySQL 5.5版本后默认的存储引擎为InnoDB。

大多数时候我们使用的都是 InnoDB 存储引擎,但是在某些情况下使用 MyISAM 也是合适的比如读密集的情况下。(如果你不介意 MyISAM 崩溃恢复问题的话)。

**两者的对比:**

1. **是否支持行级锁** : MyISAM 只有表级锁(table-level locking),而InnoDB 支持行级锁(row-level locking)和表级锁,默认为行级锁。

2. **是否支持事务和崩溃后的安全恢复: MyISAM** 强调的是性能,每次查询具有原子性,其执行速度比InnoDB类型更快,但是不提供事务支持。但是**InnoDB** 提供事务支持事务,外部键等高级数据库功能。 具有事务(commit)、回滚(rollback)和崩溃修复能力(crash recovery capabilities)的事务安全(transaction-safe (ACID compliant))型表。

3. **是否支持外键:** MyISAM不支持,而InnoDB支持。

4. **是否支持MVCC** :仅 InnoDB 支持。应对高并发事务, MVCC比单纯的加锁更高效;MVCC只在 `READ COMMITTED` 和 `REPEATABLE READ` 两个隔离级别下工作;MVCC可以使用 乐观(optimistic)锁 和 悲观(pessimistic)锁来实现;各数据库中MVCC实现并不统一。推荐阅读:[MySQL-InnoDB-MVCC多版本并发控制](https://segmentfault.com/a/1190000012650596)

5. ......

《MySQL高性能》上面有一句话这样写到:

> 不要轻易相信“MyISAM比InnoDB快”之类的经验之谈,这个结论往往不是绝对的。在很多我们已知场景中,InnoDB的速度都可以让MyISAM望尘莫及,尤其是用到了聚簇索引,或者需要访问的数据都可以放入内存的应用。

一般情况下我们选择 InnoDB 都是没有问题的,但是某些情况下你并不在乎可扩展能力和并发能力,也不需要事务支持,也不在乎崩溃后的安全恢复问题的话,选择MyISAM也是一个不错的选择。但是一般情况下,我们都是需要考虑到这些问题的。

### 字符集及校对规则

字符集指的是一种从二进制编码到某类字符符号的映射。校对规则则是指某种字符集下的排序规则。MySQL中每一种字符集都会对应一系列的校对规则。

MySQL采用的是类似继承的方式指定字符集的默认值,每个数据库以及每张数据表都有自己的默认值,他们逐层继承。比如:某个库中所有表的默认字符集将是该数据库所指定的字符集(这些表在没有指定字符集的情况下,才会采用默认字符集) PS:整理自《Java工程师修炼之道》

详细内容可以参考: [MySQL字符集及校对规则的理解](https://www.cnblogs.com/geaozhang/p/6724393.html#MySQLyuzifuji)

### 索引

MySQL索引使用的数据结构主要有**BTree索引** 和 **哈希索引** 。对于哈希索引来说,底层的数据结构就是哈希表,因此在绝大多数需求为单条记录查询的时候,可以选择哈希索引,查询性能最快;其余大部分场景,建议选择BTree索引。

MySQL的BTree索引使用的是B树中的B+Tree,但对于主要的两种存储引擎的实现方式是不同的。

- **MyISAM:** B+Tree叶节点的data域存放的是数据记录的地址。在索引检索的时候,首先按照B+Tree搜索算法搜索索引,如果指定的Key存在,则取出其 data 域的值,然后以 data 域的值为地址读取相应的数据记录。这被称为“非聚簇索引”。

- **InnoDB:** 其数据文件本身就是索引文件。相比MyISAM,索引文件和数据文件是分离的,其表数据文件本身就是按B+Tree组织的一个索引结构,树的叶节点data域保存了完整的数据记录。这个索引的key是数据表的主键,因此InnoDB表数据文件本身就是主索引。这被称为“聚簇索引(或聚集索引)”。而其余的索引都作为辅助索引,辅助索引的data域存储相应记录主键的值而不是地址,这也是和MyISAM不同的地方。**在根据主索引搜索时,直接找到key所在的节点即可取出数据;在根据辅助索引查找时,则需要先取出主键的值,再走一遍主索引。** **因此,在设计表的时候,不建议使用过长的字段作为主键,也不建议使用非单调的字段作为主键,这样会造成主索引频繁分裂。** PS:整理自《Java工程师修炼之道》

**更多关于索引的内容可以查看文档首页MySQL目录下关于索引的详细总结。**

### 查询缓存的使用

> 执行查询语句的时候,会先查询缓存。不过,MySQL 8.0 版本后移除,因为这个功能不太实用

my.cnf加入以下配置,重启MySQL开启查询缓存

```properties

query_cache_type=1

query_cache_size=600000

```

MySQL执行以下命令也可以开启查询缓存

```properties

set global query_cache_type=1;

set global query_cache_size=600000;

```

如上,**开启查询缓存后在同样的查询条件以及数据情况下,会直接在缓存中返回结果**。这里的查询条件包括查询本身、当前要查询的数据库、客户端协议版本号等一些可能影响结果的信息。因此任何两个查询在任何字符上的不同都会导致缓存不命中。此外,如果查询中包含任何用户自定义函数、存储函数、用户变量、临时表、MySQL库中的系统表,其查询结果也不会被缓存。

缓存建立之后,MySQL的查询缓存系统会跟踪查询中涉及的每张表,如果这些表(数据或结构)发生变化,那么和这张表相关的所有缓存数据都将失效。

**缓存虽然能够提升数据库的查询性能,但是缓存同时也带来了额外的开销,每次查询后都要做一次缓存操作,失效后还要销毁。** 因此,开启缓存查询要谨慎,尤其对于写密集的应用来说更是如此。如果开启,要注意合理控制缓存空间大小,一般来说其大小设置为几十MB比较合适。此外,**还可以通过sql_cache和sql_no_cache来控制某个查询语句是否需要缓存:**

```sql

select sql_no_cache count(*) from usr;

```

### 什么是事务?

**事务是逻辑上的一组操作,要么都执行,要么都不执行。**

事务最经典也经常被拿出来说例子就是转账了。假如小明要给小红转账1000元,这个转账会涉及到两个关键操作就是:将小明的余额减少1000元,将小红的余额增加1000元。万一在这两个操作之间突然出现错误比如银行系统崩溃,导致小明余额减少而小红的余额没有增加,这样就不对了。事务就是保证这两个关键操作要么都成功,要么都要失败。

### 事物的四大特性(ACID)

1. **原子性(Atomicity):** 事务是最小的执行单位,不允许分割。事务的原子性确保动作要么全部完成,要么完全不起作用;

2. **一致性(Consistency):** 执行事务前后,数据保持一致,多个事务对同一个数据读取的结果是相同的;

3. **隔离性(Isolation):** 并发访问数据库时,一个用户的事务不被其他事务所干扰,各并发事务之间数据库是独立的;

4. **持久性(Durability):** 一个事务被提交之后。它对数据库中数据的改变是持久的,即使数据库发生故障也不应该对其有任何影响。

### 并发事务带来哪些问题?

在典型的应用程序中,多个事务并发运行,经常会操作相同的数据来完成各自的任务(多个用户对同一数据进行操作)。并发虽然是必须的,但可能会导致以下的问题。

- **脏读(Dirty read):** 当一个事务正在访问数据并且对数据进行了修改,而这种修改还没有提交到数据库中,这时另外一个事务也访问了这个数据,然后使用了这个数据。因为这个数据是还没有提交的数据,那么另外一个事务读到的这个数据是“脏数据”,依据“脏数据”所做的操作可能是不正确的。

- **丢失修改(Lost to modify):** 指在一个事务读取一个数据时,另外一个事务也访问了该数据,那么在第一个事务中修改了这个数据后,第二个事务也修改了这个数据。这样第一个事务内的修改结果就被丢失,因此称为丢失修改。 例如:事务1读取某表中的数据A=20,事务2也读取A=20,事务1修改A=A-1,事务2也修改A=A-1,最终结果A=19,事务1的修改被丢失。

- **不可重复读(Unrepeatableread):** 指在一个事务内多次读同一数据。在这个事务还没有结束时,另一个事务也访问该数据。那么,在第一个事务中的两次读数据之间,由于第二个事务的修改导致第一个事务两次读取的数据可能不太一样。这就发生了在一个事务内两次读到的数据是不一样的情况,因此称为不可重复读。

- **幻读(Phantom read):** 幻读与不可重复读类似。它发生在一个事务(T1)读取了几行数据,接着另一个并发事务(T2)插入了一些数据时。在随后的查询中,第一个事务(T1)就会发现多了一些原本不存在的记录,就好像发生了幻觉一样,所以称为幻读。

**不可重复读和幻读区别:**

不可重复读的重点是修改比如多次读取一条记录发现其中某些列的值被修改,幻读的重点在于新增或者删除比如多次读取一条记录发现记录增多或减少了。

### 事务隔离级别有哪些?MySQL的默认隔离级别是?

**SQL 标准定义了四个隔离级别:**

- **READ-UNCOMMITTED(读取未提交):** 最低的隔离级别,允许读取尚未提交的数据变更,**可能会导致脏读、幻读或不可重复读**。

- **READ-COMMITTED(读取已提交):** 允许读取并发事务已经提交的数据,**可以阻止脏读,但是幻读或不可重复读仍有可能发生**。

- **REPEATABLE-READ(可重复读):** 对同一字段的多次读取结果都是一致的,除非数据是被本身事务自己所修改,**可以阻止脏读和不可重复读,但幻读仍有可能发生**。

- **SERIALIZABLE(可串行化):** 最高的隔离级别,完全服从ACID的隔离级别。所有的事务依次逐个执行,这样事务之间就完全不可能产生干扰,也就是说,**该级别可以防止脏读、不可重复读以及幻读**。

------

| 隔离级别 | 脏读 | 不可重复读 | 幻影读 |

| :--------------: | :--: | :--------: | :----: |

| READ-UNCOMMITTED | √ | √ | √ |

| READ-COMMITTED | × | √ | √ |

| REPEATABLE-READ | × | × | √ |

| SERIALIZABLE | × | × | × |

MySQL InnoDB 存储引擎的默认支持的隔离级别是 **REPEATABLE-READ(可重读)**。我们可以通过`SELECT @@tx_isolation;`命令来查看

```sql

mysql> SELECT @@tx_isolation;

+-----------------+

| @@tx_isolation |

+-----------------+

| REPEATABLE-READ |

+-----------------+

```

这里需要注意的是:与 SQL 标准不同的地方在于 InnoDB 存储引擎在 **REPEATABLE-READ(可重读)**

事务隔离级别下使用的是Next-Key Lock 锁算法,因此可以避免幻读的产生,这与其他数据库系统(如 SQL Server)

是不同的。所以说InnoDB 存储引擎的默认支持的隔离级别是 **REPEATABLE-READ(可重读)** 已经可以完全保证事务的隔离性要求,即达到了

SQL标准的 **SERIALIZABLE(可串行化)** 隔离级别。因为隔离级别越低,事务请求的锁越少,所以大部分数据库系统的隔离级别都是 **READ-COMMITTED(读取提交内容)** ,但是你要知道的是InnoDB 存储引擎默认使用 **REPEAaTABLE-READ(可重读)** 并不会有任何性能损失。

InnoDB 存储引擎在 **分布式事务** 的情况下一般会用到 **SERIALIZABLE(可串行化)** 隔离级别。

### 锁机制与InnoDB锁算法

**MyISAM和InnoDB存储引擎使用的锁:**

- MyISAM采用表级锁(table-level locking)。

- InnoDB支持行级锁(row-level locking)和表级锁,默认为行级锁

**表级锁和行级锁对比:**

- **表级锁:** MySQL中锁定 **粒度最大** 的一种锁,对当前操作的整张表加锁,实现简单,资源消耗也比较少,加锁快,不会出现死锁。其锁定粒度最大,触发锁冲突的概率最高,并发度最低,MyISAM和 InnoDB引擎都支持表级锁。

- **行级锁:** MySQL中锁定 **粒度最小** 的一种锁,只针对当前操作的行进行加锁。 行级锁能大大减少数据库操作的冲突。其加锁粒度最小,并发度高,但加锁的开销也最大,加锁慢,会出现死锁。

详细内容可以参考: MySQL锁机制简单了解一下:[https://blog.csdn.net/qq_34337272/article/details/80611486](https://blog.csdn.net/qq_34337272/article/details/80611486)

**InnoDB存储引擎的锁的算法有三种:**

- Record lock:单个行记录上的锁

- Gap lock:间隙锁,锁定一个范围,不包括记录本身

- Next-key lock:record+gap 锁定一个范围,包含记录本身

**相关知识点:**

1. innodb对于行的查询使用next-key lock

2. Next-locking keying为了解决Phantom Problem幻读问题

3. 当查询的索引含有唯一属性时,将next-key lock降级为record key

4. Gap锁设计的目的是为了阻止多个事务将记录插入到同一范围内,而这会导致幻读问题的产生

5. 有两种方式显式关闭gap锁:(除了外键约束和唯一性检查外,其余情况仅使用record lock) A. 将事务隔离级别设置为RC B. 将参数innodb_locks_unsafe_for_binlog设置为1

### 大表优化

当MySQL单表记录数过大时,数据库的CRUD性能会明显下降,一些常见的优化措施如下:

#### 1. 限定数据的范围

务必禁止不带任何限制数据范围条件的查询语句。比如:我们当用户在查询订单历史的时候,我们可以控制在一个月的范围内;

#### 2. 读/写分离

经典的数据库拆分方案,主库负责写,从库负责读;

#### 3. 垂直分区

**根据数据库里面数据表的相关性进行拆分。** 例如,用户表中既有用户的登录信息又有用户的基本信息,可以将用户表拆分成两个单独的表,甚至放到单独的库做分库。

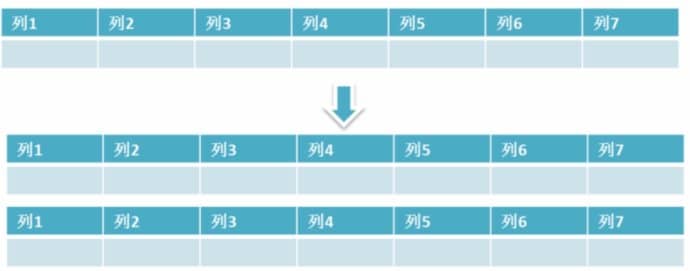

**简单来说垂直拆分是指数据表列的拆分,把一张列比较多的表拆分为多张表。** 如下图所示,这样来说大家应该就更容易理解了。

- **垂直拆分的优点:** 可以使得列数据变小,在查询时减少读取的Block数,减少I/O次数。此外,垂直分区可以简化表的结构,易于维护。

- **垂直拆分的缺点:** 主键会出现冗余,需要管理冗余列,并会引起Join操作,可以通过在应用层进行Join来解决。此外,垂直分区会让事务变得更加复杂;

#### 4. 水平分区

**保持数据表结构不变,通过某种策略存储数据分片。这样每一片数据分散到不同的表或者库中,达到了分布式的目的。 水平拆分可以支撑非常大的数据量。**

水平拆分是指数据表行的拆分,表的行数超过200万行时,就会变慢,这时可以把一张的表的数据拆成多张表来存放。举个例子:我们可以将用户信息表拆分成多个用户信息表,这样就可以避免单一表数据量过大对性能造成影响。

水平拆分可以支持非常大的数据量。需要注意的一点是:分表仅仅是解决了单一表数据过大的问题,但由于表的数据还是在同一台机器上,其实对于提升MySQL并发能力没有什么意义,所以 **水平拆分最好分库** 。

水平拆分能够 **支持非常大的数据量存储,应用端改造也少**,但 **分片事务难以解决** ,跨节点Join性能较差,逻辑复杂。《Java工程师修炼之道》的作者推荐 **尽量不要对数据进行分片,因为拆分会带来逻辑、部署、运维的各种复杂度** ,一般的数据表在优化得当的情况下支撑千万以下的数据量是没有太大问题的。如果实在要分片,尽量选择客户端分片架构,这样可以减少一次和中间件的网络I/O。

**下面补充一下数据库分片的两种常见方案:**

- **客户端代理:** **分片逻辑在应用端,封装在jar包中,通过修改或者封装JDBC层来实现。** 当当网的 **Sharding-JDBC** 、阿里的TDDL是两种比较常用的实现。

- **中间件代理:** **在应用和数据中间加了一个代理层。分片逻辑统一维护在中间件服务中。** 我们现在谈的 **Mycat** 、360的Atlas、网易的DDB等等都是这种架构的实现。

详细内容可以参考: MySQL大表优化方案: [https://segmentfault.com/a/1190000006158186](https://segmentfault.com/a/1190000006158186)

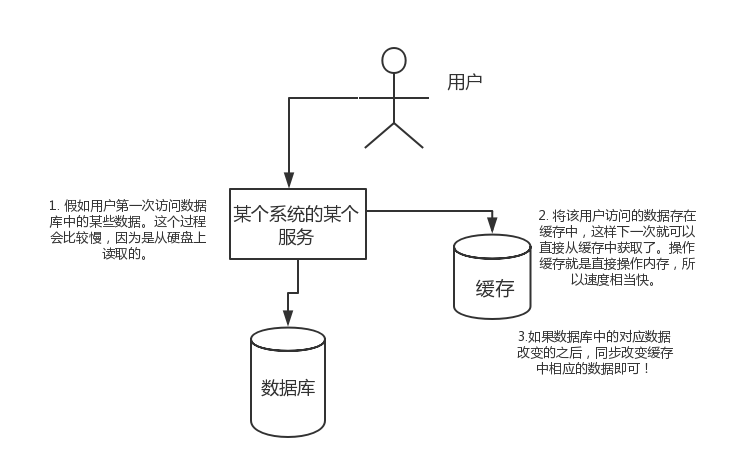

### 解释一下什么是池化设计思想。什么是数据库连接池?为什么需要数据库连接池?

池话设计应该不是一个新名词。我们常见的如java线程池、jdbc连接池、redis连接池等就是这类设计的代表实现。这种设计会初始预设资源,解决的问题就是抵消每次获取资源的消耗,如创建线程的开销,获取远程连接的开销等。就好比你去食堂打饭,打饭的大妈会先把饭盛好几份放那里,你来了就直接拿着饭盒加菜即可,不用再临时又盛饭又打菜,效率就高了。除了初始化资源,池化设计还包括如下这些特征:池子的初始值、池子的活跃值、池子的最大值等,这些特征可以直接映射到java线程池和数据库连接池的成员属性中。——这篇文章对[池化设计思想](https://mp.weixin.qq.com/s?__biz=Mzg2OTA0Njk0OA==&mid=2247485679&idx=1&sn=57dbca8c9ad49e1f3968ecff04a4f735&chksm=cea24724f9d5ce3212292fac291234a760c99c0960b5430d714269efe33554730b5f71208582&token=1141994790&lang=zh_CN#rd)介绍的还不错,直接复制过来,避免重复造轮子了。

数据库连接本质就是一个 socket 的连接。数据库服务端还要维护一些缓存和用户权限信息之类的 所以占用了一些内存。我们可以把数据库连接池是看做是维护的数据库连接的缓存,以便将来需要对数据库的请求时可以重用这些连接。为每个用户打开和维护数据库连接,尤其是对动态数据库驱动的网站应用程序的请求,既昂贵又浪费资源。**在连接池中,创建连接后,将其放置在池中,并再次使用它,因此不必建立新的连接。如果使用了所有连接,则会建立一个新连接并将其添加到池中。**连接池还减少了用户必须等待建立与数据库的连接的时间。

### 分库分表之后,id 主键如何处理?

因为要是分成多个表之后,每个表都是从 1 开始累加,这样是不对的,我们需要一个全局唯一的 id 来支持。

生成全局 id 有下面这几种方式:

- **UUID**:不适合作为主键,因为太长了,并且无序不可读,查询效率低。比较适合用于生成唯一的名字的标示比如文件的名字。

- **数据库自增 id** : 两台数据库分别设置不同步长,生成不重复ID的策略来实现高可用。这种方式生成的 id 有序,但是需要独立部署数据库实例,成本高,还会有性能瓶颈。

- **利用 redis 生成 id :** 性能比较好,灵活方便,不依赖于数据库。但是,引入了新的组件造成系统更加复杂,可用性降低,编码更加复杂,增加了系统成本。

- **Twitter的snowflake算法** :Github 地址:https://github.com/twitter-archive/snowflake。

- **美团的[Leaf](https://tech.meituan.com/2017/04/21/mt-leaf.html)分布式ID生成系统** :Leaf 是美团开源的分布式ID生成器,能保证全局唯一性、趋势递增、单调递增、信息安全,里面也提到了几种分布式方案的对比,但也需要依赖关系数据库、Zookeeper等中间件。感觉还不错。美团技术团队的一篇文章:https://tech.meituan.com/2017/04/21/mt-leaf.html 。

- ......

### 一条SQL语句在MySQL中如何执行的

[一条SQL语句在MySQL中如何执行的](<https://mp.weixin.qq.com/s?__biz=Mzg2OTA0Njk0OA==&mid=2247485097&idx=1&sn=84c89da477b1338bdf3e9fcd65514ac1&chksm=cea24962f9d5c074d8d3ff1ab04ee8f0d6486e3d015cfd783503685986485c11738ccb542ba7&token=79317275&lang=zh_CN#rd>)

### MySQL高性能优化规范建议

[MySQL高性能优化规范建议](<https://mp.weixin.qq.com/s?__biz=Mzg2OTA0Njk0OA==&mid=2247485117&idx=1&sn=92361755b7c3de488b415ec4c5f46d73&chksm=cea24976f9d5c060babe50c3747616cce63df5d50947903a262704988143c2eeb4069ae45420&token=79317275&lang=zh_CN#rd>)

### 一条SQL语句执行得很慢的原因有哪些?

[腾讯面试:一条SQL语句执行得很慢的原因有哪些?---不看后悔系列](https://mp.weixin.qq.com/s?__biz=Mzg2OTA0Njk0OA==&mid=2247485185&idx=1&sn=66ef08b4ab6af5757792223a83fc0d45&chksm=cea248caf9d5c1dc72ec8a281ec16aa3ec3e8066dbb252e27362438a26c33fbe842b0e0adf47&token=79317275&lang=zh_CN#rd)

## 公众号

如果大家想要实时关注我更新的文章以及分享的干货的话,可以关注我的公众号。

**《Java面试突击》:** 由本文档衍生的专为面试而生的《Java面试突击》V2.0 PDF 版本[公众号](#公众号)后台回复 **"Java面试突击"** 即可免费领取!

**Java工程师必备学习资源:** 一些Java工程师常用学习资源公众号后台回复关键字 **“1”** 即可免费无套路获取。

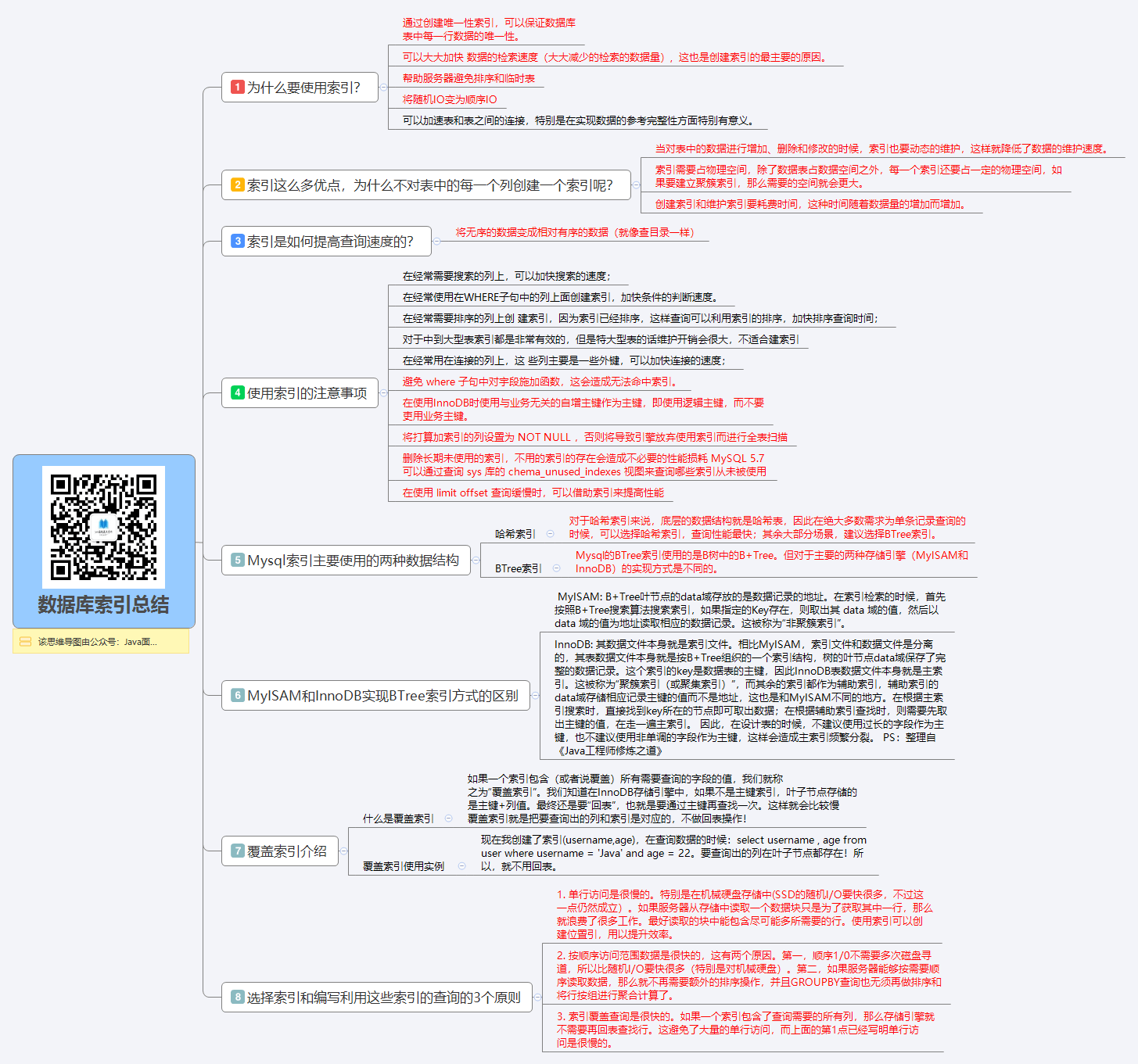

# 思维导图-索引篇

> 系列思维导图源文件(数据库+架构)以及思维导图制作软件—XMind8 破解安装,公众号后台回复:**“思维导图”** 免费领取!(下面的图片不是很清楚,原图非常清晰,另外提供给大家源文件也是为了大家根据自己需要进行修改)

> **下面是我补充的一些内容**

# 为什么索引能提高查询速度

> 以下内容整理自:

> 地址: https://juejin.im/post/5b55b842f265da0f9e589e79

> 作者 :Java3y

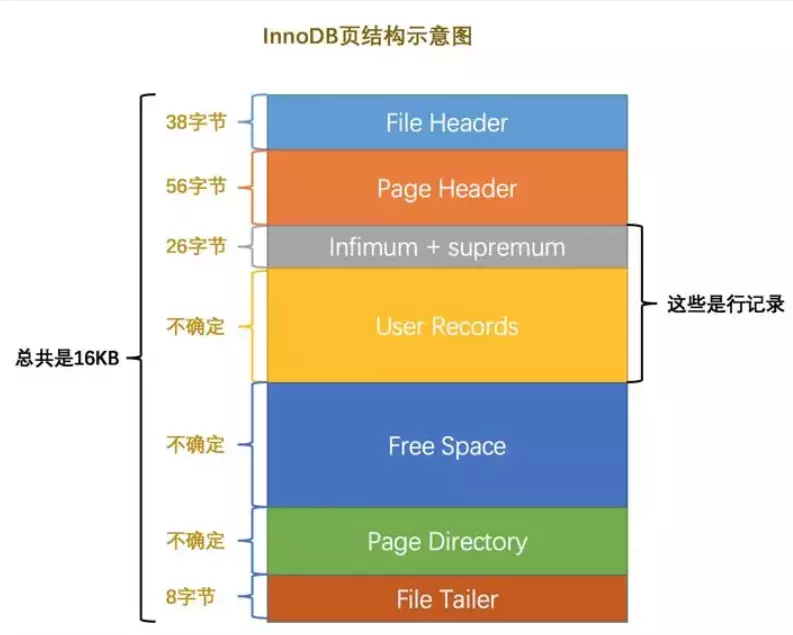

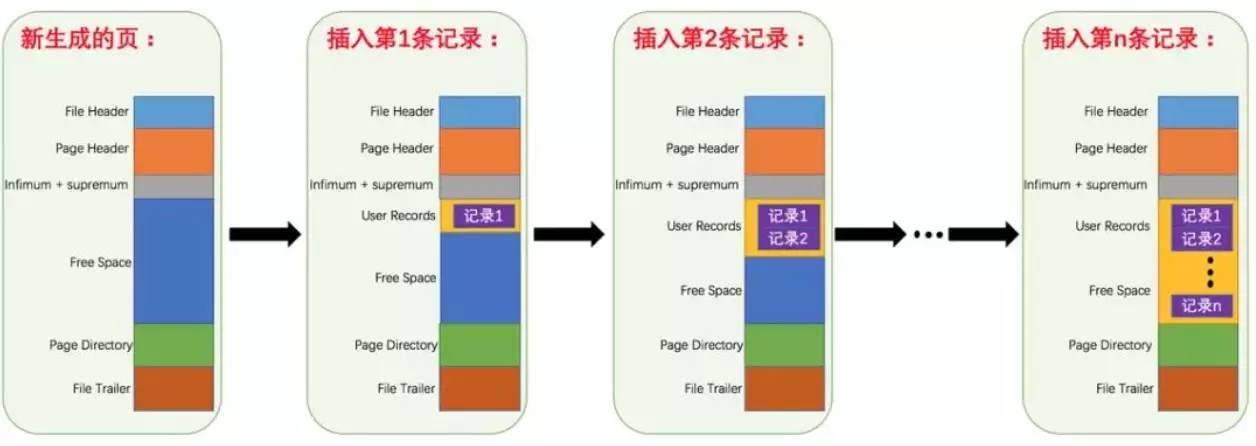

### 先从 MySQL 的基本存储结构说起

MySQL的基本存储结构是页(记录都存在页里边):

- **各个数据页可以组成一个双向链表**

- **每个数据页中的记录又可以组成一个单向链表**

- 每个数据页都会为存储在它里边儿的记录生成一个页目录,在通过主键查找某条记录的时候可以在页目录中使用二分法快速定位到对应的槽,然后再遍历该槽对应分组中的记录即可快速找到指定的记录

- 以其他列(非主键)作为搜索条件:只能从最小记录开始依次遍历单链表中的每条记录。

所以说,如果我们写select * from user where indexname = 'xxx'这样没有进行任何优化的sql语句,默认会这样做:

1. **定位到记录所在的页:需要遍历双向链表,找到所在的页**

2. **从所在的页内中查找相应的记录:由于不是根据主键查询,只能遍历所在页的单链表了**

很明显,在数据量很大的情况下这样查找会很慢!这样的时间复杂度为O(n)。

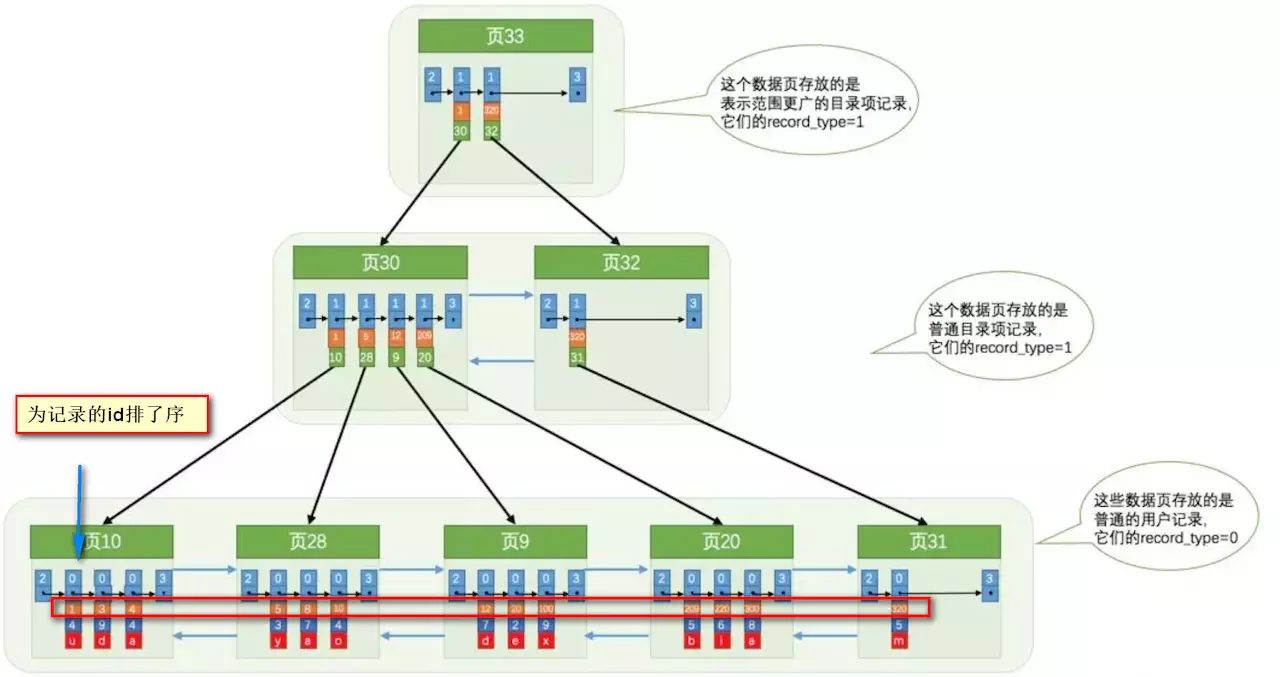

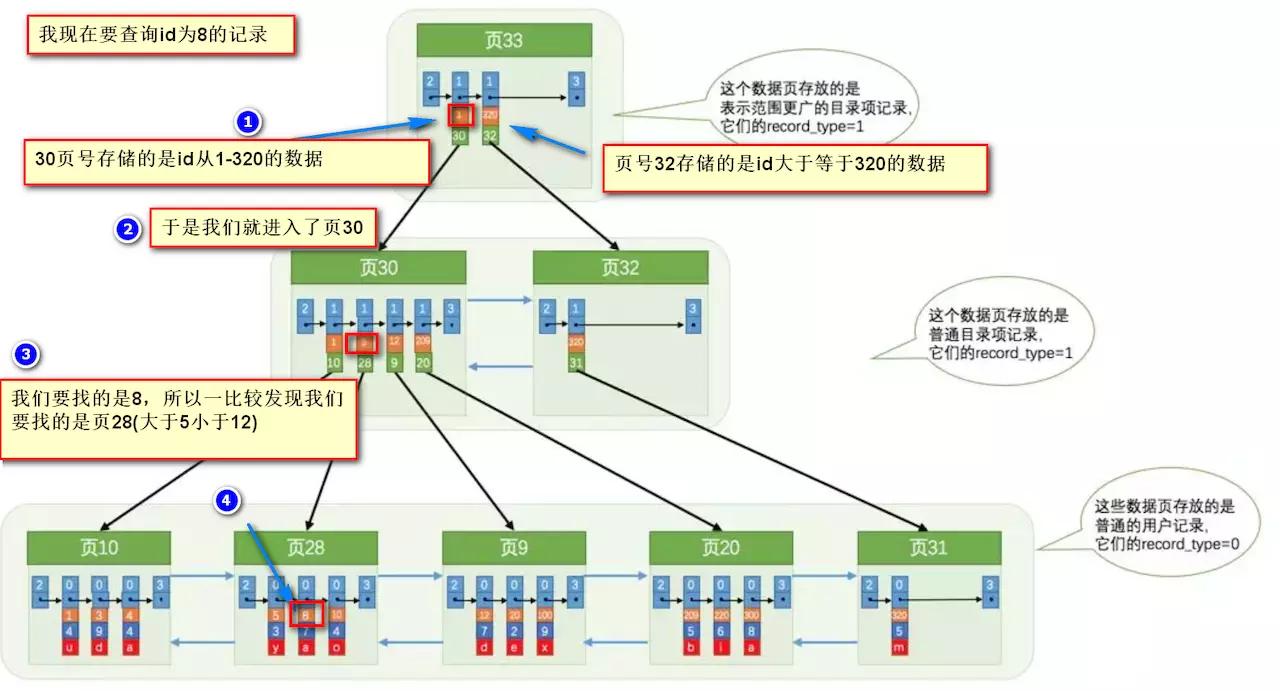

### 使用索引之后

索引做了些什么可以让我们查询加快速度呢?其实就是将无序的数据变成有序(相对):

要找到id为8的记录简要步骤:

很明显的是:没有用索引我们是需要遍历双向链表来定位对应的页,现在通过 **“目录”** 就可以很快地定位到对应的页上了!(二分查找,时间复杂度近似为O(logn))

其实底层结构就是B+树,B+树作为树的一种实现,能够让我们很快地查找出对应的记录。

# 关于索引其他重要的内容补充

> 以下内容整理自:《Java工程师修炼之道》

### 最左前缀原则

MySQL中的索引可以以一定顺序引用多列,这种索引叫作联合索引。如User表的name和city加联合索引就是(name,city),而最左前缀原则指的是,如果查询的时候查询条件精确匹配索引的左边连续一列或几列,则此列就可以被用到。如下:

```

select * from user where name=xx and city=xx ; //可以命中索引

select * from user where name=xx ; // 可以命中索引

select * from user where city=xx ; // 无法命中索引

```

这里需要注意的是,查询的时候如果两个条件都用上了,但是顺序不同,如 `city= xx and name =xx`,那么现在的查询引擎会自动优化为匹配联合索引的顺序,这样是能够命中索引的。

由于最左前缀原则,在创建联合索引时,索引字段的顺序需要考虑字段值去重之后的个数,较多的放前面。ORDER BY子句也遵循此规则。

### 注意避免冗余索引

冗余索引指的是索引的功能相同,能够命中 就肯定能命中 ,那么 就是冗余索引如(name,city )和(name )这两个索引就是冗余索引,能够命中后者的查询肯定是能够命中前者的 在大多数情况下,都应该尽量扩展已有的索引而不是创建新索引。

MySQL 5.7 版本后,可以通过查询 sys 库的 `schema_redundant_indexes` 表来查看冗余索引

### Mysql如何为表字段添加索引???

1.添加PRIMARY KEY(主键索引)

```

ALTER TABLE `table_name` ADD PRIMARY KEY ( `column` )

```

2.添加UNIQUE(唯一索引)

```

ALTER TABLE `table_name` ADD UNIQUE ( `column` )

```

3.添加INDEX(普通索引)

```

ALTER TABLE `table_name` ADD INDEX index_name ( `column` )

```

4.添加FULLTEXT(全文索引)

```

ALTER TABLE `table_name` ADD FULLTEXT ( `column`)

```

5.添加多列索引

```

ALTER TABLE `table_name` ADD INDEX index_name ( `column1`, `column2`, `column3` )

```

# 参考

- 《Java工程师修炼之道》

- 《MySQL高性能书籍_第3版》

- https://juejin.im/post/5b55b842f265da0f9e589e79

> 作者: 听风,原文地址: <https://www.cnblogs.com/huchong/p/10219318.html>。JavaGuide 已获得作者授权。

<!-- TOC -->

- [数据库命令规范](#数据库命令规范)

- [数据库基本设计规范](#数据库基本设计规范)

- [1. 所有表必须使用 Innodb 存储引擎](#1-所有表必须使用-innodb-存储引擎)

- [2. 数据库和表的字符集统一使用 UTF8](#2-数据库和表的字符集统一使用-utf8)

- [3. 所有表和字段都需要添加注释](#3-所有表和字段都需要添加注释)

- [4. 尽量控制单表数据量的大小,建议控制在 500 万以内。](#4-尽量控制单表数据量的大小建议控制在-500-万以内)

- [5. 谨慎使用 MySQL 分区表](#5-谨慎使用-mysql-分区表)

- [6.尽量做到冷热数据分离,减小表的宽度](#6尽量做到冷热数据分离减小表的宽度)

- [7. 禁止在表中建立预留字段](#7-禁止在表中建立预留字段)

- [8. 禁止在数据库中存储图片,文件等大的二进制数据](#8-禁止在数据库中存储图片文件等大的二进制数据)

- [9. 禁止在线上做数据库压力测试](#9-禁止在线上做数据库压力测试)

- [10. 禁止从开发环境,测试环境直接连接生成环境数据库](#10-禁止从开发环境测试环境直接连接生成环境数据库)

- [数据库字段设计规范](#数据库字段设计规范)

- [1. 优先选择符合存储需要的最小的数据类型](#1-优先选择符合存储需要的最小的数据类型)

- [2. 避免使用 TEXT,BLOB 数据类型,最常见的 TEXT 类型可以存储 64k 的数据](#2-避免使用-textblob-数据类型最常见的-text-类型可以存储-64k-的数据)

- [3. 避免使用 ENUM 类型](#3-避免使用-enum-类型)

- [4. 尽可能把所有列定义为 NOT NULL](#4-尽可能把所有列定义为-not-null)

- [5. 使用 TIMESTAMP(4 个字节) 或 DATETIME 类型 (8 个字节) 存储时间](#5-使用-timestamp4-个字节-或-datetime-类型-8-个字节-存储时间)

- [6. 同财务相关的金额类数据必须使用 decimal 类型](#6-同财务相关的金额类数据必须使用-decimal-类型)

- [索引设计规范](#索引设计规范)

- [1. 限制每张表上的索引数量,建议单张表索引不超过 5 个](#1-限制每张表上的索引数量建议单张表索引不超过-5-个)

- [2. 禁止给表中的每一列都建立单独的索引](#2-禁止给表中的每一列都建立单独的索引)

- [3. 每个 Innodb 表必须有个主键](#3-每个-innodb-表必须有个主键)

- [4. 常见索引列建议](#4-常见索引列建议)

- [5.如何选择索引列的顺序](#5如何选择索引列的顺序)

- [6. 避免建立冗余索引和重复索引(增加了查询优化器生成执行计划的时间)](#6-避免建立冗余索引和重复索引增加了查询优化器生成执行计划的时间)

- [7. 对于频繁的查询优先考虑使用覆盖索引](#7-对于频繁的查询优先考虑使用覆盖索引)

- [8.索引 SET 规范](#8索引-set-规范)

- [数据库 SQL 开发规范](#数据库-sql-开发规范)

- [1. 建议使用预编译语句进行数据库操作](#1-建议使用预编译语句进行数据库操作)

- [2. 避免数据类型的隐式转换](#2-避免数据类型的隐式转换)

- [3. 充分利用表上已经存在的索引](#3-充分利用表上已经存在的索引)

- [4. 数据库设计时,应该要对以后扩展进行考虑](#4-数据库设计时应该要对以后扩展进行考虑)

- [5. 程序连接不同的数据库使用不同的账号,进制跨库查询](#5-程序连接不同的数据库使用不同的账号进制跨库查询)

- [6. 禁止使用 SELECT * 必须使用 SELECT <字段列表> 查询](#6-禁止使用-select--必须使用-select-字段列表-查询)

- [7. 禁止使用不含字段列表的 INSERT 语句](#7-禁止使用不含字段列表的-insert-语句)

- [8. 避免使用子查询,可以把子查询优化为 join 操作](#8-避免使用子查询可以把子查询优化为-join-操作)

- [9. 避免使用 JOIN 关联太多的表](#9-避免使用-join-关联太多的表)

- [10. 减少同数据库的交互次数](#10-减少同数据库的交互次数)

- [11. 对应同一列进行 or 判断时,使用 in 代替 or](#11-对应同一列进行-or-判断时使用-in-代替-or)

- [12. 禁止使用 order by rand() 进行随机排序](#12-禁止使用-order-by-rand-进行随机排序)

- [13. WHERE 从句中禁止对列进行函数转换和计算](#13-where-从句中禁止对列进行函数转换和计算)

- [14. 在明显不会有重复值时使用 UNION ALL 而不是 UNION](#14-在明显不会有重复值时使用-union-all-而不是-union)

- [15. 拆分复杂的大 SQL 为多个小 SQL](#15-拆分复杂的大-sql-为多个小-sql)

- [数据库操作行为规范](#数据库操作行为规范)

- [1. 超 100 万行的批量写 (UPDATE,DELETE,INSERT) 操作,要分批多次进行操作](#1-超-100-万行的批量写-updatedeleteinsert-操作要分批多次进行操作)

- [2. 对于大表使用 pt-online-schema-change 修改表结构](#2-对于大表使用-pt-online-schema-change-修改表结构)

- [3. 禁止为程序使用的账号赋予 super 权限](#3-禁止为程序使用的账号赋予-super-权限)

- [4. 对于程序连接数据库账号,遵循权限最小原则](#4-对于程序连接数据库账号遵循权限最小原则)

<!-- /TOC -->

## 数据库命令规范

- 所有数据库对象名称必须使用小写字母并用下划线分割

- 所有数据库对象名称禁止使用 MySQL 保留关键字(如果表名中包含关键字查询时,需要将其用单引号括起来)

- 数据库对象的命名要能做到见名识意,并且最后不要超过 32 个字符

- 临时库表必须以 tmp_为前缀并以日期为后缀,备份表必须以 bak_为前缀并以日期 (时间戳) 为后缀

- 所有存储相同数据的列名和列类型必须一致(一般作为关联列,如果查询时关联列类型不一致会自动进行数据类型隐式转换,会造成列上的索引失效,导致查询效率降低)

------

## 数据库基本设计规范

### 1. 所有表必须使用 Innodb 存储引擎

没有特殊要求(即 Innodb 无法满足的功能如:列存储,存储空间数据等)的情况下,所有表必须使用 Innodb 存储引擎(MySQL5.5 之前默认使用 Myisam,5.6 以后默认的为 Innodb)。

Innodb 支持事务,支持行级锁,更好的恢复性,高并发下性能更好。

### 2. 数据库和表的字符集统一使用 UTF8

兼容性更好,统一字符集可以避免由于字符集转换产生的乱码,不同的字符集进行比较前需要进行转换会造成索引失效,如果数据库中有存储 emoji 表情的需要,字符集需要采用 utf8mb4 字符集。

### 3. 所有表和字段都需要添加注释

使用 comment 从句添加表和列的备注,从一开始就进行数据字典的维护

### 4. 尽量控制单表数据量的大小,建议控制在 500 万以内。

500 万并不是 MySQL 数据库的限制,过大会造成修改表结构,备份,恢复都会有很大的问题。

可以用历史数据归档(应用于日志数据),分库分表(应用于业务数据)等手段来控制数据量大小

### 5. 谨慎使用 MySQL 分区表

分区表在物理上表现为多个文件,在逻辑上表现为一个表;

谨慎选择分区键,跨分区查询效率可能更低;

建议采用物理分表的方式管理大数据。

### 6.尽量做到冷热数据分离,减小表的宽度

> MySQL 限制每个表最多存储 4096 列,并且每一行数据的大小不能超过 65535 字节。

减少磁盘 IO,保证热数据的内存缓存命中率(表越宽,把表装载进内存缓冲池时所占用的内存也就越大,也会消耗更多的 IO);

更有效的利用缓存,避免读入无用的冷数据;

经常一起使用的列放到一个表中(避免更多的关联操作)。

### 7. 禁止在表中建立预留字段

预留字段的命名很难做到见名识义。

预留字段无法确认存储的数据类型,所以无法选择合适的类型。

对预留字段类型的修改,会对表进行锁定。

### 8. 禁止在数据库中存储图片,文件等大的二进制数据

通常文件很大,会短时间内造成数据量快速增长,数据库进行数据库读取时,通常会进行大量的随机 IO 操作,文件很大时,IO 操作很耗时。

通常存储于文件服务器,数据库只存储文件地址信息

### 9. 禁止在线上做数据库压力测试

### 10. 禁止从开发环境,测试环境直接连接生产环境数据库

------

## 数据库字段设计规范

### 1. 优先选择符合存储需要的最小的数据类型

**原因:**

列的字段越大,建立索引时所需要的空间也就越大,这样一页中所能存储的索引节点的数量也就越少也越少,在遍历时所需要的 IO 次数也就越多,索引的性能也就越差。

**方法:**

**a.将字符串转换成数字类型存储,如:将 IP 地址转换成整形数据**

MySQL 提供了两个方法来处理 ip 地址

- inet_aton 把 ip 转为无符号整型 (4-8 位)

- inet_ntoa 把整型的 ip 转为地址

插入数据前,先用 inet_aton 把 ip 地址转为整型,可以节省空间,显示数据时,使用 inet_ntoa 把整型的 ip 地址转为地址显示即可。

**b.对于非负型的数据 (如自增 ID,整型 IP) 来说,要优先使用无符号整型来存储**

**原因:**

无符号相对于有符号可以多出一倍的存储空间

```

SIGNED INT -2147483648~2147483647

UNSIGNED INT 0~4294967295

```

VARCHAR(N) 中的 N 代表的是字符数,而不是字节数,使用 UTF8 存储 255 个汉字 Varchar(255)=765 个字节。**过大的长度会消耗更多的内存。**

### 2. 避免使用 TEXT,BLOB 数据类型,最常见的 TEXT 类型可以存储 64k 的数据

**a. 建议把 BLOB 或是 TEXT 列分离到单独的扩展表中**

MySQL 内存临时表不支持 TEXT、BLOB 这样的大数据类型,如果查询中包含这样的数据,在排序等操作时,就不能使用内存临时表,必须使用磁盘临时表进行。而且对于这种数据,MySQL 还是要进行二次查询,会使 sql 性能变得很差,但是不是说一定不能使用这样的数据类型。

如果一定要使用,建议把 BLOB 或是 TEXT 列分离到单独的扩展表中,查询时一定不要使用 select * 而只需要取出必要的列,不需要 TEXT 列的数据时不要对该列进行查询。

**2、TEXT 或 BLOB 类型只能使用前缀索引**

因为[MySQL](http://mp.weixin.qq.com/s?__biz=MzI4Njc5NjM1NQ==&mid=2247487885&idx=1&sn=65b1bf5f7d4505502620179669a9c2df&chksm=ebd62ea1dca1a7b7bf884bcd9d538d78ba064ee03c09436ca8e57873b1d98a55afd6d7884cfc&scene=21#wechat_redirect) 对索引字段长度是有限制的,所以 TEXT 类型只能使用前缀索引,并且 TEXT 列上是不能有默认值的

### 3. 避免使用 ENUM 类型

修改 ENUM 值需要使用 ALTER 语句

ENUM 类型的 ORDER BY 操作效率低,需要额外操作

禁止使用数值作为 ENUM 的枚举值

### 4. 尽可能把所有列定义为 NOT NULL

**原因:**

索引 NULL 列需要额外的空间来保存,所以要占用更多的空间

进行比较和计算时要对 NULL 值做特别的处理

### 5. 使用 TIMESTAMP(4 个字节) 或 DATETIME 类型 (8 个字节) 存储时间

TIMESTAMP 存储的时间范围 1970-01-01 00:00:01 ~ 2038-01-19-03:14:07

TIMESTAMP 占用 4 字节和 INT 相同,但比 INT 可读性高

超出 TIMESTAMP 取值范围的使用 DATETIME 类型存储

**经常会有人用字符串存储日期型的数据(不正确的做法)**

- 缺点 1:无法用日期函数进行计算和比较

- 缺点 2:用字符串存储日期要占用更多的空间

### 6. 同财务相关的金额类数据必须使用 decimal 类型

- 非精准浮点:float,double

- 精准浮点:decimal

Decimal 类型为精准浮点数,在计算时不会丢失精度

占用空间由定义的宽度决定,每 4 个字节可以存储 9 位数字,并且小数点要占用一个字节

可用于存储比 bigint 更大的整型数据

------

## 索引设计规范

### 1. 限制每张表上的索引数量,建议单张表索引不超过 5 个

索引并不是越多越好!索引可以提高效率同样可以降低效率。

索引可以增加查询效率,但同样也会降低插入和更新的效率,甚至有些情况下会降低查询效率。

因为 MySQL 优化器在选择如何优化查询时,会根据统一信息,对每一个可以用到的索引来进行评估,以生成出一个最好的执行计划,如果同时有很多个索引都可以用于查询,就会增加 MySQL 优化器生成执行计划的时间,同样会降低查询性能。

### 2. 禁止给表中的每一列都建立单独的索引

5.6 版本之前,一个 sql 只能使用到一个表中的一个索引,5.6 以后,虽然有了合并索引的优化方式,但是还是远远没有使用一个联合索引的查询方式好。

### 3. 每个 Innodb 表必须有个主键

Innodb 是一种索引组织表:数据的存储的逻辑顺序和索引的顺序是相同的。每个表都可以有多个索引,但是表的存储顺序只能有一种。

Innodb 是按照主键索引的顺序来组织表的

- 不要使用更新频繁的列作为主键,不适用多列主键(相当于联合索引)

- 不要使用 UUID,MD5,HASH,字符串列作为主键(无法保证数据的顺序增长)

- 主键建议使用自增 ID 值

------

### 4. 常见索引列建议

- 出现在 SELECT、UPDATE、DELETE 语句的 WHERE 从句中的列

- 包含在 ORDER BY、GROUP BY、DISTINCT 中的字段

- 并不要将符合 1 和 2 中的字段的列都建立一个索引, 通常将 1、2 中的字段建立联合索引效果更好

- 多表 join 的关联列

------

### 5.如何选择索引列的顺序

建立索引的目的是:希望通过索引进行数据查找,减少随机 IO,增加查询性能 ,索引能过滤出越少的数据,则从磁盘中读入的数据也就越少。

- 区分度最高的放在联合索引的最左侧(区分度=列中不同值的数量/列的总行数)

- 尽量把字段长度小的列放在联合索引的最左侧(因为字段长度越小,一页能存储的数据量越大,IO 性能也就越好)

- 使用最频繁的列放到联合索引的左侧(这样可以比较少的建立一些索引)

------

### 6. 避免建立冗余索引和重复索引(增加了查询优化器生成执行计划的时间)

- 重复索引示例:primary key(id)、index(id)、unique index(id)

- 冗余索引示例:index(a,b,c)、index(a,b)、index(a)

------

### 7. 对于频繁的查询优先考虑使用覆盖索引

> 覆盖索引:就是包含了所有查询字段 (where,select,ordery by,group by 包含的字段) 的索引

**覆盖索引的好处:**

- **避免 Innodb 表进行索引的二次查询:** Innodb 是以聚集索引的顺序来存储的,对于 Innodb 来说,二级索引在叶子节点中所保存的是行的主键信息,如果是用二级索引查询数据的话,在查找到相应的键值后,还要通过主键进行二次查询才能获取我们真实所需要的数据。而在覆盖索引中,二级索引的键值中可以获取所有的数据,避免了对主键的二次查询 ,减少了 IO 操作,提升了查询效率。

- **可以把随机 IO 变成顺序 IO 加快查询效率:** 由于覆盖索引是按键值的顺序存储的,对于 IO 密集型的范围查找来说,对比随机从磁盘读取每一行的数据 IO 要少的多,因此利用覆盖索引在访问时也可以把磁盘的随机读取的 IO 转变成索引查找的顺序 IO。

------

### 8.索引 SET 规范

**尽量避免使用外键约束**

- 不建议使用外键约束(foreign key),但一定要在表与表之间的关联键上建立索引

- 外键可用于保证数据的参照完整性,但建议在业务端实现

- 外键会影响父表和子表的写操作从而降低性能

------

## 数据库 SQL 开发规范

### 1. 建议使用预编译语句进行数据库操作

预编译语句可以重复使用这些计划,减少 SQL 编译所需要的时间,还可以解决动态 SQL 所带来的 SQL 注入的问题。

只传参数,比传递 SQL 语句更高效。

相同语句可以一次解析,多次使用,提高处理效率。

### 2. 避免数据类型的隐式转换

隐式转换会导致索引失效如:

```

select name,phone from customer where id = '111';

```

### 3. 充分利用表上已经存在的索引

避免使用双%号的查询条件。如:`a like '%123%'`,(如果无前置%,只有后置%,是可以用到列上的索引的)

一个 SQL 只能利用到复合索引中的一列进行范围查询。如:有 a,b,c 列的联合索引,在查询条件中有 a 列的范围查询,则在 b,c 列上的索引将不会被用到。

在定义联合索引时,如果 a 列要用到范围查找的话,就要把 a 列放到联合索引的右侧,使用 left join 或 not exists 来优化 not in 操作,因为 not in 也通常会使用索引失效。

### 4. 数据库设计时,应该要对以后扩展进行考虑

### 5. 程序连接不同的数据库使用不同的账号,禁止跨库查询

- 为数据库迁移和分库分表留出余地

- 降低业务耦合度

- 避免权限过大而产生的安全风险

### 6. 禁止使用 SELECT * 必须使用 SELECT <字段列表> 查询

**原因:**

- 消耗更多的 CPU 和 IO 以网络带宽资源

- 无法使用覆盖索引

- 可减少表结构变更带来的影响

### 7. 禁止使用不含字段列表的 INSERT 语句

如:

```

insert into values ('a','b','c');

```

应使用:

```

insert into t(c1,c2,c3) values ('a','b','c');

```

### 8. 避免使用子查询,可以把子查询优化为 join 操作

通常子查询在 in 子句中,且子查询中为简单 SQL(不包含 union、group by、order by、limit 从句) 时,才可以把子查询转化为关联查询进行优化。

**子查询性能差的原因:**

子查询的结果集无法使用索引,通常子查询的结果集会被存储到临时表中,不论是内存临时表还是磁盘临时表都不会存在索引,所以查询性能会受到一定的影响。特别是对于返回结果集比较大的子查询,其对查询性能的影响也就越大。

由于子查询会产生大量的临时表也没有索引,所以会消耗过多的 CPU 和 IO 资源,产生大量的慢查询。

### 9. 避免使用 JOIN 关联太多的表

对于 MySQL 来说,是存在关联缓存的,缓存的大小可以由 join_buffer_size 参数进行设置。

在 MySQL 中,对于同一个 SQL 多关联(join)一个表,就会多分配一个关联缓存,如果在一个 SQL 中关联的表越多,所占用的内存也就越大。

如果程序中大量的使用了多表关联的操作,同时 join_buffer_size 设置的也不合理的情况下,就容易造成服务器内存溢出的情况,就会影响到服务器数据库性能的稳定性。

同时对于关联操作来说,会产生临时表操作,影响查询效率,MySQL 最多允许关联 61 个表,建议不超过 5 个。

### 10. 减少同数据库的交互次数

数据库更适合处理批量操作,合并多个相同的操作到一起,可以提高处理效率。

### 11. 对应同一列进行 or 判断时,使用 in 代替 or

in 的值不要超过 500 个,in 操作可以更有效的利用索引,or 大多数情况下很少能利用到索引。

### 12. 禁止使用 order by rand() 进行随机排序

order by rand() 会把表中所有符合条件的数据装载到内存中,然后在内存中对所有数据根据随机生成的值进行排序,并且可能会对每一行都生成一个随机值,如果满足条件的数据集非常大,就会消耗大量的 CPU 和 IO 及内存资源。

推荐在程序中获取一个随机值,然后从数据库中获取数据的方式。

### 13. WHERE 从句中禁止对列进行函数转换和计算

对列进行函数转换或计算时会导致无法使用索引

**不推荐:**

```

where date(create_time)='20190101'

```

**推荐:**

```

where create_time >= '20190101' and create_time < '20190102'

```

### 14. 在明显不会有重复值时使用 UNION ALL 而不是 UNION

- UNION 会把两个结果集的所有数据放到临时表中后再进行去重操作

- UNION ALL 不会再对结果集进行去重操作

### 15. 拆分复杂的大 SQL 为多个小 SQL

- 大 SQL 逻辑上比较复杂,需要占用大量 CPU 进行计算的 SQL

- MySQL 中,一个 SQL 只能使用一个 CPU 进行计算

- SQL 拆分后可以通过并行执行来提高处理效率

------

## 数据库操作行为规范

### 1. 超 100 万行的批量写 (UPDATE,DELETE,INSERT) 操作,要分批多次进行操作

**大批量操作可能会造成严重的主从延迟**

主从环境中,大批量操作可能会造成严重的主从延迟,大批量的写操作一般都需要执行一定长的时间,

而只有当主库上执行完成后,才会在其他从库上执行,所以会造成主库与从库长时间的延迟情况

**binlog 日志为 row 格式时会产生大量的日志**

大批量写操作会产生大量日志,特别是对于 row 格式二进制数据而言,由于在 row 格式中会记录每一行数据的修改,我们一次修改的数据越多,产生的日志量也就会越多,日志的传输和恢复所需要的时间也就越长,这也是造成主从延迟的一个原因

**避免产生大事务操作**

大批量修改数据,一定是在一个事务中进行的,这就会造成表中大批量数据进行锁定,从而导致大量的阻塞,阻塞会对 MySQL 的性能产生非常大的影响。

特别是长时间的阻塞会占满所有数据库的可用连接,这会使生产环境中的其他应用无法连接到数据库,因此一定要注意大批量写操作要进行分批

### 2. 对于大表使用 pt-online-schema-change 修改表结构

- 避免大表修改产生的主从延迟

- 避免在对表字段进行修改时进行锁表

对大表数据结构的修改一定要谨慎,会造成严重的锁表操作,尤其是生产环境,是不能容忍的。

pt-online-schema-change 它会首先建立一个与原表结构相同的新表,并且在新表上进行表结构的修改,然后再把原表中的数据复制到新表中,并在原表中增加一些触发器。把原表中新增的数据也复制到新表中,在行所有数据复制完成之后,把新表命名成原表,并把原来的表删除掉。把原来一个 DDL 操作,分解成多个小的批次进行。

### 3. 禁止为程序使用的账号赋予 super 权限

- 当达到最大连接数限制时,还运行 1 个有 super 权限的用户连接

- super 权限只能留给 DBA 处理问题的账号使用

### 4. 对于程序连接数据库账号,遵循权限最小原则

- 程序使用数据库账号只能在一个 DB 下使用,不准跨库

- 程序使用的账号原则上不准有 drop 权限

> 原文地址:https://shockerli.net/post/1000-line-mysql-note/ ,JavaGuide 对本文进行了简答排版,新增了目录。

> 作者:格物

非常不错的总结,强烈建议保存下来,需要的时候看一看。

<!-- TOC -->

- [基本操作](#基本操作)

- [数据库操作](#数据库操作)

- [表的操作](#表的操作)

- [数据操作](#数据操作)

- [字符集编码](#字符集编码)

- [数据类型(列类型)](#数据类型列类型)

- [列属性(列约束)](#列属性列约束)

- [建表规范](#建表规范)

- [SELECT](#select)

- [UNION](#union)

- [子查询](#子查询)

- [连接查询(join)](#连接查询join)

- [TRUNCATE](#truncate)

- [备份与还原](#备份与还原)

- [视图](#视图)

- [事务(transaction)](#事务transaction)

- [锁表](#锁表)

- [触发器](#触发器)

- [SQL编程](#sql编程)

- [存储过程](#存储过程)

- [用户和权限管理](#用户和权限管理)

- [表维护](#表维护)

- [杂项](#杂项)

<!-- /TOC -->

### 基本操作

```mysql

/* Windows服务 */

-- 启动MySQL

net start mysql

-- 创建Windows服务

sc create mysql binPath= mysqld_bin_path(注意:等号与值之间有空格)

/* 连接与断开服务器 */

mysql -h 地址 -P 端口 -u 用户名 -p 密码

SHOW PROCESSLIST -- 显示哪些线程正在运行

SHOW VARIABLES -- 显示系统变量信息

```

### 数据库操作

```mysql

/* 数据库操作 */ ------------------

-- 查看当前数据库

SELECT DATABASE();

-- 显示当前时间、用户名、数据库版本

SELECT now(), user(), version();

-- 创建库

CREATE DATABASE[ IF NOT EXISTS] 数据库名 数据库选项

数据库选项:

CHARACTER SET charset_name

COLLATE collation_name

-- 查看已有库

SHOW DATABASES[ LIKE 'PATTERN']

-- 查看当前库信息

SHOW CREATE DATABASE 数据库名

-- 修改库的选项信息

ALTER DATABASE 库名 选项信息

-- 删除库

DROP DATABASE[ IF EXISTS] 数据库名

同时删除该数据库相关的目录及其目录内容

```

### 表的操作

```mysql

-- 创建表

CREATE [TEMPORARY] TABLE[ IF NOT EXISTS] [库名.]表名 ( 表的结构定义 )[ 表选项]

每个字段必须有数据类型

最后一个字段后不能有逗号

TEMPORARY 临时表,会话结束时表自动消失

对于字段的定义:

字段名 数据类型 [NOT NULL | NULL] [DEFAULT default_value] [AUTO_INCREMENT] [UNIQUE [KEY] | [PRIMARY] KEY] [COMMENT 'string']

-- 表选项

-- 字符集

CHARSET = charset_name

如果表没有设定,则使用数据库字符集

-- 存储引擎

ENGINE = engine_name

表在管理数据时采用的不同的数据结构,结构不同会导致处理方式、提供的特性操作等不同

常见的引擎:InnoDB MyISAM Memory/Heap BDB Merge Example CSV MaxDB Archive

不同的引擎在保存表的结构和数据时采用不同的方式

MyISAM表文件含义:.frm表定义,.MYD表数据,.MYI表索引

InnoDB表文件含义:.frm表定义,表空间数据和日志文件

SHOW ENGINES -- 显示存储引擎的状态信息

SHOW ENGINE 引擎名 {LOGS|STATUS} -- 显示存储引擎的日志或状态信息

-- 自增起始数

AUTO_INCREMENT = 行数

-- 数据文件目录

DATA DIRECTORY = '目录'

-- 索引文件目录

INDEX DIRECTORY = '目录'

-- 表注释

COMMENT = 'string'

-- 分区选项

PARTITION BY ... (详细见手册)

-- 查看所有表

SHOW TABLES[ LIKE 'pattern']

SHOW TABLES FROM 库名

-- 查看表结构

SHOW CREATE TABLE 表名 (信息更详细)

DESC 表名 / DESCRIBE 表名 / EXPLAIN 表名 / SHOW COLUMNS FROM 表名 [LIKE 'PATTERN']

SHOW TABLE STATUS [FROM db_name] [LIKE 'pattern']

-- 修改表

-- 修改表本身的选项

ALTER TABLE 表名 表的选项

eg: ALTER TABLE 表名 ENGINE=MYISAM;

-- 对表进行重命名

RENAME TABLE 原表名 TO 新表名

RENAME TABLE 原表名 TO 库名.表名 (可将表移动到另一个数据库)

-- RENAME可以交换两个表名

-- 修改表的字段机构(13.1.2. ALTER TABLE语法)

ALTER TABLE 表名 操作名

-- 操作名

ADD[ COLUMN] 字段定义 -- 增加字段

AFTER 字段名 -- 表示增加在该字段名后面

FIRST -- 表示增加在第一个

ADD PRIMARY KEY(字段名) -- 创建主键

ADD UNIQUE [索引名] (字段名)-- 创建唯一索引

ADD INDEX [索引名] (字段名) -- 创建普通索引

DROP[ COLUMN] 字段名 -- 删除字段

MODIFY[ COLUMN] 字段名 字段属性 -- 支持对字段属性进行修改,不能修改字段名(所有原有属性也需写上)

CHANGE[ COLUMN] 原字段名 新字段名 字段属性 -- 支持对字段名修改

DROP PRIMARY KEY -- 删除主键(删除主键前需删除其AUTO_INCREMENT属性)

DROP INDEX 索引名 -- 删除索引

DROP FOREIGN KEY 外键 -- 删除外键

-- 删除表

DROP TABLE[ IF EXISTS] 表名 ...

-- 清空表数据

TRUNCATE [TABLE] 表名

-- 复制表结构

CREATE TABLE 表名 LIKE 要复制的表名

-- 复制表结构和数据

CREATE TABLE 表名 [AS] SELECT * FROM 要复制的表名

-- 检查表是否有错误

CHECK TABLE tbl_name [, tbl_name] ... [option] ...

-- 优化表

OPTIMIZE [LOCAL | NO_WRITE_TO_BINLOG] TABLE tbl_name [, tbl_name] ...

-- 修复表

REPAIR [LOCAL | NO_WRITE_TO_BINLOG] TABLE tbl_name [, tbl_name] ... [QUICK] [EXTENDED] [USE_FRM]

-- 分析表

ANALYZE [LOCAL | NO_WRITE_TO_BINLOG] TABLE tbl_name [, tbl_name] ...

```

### 数据操作

```mysql

/* 数据操作 */ ------------------

-- 增

INSERT [INTO] 表名 [(字段列表)] VALUES (值列表)[, (值列表), ...]

-- 如果要插入的值列表包含所有字段并且顺序一致,则可以省略字段列表。

-- 可同时插入多条数据记录!

REPLACE 与 INSERT 完全一样,可互换。

INSERT [INTO] 表名 SET 字段名=值[, 字段名=值, ...]

-- 查

SELECT 字段列表 FROM 表名[ 其他子句]

-- 可来自多个表的多个字段

-- 其他子句可以不使用

-- 字段列表可以用*代替,表示所有字段

-- 删

DELETE FROM 表名[ 删除条件子句]

没有条件子句,则会删除全部

-- 改

UPDATE 表名 SET 字段名=新值[, 字段名=新值] [更新条件]

```

### 字符集编码

```mysql

/* 字符集编码 */ ------------------

-- MySQL、数据库、表、字段均可设置编码

-- 数据编码与客户端编码不需一致

SHOW VARIABLES LIKE 'character_set_%' -- 查看所有字符集编码项

character_set_client 客户端向服务器发送数据时使用的编码

character_set_results 服务器端将结果返回给客户端所使用的编码

character_set_connection 连接层编码

SET 变量名 = 变量值

SET character_set_client = gbk;

SET character_set_results = gbk;

SET character_set_connection = gbk;

SET NAMES GBK; -- 相当于完成以上三个设置

-- 校对集

校对集用以排序

SHOW CHARACTER SET [LIKE 'pattern']/SHOW CHARSET [LIKE 'pattern'] 查看所有字符集

SHOW COLLATION [LIKE 'pattern'] 查看所有校对集

CHARSET 字符集编码 设置字符集编码

COLLATE 校对集编码 设置校对集编码

```

### 数据类型(列类型)

```mysql

/* 数据类型(列类型) */ ------------------

1. 数值类型

-- a. 整型 ----------

类型 字节 范围(有符号位)

tinyint 1字节 -128 ~ 127 无符号位:0 ~ 255

smallint 2字节 -32768 ~ 32767

mediumint 3字节 -8388608 ~ 8388607

int 4字节

bigint 8字节

int(M) M表示总位数

- 默认存在符号位,unsigned 属性修改

- 显示宽度,如果某个数不够定义字段时设置的位数,则前面以0补填,zerofill 属性修改

例:int(5) 插入一个数'123',补填后为'00123'

- 在满足要求的情况下,越小越好。

- 1表示bool值真,0表示bool值假。MySQL没有布尔类型,通过整型0和1表示。常用tinyint(1)表示布尔型。

-- b. 浮点型 ----------

类型 字节 范围

float(单精度) 4字节

double(双精度) 8字节

浮点型既支持符号位 unsigned 属性,也支持显示宽度 zerofill 属性。

不同于整型,前后均会补填0.

定义浮点型时,需指定总位数和小数位数。

float(M, D) double(M, D)

M表示总位数,D表示小数位数。

M和D的大小会决定浮点数的范围。不同于整型的固定范围。

M既表示总位数(不包括小数点和正负号),也表示显示宽度(所有显示符号均包括)。

支持科学计数法表示。

浮点数表示近似值。

-- c. 定点数 ----------

decimal -- 可变长度

decimal(M, D) M也表示总位数,D表示小数位数。

保存一个精确的数值,不会发生数据的改变,不同于浮点数的四舍五入。

将浮点数转换为字符串来保存,每9位数字保存为4个字节。

2. 字符串类型

-- a. char, varchar ----------

char 定长字符串,速度快,但浪费空间

varchar 变长字符串,速度慢,但节省空间

M表示能存储的最大长度,此长度是字符数,非字节数。

不同的编码,所占用的空间不同。

char,最多255个字符,与编码无关。

varchar,最多65535字符,与编码有关。

一条有效记录最大不能超过65535个字节。

utf8 最大为21844个字符,gbk 最大为32766个字符,latin1 最大为65532个字符

varchar 是变长的,需要利用存储空间保存 varchar 的长度,如果数据小于255个字节,则采用一个字节来保存长度,反之需要两个字节来保存。

varchar 的最大有效长度由最大行大小和使用的字符集确定。

最大有效长度是65532字节,因为在varchar存字符串时,第一个字节是空的,不存在任何数据,然后还需两个字节来存放字符串的长度,所以有效长度是64432-1-2=65532字节。

例:若一个表定义为 CREATE TABLE tb(c1 int, c2 char(30), c3 varchar(N)) charset=utf8; 问N的最大值是多少? 答:(65535-1-2-4-30*3)/3

-- b. blob, text ----------

blob 二进制字符串(字节字符串)

tinyblob, blob, mediumblob, longblob

text 非二进制字符串(字符字符串)

tinytext, text, mediumtext, longtext

text 在定义时,不需要定义长度,也不会计算总长度。

text 类型在定义时,不可给default值

-- c. binary, varbinary ----------

类似于char和varchar,用于保存二进制字符串,也就是保存字节字符串而非字符字符串。

char, varchar, text 对应 binary, varbinary, blob.

3. 日期时间类型

一般用整型保存时间戳,因为PHP可以很方便的将时间戳进行格式化。

datetime 8字节 日期及时间 1000-01-01 00:00:00 到 9999-12-31 23:59:59

date 3字节 日期 1000-01-01 到 9999-12-31

timestamp 4字节 时间戳 19700101000000 到 2038-01-19 03:14:07

time 3字节 时间 -838:59:59 到 838:59:59

year 1字节 年份 1901 - 2155

datetime YYYY-MM-DD hh:mm:ss

timestamp YY-MM-DD hh:mm:ss

YYYYMMDDhhmmss

YYMMDDhhmmss

YYYYMMDDhhmmss

YYMMDDhhmmss

date YYYY-MM-DD

YY-MM-DD

YYYYMMDD

YYMMDD

YYYYMMDD

YYMMDD

time hh:mm:ss

hhmmss

hhmmss

year YYYY

YY

YYYY

YY

4. 枚举和集合

-- 枚举(enum) ----------

enum(val1, val2, val3...)

在已知的值中进行单选。最大数量为65535.

枚举值在保存时,以2个字节的整型(smallint)保存。每个枚举值,按保存的位置顺序,从1开始逐一递增。

表现为字符串类型,存储却是整型。

NULL值的索引是NULL。

空字符串错误值的索引值是0。

-- 集合(set) ----------

set(val1, val2, val3...)

create table tab ( gender set('男', '女', '无') );

insert into tab values ('男, 女');

最多可以有64个不同的成员。以bigint存储,共8个字节。采取位运算的形式。

当创建表时,SET成员值的尾部空格将自动被删除。

```

### 列属性(列约束)

```mysql

/* 列属性(列约束) */ ------------------

1. PRIMARY 主键

- 能唯一标识记录的字段,可以作为主键。

- 一个表只能有一个主键。

- 主键具有唯一性。

- 声明字段时,用 primary key 标识。

也可以在字段列表之后声明

例:create table tab ( id int, stu varchar(10), primary key (id));

- 主键字段的值不能为null。

- 主键可以由多个字段共同组成。此时需要在字段列表后声明的方法。

例:create table tab ( id int, stu varchar(10), age int, primary key (stu, age));

2. UNIQUE 唯一索引(唯一约束)

使得某字段的值也不能重复。

3. NULL 约束

null不是数据类型,是列的一个属性。

表示当前列是否可以为null,表示什么都没有。

null, 允许为空。默认。

not null, 不允许为空。

insert into tab values (null, 'val');

-- 此时表示将第一个字段的值设为null, 取决于该字段是否允许为null

4. DEFAULT 默认值属性

当前字段的默认值。

insert into tab values (default, 'val'); -- 此时表示强制使用默认值。

create table tab ( add_time timestamp default current_timestamp );

-- 表示将当前时间的时间戳设为默认值。

current_date, current_time

5. AUTO_INCREMENT 自动增长约束

自动增长必须为索引(主键或unique)

只能存在一个字段为自动增长。

默认为1开始自动增长。可以通过表属性 auto_increment = x进行设置,或 alter table tbl auto_increment = x;

6. COMMENT 注释

例:create table tab ( id int ) comment '注释内容';

7. FOREIGN KEY 外键约束

用于限制主表与从表数据完整性。

alter table t1 add constraint `t1_t2_fk` foreign key (t1_id) references t2(id);

-- 将表t1的t1_id外键关联到表t2的id字段。

-- 每个外键都有一个名字,可以通过 constraint 指定

存在外键的表,称之为从表(子表),外键指向的表,称之为主表(父表)。

作用:保持数据一致性,完整性,主要目的是控制存储在外键表(从表)中的数据。

MySQL中,可以对InnoDB引擎使用外键约束:

语法:

foreign key (外键字段) references 主表名 (关联字段) [主表记录删除时的动作] [主表记录更新时的动作]

此时需要检测一个从表的外键需要约束为主表的已存在的值。外键在没有关联的情况下,可以设置为null.前提是该外键列,没有not null。

可以不指定主表记录更改或更新时的动作,那么此时主表的操作被拒绝。

如果指定了 on update 或 on delete:在删除或更新时,有如下几个操作可以选择:

1. cascade,级联操作。主表数据被更新(主键值更新),从表也被更新(外键值更新)。主表记录被删除,从表相关记录也被删除。

2. set null,设置为null。主表数据被更新(主键值更新),从表的外键被设置为null。主表记录被删除,从表相关记录外键被设置成null。但注意,要求该外键列,没有not null属性约束。

3. restrict,拒绝父表删除和更新。

注意,外键只被InnoDB存储引擎所支持。其他引擎是不支持的。

```

### 建表规范

```mysql

/* 建表规范 */ ------------------

-- Normal Format, NF

- 每个表保存一个实体信息

- 每个具有一个ID字段作为主键

- ID主键 + 原子表

-- 1NF, 第一范式

字段不能再分,就满足第一范式。

-- 2NF, 第二范式

满足第一范式的前提下,不能出现部分依赖。

消除复合主键就可以避免部分依赖。增加单列关键字。

-- 3NF, 第三范式

满足第二范式的前提下,不能出现传递依赖。

某个字段依赖于主键,而有其他字段依赖于该字段。这就是传递依赖。

将一个实体信息的数据放在一个表内实现。

```

### SELECT

```mysql

/* SELECT */ ------------------

SELECT [ALL|DISTINCT] select_expr FROM -> WHERE -> GROUP BY [合计函数] -> HAVING -> ORDER BY -> LIMIT

a. select_expr

-- 可以用 * 表示所有字段。

select * from tb;

-- 可以使用表达式(计算公式、函数调用、字段也是个表达式)

select stu, 29+25, now() from tb;

-- 可以为每个列使用别名。适用于简化列标识,避免多个列标识符重复。

- 使用 as 关键字,也可省略 as.

select stu+10 as add10 from tb;

b. FROM 子句

用于标识查询来源。

-- 可以为表起别名。使用as关键字。

SELECT * FROM tb1 AS tt, tb2 AS bb;

-- from子句后,可以同时出现多个表。

-- 多个表会横向叠加到一起,而数据会形成一个笛卡尔积。

SELECT * FROM tb1, tb2;

-- 向优化符提示如何选择索引

USE INDEX、IGNORE INDEX、FORCE INDEX

SELECT * FROM table1 USE INDEX (key1,key2) WHERE key1=1 AND key2=2 AND key3=3;

SELECT * FROM table1 IGNORE INDEX (key3) WHERE key1=1 AND key2=2 AND key3=3;

c. WHERE 子句

-- 从from获得的数据源中进行筛选。

-- 整型1表示真,0表示假。

-- 表达式由运算符和运算数组成。

-- 运算数:变量(字段)、值、函数返回值

-- 运算符:

=, <=>, <>, !=, <=, <, >=, >, !, &&, ||,

in (not) null, (not) like, (not) in, (not) between and, is (not), and, or, not, xor

is/is not 加上ture/false/unknown,检验某个值的真假

<=>与<>功能相同,<=>可用于null比较

d. GROUP BY 子句, 分组子句

GROUP BY 字段/别名 [排序方式]

分组后会进行排序。升序:ASC,降序:DESC

以下[合计函数]需配合 GROUP BY 使用:

count 返回不同的非NULL值数目 count(*)、count(字段)

sum 求和

max 求最大值

min 求最小值

avg 求平均值

group_concat 返回带有来自一个组的连接的非NULL值的字符串结果。组内字符串连接。

e. HAVING 子句,条件子句

与 where 功能、用法相同,执行时机不同。

where 在开始时执行检测数据,对原数据进行过滤。

having 对筛选出的结果再次进行过滤。

having 字段必须是查询出来的,where 字段必须是数据表存在的。

where 不可以使用字段的别名,having 可以。因为执行WHERE代码时,可能尚未确定列值。

where 不可以使用合计函数。一般需用合计函数才会用 having

SQL标准要求HAVING必须引用GROUP BY子句中的列或用于合计函数中的列。

f. ORDER BY 子句,排序子句

order by 排序字段/别名 排序方式 [,排序字段/别名 排序方式]...

升序:ASC,降序:DESC

支持多个字段的排序。

g. LIMIT 子句,限制结果数量子句

仅对处理好的结果进行数量限制。将处理好的结果的看作是一个集合,按照记录出现的顺序,索引从0开始。

limit 起始位置, 获取条数

省略第一个参数,表示从索引0开始。limit 获取条数

h. DISTINCT, ALL 选项

distinct 去除重复记录

默认为 all, 全部记录

```

### UNION

```mysql

/* UNION */ ------------------

将多个select查询的结果组合成一个结果集合。

SELECT ... UNION [ALL|DISTINCT] SELECT ...

默认 DISTINCT 方式,即所有返回的行都是唯一的

建议,对每个SELECT查询加上小括号包裹。

ORDER BY 排序时,需加上 LIMIT 进行结合。

需要各select查询的字段数量一样。

每个select查询的字段列表(数量、类型)应一致,因为结果中的字段名以第一条select语句为准。

```

### 子查询

```mysql

/* 子查询 */ ------------------

- 子查询需用括号包裹。

-- from型

from后要求是一个表,必须给子查询结果取个别名。

- 简化每个查询内的条件。

- from型需将结果生成一个临时表格,可用以原表的锁定的释放。

- 子查询返回一个表,表型子查询。

select * from (select * from tb where id>0) as subfrom where id>1;

-- where型

- 子查询返回一个值,标量子查询。

- 不需要给子查询取别名。

- where子查询内的表,不能直接用以更新。

select * from tb where money = (select max(money) from tb);

-- 列子查询

如果子查询结果返回的是一列。

使用 in 或 not in 完成查询

exists 和 not exists 条件

如果子查询返回数据,则返回1或0。常用于判断条件。

select column1 from t1 where exists (select * from t2);

-- 行子查询

查询条件是一个行。

select * from t1 where (id, gender) in (select id, gender from t2);

行构造符:(col1, col2, ...) 或 ROW(col1, col2, ...)

行构造符通常用于与对能返回两个或两个以上列的子查询进行比较。

-- 特殊运算符

!= all() 相当于 not in

= some() 相当于 in。any 是 some 的别名

!= some() 不等同于 not in,不等于其中某一个。

all, some 可以配合其他运算符一起使用。

```

### 连接查询(join)

```mysql

/* 连接查询(join) */ ------------------

将多个表的字段进行连接,可以指定连接条件。

-- 内连接(inner join)

- 默认就是内连接,可省略inner。

- 只有数据存在时才能发送连接。即连接结果不能出现空行。

on 表示连接条件。其条件表达式与where类似。也可以省略条件(表示条件永远为真)

也可用where表示连接条件。

还有 using, 但需字段名相同。 using(字段名)

-- 交叉连接 cross join

即,没有条件的内连接。

select * from tb1 cross join tb2;

-- 外连接(outer join)

- 如果数据不存在,也会出现在连接结果中。

-- 左外连接 left join

如果数据不存在,左表记录会出现,而右表为null填充

-- 右外连接 right join

如果数据不存在,右表记录会出现,而左表为null填充

-- 自然连接(natural join)

自动判断连接条件完成连接。

相当于省略了using,会自动查找相同字段名。

natural join

natural left join

natural right join

select info.id, info.name, info.stu_num, extra_info.hobby, extra_info.sex from info, extra_info where info.stu_num = extra_info.stu_id;

```

### TRUNCATE

```mysql

/* TRUNCATE */ ------------------

TRUNCATE [TABLE] tbl_name

清空数据

删除重建表

区别:

1,truncate 是删除表再创建,delete 是逐条删除

2,truncate 重置auto_increment的值。而delete不会

3,truncate 不知道删除了几条,而delete知道。

4,当被用于带分区的表时,truncate 会保留分区

```

### 备份与还原

```mysql

/* 备份与还原 */ ------------------

备份,将数据的结构与表内数据保存起来。

利用 mysqldump 指令完成。

-- 导出

mysqldump [options] db_name [tables]

mysqldump [options] ---database DB1 [DB2 DB3...]

mysqldump [options] --all--database

1. 导出一张表

mysqldump -u用户名 -p密码 库名 表名 > 文件名(D:/a.sql)

2. 导出多张表

mysqldump -u用户名 -p密码 库名 表1 表2 表3 > 文件名(D:/a.sql)

3. 导出所有表

mysqldump -u用户名 -p密码 库名 > 文件名(D:/a.sql)

4. 导出一个库

mysqldump -u用户名 -p密码 --lock-all-tables --database 库名 > 文件名(D:/a.sql)

可以-w携带WHERE条件

-- 导入

1. 在登录mysql的情况下:

source 备份文件

2. 在不登录的情况下

mysql -u用户名 -p密码 库名 < 备份文件

```

### 视图

```mysql

什么是视图:

视图是一个虚拟表,其内容由查询定义。同真实的表一样,视图包含一系列带有名称的列和行数据。但是,视图并不在数据库中以存储的数据值集形式存在。行和列数据来自由定义视图的查询所引用的表,并且在引用视图时动态生成。

视图具有表结构文件,但不存在数据文件。

对其中所引用的基础表来说,视图的作用类似于筛选。定义视图的筛选可以来自当前或其它数据库的一个或多个表,或者其它视图。通过视图进行查询没有任何限制,通过它们进行数据修改时的限制也很少。

视图是存储在数据库中的查询的sql语句,它主要出于两种原因:安全原因,视图可以隐藏一些数据,如:社会保险基金表,可以用视图只显示姓名,地址,而不显示社会保险号和工资数等,另一原因是可使复杂的查询易于理解和使用。

-- 创建视图

CREATE [OR REPLACE] [ALGORITHM = {UNDEFINED | MERGE | TEMPTABLE}] VIEW view_name [(column_list)] AS select_statement

- 视图名必须唯一,同时不能与表重名。

- 视图可以使用select语句查询到的列名,也可以自己指定相应的列名。

- 可以指定视图执行的算法,通过ALGORITHM指定。

- column_list如果存在,则数目必须等于SELECT语句检索的列数

-- 查看结构

SHOW CREATE VIEW view_name

-- 删除视图

- 删除视图后,数据依然存在。

- 可同时删除多个视图。

DROP VIEW [IF EXISTS] view_name ...

-- 修改视图结构

- 一般不修改视图,因为不是所有的更新视图都会映射到表上。

ALTER VIEW view_name [(column_list)] AS select_statement

-- 视图作用

1. 简化业务逻辑

2. 对客户端隐藏真实的表结构

-- 视图算法(ALGORITHM)

MERGE 合并

将视图的查询语句,与外部查询需要先合并再执行!

TEMPTABLE 临时表

将视图执行完毕后,形成临时表,再做外层查询!

UNDEFINED 未定义(默认),指的是MySQL自主去选择相应的算法。

```

### 事务(transaction)

```mysql

事务是指逻辑上的一组操作,组成这组操作的各个单元,要不全成功要不全失败。

- 支持连续SQL的集体成功或集体撤销。

- 事务是数据库在数据完整性方面的一个功能。

- 需要利用 InnoDB 或 BDB 存储引擎,对自动提交的特性支持完成。

- InnoDB被称为事务安全型引擎。

-- 事务开启

START TRANSACTION; 或者 BEGIN;

开启事务后,所有被执行的SQL语句均被认作当前事务内的SQL语句。

-- 事务提交

COMMIT;

-- 事务回滚

ROLLBACK;

如果部分操作发生问题,映射到事务开启前。

-- 事务的特性

1. 原子性(Atomicity)

事务是一个不可分割的工作单位,事务中的操作要么都发生,要么都不发生。

2. 一致性(Consistency)

事务前后数据的完整性必须保持一致。

- 事务开始和结束时,外部数据一致

- 在整个事务过程中,操作是连续的

3. 隔离性(Isolation)

多个用户并发访问数据库时,一个用户的事务不能被其它用户的事物所干扰,多个并发事务之间的数据要相互隔离。

4. 持久性(Durability)

一个事务一旦被提交,它对数据库中的数据改变就是永久性的。

-- 事务的实现

1. 要求是事务支持的表类型

2. 执行一组相关的操作前开启事务

3. 整组操作完成后,都成功,则提交;如果存在失败,选择回滚,则会回到事务开始的备份点。

-- 事务的原理

利用InnoDB的自动提交(autocommit)特性完成。

普通的MySQL执行语句后,当前的数据提交操作均可被其他客户端可见。

而事务是暂时关闭“自动提交”机制,需要commit提交持久化数据操作。

-- 注意

1. 数据定义语言(DDL)语句不能被回滚,比如创建或取消数据库的语句,和创建、取消或更改表或存储的子程序的语句。

2. 事务不能被嵌套

-- 保存点

SAVEPOINT 保存点名称 -- 设置一个事务保存点

ROLLBACK TO SAVEPOINT 保存点名称 -- 回滚到保存点

RELEASE SAVEPOINT 保存点名称 -- 删除保存点

-- InnoDB自动提交特性设置

SET autocommit = 0|1; 0表示关闭自动提交,1表示开启自动提交。

- 如果关闭了,那普通操作的结果对其他客户端也不可见,需要commit提交后才能持久化数据操作。

- 也可以关闭自动提交来开启事务。但与START TRANSACTION不同的是,

SET autocommit是永久改变服务器的设置,直到下次再次修改该设置。(针对当前连接)

而START TRANSACTION记录开启前的状态,而一旦事务提交或回滚后就需要再次开启事务。(针对当前事务)

```

### 锁表

```mysql

/* 锁表 */

表锁定只用于防止其它客户端进行不正当地读取和写入

MyISAM 支持表锁,InnoDB 支持行锁

-- 锁定

LOCK TABLES tbl_name [AS alias]

-- 解锁

UNLOCK TABLES

```

### 触发器

```mysql

/* 触发器 */ ------------------

触发程序是与表有关的命名数据库对象,当该表出现特定事件时,将激活该对象

监听:记录的增加、修改、删除。

-- 创建触发器

CREATE TRIGGER trigger_name trigger_time trigger_event ON tbl_name FOR EACH ROW trigger_stmt

参数:

trigger_time是触发程序的动作时间。它可以是 before 或 after,以指明触发程序是在激活它的语句之前或之后触发。

trigger_event指明了激活触发程序的语句的类型

INSERT:将新行插入表时激活触发程序

UPDATE:更改某一行时激活触发程序

DELETE:从表中删除某一行时激活触发程序

tbl_name:监听的表,必须是永久性的表,不能将触发程序与TEMPORARY表或视图关联起来。

trigger_stmt:当触发程序激活时执行的语句。执行多个语句,可使用BEGIN...END复合语句结构

-- 删除

DROP TRIGGER [schema_name.]trigger_name

可以使用old和new代替旧的和新的数据

更新操作,更新前是old,更新后是new.

删除操作,只有old.

增加操作,只有new.

-- 注意

1. 对于具有相同触发程序动作时间和事件的给定表,不能有两个触发程序。

-- 字符连接函数

concat(str1,str2,...])

concat_ws(separator,str1,str2,...)

-- 分支语句

if 条件 then

执行语句

elseif 条件 then

执行语句

else

执行语句

end if;

-- 修改最外层语句结束符

delimiter 自定义结束符号

SQL语句

自定义结束符号

delimiter ; -- 修改回原来的分号

-- 语句块包裹

begin

语句块

end

-- 特殊的执行

1. 只要添加记录,就会触发程序。

2. Insert into on duplicate key update 语法会触发:

如果没有重复记录,会触发 before insert, after insert;

如果有重复记录并更新,会触发 before insert, before update, after update;

如果有重复记录但是没有发生更新,则触发 before insert, before update

3. Replace 语法 如果有记录,则执行 before insert, before delete, after delete, after insert

```

### SQL编程

```mysql

/* SQL编程 */ ------------------

--// 局部变量 ----------

-- 变量声明

declare var_name[,...] type [default value]

这个语句被用来声明局部变量。要给变量提供一个默认值,请包含一个default子句。值可以被指定为一个表达式,不需要为一个常数。如果没有default子句,初始值为null。

-- 赋值

使用 set 和 select into 语句为变量赋值。

- 注意:在函数内是可以使用全局变量(用户自定义的变量)

--// 全局变量 ----------

-- 定义、赋值

set 语句可以定义并为变量赋值。

set @var = value;

也可以使用select into语句为变量初始化并赋值。这样要求select语句只能返回一行,但是可以是多个字段,就意味着同时为多个变量进行赋值,变量的数量需要与查询的列数一致。

还可以把赋值语句看作一个表达式,通过select执行完成。此时为了避免=被当作关系运算符看待,使用:=代替。(set语句可以使用= 和 :=)。

select @var:=20;

select @v1:=id, @v2=name from t1 limit 1;

select * from tbl_name where @var:=30;

select into 可以将表中查询获得的数据赋给变量。

-| select max(height) into @max_height from tb;

-- 自定义变量名

为了避免select语句中,用户自定义的变量与系统标识符(通常是字段名)冲突,用户自定义变量在变量名前使用@作为开始符号。

@var=10;

- 变量被定义后,在整个会话周期都有效(登录到退出)

--// 控制结构 ----------

-- if语句

if search_condition then

statement_list

[elseif search_condition then

statement_list]

...

[else

statement_list]

end if;

-- case语句

CASE value WHEN [compare-value] THEN result

[WHEN [compare-value] THEN result ...]

[ELSE result]

END

-- while循环

[begin_label:] while search_condition do

statement_list

end while [end_label];

- 如果需要在循环内提前终止 while循环,则需要使用标签;标签需要成对出现。

-- 退出循环

退出整个循环 leave

退出当前循环 iterate

通过退出的标签决定退出哪个循环

--// 内置函数 ----------

-- 数值函数

abs(x) -- 绝对值 abs(-10.9) = 10

format(x, d) -- 格式化千分位数值 format(1234567.456, 2) = 1,234,567.46

ceil(x) -- 向上取整 ceil(10.1) = 11

floor(x) -- 向下取整 floor (10.1) = 10

round(x) -- 四舍五入去整

mod(m, n) -- m%n m mod n 求余 10%3=1

pi() -- 获得圆周率

pow(m, n) -- m^n

sqrt(x) -- 算术平方根

rand() -- 随机数

truncate(x, d) -- 截取d位小数

-- 时间日期函数

now(), current_timestamp(); -- 当前日期时间

current_date(); -- 当前日期

current_time(); -- 当前时间

date('yyyy-mm-dd hh:ii:ss'); -- 获取日期部分

time('yyyy-mm-dd hh:ii:ss'); -- 获取时间部分

date_format('yyyy-mm-dd hh:ii:ss', '%d %y %a %d %m %b %j'); -- 格式化时间

unix_timestamp(); -- 获得unix时间戳

from_unixtime(); -- 从时间戳获得时间

-- 字符串函数

length(string) -- string长度,字节

char_length(string) -- string的字符个数

substring(str, position [,length]) -- 从str的position开始,取length个字符

replace(str ,search_str ,replace_str) -- 在str中用replace_str替换search_str

instr(string ,substring) -- 返回substring首次在string中出现的位置

concat(string [,...]) -- 连接字串

charset(str) -- 返回字串字符集

lcase(string) -- 转换成小写

left(string, length) -- 从string2中的左边起取length个字符

load_file(file_name) -- 从文件读取内容

locate(substring, string [,start_position]) -- 同instr,但可指定开始位置

lpad(string, length, pad) -- 重复用pad加在string开头,直到字串长度为length

ltrim(string) -- 去除前端空格

repeat(string, count) -- 重复count次

rpad(string, length, pad) --在str后用pad补充,直到长度为length

rtrim(string) -- 去除后端空格

strcmp(string1 ,string2) -- 逐字符比较两字串大小

-- 流程函数

case when [condition] then result [when [condition] then result ...] [else result] end 多分支

if(expr1,expr2,expr3) 双分支。

-- 聚合函数

count()

sum();

max();

min();

avg();

group_concat()

-- 其他常用函数

md5();

default();

--// 存储函数,自定义函数 ----------

-- 新建

CREATE FUNCTION function_name (参数列表) RETURNS 返回值类型

函数体

- 函数名,应该合法的标识符,并且不应该与已有的关键字冲突。

- 一个函数应该属于某个数据库,可以使用db_name.funciton_name的形式执行当前函数所属数据库,否则为当前数据库。

- 参数部分,由"参数名"和"参数类型"组成。多个参数用逗号隔开。

- 函数体由多条可用的mysql语句,流程控制,变量声明等语句构成。

- 多条语句应该使用 begin...end 语句块包含。

- 一定要有 return 返回值语句。

-- 删除

DROP FUNCTION [IF EXISTS] function_name;

-- 查看

SHOW FUNCTION STATUS LIKE 'partten'

SHOW CREATE FUNCTION function_name;

-- 修改

ALTER FUNCTION function_name 函数选项

--// 存储过程,自定义功能 ----------

-- 定义

存储存储过程 是一段代码(过程),存储在数据库中的sql组成。

一个存储过程通常用于完成一段业务逻辑,例如报名,交班费,订单入库等。

而一个函数通常专注与某个功能,视为其他程序服务的,需要在其他语句中调用函数才可以,而存储过程不能被其他调用,是自己执行 通过call执行。

-- 创建

CREATE PROCEDURE sp_name (参数列表)

过程体

参数列表:不同于函数的参数列表,需要指明参数类型

IN,表示输入型

OUT,表示输出型

INOUT,表示混合型

注意,没有返回值。

```

### 存储过程

```mysql

/* 存储过程 */ ------------------

存储过程是一段可执行性代码的集合。相比函数,更偏向于业务逻辑。

调用:CALL 过程名

-- 注意

- 没有返回值。

- 只能单独调用,不可夹杂在其他语句中

-- 参数

IN|OUT|INOUT 参数名 数据类型

IN 输入:在调用过程中,将数据输入到过程体内部的参数

OUT 输出:在调用过程中,将过程体处理完的结果返回到客户端

INOUT 输入输出:既可输入,也可输出

-- 语法

CREATE PROCEDURE 过程名 (参数列表)

BEGIN

过程体

END

```

### 用户和权限管理

```mysql

/* 用户和权限管理 */ ------------------

-- root密码重置

1. 停止MySQL服务

2. [Linux] /usr/local/mysql/bin/safe_mysqld --skip-grant-tables &

[Windows] mysqld --skip-grant-tables

3. use mysql;

4. UPDATE `user` SET PASSWORD=PASSWORD("密码") WHERE `user` = "root";

5. FLUSH PRIVILEGES;

用户信息表:mysql.user

-- 刷新权限

FLUSH PRIVILEGES;

-- 增加用户

CREATE USER 用户名 IDENTIFIED BY [PASSWORD] 密码(字符串)

- 必须拥有mysql数据库的全局CREATE USER权限,或拥有INSERT权限。

- 只能创建用户,不能赋予权限。

- 用户名,注意引号:如 'user_name'@'192.168.1.1'

- 密码也需引号,纯数字密码也要加引号

- 要在纯文本中指定密码,需忽略PASSWORD关键词。要把密码指定为由PASSWORD()函数返回的混编值,需包含关键字PASSWORD

-- 重命名用户

RENAME USER old_user TO new_user

-- 设置密码

SET PASSWORD = PASSWORD('密码') -- 为当前用户设置密码

SET PASSWORD FOR 用户名 = PASSWORD('密码') -- 为指定用户设置密码

-- 删除用户

DROP USER 用户名

-- 分配权限/添加用户

GRANT 权限列表 ON 表名 TO 用户名 [IDENTIFIED BY [PASSWORD] 'password']

- all privileges 表示所有权限

- *.* 表示所有库的所有表

- 库名.表名 表示某库下面的某表

GRANT ALL PRIVILEGES ON `pms`.* TO 'pms'@'%' IDENTIFIED BY 'pms0817';

-- 查看权限

SHOW GRANTS FOR 用户名

-- 查看当前用户权限

SHOW GRANTS; 或 SHOW GRANTS FOR CURRENT_USER; 或 SHOW GRANTS FOR CURRENT_USER();

-- 撤消权限

REVOKE 权限列表 ON 表名 FROM 用户名

REVOKE ALL PRIVILEGES, GRANT OPTION FROM 用户名 -- 撤销所有权限

-- 权限层级

-- 要使用GRANT或REVOKE,您必须拥有GRANT OPTION权限,并且您必须用于您正在授予或撤销的权限。

全局层级:全局权限适用于一个给定服务器中的所有数据库,mysql.user

GRANT ALL ON *.*和 REVOKE ALL ON *.*只授予和撤销全局权限。

数据库层级:数据库权限适用于一个给定数据库中的所有目标,mysql.db, mysql.host

GRANT ALL ON db_name.*和REVOKE ALL ON db_name.*只授予和撤销数据库权限。

表层级:表权限适用于一个给定表中的所有列,mysql.talbes_priv

GRANT ALL ON db_name.tbl_name和REVOKE ALL ON db_name.tbl_name只授予和撤销表权限。

列层级:列权限适用于一个给定表中的单一列,mysql.columns_priv

当使用REVOKE时,您必须指定与被授权列相同的列。

-- 权限列表

ALL [PRIVILEGES] -- 设置除GRANT OPTION之外的所有简单权限

ALTER -- 允许使用ALTER TABLE

ALTER ROUTINE -- 更改或取消已存储的子程序

CREATE -- 允许使用CREATE TABLE

CREATE ROUTINE -- 创建已存储的子程序

CREATE TEMPORARY TABLES -- 允许使用CREATE TEMPORARY TABLE

CREATE USER -- 允许使用CREATE USER, DROP USER, RENAME USER和REVOKE ALL PRIVILEGES。

CREATE VIEW -- 允许使用CREATE VIEW

DELETE -- 允许使用DELETE

DROP -- 允许使用DROP TABLE

EXECUTE -- 允许用户运行已存储的子程序

FILE -- 允许使用SELECT...INTO OUTFILE和LOAD DATA INFILE

INDEX -- 允许使用CREATE INDEX和DROP INDEX

INSERT -- 允许使用INSERT

LOCK TABLES -- 允许对您拥有SELECT权限的表使用LOCK TABLES

PROCESS -- 允许使用SHOW FULL PROCESSLIST

REFERENCES -- 未被实施

RELOAD -- 允许使用FLUSH

REPLICATION CLIENT -- 允许用户询问从属服务器或主服务器的地址

REPLICATION SLAVE -- 用于复制型从属服务器(从主服务器中读取二进制日志事件)

SELECT -- 允许使用SELECT

SHOW DATABASES -- 显示所有数据库

SHOW VIEW -- 允许使用SHOW CREATE VIEW

SHUTDOWN -- 允许使用mysqladmin shutdown

SUPER -- 允许使用CHANGE MASTER, KILL, PURGE MASTER LOGS和SET GLOBAL语句,mysqladmin debug命令;允许您连接(一次),即使已达到max_connections。

UPDATE -- 允许使用UPDATE

USAGE -- “无权限”的同义词

GRANT OPTION -- 允许授予权限

```

### 表维护

```mysql

/* 表维护 */

-- 分析和存储表的关键字分布

ANALYZE [LOCAL | NO_WRITE_TO_BINLOG] TABLE 表名 ...

-- 检查一个或多个表是否有错误

CHECK TABLE tbl_name [, tbl_name] ... [option] ...

option = {QUICK | FAST | MEDIUM | EXTENDED | CHANGED}

-- 整理数据文件的碎片

OPTIMIZE [LOCAL | NO_WRITE_TO_BINLOG] TABLE tbl_name [, tbl_name] ...

```

### 杂项

```mysql

/* 杂项 */ ------------------

1. 可用反引号(`)为标识符(库名、表名、字段名、索引、别名)包裹,以避免与关键字重名!中文也可以作为标识符!

2. 每个库目录存在一个保存当前数据库的选项文件db.opt。

3. 注释:

单行注释 # 注释内容

多行注释 /* 注释内容 */

单行注释 -- 注释内容 (标准SQL注释风格,要求双破折号后加一空格符(空格、TAB、换行等))

4. 模式通配符:

_ 任意单个字符

% 任意多个字符,甚至包括零字符

单引号需要进行转义 \'

5. CMD命令行内的语句结束符可以为 ";", "\G", "\g",仅影响显示结果。其他地方还是用分号结束。delimiter 可修改当前对话的语句结束符。

6. SQL对大小写不敏感

7. 清除已有语句:\c

```

本文来自[木木匠](https://github.com/kinglaw1204)投稿。

<!-- TOC -->

- [一 MySQL 基础架构分析](#一-mysql-基础架构分析)

- [1.1 MySQL 基本架构概览](#11-mysql-基本架构概览)

- [1.2 Server 层基本组件介绍](#12-server-层基本组件介绍)

- [1) 连接器](#1-连接器)

- [2) 查询缓存(MySQL 8.0 版本后移除)](#2-查询缓存mysql-80-版本后移除)

- [3) 分析器](#3-分析器)

- [4) 优化器](#4-优化器)

- [5) 执行器](#5-执行器)

- [二 语句分析](#二-语句分析)

- [2.1 查询语句](#21-查询语句)

- [2.2 更新语句](#22-更新语句)

- [三 总结](#三-总结)

- [四 参考](#四-参考)

<!-- /TOC -->

本篇文章会分析下一个 sql 语句在 MySQL 中的执行流程,包括 sql 的查询在 MySQL 内部会怎么流转,sql 语句的更新是怎么完成的。

在分析之前我会先带着你看看 MySQL 的基础架构,知道了 MySQL 由那些组件组成已经这些组件的作用是什么,可以帮助我们理解和解决这些问题。

## 一 MySQL 基础架构分析

### 1.1 MySQL 基本架构概览

下图是 MySQL 的一个简要架构图,从下图你可以很清晰的看到用户的 SQL 语句在 MySQL 内部是如何执行的。

先简单介绍一下下图涉及的一些组件的基本作用帮助大家理解这幅图,在 1.2 节中会详细介绍到这些组件的作用。

- **连接器:** 身份认证和权限相关(登录 MySQL 的时候)。

- **查询缓存:** 执行查询语句的时候,会先查询缓存(MySQL 8.0 版本后移除,因为这个功能不太实用)。

- **分析器:** 没有命中缓存的话,SQL 语句就会经过分析器,分析器说白了就是要先看你的 SQL 语句要干嘛,再检查你的 SQL 语句语法是否正确。

- **优化器:** 按照 MySQL 认为最优的方案去执行。

- **执行器:** 执行语句,然后从存储引擎返回数据。

简单来说 MySQL 主要分为 Server 层和存储引擎层:

- **Server 层**:主要包括连接器、查询缓存、分析器、优化器、执行器等,所有跨存储引擎的功能都在这一层实现,比如存储过程、触发器、视图,函数等,还有一个通用的日志模块 binglog 日志模块。

- **存储引擎**: 主要负责数据的存储和读取,采用可以替换的插件式架构,支持 InnoDB、MyISAM、Memory 等多个存储引擎,其中 InnoDB 引擎有自有的日志模块 redolog 模块。**现在最常用的存储引擎是 InnoDB,它从 MySQL 5.5.5 版本开始就被当做默认存储引擎了。**

### 1.2 Server 层基本组件介绍

#### 1) 连接器

连接器主要和身份认证和权限相关的功能相关,就好比一个级别很高的门卫一样。

主要负责用户登录数据库,进行用户的身份认证,包括校验账户密码,权限等操作,如果用户账户密码已通过,连接器会到权限表中查询该用户的所有权限,之后在这个连接里的权限逻辑判断都是会依赖此时读取到的权限数据,也就是说,后续只要这个连接不断开,即时管理员修改了该用户的权限,该用户也是不受影响的。

#### 2) 查询缓存(MySQL 8.0 版本后移除)

查询缓存主要用来缓存我们所执行的 SELECT 语句以及该语句的结果集。

连接建立后,执行查询语句的时候,会先查询缓存,MySQL 会先校验这个 sql 是否执行过,以 Key-Value 的形式缓存在内存中,Key 是查询预计,Value 是结果集。如果缓存 key 被命中,就会直接返回给客户端,如果没有命中,就会执行后续的操作,完成后也会把结果缓存起来,方便下一次调用。当然在真正执行缓存查询的时候还是会校验用户的权限,是否有该表的查询条件。

MySQL 查询不建议使用缓存,因为查询缓存失效在实际业务场景中可能会非常频繁,假如你对一个表更新的话,这个表上的所有的查询缓存都会被清空。对于不经常更新的数据来说,使用缓存还是可以的。

所以,一般在大多数情况下我们都是不推荐去使用查询缓存的。

MySQL 8.0 版本后删除了缓存的功能,官方也是认为该功能在实际的应用场景比较少,所以干脆直接删掉了。

#### 3) 分析器

MySQL 没有命中缓存,那么就会进入分析器,分析器主要是用来分析 SQL 语句是来干嘛的,分析器也会分为几步:

**第一步,词法分析**,一条 SQL 语句有多个字符串组成,首先要提取关键字,比如 select,提出查询的表,提出字段名,提出查询条件等等。做完这些操作后,就会进入第二步。

**第二步,语法分析**,主要就是判断你输入的 sql 是否正确,是否符合 MySQL 的语法。

完成这 2 步之后,MySQL 就准备开始执行了,但是如何执行,怎么执行是最好的结果呢?这个时候就需要优化器上场了。

#### 4) 优化器

优化器的作用就是它认为的最优的执行方案去执行(有时候可能也不是最优,这篇文章涉及对这部分知识的深入讲解),比如多个索引的时候该如何选择索引,多表查询的时候如何选择关联顺序等。

可以说,经过了优化器之后可以说这个语句具体该如何执行就已经定下来。

#### 5) 执行器

当选择了执行方案后,MySQL 就准备开始执行了,首先执行前会校验该用户有没有权限,如果没有权限,就会返回错误信息,如果有权限,就会去调用引擎的接口,返回接口执行的结果。

## 二 语句分析

### 2.1 查询语句

说了以上这么多,那么究竟一条 sql 语句是如何执行的呢?其实我们的 sql 可以分为两种,一种是查询,一种是更新(增加,更新,删除)。我们先分析下查询语句,语句如下:

```sql

select * from tb_student A where A.age='18' and A.name=' 张三 ';

```

结合上面的说明,我们分析下这个语句的执行流程:

* 先检查该语句是否有权限,如果没有权限,直接返回错误信息,如果有权限,在 MySQL8.0 版本以前,会先查询缓存,以这条 sql 语句为 key 在内存中查询是否有结果,如果有直接缓存,如果没有,执行下一步。

* 通过分析器进行词法分析,提取 sql 语句的关键元素,比如提取上面这个语句是查询 select,提取需要查询的表名为 tb_student,需要查询所有的列,查询条件是这个表的 id='1'。然后判断这个 sql 语句是否有语法错误,比如关键词是否正确等等,如果检查没问题就执行下一步。

* 接下来就是优化器进行确定执行方案,上面的 sql 语句,可以有两种执行方案:

a.先查询学生表中姓名为“张三”的学生,然后判断是否年龄是 18。

b.先找出学生中年龄 18 岁的学生,然后再查询姓名为“张三”的学生。

那么优化器根据自己的优化算法进行选择执行效率最好的一个方案(优化器认为,有时候不一定最好)。那么确认了执行计划后就准备开始执行了。

* 进行权限校验,如果没有权限就会返回错误信息,如果有权限就会调用数据库引擎接口,返回引擎的执行结果。

### 2.2 更新语句

以上就是一条查询 sql 的执行流程,那么接下来我们看看一条更新语句如何执行的呢?sql 语句如下:

```

update tb_student A set A.age='19' where A.name=' 张三 ';

```

我们来给张三修改下年龄,在实际数据库肯定不会设置年龄这个字段的,不然要被技术负责人打的。其实条语句也基本上会沿着上一个查询的流程走,只不过执行更新的时候肯定要记录日志啦,这就会引入日志模块了,MySQL 自带的日志模块式 **binlog(归档日志)** ,所有的存储引擎都可以使用,我们常用的 InnoDB 引擎还自带了一个日志模块 **redo log(重做日志)**,我们就以 InnoDB 模式下来探讨这个语句的执行流程。流程如下:

* 先查询到张三这一条数据,如果有缓存,也是会用到缓存。

* 然后拿到查询的语句,把 age 改为 19,然后调用引擎 API 接口,写入这一行数据,InnoDB 引擎把数据保存在内存中,同时记录 redo log,此时 redo log 进入 prepare 状态,然后告诉执行器,执行完成了,随时可以提交。

* 执行器收到通知后记录 binlog,然后调用引擎接口,提交 redo log 为提交状态。

* 更新完成。

**这里肯定有同学会问,为什么要用两个日志模块,用一个日志模块不行吗?**

这是因为最开始 MySQL 并没与 InnoDB 引擎( InnoDB 引擎是其他公司以插件形式插入 MySQL 的) ,MySQL 自带的引擎是 MyISAM,但是我们知道 redo log 是 InnoDB 引擎特有的,其他存储引擎都没有,这就导致会没有 crash-safe 的能力(crash-safe 的能力即使数据库发生异常重启,之前提交的记录都不会丢失),binlog 日志只能用来归档。

并不是说只用一个日志模块不可以,只是 InnoDB 引擎就是通过 redo log 来支持事务的。那么,又会有同学问,我用两个日志模块,但是不要这么复杂行不行,为什么 redo log 要引入 prepare 预提交状态?这里我们用反证法来说明下为什么要这么做?

* **先写 redo log 直接提交,然后写 binlog**,假设写完 redo log 后,机器挂了,binlog 日志没有被写入,那么机器重启后,这台机器会通过 redo log 恢复数据,但是这个时候 bingog 并没有记录该数据,后续进行机器备份的时候,就会丢失这一条数据,同时主从同步也会丢失这一条数据。

* **先写 binlog,然后写 redo log**,假设写完了 binlog,机器异常重启了,由于没有 redo log,本机是无法恢复这一条记录的,但是 binlog 又有记录,那么和上面同样的道理,就会产生数据不一致的情况。

如果采用 redo log 两阶段提交的方式就不一样了,写完 binglog 后,然后再提交 redo log 就会防止出现上述的问题,从而保证了数据的一致性。那么问题来了,有没有一个极端的情况呢?假设 redo log 处于预提交状态,binglog 也已经写完了,这个时候发生了异常重启会怎么样呢?

这个就要依赖于 MySQL 的处理机制了,MySQL 的处理过程如下:

* 判断 redo log 是否完整,如果判断是完整的,就立即提交。

* 如果 redo log 只是预提交但不是 commit 状态,这个时候就会去判断 binlog 是否完整,如果完整就提交 redo log, 不完整就回滚事务。

这样就解决了数据一致性的问题。

## 三 总结

* MySQL 主要分为 Server 层和引擎层,Server 层主要包括连接器、查询缓存、分析器、优化器、执行器,同时还有一个日志模块(binlog),这个日志模块所有执行引擎都可以共用,redolog 只有 InnoDB 有。

* 引擎层是插件式的,目前主要包括,MyISAM,InnoDB,Memory 等。

* 查询语句的执行流程如下:权限校验(如果命中缓存)---》查询缓存---》分析器---》优化器---》权限校验---》执行器---》引擎

* 更新语句执行流程如下:分析器----》权限校验----》执行器---》引擎---redo log(prepare 状态---》binlog---》redo log(commit状态)

## 四 参考

* 《MySQL 实战45讲》

* MySQL 5.6参考手册:<https://dev.MySQL.com/doc/refman/5.6/en/>

> 本文由 [SnailClimb](https://github.com/Snailclimb) 和 [BugSpeak](https://github.com/BugSpeak) 共同完成。

<!-- TOC -->

- [事务隔离级别(图文详解)](#事务隔离级别图文详解)

- [什么是事务?](#什么是事务)

- [事务的特性(ACID)](#事务的特性acid)

- [并发事务带来的问题](#并发事务带来的问题)

- [事务隔离级别](#事务隔离级别)

- [实际情况演示](#实际情况演示)

- [脏读(读未提交)](#脏读读未提交)

- [避免脏读(读已提交)](#避免脏读读已提交)

- [不可重复读](#不可重复读)

- [可重复读](#可重复读)

- [防止幻读(可重复读)](#防止幻读可重复读)

- [参考](#参考)

<!-- /TOC -->

## 事务隔离级别(图文详解)

### 什么是事务?

事务是逻辑上的一组操作,要么都执行,要么都不执行。

事务最经典也经常被拿出来说例子就是转账了。假如小明要给小红转账1000元,这个转账会涉及到两个关键操作就是:将小明的余额减少1000元,将小红的余额增加1000元。万一在这两个操作之间突然出现错误比如银行系统崩溃,导致小明余额减少而小红的余额没有增加,这样就不对了。事务就是保证这两个关键操作要么都成功,要么都要失败。

### 事务的特性(ACID)

1. **原子性:** 事务是最小的执行单位,不允许分割。事务的原子性确保动作要么全部完成,要么完全不起作用;

2. **一致性:** 执行事务前后,数据保持一致,例如转账业务中,无论事务是否成功,转账者和收款人的总额应该是不变的;

3. **隔离性:** 并发访问数据库时,一个用户的事务不被其他事务所干扰,各并发事务之间数据库是独立的;

4. **持久性:** 一个事务被提交之后。它对数据库中数据的改变是持久的,即使数据库发生故障也不应该对其有任何影响。

### 并发事务带来的问题

在典型的应用程序中,多个事务并发运行,经常会操作相同的数据来完成各自的任务(多个用户对统一数据进行操作)。并发虽然是必须的,但可能会导致以下的问题。

- **脏读(Dirty read):** 当一个事务正在访问数据并且对数据进行了修改,而这种修改还没有提交到数据库中,这时另外一个事务也访问了这个数据,然后使用了这个数据。因为这个数据是还没有提交的数据,那么另外一个事务读到的这个数据是“脏数据”,依据“脏数据”所做的操作可能是不正确的。

- **丢失修改(Lost to modify):** 指在一个事务读取一个数据时,另外一个事务也访问了该数据,那么在第一个事务中修改了这个数据后,第二个事务也修改了这个数据。这样第一个事务内的修改结果就被丢失,因此称为丢失修改。 例如:事务1读取某表中的数据A=20,事务2也读取A=20,事务1修改A=A-1,事务2也修改A=A-1,最终结果A=19,事务1的修改被丢失。

- **不可重复读(Unrepeatableread):** 指在一个事务内多次读同一数据。在这个事务还没有结束时,另一个事务也访问该数据。那么,在第一个事务中的两次读数据之间,由于第二个事务的修改导致第一个事务两次读取的数据可能不太一样。这就发生了在一个事务内两次读到的数据是不一样的情况,因此称为不可重复读。

- **幻读(Phantom read):** 幻读与不可重复读类似。它发生在一个事务(T1)读取了几行数据,接着另一个并发事务(T2)插入了一些数据时。在随后的查询中,第一个事务(T1)就会发现多了一些原本不存在的记录,就好像发生了幻觉一样,所以称为幻读。

**不可重复度和幻读区别:**

不可重复读的重点是修改,幻读的重点在于新增或者删除。

例1(同样的条件, 你读取过的数据, 再次读取出来发现值不一样了 ):事务1中的A先生读取自己的工资为 1000的操作还没完成,事务2中的B先生就修改了A的工资为2000,导 致A再读自己的工资时工资变为 2000;这就是不可重复读。

例2(同样的条件, 第1次和第2次读出来的记录数不一样 ):假某工资单表中工资大于3000的有4人,事务1读取了所有工资大于3000的人,共查到4条记录,这时事务2 又插入了一条工资大于3000的记录,事务1再次读取时查到的记录就变为了5条,这样就导致了幻读。

### 事务隔离级别

**SQL 标准定义了四个隔离级别:**

- **READ-UNCOMMITTED(读取未提交):** 最低的隔离级别,允许读取尚未提交的数据变更,**可能会导致脏读、幻读或不可重复读**。

- **READ-COMMITTED(读取已提交):** 允许读取并发事务已经提交的数据,**可以阻止脏读,但是幻读或不可重复读仍有可能发生**。

- **REPEATABLE-READ(可重复读):** 对同一字段的多次读取结果都是一致的,除非数据是被本身事务自己所修改,**可以阻止脏读和不可重复读,但幻读仍有可能发生**。

- **SERIALIZABLE(可串行化):** 最高的隔离级别,完全服从ACID的隔离级别。所有的事务依次逐个执行,这样事务之间就完全不可能产生干扰,也就是说,**该级别可以防止脏读、不可重复读以及幻读**。

----

| 隔离级别 | 脏读 | 不可重复读 | 幻影读 |

| :---: | :---: | :---:| :---: |

| READ-UNCOMMITTED | √ | √ | √ |

| READ-COMMITTED | × | √ | √ |

| REPEATABLE-READ | × | × | √ |

| SERIALIZABLE | × | × | × |

MySQL InnoDB 存储引擎的默认支持的隔离级别是 **REPEATABLE-READ(可重读)**。我们可以通过`SELECT @@tx_isolation;`命令来查看,MySQL 8.0 该命令改为`SELECT @@transaction_isolation;`

```sql

mysql> SELECT @@tx_isolation;

+-----------------+

| @@tx_isolation |

+-----------------+

| REPEATABLE-READ |

+-----------------+

```

这里需要注意的是:与 SQL 标准不同的地方在于InnoDB 存储引擎在 **REPEATABLE-READ(可重读)**事务隔离级别下使用的是Next-Key Lock 锁算法,因此可以避免幻读的产生,这与其他数据库系统(如 SQL Server)是不同的。所以说InnoDB 存储引擎的默认支持的隔离级别是 **REPEATABLE-READ(可重读)** 已经可以完全保证事务的隔离性要求,即达到了 SQL标准的**SERIALIZABLE(可串行化)**隔离级别。

因为隔离级别越低,事务请求的锁越少,所以大部分数据库系统的隔离级别都是**READ-COMMITTED(读取提交内容):**,但是你要知道的是InnoDB 存储引擎默认使用 **REPEATABLE-READ(可重读)**并不会有任何性能损失。

InnoDB 存储引擎在 **分布式事务** 的情况下一般会用到**SERIALIZABLE(可串行化)**隔离级别。

### 实际情况演示

在下面我会使用 2 个命令行mysql ,模拟多线程(多事务)对同一份数据的脏读问题。

MySQL 命令行的默认配置中事务都是自动提交的,即执行SQL语句后就会马上执行 COMMIT 操作。如果要显式地开启一个事务需要使用命令:`START TARNSACTION`。

我们可以通过下面的命令来设置隔离级别。

```sql

SET [SESSION|GLOBAL] TRANSACTION ISOLATION LEVEL [READ UNCOMMITTED|READ COMMITTED|REPEATABLE READ|SERIALIZABLE]

```

我们再来看一下我们在下面实际操作中使用到的一些并发控制语句:

- `START TARNSACTION` |`BEGIN`:显式地开启一个事务。

- `COMMIT`:提交事务,使得对数据库做的所有修改成为永久性。

- `ROLLBACK`:回滚会结束用户的事务,并撤销正在进行的所有未提交的修改。

#### 脏读(读未提交)

<div align="center">

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-31-1脏读(读未提交)实例.jpg" width="800px"/>

</div>

#### 避免脏读(读已提交)

<div align="center">

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-31-2读已提交实例.jpg" width="800px"/>

</div>

#### 不可重复读

还是刚才上面的读已提交的图,虽然避免了读未提交,但是却出现了,一个事务还没有结束,就发生了 不可重复读问题。

<div align="center">

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-32-1不可重复读实例.jpg"/>

</div>

#### 可重复读

<div align="center">

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-33-2可重复读.jpg"/>

</div>

#### 防止幻读(可重复读)

<div align="center">

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-33防止幻读(使用可重复读).jpg"/>

</div>