讲道理,线性支持向量机,分两种情况,一个线性可分,一个线性不可分

1.线性可分:

数据线性可分,也就是说我可以训练出这么一个sign(wx+b)的模型,对于所有的训练样本都能分类正确,这里回顾一下,感知机分类是最小化错误分类,用的函数是

∑-y*(wx+b),是所有错误分类的点的误差和,而Logistic regression,用的是极大似然估计,而线性回归是1/2*∑(h(x)-y)^2 ,极小化误差,Logistic regression和linear regression最大的不同在于linear regression是直接得到wx+b,作为预测值,而logistic regression是用sigmoid函数将这个值实现了归一化,表现成概率的形式,其实也是线性回归的一种啦。

回到SVM,先定义:

函数间隔:

wx+b=0作为区分超平面(svm也使用sign(wx+b)判断分类),某个点到这个平面的距离讲道理是wx+b,但是假如将平面w=2w,b=2b,超平面就变成了2wx+2b=0,实际上超平面其实并没有变,但是一个点到这个平面的函数间隔wx+b,却翻倍了,所以用这个衡量距离不是很好,引入下面的几何间隔

几何间隔:

wx+b/(||w||),分母是w的二范数其实也就是(w1^2+w2^2+w3^2...)^(1/2)(GTMDZH,不会打公式。。。),这样几何间隔是确定的。

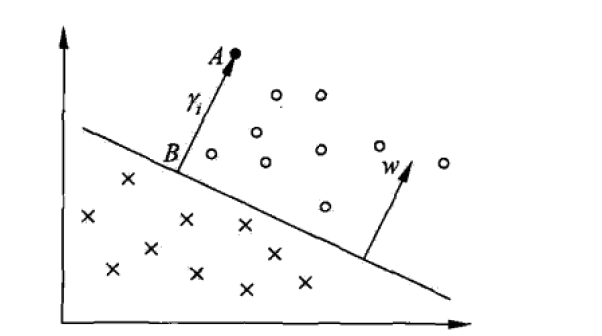

那么现在假设所有的节点已经分类正确,假设用感知机的话,这个时候已经完事了,对于所有的节点已经分类正确,但是svm改进了它,svm利用的是几何间隔最大化,

讲道理,明显是存在很多个超平面可以区分这么多点的,但是svm选择了中间那条,因为这样间隔最宽,在识别边界附近的点的情况会表现更加优秀。

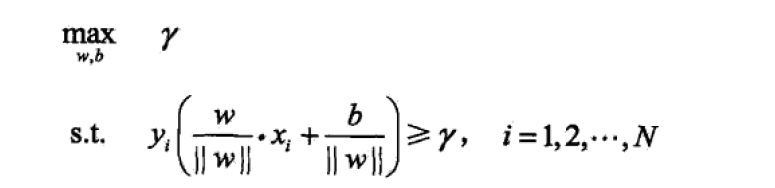

最大间隔,那么将这个作为求解函数:

γ就是里这个超平面最近的样本点到超平面的几何间隔的意思,需要最大化他,这样可以实现分类最优,下面的条件就是说所有的样本点到这个分割超平面的集合间隔是都大于他的,也就是因为前面说了γ是最近的点,那你别的点离平面不是最近,距离肯定是会大于他的嘛。

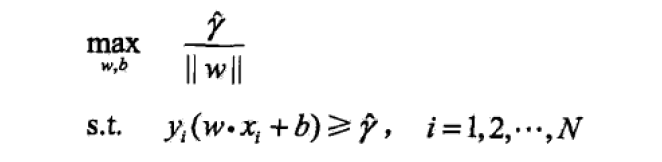

由于几何间隔跟函数间隔的关系,式子可以转化成下面这样:

上面那个符号就是函数间隔,可以看到,函数间隔的改变不会影响这个不等式约束,那么让函数间隔为1,也就是说让离超平面最近的点y*(wx+b)=1,

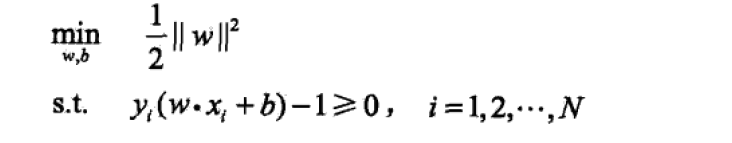

那么就变成max(1/||w||),等价转换成1/2*min(||w||^2):

这样子的式子就应当联想到KKT条件:

。。。。。。。啊,我不愿写了,哪天心情好再写吧,SVM好长好长。。。。

639

639

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?