爬点什么好呢?最近老是浏览豆瓣上的帖子,那就爬取下豆瓣读书吧!

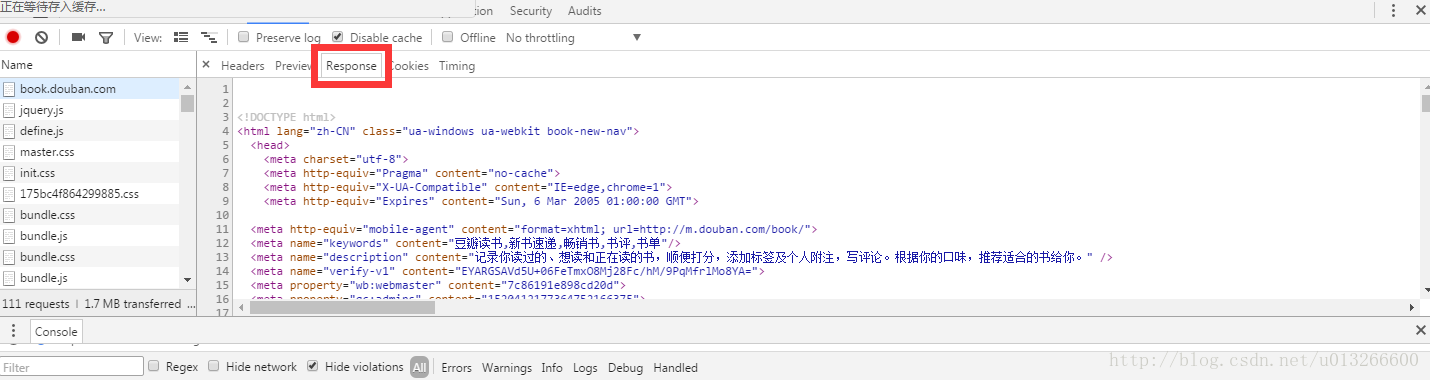

网络请求,返回值是html页面。

需要对返回回来的结果进行解析。使用Beautiful Soup来解析

参见(http://beautifulsoup.readthedocs.io/zh_CN/latest/)

说几个再爬虫中使用到的:

(1)find_all(tag,attributes,recursive,text,limit,keywords)

这个方法一般会大量使用,查找文档中含有该tag标签的所有信息

bsObj.find_all("li",{

"class":""})就是查找文档中所有的li标签,并且该标签的class属性为“”

(2)获取某个标签属性的值,可以使用tag.get(“属性名称”)

a.get("href")(3)获取标签中的文本,可以使用get_text() 方法

如以下这种:

本文介绍了如何使用Python爬虫抓取豆瓣读书的数据。通过网络请求获取HTML页面,利用Beautiful Soup解析,主要使用find_all方法查找特定标签。内容包括获取标签属性值、文本,以及从li标签下的div、h4、span等子节点提取信息。最后将数据存储到MongoDB,遇到并解决了主键重复的问题。

本文介绍了如何使用Python爬虫抓取豆瓣读书的数据。通过网络请求获取HTML页面,利用Beautiful Soup解析,主要使用find_all方法查找特定标签。内容包括获取标签属性值、文本,以及从li标签下的div、h4、span等子节点提取信息。最后将数据存储到MongoDB,遇到并解决了主键重复的问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

750

750

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?