第3集 欠拟合和过拟合的概念

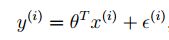

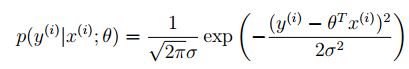

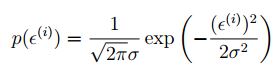

一、线性回归的解释

推出:

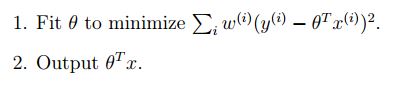

二、Locally weighted linear regression局部加权线性回归(非参数学习算法)

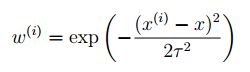

在预测值时,选取待预测x周围邻近训练集中的数据【x^(i)s,y^(i)s】进行拟合,然后预测

非负权重:

不适合大数据集,速度慢一些,因为每次要遍历所有数据。可以参考Andrew Moore的研究对其的改进

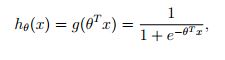

三、逻辑回归 logistic regression

线性回归不适合分类问题,当增加一个样本时,拟合出的参数差别很大,不适合分类

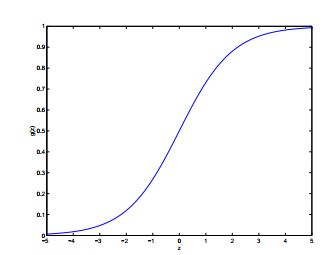

逻辑函数或sigmoid函数:

正无穷对应趋于1,负无穷对应趋于0

感知器学习算法:

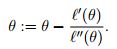

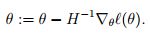

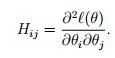

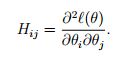

第4集 牛顿方法

迭代收敛的很快,二次方的速度,代价时每次重新计算Hessian矩阵(适合小数据集,速度快,大数据集在计算矩阵时花费代价大)

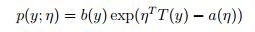

指数家族

贝努力分布——逻辑回归

高斯分布——最小二乘

GLM (Generalized Linear Models)广义线性模型

选择怎样的分布进行假设?

Bernouli:0,1问题建模

高斯: K个结果建模

泊松分布: 计数建模 例如:网站访问人数

伽马和指数分布:间隔问题建模,例如等公交车时间

beta,Dirichlet:小数建模

要做的是假设服从什么样的分布,后面的都一样

1029

1029

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?