前言:

在部署spark集群时,我们知道有三种:一种是本地模式,一种是Standalone 集群,还有一种是云端

下面我们部署的是Standalone 集群

Standalone 集群部署

官方文档::http://spark.apache.org/docs/2.4.5/spark-standalone.html

软件包

分为编译后和没有编译的软件包,没有编译的需要自己重新编译

链接:

没有编译: https://pan.baidu.com/s/1y0DsJ_LXe89S92NPitJIgA

提取码:qv1h编译后:链接:https://pan.baidu.com/s/1KgajRxSfwWsQ5DPli9R7yw

提取码:xpbe

解压,环境变量

解压软件包

tar -zxf /export/software/spark-2.4.5-bin-cdh5.16.2-2.11.tgz -C /export/server/

#创建软连接,方便后期升级

ln -s /export/server/spark-2.4.5-bin-cdh5.16.2-2.11 /export/server/spark

#进入配置目录

cd /export/server/spark/conf

#修改配置文件名称

mv spark-env.sh.template spark-env.sh

vim spark-env.sh

#添加内容如下:

JAVA_HOME=/export/server/jdk

SCALA_HOME=/export/server/scala

HADOOP_CONF_DIR=/export/server/hadoop/etc/hadoop

Workers主机名称

将【$SPARK_HOME/conf/slaves.template】名称命名为【slaves】,填写从节点名称

#进入配置目录

cd /export/server/spark/conf

##修改配置文件名称

mv slaves.template slaves

vim slaves

#内容如下:

node1.itcast.cn

node2.itcast.cn

node3.itcast.cn

配置Master、Workers、HistoryServer

在配置文件【$SPARK_HOME/conf/spark-env.sh】添加如下内容

SPARK_MASTER_HOST=node1.itcast.cn

SPARK_MASTER_PORT=7077

SPARK_MASTER_WEBUI_PORT=8080

SPARK_WORKER_CORES=1

SPARK_WORKER_MEMORY=1g

SPARK_WORKER_PORT=7078

SPARK_WORKER_WEBUI_PORT=8081

SPARK_HISTORY_OPTS="-Dspark.history.fs.logDirectory=hdfs://node1.itcast.cn:8020/spark/eventLogs/-Dspark.history.fs.cleaner.enabled=true"

创建EventLogs存储目录

启动HDFS服务,创建应用运行事件日志目录,命令如下

hadoop-daemon.sh start namenode

hadoop-daemons.sh start datanode

hdfs dfs -mkdir -p /spark/eventLogs/

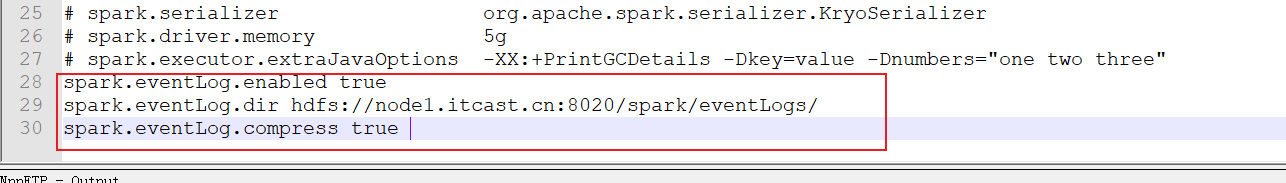

配置Spark应用保存EventLogs

将【$SPARK_HOME/conf/spark-defaults.conf.template】名称命名为【spark-defaults.conf】,

填写如下内容:

##进入配置目录

cd /export/server/spark/conf

##修改配置文件名称

mv spark-defaults.conf.template spark-defaults.conf

vim spark-defaults.conf

##添加内容如下:

spark.eventLog.enabled true

spark.eventLog.dir hdfs://node1.itcast.cn:8020/spark/eventLogs/

spark.eventLog.compress true

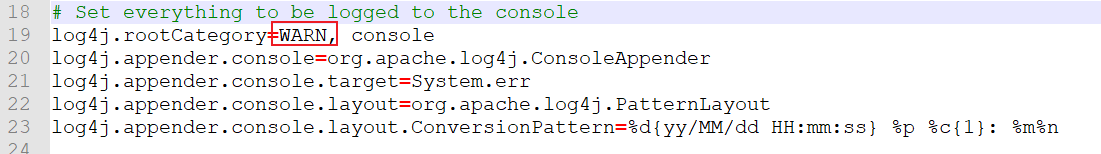

设置日志级别

将【$SPARK_HOME/conf/log4j.properties.template】名称命名为【log4j.properties】,修改

级别为警告WARN。

##进入目录

cd /export/server/spark/conf

##修改日志属性配置文件名称

mv log4j.properties.template log4j.properties

##改变日志级别

vim log4j.properties

分发到集群所有机器

将配置好的将 Spark 安装包分发给集群中其它机器,命令如下:

cd /export/server/

scp -r spark-2.4.5-bin-cdh5.16.2-2.11 root@node2.itcast.cn:$PWD

scp -r spark-2.4.5-bin-cdh5.16.2-2.11 root@ node3.itcast.cn:$PWD

##远程连接到node2.itcast.cn和node3.itcast.cn机器,创建软连接

ln -s /export/server/spark-2.4.5-bin-cdh5.16.2-2.11 /export/server/spark

启动服务进程

在Master节点node1.itcast.cn上启动,进入$SPARK_HOME,必须配置主节点到所有从节点的

SSH无密钥登录,集群各个机器时间同步。

主节点Master启动命令

/export/server/spark/sbin/start-master.sh

WEB UI页面地址:http://node1.itcast.cn:8080

从节点Workers启动命令:

/export/server/spark/sbin/start-slaves.sh

历史服务器HistoryServer:

/export/server/spark/sbin/start-history-server.sh

WEB UI页面地址:http://node1.itcast.cn:18080

测试( 提交运行圆周率)

SPARK_HOME=/export/server/spark

${SPARK_HOME}/bin/spark-submit

–master spark://node1.itcast.cn:7077

–class org.apache.spark.examples.SparkPi

${SPARK_HOME}/examples/jars/spark-examples_2.11-2.4.5.jar

10

查看Master主节点WEB UI界面:

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?