1. What:什么是Nvidia NIM

NIM是英伟达AI的Nvidia Inference Microservices,即英伟达的模型推理微服务。

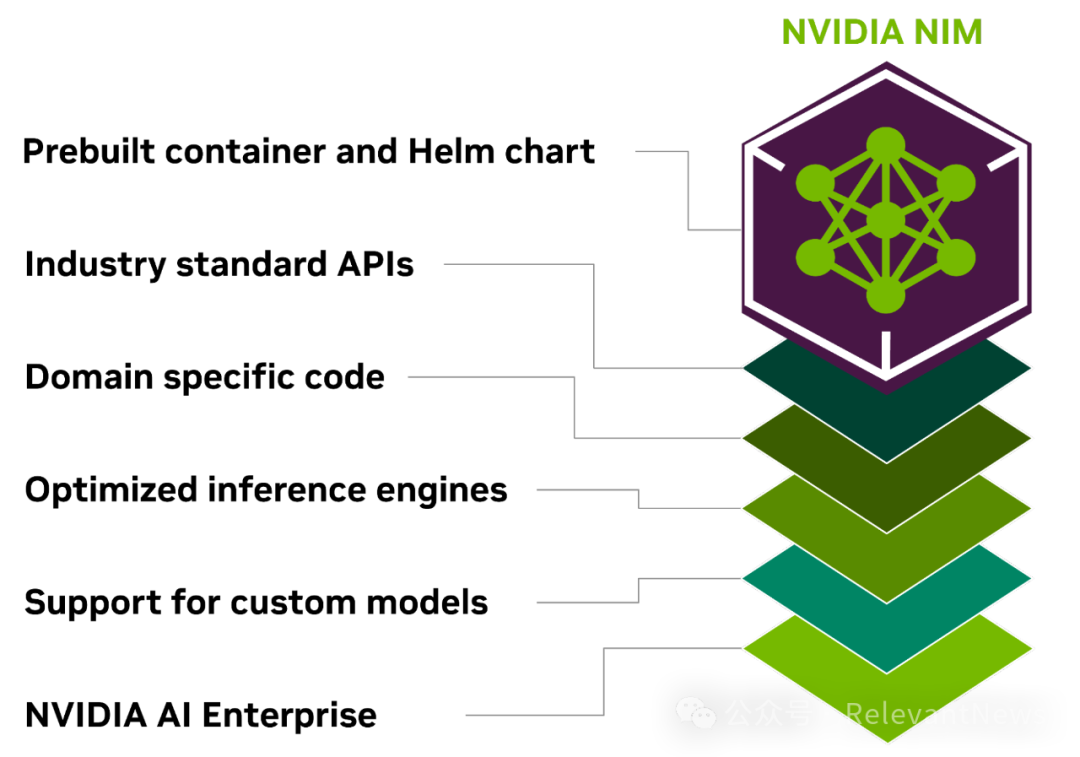

基本上,NIM是包含了大模型,并提供推理微服务的容器(Container)。大模型和推理服务经过了针对Nvidia GPU的优化。封装成容器的方式使它可以部署在云端,数据中心、工作站或在笔记本电脑中,在任何支持CUDA的GPU上运行。

NIM模型

目前,Nvidia在NIM里选择提供了二十几个经过其为其GPU和推理优化的大模型。包括Nvidia自己的、其他公司商用的和开放、开源的,文本的、语音的、图像的和多模态的,通用的和一些垂直领域的模型(详见https://build.nvidia.com/explore/discover):

大语言模型 (LARGE LANGUAGE MODELS)

google / gemma-7b

meta / codellama-70b

meta / llama2-70b

mistralai / mistral-7b-instruct

mistralai / mixtral-8x7b-instruct检索相关模型(RETRIEVAL)

nvidia / embedding-2b

nvidia / reranking-4b视觉模型 (VISUAL MODELS)

stability-ai / sdxl-turbo

stability-ai / stable-diffusion-xl

stability-ai / stable-video-diffusion多模态模型 (MULTIMODEL)

adept / fuyu-8b

google / deplot

microsoft / kosmos-2

nvidia / neva-22b健康医疗模型 (HEALTHCARE)

mit / diffdock

meta / esmfold

nvidia / molmim

nvidia / deepvariant

nvidia / fq2bam

nvidia / vista3d路径优化模型 (ROUTE OPTIMIZATION)

nvidia / cuOpt气候模拟模型 (CLIMATE SIMULATION)

nvidia / ai-weather-forecastingNIM推理引擎

以上NIM中的模型,通过同样封装在容器里的以下的两个推理引擎实现模型推理服务:

Triton Inference Server

TensorRT-LLM这两个推理引擎都是Nvidia支持的,在GPU和CPU上提供模型推理的开源软件。二者都为Nvidia GPU高效推理计算进行了优化。

2. Why:NIM的价值和意义

“Faster and Smoother Deploy AI models into production.”

对于企业用户而言,NIM的价值在于将大模型推理服务的原来需要数周才能完成部署的时间缩短到数分钟。

2024年,各类组织正在将工作重点从了解熟悉和构建AI原型上转移到全面生产部署。但大规模产品化的道路既复杂又漫长,需要专业技能、平台和流程。Nvidia NIM作为一套优化的云原生微服务,简化了云、数据中心和GPU加速工作站在任何地方部署生成AI模型。它通过抽象化人工智能模型开发和使用行业标准API进行生产打包的复杂性来扩展开发人员库。

NIM不仅将人工智能模型连接到现有企业基础设施,优化系统延迟和吞吐量;作为Nvidia AI Enterprise的一部分,日志记录、监控和安全性等运维也变得简单。

这样,NIM为开发人工智能驱动的企业应用程序和在生产中部署人工智能模型提供了简化的路径,缩短上市时间。

3. How:从不同视角看NIM的功能

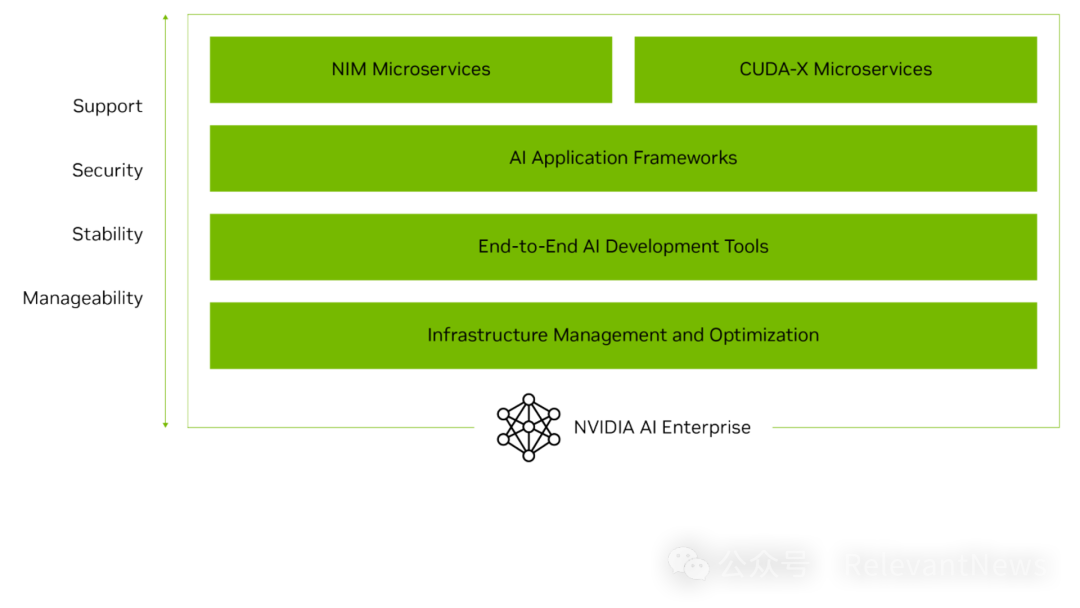

NIM是Nvidia AI Enterprise的一部分

图:Nvidia AI Enterprise是AI平台的“操作系统”

Nvidia Al Enterprise是一个端到端的云原生Al和数据分析软件套件,经过针对Nvidia GPU的优化。作为Nvidia Al平台的"操作系统",Nvidia Al Enterprise对于使用广泛的Nvidia框架库和预训练模型构建的应用程序的生产和支持至关重要。

可以看到,NIM是Nvidia AI Enterprise加速并简化生产级生成AI应用程序的开发和部署的核心部件。整套软件为易于使用的NIM(生成式AI)微服务和CUDA-X(数据处理、深度学习和高性能计算)微服务提供具有企业级安全性、支持和稳定性的优化模型性能,以确保在人工智能上运营业务的企业从原型平稳过渡到生产。

图:在Nvidia AI Enterpriset提供的基础设施管理、开发工具集和AI应用框架等,NIM和CUDA-X微服务能够为企业提供生产级的服务。

NIM是Nvidia NeMo框架的一部分

图:通过Nvidia NeMo,用户可以完成从训练数据集准备,模型训练和定制,和模型部署的大模型生产的端到端过程。Nvidia NIM是这个过程中的最后一环。Nvidia AI Enterpirse为NeMo提供了基础设施和环境。

Nvidia NeMo框架是一个端到端的云原生框架,用于在任何地方构建、定制和部署生成性AI模型。

Nvidia NeMo框架中,NeMo Curator提供训练数据准备,NeMo Customizer提供模型微调能力,NeMo Evaulator进行模型评估,NeMo Retrieval提供数据检索从而进一步构建RAG能力,NeMo Guardrails则保障生成式AI模型的安全性。最后,由Nvidia NIM完成模型的推理和使用。

使用Nvidia NIM

Nvidia NIM的使用很简单,(1)下载模型容器;(2)启动容器;(3)API调用。具体操作可参考Nvidia开发者官网的范例程序(https://developer.nvidia.com/blog/nvidia-nim-offers-optimized-inference-microservices-for-deploying-ai-models-at-scale/)

4. Who:Nvidia NIM的伙伴和客户

这一节里,与其说我们在讨论Nvidia NIM,不如说我们在讨论建立在Nvidia GPU基础之上的,Nvidia 在努力构建的AI软件护城河。从NIM在Nvidia AI Enterprise平台和Nvidia NeMo框架的定位来看,Nvidia NIM正处在Nvidia软件战略的核心。从以下的利益相关者分析,可以看到Nvidia当前的老大地位、超强能力和影响力,以及Nvidia的向软件扩张的野心。

公有云服务商

NIM Containers还在Amazon Sagemaker,Microsoft Azure和Google Kubernates Engine等主流云服务里。

大语言模型框架

NIM与Deepset.ai的Haystack,Langchain和LlamaIndex集成。通过这些框架,可实现易于使用、自定义、扩展、优化、评估并最终部署到生产中的可组合人工智能系统。

模型供应商

NIM中提供的模型,分别来自于Nvidia、A121、Adept、Cohere、Getty Images、Shutterstock、Google、Hugging Face、Meta、Microsoft、Mistral AI和Stability AI等公司。

数据平台供应商

Box、Cloudera、Cohesity、Datastax、Dropbox、NetApp和Snowflake等与NVIDIA微服务合作,帮助客户优化其RAG管道,并将其专有数据集成到生成的AI应用程序中。

基础设施软件平台

Nvidia AI企业微服务正在进入基础设施软件平台,包括VMware Private AI Foundation,红帽OpenShift,Canonical,帮助企业更轻松地将生成性人工智能功能集成到应用程序中,并优化安全性、合规性和控制功能。

AI和MLOps 合作伙伴

Nvidia由数百个AI和MLOps合作伙伴组成的生态系统,包括Abridge、Anyscale、Dataiku、DataRobot、Glean、H2O.ai、Securiti AI、Scale AI、OctoAI和Weights & Biases,通过NVIDIA AI Enterprise增加对NVIDIA微服务的支持。

向量数据库合作伙伴

Apache Lucene、Datastax、Faiss、Kinetica、Milvus、Redis和Weaviate是与Nvidia NeMo Retriever微服务合作的向量搜索提供商,为企业提供响应式RAG功能。

计算机制造和企业解决方案提供商

超过400个Nvidia认证系统也支持NVIDIA微服务,包括来自思科、戴尔技术、惠普企业(HPE)、惠普、联想和Supermicro的服务器和工作站,和用于生成AI的企业计算解决方案中。

5. 一些案例

ServiceNow

ServiceNow评估发现生成式AI已经大幅低提高了生产效率(见下图)。在Now Assist系统中,GenAI实现54%的事件偏转率来解决员工问题,缩短开发时间38%。NVIDIA NIM推理微服务已经集成在Now LLM中,供所有安装了Now Assist的ServiceNow客户使用。

药物发现 医疗技术 数字健康

Nvidia NIM为成像、医疗技术、药物发现和数字健康等不断增长的模型集合提供优化的推理。这些可用于生成生物学和化学,以及分子预测;还包括一系列药物发现模型,包括用于生成化学的MolMIM,用于蛋白质结构预测的ESMFold和DiffDock,以帮助研究人员了解药物分子如何与靶子相互作用。VISTA 3D微服务加速了3D分割模型的创建。与在CPU上运行的DeepVariant实现相比,通用DeepVariant微服务为基因组分析工作流程中的变体调用提供了超过50倍的速度改进。

Cadence正在将Nvidia BioNeMo™微服务集成到其Orion®分子设计平台中,该平台用于加速药物发现。Orion允许制药公司的研究人员生成、搜索和建模包含数千亿化合物的数据库。BioNeMo微服务,如MolMIM生成化学模型和AlphaFold-2蛋白质折叠模型,增强了Orion的设计能力。

包括Amgen、Astellas、DNA Nexus、Iambic Therapeutics、Recursion和Terray,以及V7等医学成像软件制造商在内,近50家应用程序提供商、生物技术和制药公司和平台正在使用医疗保健微服务。

改善患者和临床医生的互动

Hippocratic AI等公司则正在开发特定任务的生成人工智能医疗保健代理,这些代理通过电话与患者交谈,以安排预约,进行术前外展,进行出院后随访等。Nvidia NIM被用于进行低延迟推理和语音识别。

Abridge公司正在构建一个由人工智能驱动的临床对话平台,该平台生成笔记草稿,为临床医生每天节省多达三个小时。从嘈杂环境中的原始音频到起草文档,需要许多人工智能技术才能无缝协作。语言识别、转录、对齐和对话都必须在几秒钟内进行,对话必须根据每种话语中包含的医疗信息进行结构化,并且必须应用强大的语言模型将相关证据转化为摘要。该系统将临床对话实时转换为高质量的访问后文档。

FlyWheel公司则创建可以转换为微服务的模型。该公司基于云的集中平台为生物制药公司、生命科学组织、医疗保健提供商和学术医疗中心提供动力,帮助他们识别、策划和培训医疗成像数据,以加快洞察力的时间。

6. 总结

Nvidia Inference Microservice(NIM)是Nvidia Enterprise AI的新组件。目的在于帮助客户以安全、稳定和可扩展的方式快速部署其生成性人工智能应用程序,减少集成和开发工作量。NIM容器封装了用户进行生成式AI推理所需的一切,包括生成式AI模型和集成代码,可以部署在从本地到云端的任何地方。

Nvidia NIM推理微服务和容器处在Nvidia软件系统的中心。在如日中天的Nvidia GPU强势加持下,Nvidia积极地推动NIM与基础设施伙伴、技术合作伙伴的系统和方案的集成,和在企业客户和垂直领域业务中的应用。

Nvidia NIM巩固并大大增加了Nvidia在企业客户和伙伴系统中的存在。从底层芯片硬件、到应用微服务,Nvidia端到端地提供了完整的方案。NIM则是这个方案中负责生成式AI推理的那一块拼图。

部分参考材料

https://nvidianews.nvidia.com/news/generative-ai-microservices-for-developers

https://developer.nvidia.com/blog/nvidia-nim-offers-optimized-inference-microservices-for-deploying-ai-models-at-scale/

https://techcrunch.com/2024/03/18/nvidia-launches-a-set-of-microservices-for-optimized-inferencing/

https://nvidianews.nvidia.com/news/healthcare-generative-ai-microservices

https://www.nvidia.com/en-us/launchpad/ai/generative-ai-inference-with-nim/

https://www.hpcwire.com/2024/03/19/nvidia-looks-to-accelerate-genai-adoption-with-nim/

https://venturebeat.com/ai/whats-a-nim-nvidia-inference-manager-is-new-approach-to-gen-ai-model-deployment-that-could-change-the-industry/

https://blog.langchain.dev/nvidia-nim/

https://www.constellationr.com/blog-news/insights/nvidia-today-all-about-bigger-gpus-tomorrow-its-software-nim-ai-enterprise

https://nvidianews.nvidia.com/news/google-cloud-ai-development

https://aws.amazon.com/about-aws/whats-new/2024/03/amazon-sagemaker-integration-nvidia-nim-microservices/

https://aws.amazon.com/blogs/machine-learning/optimize-price-performance-of-llm-inference-on-nvidia-gpus-using-the-amazon-sagemaker-integration-with-nvidia-nim-microservices/

https://blocksandfiles.com/2024/03/18/nvidia-dataloop-netapp/

https://github.com/mickymultani/nvidia-NIM-RAG

https://build.nvidia.com/explore/discover

https://haystack.deepset.ai/blog/haystack-nvidia-integration

https://www.nvidia.com/en-us/ai-data-science/products/nemo/

https://docs.api.nvidia.com/nim/reference/google-gemma7b

Nvidia的NIM是一种微服务架构,包含经过GPU优化的大模型,旨在加速AI模型的部署,特别适用于生产环境。它简化了模型部署流程,与NvidiaAIEnterprise和NeMo框架集成,助力企业在云端和本地设备上高效利用GPU资源。

Nvidia的NIM是一种微服务架构,包含经过GPU优化的大模型,旨在加速AI模型的部署,特别适用于生产环境。它简化了模型部署流程,与NvidiaAIEnterprise和NeMo框架集成,助力企业在云端和本地设备上高效利用GPU资源。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?