1.介绍

部署本地DeepSeek+本地知识库,将现有的内部项目测试相关资料上传,构建测试领域模型。笔记本电脑配置较低,不能一起部署DeepSeeK+Dify。在现有服务器上创建虚拟机进行部署,尝试使用。

2.系统准备

2.1服务器介绍

硬件服务器:40核/256G服务器+CentOS7.9+KVM虚拟机

本次使用虚拟机配置:CPU:>16(实际配置32),

内存:>32G(实际配置64),

存储:400G

操作系统:CentOS7.9+最小化部署+开发相关软件

2.2操作系统设置

1.关闭Seliunx和防火墙

#防火墙关闭和禁用开机启动

systemctl disable firewalld

systemctl stop firewalld

#永久关闭selinux:

vi /etc/selinux/config SELINUX=disabled

#临时关闭selinux:

setenforce 02.配置国内ali-yum源

# yum源配置

curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repo

curl -o /etc/yum.repos.d/docker-ce.repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install epel-release -y

yum install fuse-overlayfs

#安装wget测试yum源:

yum install wget2.3安装docker、docker-compose

安装docker及docker-compose(版本要求:Docker 19.03 or later Docker Compose 1.28 or later)

#安装docker:

yum install -y yum-utils device-mapper-persistent-data lvm2 docker

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum makecache fast

#安装docker-compose,需要版本大于1.28

curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

#配置开机启动

systemctl enable docker

systemctl start docker

# 验证docker及docker-compose服务OK

systemctl status docker

docker-compose -v

docker-compose version 1.29.2, build 5becea4c

2.4docker配置国内镜像源

vi /etc/docker/daemon.json 创建文件,配置内容

vi /etc/docker/daemon.json #配置json

{

"registry-mirrors": [

"https://自己的阿里云加速器id.mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://do.nark.eu.org",

"https://dc.j8.work",

"https://docker.m.daocloud.io",

"https://dockerproxy.com",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.nju.edu.cn"

]

}

systemctl daemon-reload

systemctl restart docker3.安装ollama及DeepSeek模型

3.1安装ollama

1.在线安装:Download Ollama on Linux ,直接运行:

curl -fsSL https://ollama.com/install.sh | shPS:因我的服务器到github网络带宽原因,执行时间过长且多次都未成功,使用离线安装方式进行。

2.离线安装ollama

- 登录https://github.com/ollama/ollama/releases ,下载当前最新版本0.5.12 ollama-linux-amd64.tgz

- 上传服务器/opt/ollama目录及解压

mkdir /opt/ollama tar -xzf ollama-linux-amd64.tgz- 配置ollama服务文件

# 创建启动文件 vi /etc/systemd/system/ollama.service [Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/opt/ollama/bin/ollama serve User=root Group=root Restart=always RestartSec=3 Environment="PATH=$PATH" # 指定模型存储位置 Environment="OLLAMA_MODELS=/opt/ollama/models" # 配置ollama非本机IP访问 Environment="OLLAMA_HOST=0.0.0.0:11434" [Install] WantedBy=default.target #修改完之后,刷新 systemctl daemon-reload配置环境变量

vi /etc/profile.d/ollama.sh #ollama.sh内容如下 PATH=$PATH:/opt/ollama/bin export PATH #刷新 source /etc/profile启动以及设置开机启动

systemctl enable ollama systemctl start ollama systemctl status ollama # systemctl stop ollama ##关闭 # systemctl restart ollama ##重启6. 验证ollama

ollama -v

3.2下载DeepSeek等模型

从Ollama Search 找到对应模拟命令进行下载

#安装deepseek的默认版本:7b

ollama run deepseek-r1

#安装向量模型

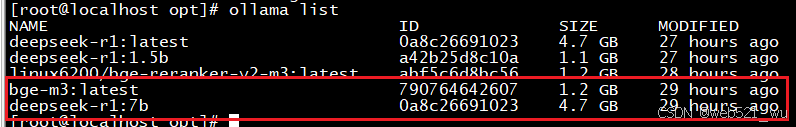

ollama pull bge-m3查看安装模型

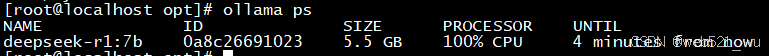

查看运行中的模型

4.Dify部署

4.1Dify部署

参考官方部署文档:Docker Compose 部署 | Dify

git clone https://github.com/langgenius/dify.git

cd /opt/dify/docker

cp .env.example .env

docker compose up -d

http://192.168.100.219/install 安装地址

http://192.168.100.219 登录地址4.2 Dify参数配置

cd /opt/dify/docker

vi .env #修改配置详见截图

#上传文件大小数量限制

# Upload file size limit, default 15M.

UPLOAD_FILE_SIZE_LIMIT=250

# The maximum number of files that can be uploaded at a time, default 5.

UPLOAD_FILE_BATCH_LIMIT=100

#重启dify所有服务,使修改配置生效

docker compose down

docker compose up -d

5.Dify配置DeepSeek等模型

5.1 添加DeepSeek+bge-m3模型

dify系统右上角--点击用户名---点击“设置”---选择模型供应商“ollama”

5.2 对接硅基流动(可选)

硅基流动统一登录 注册,创建API密钥

5.3配置dify模型设置

6.知识库导入及使用

6.1创建知识库及上传资料

6.2创建聊天助手

【角色设定】作为资深测试工程师

【详细任务描述】为xx项目集成测试写一份测试方案与计划。旨在指导测试团队明确测试目的、测试范围、测试计划、测试策略和重点、以及交付哪些交付件,和项目测试中可能出现的风险。测试时间25个工作日,测试环境分为功能测试环境、非功能(性能、稳定性、长拷)测试环境两套。要求必须进行安装部署测试和法语的本地化测试。

【关键信息补充】分多个一级标题,多个二级、三级标题,测试方案设计详细、清晰、简洁明了。

【期望输出要求】给出详细测试方案,3000字左右

使用结论:

1.已经引用了自己配置知识库,可以在不联网情况下使用DeepSeek;

2.使用deepseek-r1:7b 小型模型,因服务器无显卡、纯CPU,在进行使用时,32核基本上全部90%以上;

3.输出效果,现在使用未达到想要的效果,需要继续研究下。

7.后续

待进行

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?