提升方法的思路

对于一个复杂的任务来说,将多个专家的判断进行综合所得出的判断,要比任何一个专家的单独判断好。

在概率近似正确(probably approximately correct,PAC)学习的框架中,一个概念,如果存在一个多项式的学习方法能够学习它,并且正确率很高,那么称这个概念是可强可学习的。

一个概念,如果存在一个多项式的学习算法能够学习它,并且学习的正确率仅比随机随机猜想略好,那么这个概念是可以弱可学习的。

在PAC学习的框架下,强可学习和弱化学习是等价的,一个概念是强可学习的充分必要条件是这个概念是弱可学习的。一般来说弱可学习的方法发现比强可学习的更为容易,如果对于一个问题发现了弱可学习的方法,可以组合这些弱分类器形成一个强分类器,将若分类方法提升(boost)为强可学习的方法。

大多数提升法都是改变训练数据的概率分布(训练数据的权值分布),针对不同的训练数据分布调用弱学习的算法学习一系列的若分类器

提升法需要解决的问题

1.每一轮如何改变训练数据的权值或概率分布;2.如何将弱分类器组合成一个强分类器。

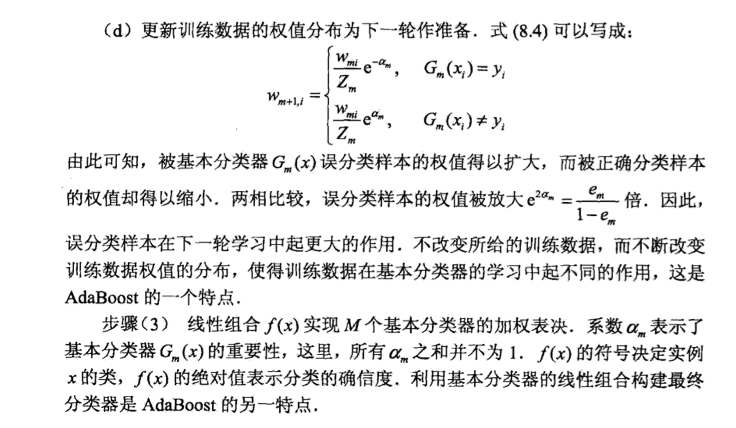

AdaBoost的做法是,提高那些被前一轮弱分类器错误分类的样本的权值,降低那些被正确分类的样本的权值。这样一来,那些没有得到正确分类的数据,由于其权值的加大而受到后一轮的若分类器的更大关注。于是,分类问题被一系列的弱分类器分而治之。至于弱分类器的组合,AdaBoost采取多数表决的方法。具体来说是加大分类误差率小的弱分类器的权值,使其在表决中起较大的作用,减少分类误差率达的弱分类器的权值,使其在分类表决中起较小的作用。

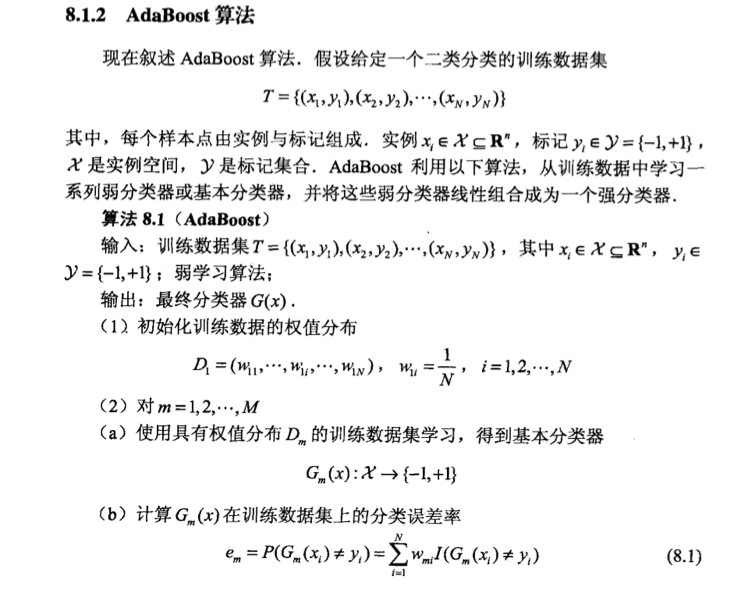

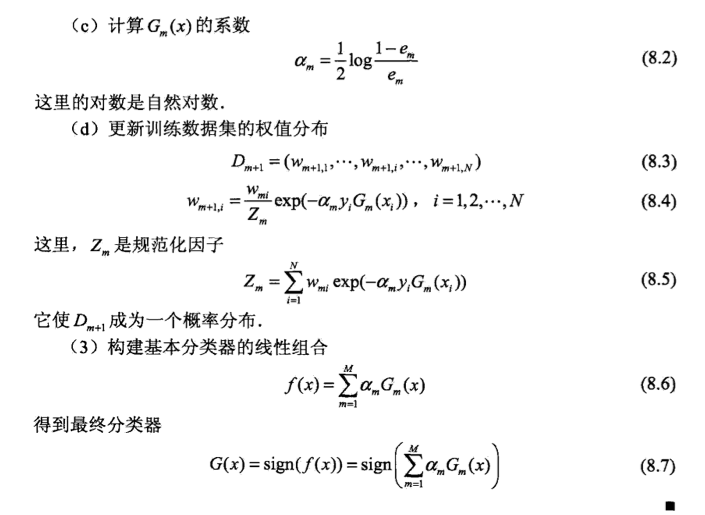

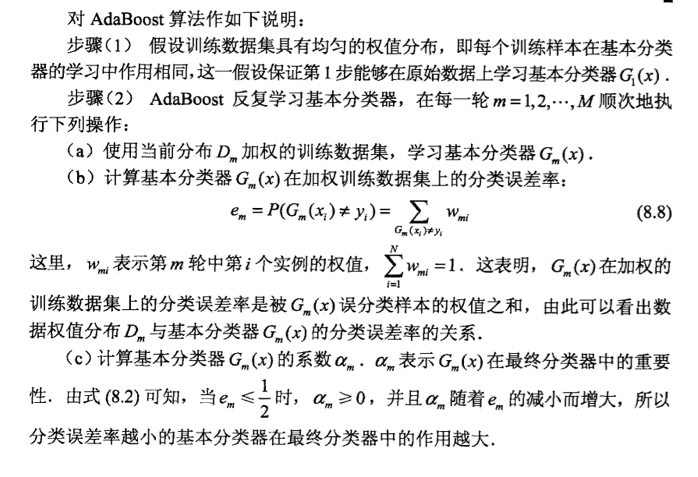

AdaBoost算法

具体例子和提升树方法见李航老师统计学习方法

757

757

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?