简介:大数据时代,Kafka的分布式消息处理能力和JVM的优化对于提升系统性能至关重要。本笔记深入探讨了Kafka的基础架构、大数据中的应用以及JVM的内存模型、垃圾回收机制,并通过案例分析介绍如何进行性能调优和问题解决。

1. Kafka基本概念和架构

1.1 Kafka的诞生与发展历程

Apache Kafka是在2011年由LinkedIn公司开发的一个分布式流处理平台,最初作为内部消息系统使用,用于处理公司网站活动数据。随着其稳定性和性能优势的显现,Kafka逐渐被开源社区所采纳,并在2012年成为Apache基金会的一个项目。此后,Kafka的版本不断演进,引入了更多的功能和改进,如事务支持、幂等性生产和流式处理API等。社区也在快速增长,为Kafka贡献了大量插件和集成,使其能够与各种大数据和云服务无缝对接。

1.2 Kafka的核心组件和工作原理

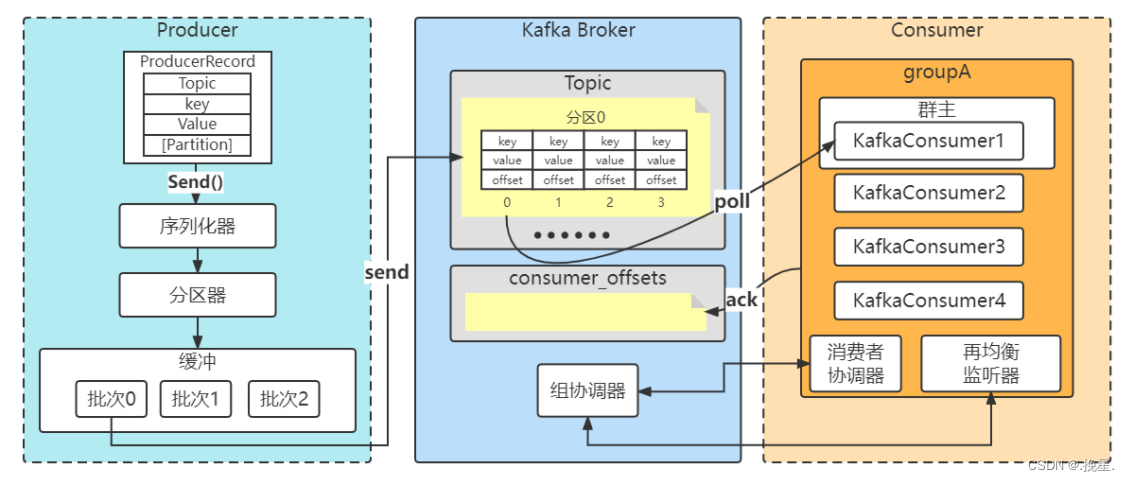

Kafka的核心组件包括生产者(Producer)、消费者(Consumer)、代理(Broker)、主题(Topic)和分区(Partition),以及副本(Replica)和领导者选举机制。生产者负责发送消息到代理,消费者则从代理获取消息,而代理则是运行Kafka服务的服务器。主题是消息的分类名,而分区是主题的并行处理单元。副本机制保障了数据的高可用性。领导选举机制则确保了在代理宕机时,系统能够快速恢复服务,从而达到高吞吐量和低延迟的处理目标。

1.3 Kafka的配置和优化

配置Kafka的Broker涉及多个参数,比如 ***work.threads 和 num.io.threads 控制网络和IO线程数量, log.flush.interval.messages 和 log.flush.interval.ms 定义消息的持久化频率。搭建Kafka集群时,需考虑副本因子和分区数量以优化性能和容错能力。监控和调优涉及使用内置的JMX接口和第三方工具,监控日志大小、消息吞吐量和延迟等关键指标,以便及时发现瓶颈并进行相应的调整。

2. Kafka在大数据处理中的应用

2.1 Kafka作为消息队列的使用

消息队列是现代分布式系统中不可或缺的组件,它承担着解耦合、异步处理和流量削峰等重要功能。Kafka凭借其高性能、可水平扩展以及持久化等特性,成为了大数据处理中消息队列的首选。

2.1.1 消息队列的基本原理

消息队列允许多个生产者(发送消息的服务或系统)和多个消费者(接收消息的服务或系统)之间进行通信。这种通信是通过消息的发送和接收来完成的。消息队列作为中间件,主要处理以下问题:

- 解耦 :系统之间不需要直接连接,只需要通过消息队列进行通信。

- 异步处理 :消息生产者发送消息后不必等待消息消费者处理完成即可继续后续操作,提高了系统的吞吐量。

- 扩展性 :通过增加消费者数量,可以提升消息处理能力。

- 保证顺序 :在某些情况下,消息队列能够保证消息的消费顺序与生产顺序一致。

2.1.2 Kafka在数据流处理中的作用

Kafka作为消息队列,可以处理各种类型的数据,包括日志、事件、传感器数据等。在数据流处理中,Kafka能够:

- 提供高吞吐量的读写能力 :Kafka能够支持每秒数百万条消息的生产与消费。

- 持久化消息 :Kafka的消息在被消费前会持久化在磁盘上,这为数据流处理提供了可靠的存储。

- 水平扩展 :通过增加更多的Kafka代理(Broker)可以线性提升Kafka集群的容量和吞吐量。

2.2 Kafka在实时数据处理中的角色

实时数据处理是大数据生态系统的核心组成部分,它涉及到实时分析、决策支持和数据的实时整合等场景。

2.2.1 实时数据处理架构的组成

一个典型的实时数据处理架构包括数据的生产者、消息队列(Kafka)、实时处理引擎(如Storm、Spark Streaming等)、数据存储和数据的消费者。Kafka在其中扮演了中心枢纽的角色,它负责收集来自不同数据源的数据,为实时处理引擎提供一个统一的输入通道。

2.2.2 Kafka与Storm、Spark Streaming的集成

Kafka与实时处理引擎的集成可以为用户提供端到端的实时数据处理解决方案。例如:

- Kafka与Storm :Storm是一个实时计算系统,通过Kafka的Spout组件可以实现对Kafka队列的实时读取。

- Kafka与Spark Streaming :Spark Streaming提供了对接Kafka的Direct API,允许直接从Kafka中读取数据进行批处理。

2.3 Kafka在企业级应用中的实践

Kafka不仅适用于构建数据管道和流处理系统,它在企业级应用中也有广泛的应用。

2.3.1 日志收集和监控系统

在大型企业系统中,日志的收集和分析是至关重要的。Kafka可以作为日志收集系统的一部分,收集来自不同服务的日志消息,然后传递给日志分析和监控系统,如ELK(Elasticsearch, Logstash, Kibana)堆栈。

2.3.2 构建数据管道和ETL流程

数据管道是数据从源系统流向目标系统的一种机制。Kafka提供了一个灵活的数据管道模型,它允许开发者构建复杂的ETL(Extract, Transform, Load)流程。数据先被生产者发送到Kafka队列,然后由消费者进行处理、转换,并最终加载到目的地,例如数据仓库或数据库。

为了实现这些功能,Kafka集群需要进行合理的配置和优化,这包括但不限于合理设置分区数量、副本数量以及监控Kafka集群的健康状态。在实际的企业应用中,Kafka集群的搭建和管理是一个持续的过程,需要根据业务的实时数据处理需求进行调整和优化。在接下来的章节中,我们将深入探讨Kafka集群的配置和优化策略。

3. JVM架构与内存模型

3.1 JVM的基本概念

3.1.1 Java虚拟机的定义和作用

Java虚拟机(JVM)是运行Java程序的核心平台,它为Java程序提供了一个与平台无关的执行环境。JVM的主要作用是将编译后的Java字节码(.class文件)转换成机器码,由操作系统执行。这个过程涉及类加载、字节码验证、解析、执行等步骤,确保了Java程序的跨平台性和安全性。

JVM负责内存管理、垃圾回收、线程调度和安全机制等底层操作。它通过将Java代码编译成字节码,然后在不同平台上的JVM实例解释执行,屏蔽了底层操作系统的差异,实现了“一次编写,到处运行”的目标。JVM也允许Java程序访问本地方法库,从而与底层操作系统交互,但这种交互仍然受到JVM的安全和隔离管理。

3.1.2 JVM的历史和主要实现

JVM的发展历史悠久,从最初的Sun Java 1.0版本到现在广泛使用的OpenJDK和Oracle JDK,Java虚拟机不断演化以适应新的应用需求和技术标准。

JVM的主要实现包括由Oracle提供的Oracle JDK,以及其开源版本OpenJDK。此外,还有其他厂商和社区提供的实现,如Amazon Corretto、AdoptOpenJDK(现为Eclipse Adoptium)等。这些实现大多遵循Java虚拟机规范,但也包含一些独有的优化和特性。

3.2 JVM的内存结构

3.2.1 堆(Heap)和栈(Stack)的区别

JVM的内存结构主要分为堆、栈、方法区、本地方法栈和程序计数器几大部分。其中,堆和栈是最基本的内存区域,它们在Java程序运行中扮演着核心角色。

堆(Heap)是JVM中用于存储对象实例和数组的内存区域。它是由垃圾回收器管理的主要区域,因此也被称为“垃圾回收堆”。堆可以是物理上不连续的内存空间,但逻辑上是连续的。所有线程共享堆内存,这也意味着在多线程环境下,堆内存需要处理好同步和并发控制,以避免数据不一致和竞争条件。

栈(Stack)是线程私有的,每个线程会创建自己的栈。它用来存储局部变量和方法调用的上下文。当方法执行时,方法的参数、局部变量和返回地址等信息都会被压入栈中。栈区的内存分配和回收速度非常快,因为它采用了“后进先出”的方式管理。当一个方法执行完毕,它的栈帧就会被弹出,相关的内存随之释放。

3.2.2 方法区(Method Area)和本地方法栈(Native Method Stack)

方法区(Method Area)用于存储已被JVM加载的类信息、常量、静态变量等数据。它与堆内存一样,被所有线程共享。方法区在Java虚拟机规范中并没有强制指定垃圾回收行为,有些JVM实现可能会对方法区进行垃圾回收,而有些则不会。

本地方法栈(Native Method Stack)是为执行本地方法(即使用Java以外的语言编写的方法)服务的。它与普通的栈功能类似,但是专门为调用本地方法而存在。在某些JVM实现中,本地方法栈和Java栈可能是同一个。

3.3 JVM的垃圾回收机制

3.3.1 垃圾回收算法和策略

垃圾回收(Garbage Collection,GC)是JVM管理内存的一种机制。其目的是自动识别和回收不再被使用的对象,以防止内存泄漏和内存溢出等问题。JVM采用了不同的垃圾回收算法和策略,常见的有标记-清除(Mark-Sweep)、复制(Copying)、标记-整理(Mark-Compact)和分代收集(Generational Collection)算法。

标记-清除算法分为标记和清除两个阶段。首先标记出所有需要回收的对象,在标记完成后统一回收掉所有被标记的对象。这个算法的缺点是效率不高,并且会产生大量的内存碎片。

复制算法通过将内存分成两个大小相等的部分,并将活跃对象复制到新的内存区域中,然后回收整个旧的内存区域。这种方法简单高效,适用于新生代的垃圾回收,但会浪费一定比例的内存空间。

标记-整理算法是标记-清除算法的改进版,它在清除阶段将存活对象向一端移动,然后直接回收掉边界以外的内存。这种方法解决了内存碎片问题,但增加了移动对象的开销。

分代收集算法将对象根据存活时间的长短分为不同的代,通常分为新生代(Young Generation)和老年代(Old Generation)。不同代采用不同的垃圾回收算法。新生代通常采用复制算法,老年代则采用标记-清除或标记-整理算法。

3.3.2 常见垃圾回收器的选择与应用

JVM中有多种垃圾回收器可供选择,不同的垃圾回收器适用于不同的场景和需求。常见的垃圾回收器包括Serial GC、Parallel GC、CMS、G1 GC和ZGC等。

Serial GC是最简单的单线程垃圾回收器,它使用标记-清除算法,并且在收集过程中会暂停所有应用程序线程,因此适合单核处理器和内存较小的应用环境。

Parallel GC(也称为Throughput GC)是一种并行执行的垃圾回收器,它通过多个线程进行垃圾回收,旨在提高吞吐量。适用于多核处理器,追求高吞吐量的应用。

CMS(Concurrent Mark Sweep)垃圾回收器是一种面向服务器端应用的垃圾回收器,它主要关注缩短垃圾回收的停顿时间。CMS使用标记-清除算法,并尽量减少应用程序的停顿。

G1 GC(Garbage-First Garbage Collector)是为适应大内存和多核处理器设计的垃圾回收器。它将堆内存划分为多个区域,可以并发地进行垃圾回收,并且在保证低停顿的前提下尽可能地提升吞吐量。

ZGC(Z Garbage Collector)是一个可伸缩的低延迟垃圾回收器,它可以处理从几MB到几个TB的内存大小,且停顿时间不受堆大小影响,适用于需要低延迟的应用场景。

JVM垃圾回收器的选择依赖于具体的应用需求、硬件环境和预期的性能指标。通常,开发者需要通过实验来确定最适合自己应用的垃圾回收器。

在实际应用中,JVM的垃圾回收是一个复杂的过程,涉及到内存分配、对象标记、清除或回收等多个步骤。理解这些过程对于优化JVM性能至关重要,因此在生产环境中要密切关注垃圾回收日志和性能指标,以便及时调整和优化。

// 示例代码:在Java中打印垃圾回收器名称

System.out.println("Garbage Collector name: " + ManagementFactory.getGarbageCollectorMXBeans());

通过上述代码,我们可以获取当前JVM中配置的垃圾回收器的信息,这有助于开发者了解和分析JVM的垃圾回收行为。对于垃圾回收器的选择与应用,不同JVM实现和不同版本可能会有细微的差别,因此在实际使用时需要结合具体的JVM文档和版本特性进行配置和调优。

4. Kafka与JVM的交互和性能优化

4.1 Kafka客户端与JVM的交互机制

4.1.1 JVM中Kafka客户端的工作原理

在JVM上运行的Kafka客户端涉及生产者和消费者两个主要的组件,它们通过网络与Kafka集群进行交互。JVM在处理这些交互时,首先会加载对应的Kafka客户端库,接着客户端会初始化连接到Kafka集群的配置,包括集群地址、端口、安全协议等。

生产者客户端将消息序列化后,通过网络发送到Kafka集群中指定的主题分区上。生产者通过发送请求给Leader分区的Broker来完成消息的写入。当写入完成后,leader会通知生产者消息已成功提交。

消费者客户端则通过订阅主题并定期向集群中的Broker发送Pull请求来获取消息。消费者通过轮询或基于偏移量的方式从分区中拉取消息。客户端同时负责与集群中的Broker进行协调,以确保消息被正确地处理,例如处理消费者的再均衡和故障转移。

4.1.2 客户端性能参数的调优

在JVM中运行Kafka客户端时,性能参数的调整至关重要。这涉及到多个方面的配置,如连接参数、批处理大小、内存缓冲区大小以及并发级别等。

-

batch.size:控制生产者在发送消息前等待数据累积到多少字节再发送,以减少网络请求的数量。 -

linger.ms:与batch.size配合使用,控制生产者发送请求前等待的时间。 -

fetch.min.bytes:消费者拉取消息时的最小数据量,以减少网络往返次数。 -

fetch.max.wait.ms:消费者在等待更多数据时的最长等待时间。 -

max.partition.fetch.bytes:指定单次拉取请求中每个分区的最大字节数。

调整这些参数时,需要考虑系统的具体需求和硬件条件,以找到性能和延迟之间的最佳平衡点。

Properties props = new Properties();

// 添加Kafka消费者和生产者配置

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "test-group");

props.put("***mit", "true");

props.put("***mit.interval.ms", "1000");

props.put("key.deserializer", "***mon.serialization.StringDeserializer");

props.put("value.deserializer", "***mon.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 生产者配置

Properties producerProps = new Properties();

producerProps.put("bootstrap.servers", "localhost:9092");

producerProps.put("key.serializer", "***mon.serialization.StringSerializer");

producerProps.put("value.serializer", "***mon.serialization.StringSerializer");

KafkaProducer<String, String> producer = new KafkaProducer<>(producerProps);

4.2 Kafka与JVM内存管理的结合

4.2.1 内存溢出和内存泄漏的诊断

在使用Kafka客户端时,内存溢出和内存泄漏是两个常见的问题。JVM内存模型中,堆内存主要存储对象实例,而方法区存储类信息等。Kafka客户端在大量消息处理过程中可能会消耗大量内存,尤其是当消息未被及时处理时。

诊断内存溢出通常需要分析GC日志来定位问题。同时,使用JVM监控工具(如JVisualVM、JProfiler)来监控内存使用情况,查看是否有持续增加的内存占用。

内存泄漏的诊断则更复杂,需要分析内存快照。可以使用如MAT(Memory Analyzer Tool)这样的工具来分析JVM的堆转储文件(heap dump),识别出内存中不再使用的对象。

4.2.2 JVM参数对Kafka性能的影响

JVM的参数设置对Kafka客户端的性能有显著影响。例如:

-

-Xms和-Xmx参数控制堆内存的初始大小和最大大小,设置不当可能导致频繁的GC,影响性能。 -

-XX:+UseG1GC启用G1垃圾收集器,适用于需要低延迟的应用。 -

-XX:+UseStringDeduplication开启字符串去重,可以节省大量堆内存,但会增加CPU的使用率。 -

-XX:+UseCompressedOops在64位JVM中使用压缩普通对象指针(OOP),有助于减少内存占用。

正确配置这些参数对于优化Kafka客户端的性能至关重要。

java -Xms256m -Xmx2048m -XX:+UseG1GC -XX:+UseStringDeduplication -XX:+UseCompressedOops -jar kafka-client-app.jar

4.3 Kafka在JVM上运行时的性能优化

4.3.1 性能瓶颈的分析方法

分析Kafka在JVM上的性能瓶颈通常包括以下几个步骤:

- 监控JVM指标 :通过JVM监控工具获取指标,如内存使用、线程状态、GC情况等。

- 分析GC日志 :详细分析GC日志,判断是否存在频繁的Full GC,以及GC的停顿时间是否影响了实时性。

- 瓶颈定位 :利用JVM分析工具识别瓶颈,可能是内存溢出、CPU占用率过高或I/O瓶颈。

4.3.2 多线程和并发控制的优化策略

在JVM中,Kafka客户端的性能也受到多线程和并发控制的影响。以下是一些优化策略:

- 线程池管理 :合理配置线程池的大小,避免创建过多的线程导致上下文切换频繁。

- 异步I/O操作 :使用异步I/O操作减少阻塞,提高吞吐量。

- 避免线程死锁 :确保线程安全,避免锁竞争,减少死锁的可能性。

- 减少锁的粒度 :优化锁的使用,减小锁的范围,可以提高并发性能。

ExecutorService executorService = Executors.newFixedThreadPool(10);

// 生产者异步发送消息的示例

executorService.submit(() -> {

producer.send(new ProducerRecord<>(topic, message));

});

通过这些策略,可以有效提升Kafka客户端在JVM上的运行效率和性能。

5. 实际案例分析与高并发场景优化

5.1 高并发下的Kafka应用实践

5.1.1 案例背景与问题描述

在高并发的业务场景下,Kafka作为消息中间件,往往会遇到巨大的消息吞吐压力。某电商平台在促销活动期间,面临用户访问量激增导致消息积压,进而影响整个系统的稳定性和响应速度。这不仅影响用户体验,还有可能引发后续的服务雪崩效应。

5.1.2 解决方案和性能评估

为解决这一问题,我们采取了以下步骤进行优化:

- 增加Broker节点 :首先,通过横向扩展增加了Kafka集群的Broker节点,提升了系统的整体消息处理能力。

- 调整分区策略 :优化了分区策略,使得数据能够更均匀地分布到各个分区中,减少了数据热点问题。

- 配置参数优化 :调整了Kafka相关参数,例如

***work.threads、num.io.threads、socket.send.buffer.bytes等,来提升网络处理能力和IO吞吐。 - 消息压缩 :开启消息压缩功能,减少了网络传输的数据量,提高了吞吐率。

- 监控和报警机制 :建立实时监控系统,对于性能瓶颈进行及时的报警和分析。

在实施了以上措施后,我们进行了性能评估:

- 消息吞吐率 :通过JMeter模拟高并发场景下消息的生产和消费,我们观察到消息吞吐率有显著提升。

- 系统延迟 :系统整体延迟降低,保证了用户请求的及时响应。

- 资源占用 :CPU和内存的使用率较优化前有所降低,说明资源利用更加高效。

5.1.3 性能优化代码示例及逻辑分析

在代码层面上,我们使用Kafka的Java客户端进行消息的生产和消费操作。以下是代码示例:

// 创建Kafka生产者

Properties properties = new Properties();

properties.put("bootstrap.servers", "broker1:9092,broker2:9092");

properties.put("key.serializer", "***mon.serialization.StringSerializer");

properties.put("value.serializer", "***mon.serialization.StringSerializer");

KafkaProducer<String, String> producer = new KafkaProducer<>(properties);

// 发送消息

ProducerRecord<String, String> record = new ProducerRecord<>("test-topic", "key", "value");

producer.send(record);

// 关闭生产者

producer.close();

在这段代码中,我们首先创建了一个 Properties 对象来配置Kafka生产者参数,指定了Kafka集群地址、序列化方式等。然后,创建 KafkaProducer 实例并发送消息。最后,关闭生产者资源。

性能优化的关键在于合理配置生产者参数。比如,调整 batch.size 和 linger.ms 可以平衡消息的发送速度和批量发送的效率; compression.type 参数可以开启消息压缩以减少网络负载。

5.2 实际案例中的JVM优化

5.2.1 JVM优化前的性能分析

在进行JVM优化之前,需要对JVM的性能进行详细的分析。使用JVM自带的监控工具,比如 jvisualvm ,进行堆内存使用情况的监控,以及 jstat 命令来分析GC日志,确定是否存在频繁的Full GC导致的性能瓶颈。通过分析发现,应用存在短命对象过多导致的频繁GC,CPU使用率不稳定。

5.2.2 优化措施和效果对比

为了减轻GC压力,我们采取了以下优化措施:

- 调整堆大小 :将堆内存调整至合理的大小,以适应当前的业务需求,避免频繁的GC。

- 选择合适的垃圾收集器 :根据应用的特点,选择了更适合的垃圾收集器组合,例如使用G1收集器来更好地处理大堆内存。

- 优化代码逻辑 :对业务代码进行了优化,减少不必要的对象创建和循环引用。

- 参数调优 :调整JVM启动参数,如

-XX:+UseStringDeduplication来减少字符串占用的内存空间。

优化效果显著,通过对比优化前后的监控数据,发现Full GC的频率和持续时间都有了明显下降,内存泄漏问题得到了解决。应用的响应时间缩短,系统的稳定性也得到了提升。

5.2.3 JVM优化案例Mermaid流程图展示

下面是优化前后的对比流程图:

graph TD

A[开始分析JVM性能] --> B[监控工具分析堆内存使用]

B --> C{是否频繁Full GC?}

C -->|是| D[调整堆大小]

C -->|否| E[检查代码逻辑]

D --> F[选择合适的垃圾收集器]

E --> F

F --> G[调整JVM参数]

G --> H[优化效果对比分析]

H -->|性能提升| I[优化成功]

H -->|无明显改善| J[进一步分析原因]

5.3 Kafka与JVM协同优化案例

5.3.1 协同优化的目标和方法

在进行高并发场景优化时,Kafka与JVM的协同优化至关重要。目标是保证Kafka集群在高负载下稳定运行,同时保证客户端JVM的性能。协同优化的方法包括:

- 资源管理 :合理分配Kafka集群资源和JVM堆内存,避免资源竞争。

- 性能监控 :建立统一的监控系统,实时监控Kafka和JVM的状态。

- 参数调优 :根据Kafka与JVM的性能数据,动态调整相关参数。

- 故障预判 :通过监控数据分析,预测潜在的性能瓶颈和故障点。

5.3.2 案例总结和未来展望

通过以上案例,我们可以看到协同优化能够显著提升系统的整体性能和稳定性。未来,我们计划引入更先进的AI监控和预测工具,进一步减少人工干预的需求,实现智能化的系统优化。此外,随着技术的发展,我们也将探索使用新型的消息中间件来满足不断增长的业务需求。

6. Kafka与JVM的交互和性能优化

4.1 Kafka客户端与JVM的交互机制

4.1.1 JVM中Kafka客户端的工作原理

在JVM中,Kafka客户端通过Java API与Kafka集群进行交互。客户端包含生产者(Producer)和消费者(Consumer),它们负责消息的发送与接收。生产者将消息发布到指定的Topic,而消费者订阅这些Topic,并从分区中拉取消息进行消费。整个过程是基于网络IO的阻塞或非阻塞操作,依赖于底层的网络库和序列化机制来实现高效的数据传输。

在JVM内部,Kafka客户端的实现通过多线程模型来提升性能,允许生产者和消费者在后台进行消息的发送和接收,而不会阻塞主线程的其他操作。然而,这也带来了线程管理的复杂性,需要合理分配线程资源,避免线程竞争和死锁。

4.1.2 客户端性能参数的调优

为了提高Kafka客户端的性能,可以通过调整客户端的参数来达到预期的效果。比如生产者可以通过调整 batch.size 和 linger.ms 来控制批量发送的大小和等待时间,以减少网络请求次数,提升吞吐量。而消费者则可以调整 fetch.min.bytes 和 fetch.max.wait.ms 来控制每次拉取的消息大小和等待时间,以避免过早的或频繁的请求。

代码示例展示如何在Java代码中配置生产者的相关参数:

Properties props = new Properties();

// 设置Kafka服务器地址

props.put("bootstrap.servers", "localhost:9092");

// 设置序列化类

props.put("key.serializer", "***mon.serialization.StringSerializer");

props.put("value.serializer", "***mon.serialization.StringSerializer");

// 设置生产者参数

props.put("batch.size", 16384);

props.put("linger.ms", 1);

// 初始化生产者

KafkaProducer<String, String> producer = new KafkaProducer<>(props);

在这个例子中,我们设置了 batch.size 为16384字节, linger.ms 为1毫秒,这会使得生产者尽可能地将消息批量发送,而不是每条消息都立即发送。这有助于减少网络I/O开销,并增加单次网络请求的数据量。

4.2 Kafka与JVM内存管理的结合

4.2.1 内存溢出和内存泄漏的诊断

内存问题在Kafka客户端运行中是一个常见的问题。内存溢出(OutOfMemoryError)通常发生在Java堆内存不足以存储更多的对象时。而内存泄漏(Memory Leak)是由于程序中的对象不再使用时,引用依然存在,导致垃圾回收器无法回收这些对象,最终导致内存无法释放。

诊断这些内存问题通常需要使用JVM提供的诊断工具,如jvisualvm和jmap。通过分析堆转储(Heap Dump)文件,可以找出内存泄漏的源头以及内存溢出的原因。

4.2.2 JVM参数对Kafka性能的影响

JVM的参数配置对Kafka的性能有着重大的影响。例如,堆大小(-Xms和-Xmx参数)决定了JVM可用的最大内存,过小的堆内存会导致频繁的垃圾回收,影响性能。另外,新生代(Young Generation)和老年代(Old Generation)的比例设置对对象的分配和垃圾回收策略也有显著影响。

代码示例展示如何在启动JVM时设置堆大小:

java -Xms2g -Xmx2g -jar kafka-client.jar

在这个例子中,我们通过 -Xms2g 和 -Xmx2g 设置了JVM初始堆大小和最大堆大小为2GB,确保了应用程序有足够的内存空间来处理大量的消息。

4.3 Kafka在JVM上运行时的性能优化

4.3.1 性能瓶颈的分析方法

性能瓶颈分析可以通过监控Kafka客户端的JVM指标来进行。通常,CPU使用率、内存使用率、网络I/O和磁盘I/O是性能分析的重点。使用Java Flight Recorder或VisualVM等工具可以实时监控这些指标,并通过分析这些数据来发现潜在的性能瓶颈。

4.3.2 多线程和并发控制的优化策略

Kafka客户端内部实现了多线程模型,但不当的线程使用可能会导致性能问题。一个有效的策略是根据系统的CPU核心数合理设置线程池的大小,避免线程过度竞争和上下文切换的开销。此外,利用JVM的并发包(java.util.concurrent包)中的高级同步工具,如 ConcurrentHashMap 和 AtomicInteger ,可以提高并发访问的效率。

代码示例展示如何使用 ExecutorService 来管理线程池:

ExecutorService executor = Executors.newFixedThreadPool(Runtime.getRuntime().availableProcessors());

// 执行任务

executor.execute(() -> {

// 任务逻辑

});

// 关闭线程池

executor.shutdown();

在这个例子中,我们创建了一个固定大小的线程池,并执行了一个任务。通过这种方式,可以合理地控制并发执行的任务数量,并在任务执行完毕后优雅地关闭线程池,以避免资源泄露。

4.3.3 性能瓶颈的解决案例

在实际的生产环境中,Kafka客户端可能会遇到各种性能瓶颈,比如单个分区处理速度慢、生产者发送消息效率低下等问题。一个典型的解决方案是针对生产者进行参数优化。例如,可以调整 compression.type 为 snappy 来压缩消息,这样可以减少网络I/O的开销,提升数据传输的效率。

在遇到消费者延迟问题时,优化的策略可能包括调整消费者的 max.poll.records 参数,以限制每次拉取记录的最大数量,从而减少单次处理的负载。同时,可以增加消费者的实例数量,以提升并发处理的能力。

通过细致的监控和参数调整,可以逐步找到并解决性能瓶颈。然而,这个过程需要依赖于对Kafka以及JVM运行原理的深入理解,并且需要结合具体的应用场景和业务需求来进行。

7. Kafka高级特性深度解析

6.1 Kafka的事务支持

Kafka从0.11版本开始引入了事务支持,允许生产者在多个分区上进行原子写操作。这一特性对于需要保证消息处理顺序和一致性的场景至关重要。

- 事务API :Kafka提供了事务API,如

initTransactions、beginTransaction、sendOffsetsToTransaction、commitTransaction等,来管理事务。 - 事务协调器 :每个broker都会运行一个事务协调器(Transaction Coordinator),负责处理事务请求。

- 幂等性 :与事务紧密相关的是生产者的幂等性特性,它保证即使生产者多次发送相同的消息,也只会被消费一次。

producer.initTransactions();

try {

producer.beginTransaction();

producer.send(record1);

producer.send(record2);

***mitTransaction();

} catch (KafkaException e) {

producer.abortTransaction();

}

6.2 Kafka Streams的流处理能力

Kafka Streams是一个轻量级的库,用于构建流处理应用。它能够在Kafka主题间转换和处理数据流,并且具有持续的、弹性的和可扩展的处理能力。

- 流处理概念 :Kafka Streams将Kafka视为动态输入和输出的数据库,通过拓扑图来描述流处理作业。

- 状态管理 :Kafka Streams提供了状态存储(如KTable、KStream),可用来维护状态和执行复杂计算。

- 可伸缩性 :任务通过分区在多个流处理任务实例之间进行负载均衡,保证了良好的可伸缩性。

6.3 Kafka Connect的集成能力

Kafka Connect是一个用于快速连接Kafka和其他数据源或系统的工具。它提供了一种高效、可靠的集成方式,能够进行批量数据导入和导出。

- 连接器 :Kafka Connect定义了连接器(Connectors)的概念,用于描述Kafka与外部系统之间的集成。

- 转换器 :转换器(Converters)负责在不同格式间转换数据,例如从外部系统的格式到Kafka的格式。

- 独立部署 :Kafka Connect可以以独立服务的形式运行,以集群的方式运行多个连接器实例,提高可靠性。

connectors:

- name: "mysql-source"

connector.class: "io.debezium.connector.mysql.MySqlConnector"

tasks.max: 1

database.hostname: "localhost"

database.port: 3306

database.user: "debezium"

database.password: "dbz"

database.server.name: "dbserver1"

6.4 Kafka的安全特性

随着企业对数据安全的日益重视,Kafka也在不断增强其安全特性,如支持加密通信、认证和授权等。

- 安全协议 :支持如SASL、SSL/TLS等安全协议来保护数据传输安全。

- 认证授权 :Kafka支持Kerberos、LDAP等认证方式,并使用ACL来控制访问权限。

- 数据加密 :利用SSL/TLS协议,可以对数据进行加密,保护数据在传输过程中的安全。

通过这些高级特性,Kafka不仅满足了基本的消息传递需求,还在处理复杂的业务场景、集成多系统、保障数据安全等方面提供了强大的支持。接下来,让我们进入第七章的内容,深入探讨Kafka在实际应用中遇到的性能挑战和优化策略。

简介:大数据时代,Kafka的分布式消息处理能力和JVM的优化对于提升系统性能至关重要。本笔记深入探讨了Kafka的基础架构、大数据中的应用以及JVM的内存模型、垃圾回收机制,并通过案例分析介绍如何进行性能调优和问题解决。

788

788

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?