简介:本文档介绍了Apollo配置中心的Docker化部署过程。Apollo是一个用于集中管理微服务应用配置的服务。通过提供的 docker-compose.yml 和 sql 文件,用户可以快速设置Docker容器环境及初始化数据库,从而实现Apollo服务的快速启动。教程详细说明了如何配置 docker-compose.yml 文件来定义Apollo服务,并运行 sql 脚本来初始化数据库。同时,涉及到了Docker Compose命令的使用、网络通信和存储卷配置等关键知识点,确保用户能够高效部署和管理Apollo配置中心。

1. Docker快速启动Apollo配置中心

1.1 初识Apollo配置中心

在软件开发中,配置中心是实现配置集中管理的关键组件,它可以帮助我们在不同的开发、测试、生产环境中共享和管理配置信息,极大地提升开发效率和配置管理的灵活性。Apollo(阿波罗)是由携程开源的配置中心,因其设计优秀、功能强大和易于使用等特点,已经成为业界广泛采用的配置中心解决方案之一。

1.2 Docker快速启动Apollo配置中心

Docker作为一种轻量级的虚拟化技术,非常适合用于快速部署像Apollo这样的应用。使用Docker启动Apollo配置中心,可以简化安装配置过程,快速搭建本地开发环境。首先,需要确保你的机器上已经安装了Docker环境。

# 以Apollo Server为例,拉取镜像

docker pull apollonian/apollo-configservice

# 运行容器实例

docker run --name apollo-configservice -d -p 8080:8080 apollonian/apollo-configservice

执行上述命令后,Apollo配置中心的服务器端将被快速启动,并且默认监听8080端口。这样,我们就可以在浏览器中访问 http://localhost:8080 来检查是否成功启动。

1.3 访问与验证

在启动Apollo配置中心后,需要进行简单的验证确保服务正常运行。可以通过访问Apollo管理后台界面来确认服务状态,通常后台管理界面会在初次部署后提供相应的访问地址和初始账户信息。

# 查看运行中的容器日志以验证启动状态

docker logs -f apollo-configservice

通过日志输出可以判断服务是否正常启动,如果出现异常,则需要根据日志信息进行问题排查。总的来说,使用Docker启动Apollo配置中心为开发者提供了一个快捷且高效的途径,使得配置中心的搭建和维护变得更加简单。

2. Docker Compose配置与服务部署

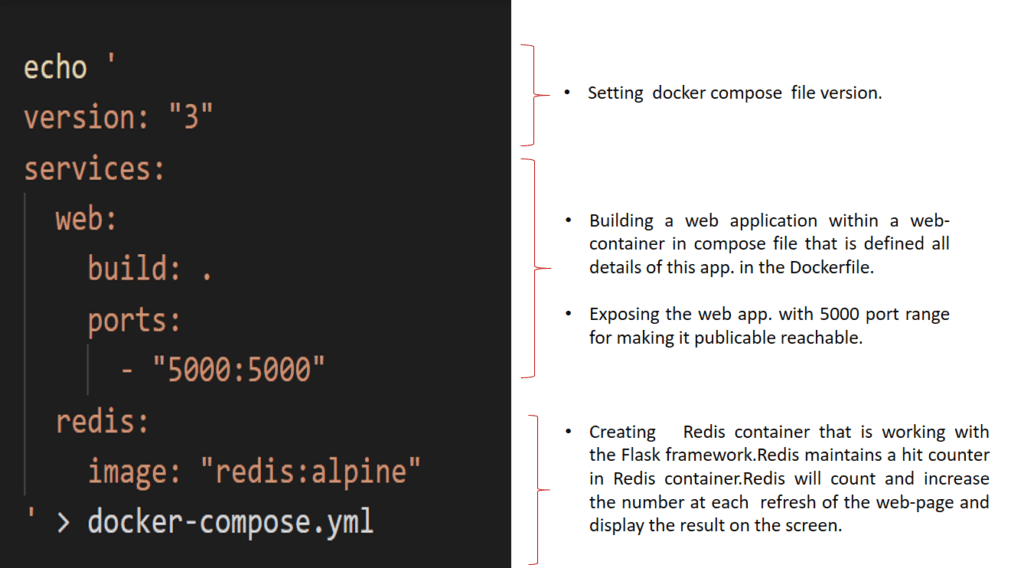

Docker Compose 是一个用于定义和运行多容器 Docker 应用程序的工具。通过 Compose,你可以使用 YAML 文件来配置应用程序的服务。然后,使用一个命令,就可以从配置中创建并启动所有服务。Docker Compose 的使用简化了在单个宿主机上管理多个容器的部署过程。

2.1 Docker Compose基础与安装

2.1.1 Docker Compose概念解析

Docker Compose 通过一个 docker-compose.yml 文件来定义一组相关联的应用服务。在这个文件中,你可以指定服务使用的镜像、依赖关系、端口映射、卷挂载和环境变量等。一旦定义了服务,就可以使用简单的命令来启动和管理整个应用程序,而无需手动一个个地启动容器。

2.1.2 安装Docker Compose

安装 Docker Compose 通常很直接,可以遵循以下步骤:

- 下载 Docker Compose 的最新版本。可以在 Docker Compose 的GitHub发布页面找到适合你操作系统的版本链接。

- 使用curl下载Docker Compose到本地系统,并使其可执行:

bash sudo curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose - 通过以下命令为

docker-compose赋予执行权限:

bash sudo chmod +x /usr/local/bin/docker-compose - 验证安装是否成功,运行:

bash docker-compose --version

2.2 Docker Compose配置文件详解

2.2.1 配置文件结构和语法

docker-compose.yml 文件遵循YAML格式,其结构分为几个主要部分:

-

version: 指定配置文件的版本。 -

services: 定义组成应用程序的服务。 -

volumes: 指定需要挂载的卷。 -

networks: 定义应用程序的网络。

示例的 docker-compose.yml 文件片段:

version: '3'

services:

web:

image: nginx:alpine

ports:

- "8000:80"

volumes:

- ./data:/data

networks:

- webnet

networks:

webnet:

2.2.2 服务定义与依赖关系

每个服务可以定义以下参数:

-

build: 指定构建镜像的路径和参数。 -

image: 指定服务使用的镜像。 -

command: 覆盖容器启动时默认执行的命令。 -

container_name: 指定容器的名称。 -

depends_on: 指定服务的依赖关系。 -

ports: 端口映射。 -

volumes: 数据卷配置。 -

networks: 网络配置。

在定义服务时,可以指定服务之间的依赖关系,使得Docker Compose在启动服务时按照依赖顺序进行。例如:

services:

db:

image: postgres

web:

build: .

depends_on:

- db

2.3 Docker Compose服务部署实践

2.3.1 构建与启动服务

使用 docker-compose up 命令可以启动并运行配置文件中的所有服务。该命令会首先构建缺失的镜像,然后启动服务,并显示服务的输出日志。

- 使用

docker-compose up启动服务。 - 使用

docker-compose up -d在后台运行服务。 - 使用

docker-compose build重新构建服务镜像。 - 使用

docker-compose down停止并移除所有由docker-compose up创建的容器、网络、镜像和卷。

2.3.2 日志查看与故障排查

Docker Compose 通过组合 docker 命令来提供日志查看和故障排查的能力。可以使用以下命令查看服务的日志:

- 查看所有服务的日志:

docker-compose logs - 查看特定服务的日志:

docker-compose logs [service_name] - 跟踪实时日志输出:

docker-compose logs -f [service_name]

使用 docker-compose ps 可以查看服务的状态,而使用 docker-compose top 可以查看运行容器的进程信息。

当遇到服务启动失败或者运行错误时,可以通过检查单个容器的日志来定位问题所在,具体步骤如下:

- 使用

docker-compose logs查看所有服务的日志,寻找错误信息。 - 确定出问题的服务后,可以使用

docker logs [container_id]来查看该服务容器的详细日志。 - 根据日志信息进行故障排查。

通过这些步骤和命令,可以有效地监控和管理使用Docker Compose部署的服务。

3. 数据库初始化与结构理解

在现代应用开发中,数据库是存储数据的核心组件。正确地初始化和理解数据库结构对于保持数据的完整性、一致性和性能至关重要。在本章中,我们将探讨数据库类型选择、环境准备、结构设计与创建以及性能优化和监控等关键方面。

3.1 数据库类型选择与环境准备

数据库系统的选择与应用需求息息相关。从简单的键值存储到复杂的关系型数据库,再到高性能的NoSQL数据库,每种数据库类型都有其特定的使用场景。在做出决策之前,需要对项目需求进行彻底的分析。

3.1.1 选择合适的数据库系统

在选择数据库系统时,需要考虑以下因素:

- 数据一致性需求 :对于要求ACID(原子性、一致性、隔离性、持久性)的业务场景,关系型数据库如MySQL或PostgreSQL是更好的选择。

- 扩展性需求 :对于需要水平扩展的高流量应用场景,NoSQL数据库如MongoDB或Cassandra可能更加适用。

- 数据结构复杂性 :如果数据模型多变,文档型数据库提供了灵活的数据结构存储能力。

3.1.2 数据库环境搭建

一旦选择了合适的数据库系统,接下来就是搭建开发、测试、生产等不同环境。环境搭建步骤大致包括:

- 操作系统选择 :根据数据库的硬件和软件需求选择合适的操作系统。

- 数据库安装 :通过官方安装包或使用Docker容器快速部署。

- 配置调整 :根据业务需求调整数据库配置,优化性能。

例如,使用Docker部署MySQL可以简单到如下命令:

docker run --name mysql -e MYSQL_ROOT_PASSWORD=your_password -d mysql

3.2 数据库结构初始化与数据迁移

数据库结构的初始化是一个涉及数据模型设计、表创建和索引优化的过程。而数据迁移则是从旧数据库向新数据库迁移的过程。

3.2.1 数据库结构设计与创建

设计良好的数据库结构是应用性能优化的关键。设计时应注意以下几点:

- 规范化 :确保数据不重复,以减少冗余和维护成本。

- 索引 :合理使用索引可以极大提高查询效率,但过多或错误的索引会导致写入性能下降。

SQL示例:

CREATE TABLE users (

id INT AUTO_INCREMENT PRIMARY KEY,

username VARCHAR(50) NOT NULL,

email VARCHAR(100) NOT NULL,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP

);

3.2.2 数据迁移策略与执行

数据迁移策略包括数据清洗、格式化和验证等步骤。迁移执行需要考虑数据一致性、完整性和回滚策略。

- 分批迁移 :逐步迁移数据以减少对生产环境的影响。

- 版本控制 :使用版本控制管理迁移脚本,确保可追溯性和可重复性。

数据迁移示例:

# 使用mysqldump导出数据

mysqldump -u root -p db_name > dump.sql

# 在新数据库导入数据

mysql -u root -p new_db_name < dump.sql

3.3 数据库性能优化与监控

随着数据量的增长,数据库性能问题越来越明显。对数据库进行性能优化并实施监控是确保稳定运行的关键。

3.3.1 性能优化方法

性能优化方法包括:

- 查询优化 :优化慢查询,确保查询计划高效。

- 硬件升级 :增加内存、使用更快的存储等硬件升级。

- 调整配置 :根据工作负载调整数据库配置参数。

3.3.2 数据库监控与维护

数据库监控是持续健康运维的必要条件。关键指标包括:

- 响应时间 :监控数据库响应请求的时间。

- 错误率 :监控错误和异常情况。

- 资源使用率 :监控CPU、内存、磁盘和网络使用情况。

案例分析

假设我们正在构建一个社交网络应用,我们选择MySQL作为关系型数据库。以下是数据库初始化和优化的过程:

- 环境搭建 :在Ubuntu 20.04服务器上使用Docker容器化部署MySQL。

- 结构初始化 :设计用户表、帖子表和评论表,并创建适当的索引。

- 数据迁移 :将旧系统中的数据迁移到新数据库中,使用分批迁移方法。

- 性能优化 :针对高查询负载进行SQL语句调优和索引优化。

- 监控部署 :部署如Prometheus和Grafana组合的监控解决方案,实时监控数据库性能和状态。

数据库结构和索引示例:

CREATE TABLE posts (

id INT AUTO_INCREMENT PRIMARY KEY,

user_id INT NOT NULL,

content TEXT,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

FOREIGN KEY (user_id) REFERENCES users(id)

);

CREATE INDEX idx_user_id ON posts(user_id);

小结

本章深入探讨了数据库的初始化、结构设计、性能优化和监控。通过精心选择数据库类型,合理设计结构,执行数据迁移,以及持续的性能优化和监控,可以为任何应用提供一个坚实可靠的数据存储基础。这些步骤共同确保了数据的完整性、一致性和高效访问,为最终用户提供了良好的体验。

4. 网络通信配置与容器间通信

网络是容器化技术的核心之一,确保容器之间的高效通信对于构建复杂的应用服务至关重要。Docker作为一个流行的容器化平台,它为容器之间的通信提供了丰富的支持。在本章节中,我们将深入探讨Docker网络模型的基础知识、配置方法以及容器间通信的机制。此外,我们还将讨论如何通过网络配置实现容器的安全隔离,以确保微服务架构中的应用安全运行。

4.1 Docker网络模型与配置

4.1.1 Docker网络概念解析

Docker网络提供了一种让多个容器之间能够相互通信的机制,同时可以连接到外部网络。Docker在安装后会默认创建几种网络模式,其中包括:

- bridge(桥接)模式 :这是Docker的默认网络模式,创建一个可以提供容器间通信的虚拟网络。

- host(主机)模式 :容器共享主机的网络命名空间,没有网络隔离。

- none(无)模式 :容器不分配任何网络资源,需要用户手动配置。

- container(容器)模式 :容器使用其他容器的网络命名空间。

除了这些默认模式,用户还可以创建自定义网络,以便更好地控制网络配置,实现更复杂的应用需求。

4.1.2 网络配置方法与实践

要配置Docker网络,可以通过 docker network create 命令来创建一个自定义网络。配置过程中可以指定网络驱动、子网、网关等参数。

docker network create --driver bridge --subnet 172.18.0.0/16 --gateway 172.18.0.1 mybridge

此命令创建了一个名为 mybridge 的桥接网络,子网为 172.18.0.0/16 ,网关为 172.18.0.1 。容器创建时可以指定使用此网络,从而实现网络隔离。

除了创建网络,Docker还允许用户对现有网络进行查看和修改。使用 docker network inspect 命令可以查看网络详情,这有助于理解和管理网络配置。

docker network inspect mybridge

此命令将输出 mybridge 网络的详细信息,包括连接的容器、网络驱动的配置、IPAM配置等。

4.2 容器间通信机制

4.2.1 Docker内置网络通信方式

Docker内置了几种通信方式,最常用的是:

- 直接通信 :在同一个网络中的容器可以通过对方的容器名作为主机名进行通信。

- 端口映射 :将容器内的端口映射到主机的端口上,外部可以通过主机端口访问容器服务。

容器间通信的实现依赖于Docker网络驱动,其中bridge网络是实现容器间直接通信的最常用方式。通过bridge网络,容器可以相互通信,同时与主机及其他网络设备通信。

4.2.2 外部网络访问容器服务

外部网络访问容器服务通常使用端口映射的方式。在创建容器时,通过 -p 参数映射端口:

docker run -d --name webserver -p 80:80 nginx

此命令创建了一个名为 webserver 的容器,并将容器内的80端口映射到了主机的80端口上。这样外部请求通过主机的80端口就能访问到运行在容器内的Nginx服务。

4.3 网络安全与隔离策略

4.3.1 网络安全策略配置

为了确保容器间的通信安全,Docker提供了网络安全策略的配置选项。例如,可以设置防火墙规则限制容器访问外部网络的权限。通过Docker的内置防火墙功能,可以创建自定义规则来控制容器间的网络访问。

docker network create --driver bridge --subnet 10.0.0.0/24 --gateway 10.0.0.1 mysecurenet

docker run --net mysecurenet --name secureweb nginx

上述命令创建了一个名为 mysecurenet 的网络,指定了自定义的子网和网关。然后在此网络上创建了一个名为 secureweb 的Nginx容器,从而实现了对网络的隔离和控制。

4.3.2 容器隔离与限制

为了更进一步地隔离容器,Docker支持通过网络命名空间来实现容器间网络资源的隔离。此外,还可以使用 docker network connect 和 disconnect 命令来控制容器加入或离开某个网络,以此实现网络级别的访问控制。

docker network connect mysecurenet anothercontainer

docker network disconnect mysecurenet anothercontainer

这两个命令分别实现将 anothercontainer 容器连接到 mysecurenet 网络,或断开连接。通过这种动态的连接与断开操作,可以在运行时控制容器的网络访问权限。

在讨论了Docker网络模型和配置方法后,我们可以看到网络通信配置对于容器化环境中的服务部署至关重要。正确配置网络,既能够满足应用之间通信的需求,又能够提供必要的安全保障。容器间通信机制的掌握以及网络安全策略的应用,是每个容器化应用架构师必须具备的能力。

在下一章节中,我们将深入探讨Docker存储卷的概念、类型、创建、管理及在实际项目中的应用,为您的应用数据持久化提供解决方案。

5. Docker存储卷数据持久化

在现代的容器化部署场景中,数据的持久化管理是保证业务连续性和数据安全的重要一环。Docker 容器虽然轻量级且易于管理,但是其运行时的数据默认是存储在可写层( writable layer)上,这种设计使得容器的生命周期往往短暂且脆弱。当容器被删除或重建时,存储在可写层上的数据就会丢失,这不符合多数应用对于数据持久化的要求。因此,Docker 提供了存储卷(volumes)作为解决方案,以支持容器在运行时的数据持久化和共享数据。

5.1 Docker存储卷概念与类型

5.1.1 存储卷基础介绍

Docker存储卷是一个由Docker管理的特别目录,可以挂载到多个容器中。它们在容器之外,生命周期独立于容器。即使容器被删除,存储卷中的数据也不会丢失。Docker对卷进行优化以具备高性能,并且可以与诸如本地文件系统、网络存储设备等后端存储技术集成。

存储卷的主要优势包括:

- 数据持久化:即使容器被删除,卷内的数据依然能够保留。

- 数据共享:可以同时挂载到多个容器,实现数据共享。

- 安全性:卷可以被独立于容器进行备份和迁移。

- 灵活性:卷的创建和管理可由Docker命令或Dockerfile操作。

5.1.2 不同类型存储卷比较

Docker支持多种类型的存储卷,最常见的是本地存储卷、命名卷和绑定挂载。让我们对比这些卷的特性:

- 本地存储卷:通过指定具体的主机路径来创建,对宿主机的文件系统有一定的依赖性,灵活性较低,但性能通常较好。

- 命名卷:Docker创建的匿名卷,用户不需要关心卷在宿主机上的具体位置,管理起来较为简单。

- 绑定挂载:可以将宿主机的任意目录或文件挂载到容器内,灵活性很高,但可能带来安全风险。

5.2 存储卷的创建与管理

5.2.1 创建和使用存储卷

使用Docker命令创建存储卷的方式是:

docker volume create my-vol

挂载存储卷至容器的命令格式如下:

docker run -d -v my-vol:/app my-image

以上命令中, -v 参数后第一个是我的卷名 my-vol ,而 :/app 表示挂载点为容器内的 /app 目录。

下面是一个实际的示例,创建一个名为 my-vol 的卷并将其挂载到一个运行中的 Nginx 容器内的 /usr/share/nginx/html 目录:

docker volume create my-vol

docker run -d -v my-vol:/usr/share/nginx/html --name my-nginx nginx

执行上述操作后,我们在宿主机上创建的 my-vol 卷会被挂载到Nginx容器的 /usr/share/nginx/html 目录,这样即使容器停止或者被删除,挂载的卷数据也会被保留。

5.2.2 存储卷的备份与恢复

存储卷的备份与恢复对于数据安全至关重要。可以使用 Docker 命令来执行这些操作。为了备份一个卷,可以使用 docker run 命令结合卷的挂载和 tar 命令来实现:

docker run --rm --volumes-from my-nginx -v $(pwd):/backup alpine sh -c "cd /usr/share/nginx/html && tar -cf /backup/my-nginx-backup.tar ."

在这个命令中, --volumes-from my-nginx 参数指定了容器从哪个容器继承卷,而 -v $(pwd):/backup 将当前工作目录( $(pwd) )映射为容器内的 /backup 目录。

恢复数据时,使用相反的命令,将备份文件恢复到卷中:

docker run --rm --volumes-from my-nginx -v $(pwd):/backup alpine sh -c "cd /usr/share/nginx/html && tar -xf /backup/my-nginx-backup.tar"

5.3 存储卷在实际项目中的应用

5.3.1 持久化数据的场景分析

在实际项目中,有很多场景需要使用Docker存储卷来实现数据持久化。例如:

- 数据库容器:MySQL、PostgreSQL等数据库容器会使用存储卷来持久化数据文件。

- 网站服务:如Nginx和Apache需要持久化存储配置文件和网页文件。

- 缓存服务:如Redis或Memcached,存储缓存数据。

在这些场景中,使用存储卷可以有效解决数据丢失问题,并提供数据备份、恢复和迁移的灵活性。

5.3.2 实际案例演示与技巧

以一个典型的WordPress博客服务为例,我们可以利用存储卷来持久化WordPress的配置文件、上传内容以及数据库文件。以下是一个用Docker Compose实现的案例:

首先,在 docker-compose.yml 文件中定义服务:

version: '3.8'

services:

db:

image: mysql:5.7

volumes:

- db-data:/var/lib/mysql

restart: always

environment:

MYSQL_ROOT_PASSWORD: somewordpress

MYSQL_DATABASE: wordpress

MYSQL_USER: wordpress

MYSQL_PASSWORD: wordpress

wordpress:

depends_on:

- db

image: wordpress:latest

volumes:

- wordpress-data:/var/www/html

ports:

- "8000:80"

restart: always

environment:

WORDPRESS_DB_HOST: db:3306

WORDPRESS_DB_USER: wordpress

WORDPRESS_DB_PASSWORD: wordpress

WORDPRESS_DB_NAME: wordpress

volumes:

db-data:

wordpress-data:

在该配置中, db-data 和 wordpress-data 分别为数据库服务和WordPress服务定义了两个卷。这些卷会在 docker-compose up 命令启动服务时自动创建,并在 docker-compose down 命令停止服务时保留数据。

使用这种配置,即使服务被停止或发生故障,WordPress和数据库的数据都不会丢失,并且可以轻松地将这些数据迁移到其他环境中,提高了项目的可维护性和扩展性。

6. 容器编排与管理进阶技巧

6.1 Kubernetes基础与集群搭建

6.1.1 Kubernetes核心组件解析

Kubernetes(简称K8s)是一个开源的容器编排平台,用于自动化部署、扩展和管理容器化应用。Kubernetes的核心组件包括:

- Master节点 :运行Kubernetes控制平面的组件,包括API Server、Scheduler、Controller Manager和etcd。Master节点负责整个集群的管理与调度决策。

- Worker节点 :运行用户应用程序的工作节点,包括kubelet、kube-proxy和Container Runtime。节点通过kubelet与Master通信,确保容器按照期望的状态运行。

6.1.2 Kubernetes集群搭建步骤

搭建一个Kubernetes集群包含以下步骤:

- 准备硬件和环境 :确保所有节点的网络互通,安装必要的依赖,例如Docker和kubelet。

- 配置Master节点 :在Master节点上安装并配置API Server、Scheduler、Controller Manager和etcd。

- 配置Worker节点 :在每个Worker节点上安装kubelet和kube-proxy,并将其注册到Master节点。

- 验证集群状态 :使用

kubectl get nodes命令检查所有节点的状态,确保Master和Worker节点均正常运行。

# 示例:使用kubectl获取节点信息

kubectl get nodes

6.1.3 Kubernetes集群初始化

在开始使用Kubernetes之前,需要对集群进行初始化操作,包括配置网络插件和RBAC(基于角色的访问控制)。以下是初始化集群的步骤:

- 安装网络插件 :例如Calico或Flannel,为集群内的Pods提供网络连接。

- 配置RBAC :创建角色和角色绑定来定义用户和权限,确保集群的安全性。

# 示例:RBAC配置文件(rbac.yaml)

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: pod-reader

rules:

- apiGroups: [""] # 空字符串""表示核心API组

resources: ["pods"]

verbs: ["get", "watch", "list"]

6.1.4 集群监控与日志管理

为了有效监控Kubernetes集群的健康状态和性能,通常会集成一些监控和日志管理工具,例如Prometheus、Grafana、ELK Stack等。

# 示例:使用kubectl部署Prometheus

kubectl create -f https://raw.githubusercontent.com/coreos/prometheus-operator/release-0.34/bundle.yaml

6.2 高可用集群架构设计

6.2.1 高可用集群的需求分析

高可用(High Availability, HA)集群设计要解决的主要问题是提高系统的稳定性和可靠性。在Kubernetes中实现高可用通常需要满足以下需求:

- 控制平面的高可用 :确保Master节点的冗余,防止单点故障。

- 工作节点的负载均衡 :实现对Pods的自动调度,确保应用的高可用。

- 数据持久化 :保证数据不会因为节点故障而丢失。

6.2.2 构建高可用集群

构建高可用Kubernetes集群通常涉及以下几个步骤:

- 配置多Master节点 :至少需要3个Master节点来实现高可用。

- 使用负载均衡器 :在Master节点前设置负载均衡器,如Nginx或云服务商提供的负载均衡服务。

- 持久化etcd数据库 :确保etcd数据库的高可用和数据持久化。

# 示例:高可用etcd集群配置(etcd-cluster.yaml)

apiVersion: v1

kind: Service

metadata:

name: etcd

spec:

clusterIP: None

ports:

- port: 2380

targetPort: 2380

selector:

etcd-cluster: etcd

apiVersion: v1

kind: Service

metadata:

name: etcd-client

spec:

ports:

- port: 2379

targetPort: 2379

selector:

etcd-cluster: etcd

6.2.3 高可用集群的测试与优化

为了确保高可用集群能够稳定运行,需要对其进行严格的压力测试和性能优化。这通常包括:

- 压力测试 :模拟多用户访问,测试系统的负载承受能力。

- 性能优化 :根据测试结果调整集群配置,优化资源调度策略。

- 故障恢复演练 :模拟节点故障,验证系统恢复的效率和正确性。

6.3 部署策略与持续集成/持续部署(CI/CD)

6.3.1 持续集成/持续部署概念

CI/CD是一种软件开发实践,通过自动化软件交付流程中的构建、测试和部署环节,加快软件迭代速度,提高软件质量。在Kubernetes中实现CI/CD通常涉及以下步骤:

- 版本控制 :使用Git等版本控制系统管理代码变更。

- 自动化构建 :通过Jenkins、GitLab CI等工具自动构建应用镜像。

- 自动化测试 :部署到测试环境,运行自动化测试确保质量。

- 自动化部署 :通过自动化脚本或工具将应用部署到生产环境。

6.3.2 使用Helm进行应用部署

Helm是Kubernetes的包管理工具,可以帮助开发者打包、配置和部署应用到Kubernetes集群。使用Helm进行应用部署可以简化复杂应用的管理和部署流程。

# 示例:使用Helm安装Nginx服务

helm install stable/nginx-ingress

6.3.3 CI/CD流水线实践

构建CI/CD流水线是实现自动化部署的关键。以下是一个基本的CI/CD流水线实践:

- 代码提交 :开发者提交代码到版本控制仓库。

- 自动化构建 :触发构建流程,生成应用镜像。

- 自动化测试 :测试镜像在测试环境中部署的效果。

- 代码审查 :对新代码进行审查,确保代码质量。

- 自动化部署 :代码审查通过后,自动化工具将应用部署到生产环境。

graph LR

A[代码提交] --> B[自动化构建]

B --> C[自动化测试]

C --> D[代码审查]

D -->|通过| E[自动化部署]

D -->|不通过| A

6.3.4 容器化应用的版本管理

容器化应用的版本管理与传统的应用管理有所不同,关键在于如何管理容器镜像的版本。以下是一些常见的容器镜像版本管理策略:

- 基于Git标签 :为每个镜像构建创建一个标签,并使用Git仓库进行管理。

- 语义化版本控制 :使用语义化版本号(如MAJOR.MINOR.PATCH)来标记镜像版本。

- 持续更新策略 :对于持续更新的应用,可以通过环境变量区分不同版本。

# 示例:使用Docker标签管理镜像版本

docker tag myapp:latest myapp:v1.0.0

6.4 灾难恢复与数据备份策略

6.4.1 灾难恢复计划的重要性

灾难恢复计划(Disaster Recovery Plan, DRP)是为了在发生灾难时,能够迅速恢复业务运行的方案。在Kubernetes集群中,灾难恢复计划需要考虑以下因素:

- 数据备份 :定期备份应用数据和集群配置。

- 多区域部署 :在不同地理位置部署集群,以防一个区域的故障影响全局。

- 故障转移机制 :实现自动或手动的故障转移,保证服务的连续性。

6.4.2 Kubernetes集群的数据备份与恢复

在Kubernetes中,数据备份和恢复通常针对etcd数据库。etcd是集群的关键数据存储,因此需要特别保护。

- 数据备份 :定期使用etcd的备份命令进行数据备份。

- 数据恢复 :在故障发生时,可以使用备份文件将etcd恢复到一致的状态。

# 示例:使用etcdctl进行备份

ETCDCTL_API=3 etcdctl --endpoints=https://[127.0.0.1]:2379 \

--cacert=/etc/etcd/kubernetes.pem \

--cert=/etc/etcd/healthcheck-client.pem \

--key=/etc/etcd/healthcheck-client-key.pem \

snapshot save snapshot.db

6.4.3 应用层面的备份与恢复

除了集群层面的数据备份外,应用层面的数据备份和恢复也是必不可少的。这通常涉及以下内容:

- 数据库备份 :定期对集群内运行的数据库进行备份。

- 持久化存储卷备份 :对持久化存储的数据进行备份,以便在数据丢失时能够恢复。

- 应用配置备份 :备份应用的配置信息,以快速恢复到预期状态。

6.5 安全策略与合规性要求

6.5.1 Kubernetes安全防护措施

Kubernetes安全防护措施包括:

- 网络安全 :使用网络策略控制Pod之间的通信。

- 身份认证和授权 :配置Kubernetes RBAC,确保只有授权用户才能访问资源。

- 镜像扫描 :定期扫描容器镜像,确保没有安全漏洞。

# 示例:配置Pod网络安全策略

kubectl apply -f network-policy.yaml

6.5.2 安全审计与合规性检查

Kubernetes集群的安全审计和合规性检查是确保集群安全合规运行的重要环节:

- 安全审计 :定期进行安全审计,检查潜在的安全风险。

- 合规性检查 :根据行业标准(如HIPAA、GDPR)进行合规性检查。

6.5.3 遵守数据保护法规

在使用Kubernetes部署应用时,必须遵守相关的数据保护法规,如欧盟的通用数据保护条例(GDPR):

- 数据访问控制 :实现严格的数据访问控制策略。

- 数据加密 :对敏感数据进行加密,保证数据在存储和传输过程中的安全。

6.6 总结

在本章中,我们深入探讨了容器编排与管理的进阶技巧,特别针对Kubernetes集群的搭建、高可用架构设计、CI/CD流水线实践、灾难恢复策略以及安全合规性要求进行了详尽的讨论。通过这些高级特性,可以进一步提升容器化应用的可靠性、安全性,并确保业务的连续性与合规性。本章旨在为希望在容器技术领域进一步深入的IT专业人员提供实践指南与策略参考。

7. 安全与备份策略

6.1 容器安全加固

6.1.1 安全扫描与漏洞管理

在使用容器技术时,安全始终是最重要的考量之一。为了防止潜在的安全风险,我们需要对运行中的容器进行定期的安全扫描,以便发现和修复已知的漏洞。Docker 提供了官方的安全扫描工具 Docker Security Scanning,以及第三方工具如 Aqua Security, Clair 等。

6.1.2 配置 Docker 安全选项

Docker 容器的安全加固还涉及到合理的配置 Docker 守护进程的安全选项。以下是一些推荐的安全配置选项:

-

--live-restore:在 Docker 守护进程停止或重启时,保持容器运行。 -

--icc=false:禁用容器之间的通信。 -

--userns-remap:使用用户命名空间重新映射,隔离容器内的用户。

6.1.3 使用 SELinux 和 AppArmor

SELinux (Security-Enhanced Linux) 和 AppArmor 是Linux系统上的两个主要安全模块,能够增强系统的安全性。对于Docker容器来说,使用这些安全模块可以限制容器访问系统资源的能力,增强系统的整体安全性。

6.2 数据备份策略

6.2.1 定期备份的重要性

数据备份是预防数据丢失的最有效方法之一。在使用容器化技术时,数据备份的策略也变得异常重要。这不仅包括了应用数据,也包括了容器镜像、配置文件等。

6.2.2 使用 Docker Volume 进行数据备份

Docker Volume 是Docker的一个重要特性,用于持久化容器数据。我们可以利用 Docker Volume 进行数据备份:

docker run --rm -v mydata:/backup ubuntu tar cvf /backup/backup.tar /path/to/directory

上述命令将会使用 ubuntu 镜像,挂载 mydata 容器卷,并将指定目录打包到 /backup/backup.tar 文件中。

6.2.3 备份恢复操作

一旦完成备份,了解如何恢复数据也至关重要。例如,要恢复备份文件,可以使用以下命令:

docker run --rm -v mydata:/restore -v /path/to/backup/backup.tar:/backup.tar ubuntu tar xvf /backup/backup.tar -C /restore/

此命令将备份文件提取到挂载的卷中,之后容器停止时,卷中的数据将被保留。

第七章:微服务架构实践与案例分析

7.1 微服务架构的优势与挑战

7.1.1 微服务架构定义

微服务架构是一种设计方法,它将应用程序构建为一组松散耦合的服务,每个服务执行特定的业务功能,并且可以独立部署、扩展和更新。这种架构特别适合容器化和微服务的部署,因为它可以减少复杂性,提高系统弹性。

7.1.2 微服务的优势

- 独立部署:各个服务可以独立更新和部署,不影响整个系统。

- 技术多样性:每项服务可以采用最合适的技术栈。

- 易于扩展:可以通过复制服务实例来横向扩展特定服务。

- 灵活性和弹性:微服务架构使得应用更易于理解和管理。

7.1.3 微服务面临的挑战

- 服务治理:微服务数量众多,需要有效的服务发现、监控和治理。

- 数据一致性:在分布式系统中保证数据的一致性是一大挑战。

- 网络通信:服务之间的调用涉及复杂的网络通信,需要正确处理。

- 性能和资源消耗:服务之间通信可能会引入额外的延迟和资源开销。

7.2 微服务架构在实际项目中的应用

7.2.1 实际案例分析

在实际项目中,微服务架构可以帮助企业快速迭代和扩展服务。下面通过一个案例来分析微服务架构的应用:

假设有一个电子商务平台,它由许多独立的服务组成,如用户认证、产品目录、购物车、订单处理、支付处理等。

- 用户认证服务 :负责处理用户注册、登录、权限验证等功能。

- 产品目录服务 :提供产品信息的查询、分类、搜索等功能。

- 购物车服务 :允许用户添加、删除和修改购物车中的商品。

- 订单处理服务 :处理订单创建、状态更新、取消等操作。

- 支付处理服务 :负责处理支付事务,包括支付确认和退款等。

通过将这些功能分解为独立的服务,每个团队可以独立地开发、测试和部署他们的服务。当某个服务需要更新或扩展会更加容易,不需要影响到整个平台。

7.2.2 微服务架构的实践和优化

在实践微服务架构时,我们需要关注几个关键点:

- 服务拆分 :合理地拆分服务,避免服务过于庞大,同时保持服务间的独立性。

- 服务间通信 :选择合适的通信机制,如 RESTful API、gRPC 等。

- 数据一致性 :使用分布式事务解决方案,如Saga模式,或引入最终一致性设计。

- 服务监控和告警 :实施全面的监控和日志记录机制,以便快速发现和响应问题。

- 持续集成/持续部署 (CI/CD) :使用自动化工具来简化服务的持续集成和部署流程。

7.3 未来展望

微服务架构已经成为现代应用程序开发的主流趋势之一。随着容器化和编排技术的持续发展,微服务在未来会更加普及。未来的技术展望可能包括:

- 云原生技术的进一步融合 :微服务与云计算平台(如 Kubernetes)的进一步整合。

- 服务网格(Service Mesh) :服务网格可以帮助管理微服务间的通信,提高可靠性和安全性。

- 声明式APIs :使用声明性语言描述系统行为,使开发更加直观和高效。

微服务架构的未来将会继续朝着更加自动化、智能化的方向发展,助力企业快速响应市场变化,加速产品上市时间。

简介:本文档介绍了Apollo配置中心的Docker化部署过程。Apollo是一个用于集中管理微服务应用配置的服务。通过提供的 docker-compose.yml 和 sql 文件,用户可以快速设置Docker容器环境及初始化数据库,从而实现Apollo服务的快速启动。教程详细说明了如何配置 docker-compose.yml 文件来定义Apollo服务,并运行 sql 脚本来初始化数据库。同时,涉及到了Docker Compose命令的使用、网络通信和存储卷配置等关键知识点,确保用户能够高效部署和管理Apollo配置中心。

809

809

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?