0 环境

Linux主机,cengtos7系统

安装有openresty软件,用来访问生成日志信息 1.15.8版本

安装有filebeat软件,用来收集openresty的日志 7.3版本

安装有redis软件,用来接收filebeat发送过来的日志,5.0.5版本

fields_under_root的值默认是false

1. filebeat.yml配置

filebeat.inputs:

- type: log

enabled: true

paths:

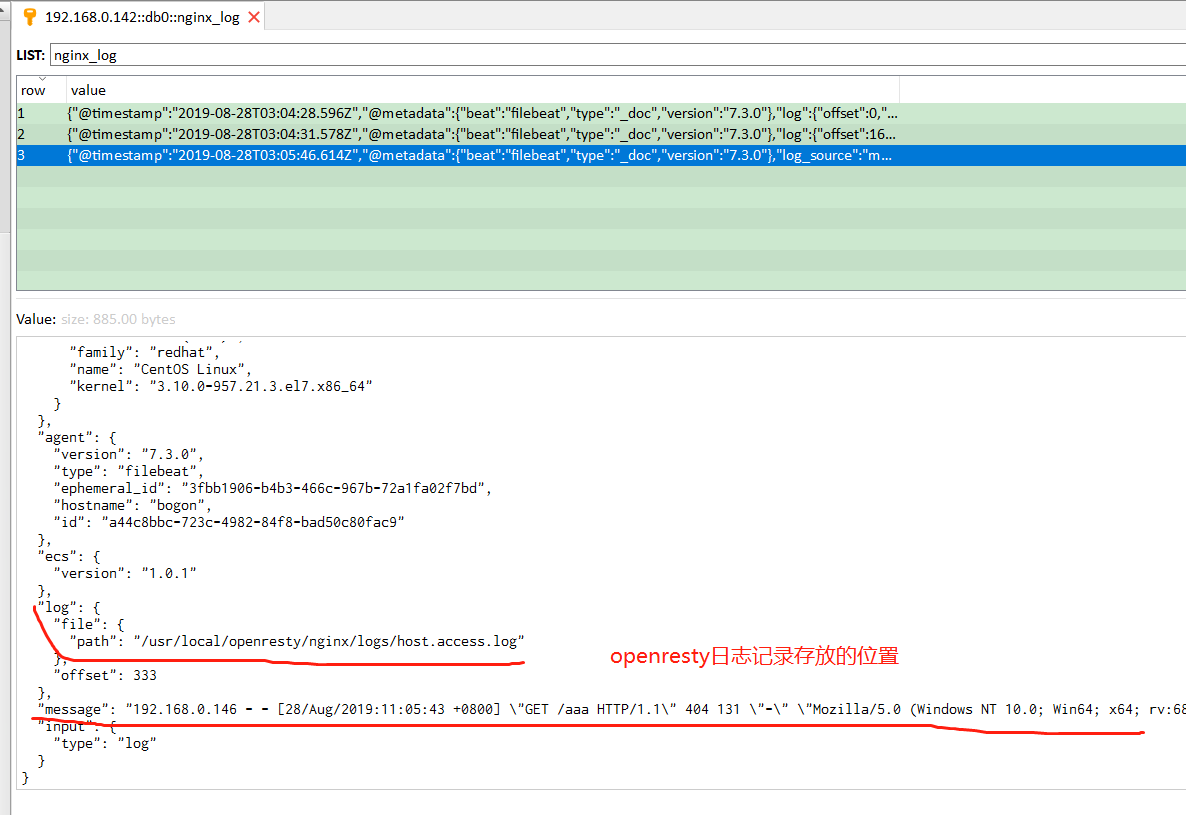

- /usr/local/openresty/nginx/logs/host.access.log

fields:

log_source: messages

fields_under_root: true

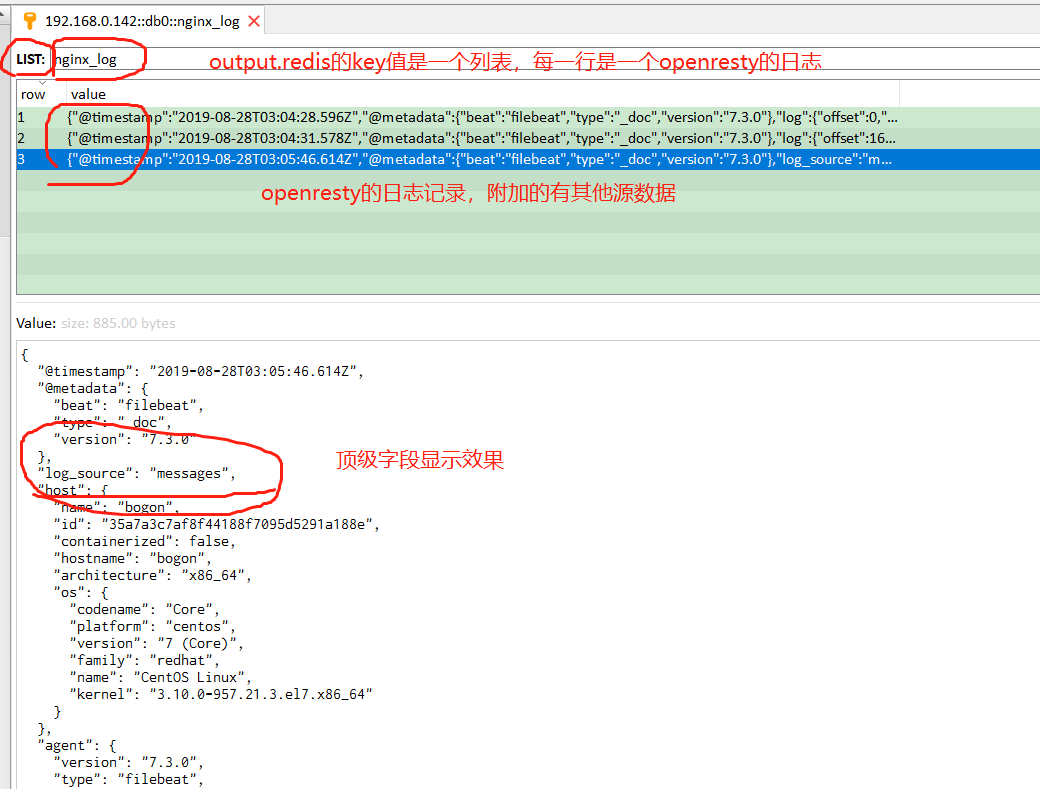

output.redis:

hosts: ["192.168.0.142:6379"]

key: nginx_log

password: foobar2000

db: 0如下参数的效果

fields:

log_source: messages

fields_under_root: true使用fields表示在filebeat收集的日志中多增加一个字段log_source,其值是messages,用来在logstash的output输出到elasticsearch中判断日志的来源,从而建立相应的索引

若fields_under_root设置为true,表示上面新增的字段是顶级参数,在redis中查看的话效果如下:

顶级字段在output输出到elasticsearch中的使用如下:

output {

# 根据redis键 messages_secure 对应的列表值中,每一行数据的其中一个参数来判断日志来源

if [log_source] == 'messages' { # 注意判断条件的写法

elasticsearch {

hosts => ["http://192.168.80.104:9200"]

index => "filebeat-message-%{+YYYY.MM.dd}"

#user => "elastic"

#password => "elastic123"

}

}

} 若fields_under_root设置为false,表示上面新增的字段是则是fields的二级字段,在redis中查看的话效果如下:

fields二级字段在output输出到elasticsearch中的使用如下:

output {

# 根据redis键 messages_secure 对应的列表值中,每一行数据的其中一个参数来判断日志来源

if [fields][log_source] == 'messages' { # 注意判断条件的写法

elasticsearch {

hosts => ["http://192.168.80.104:9200"]

index => "filebeat-message-%{+YYYY.MM.dd}"

#user => "elastic"

#password => "elastic123"

}

}

} 2. 若是多个应用的日志都输出到redis中,只需要在filebeat.inputs:下面再新增- type: log段就行,如下所示:

filebeat.inputs:

- type: log

enabled: true

paths:

- /usr/local/openresty/nginx/logs/host.access.log # 假设应用1的日志路径

fields:

log_source: messages # logstash判断日志来源

### 新增的###

- type: log

enabled: true

paths:

- /usr/local/openresty/nginx/logs/error.log # 假设应用2的日志路径

fields:

log_source: secure

### 新增的###

output.redis:

hosts: ["192.168.80.107:6379"]

key: messages_secure

password: foobar2000

db: 0在redis中显示的效果是都会输出到key值对应的列表中,根据key值是没法进行区分的,只能根据key值列表中每一行数据中的log_source来判断该行是哪一个应用的日志

3. 不同的应用日志使用不同的rediskey值

使用output.redis中的keys值,官方例子

output.redis:

hosts: ["localhost"]

key: "default_list"

keys:

- key: "error_list" # send to info_list if `message` field contains INFO

when.contains:

message: "error"

- key: "debug_list" # send to debug_list if `message` field contains DEBUG

when.contains:

message: "DEBUG"

- key: "%{[fields.list]}"

mappings:

http: "frontend_list"

nginx: "frontend_list"

mysql: "backend_list"大致意思是说,默认的key值是default_list,keys的值是动态分配创建的,当redis接收到的日志中message字段的值包含有INFO字段,则创建key为info_list,当包含有DEBUG字段,则创建key为debug_list。

问题的解决方法是在每个应用的输出日志中新增一个能够区分这个日志的值,然后再在keys中设置,这样一来就能够把不同应用的日志输出到不同的redis的key中

mappings这个还没看懂啥意思,删除mappings这几行也可以

redis中的效果显示:根据官方例子实际修改了一下参数

顺带拓展一下这个内容,logstash7.3从redis中拉取日志时也需要设置这个key值

filebeat这边是动态生成的key值,那logstash中要如何设置这个?

解决办法:

logstash设置的话时需要在目录/etc/logstash/conf.d下面创建以.conf结尾的文件

可以创建多个这样的conf文件,每个文件中从redis取值的设置key值都不同,具体来说就是根据filebeat动态生成的key值设置,然后再输出到相应的elasticsearch中创建不同的索引

拓展一下:假设使用的是nginx,部署多个项目,监控每个项目的access访问文件

ngixn中access日志格式log_format只能配置在http段,若是修改这个的话那所有的项目访问日志还是在同一个redis的key中,

那要如何才能在监控nginx下多个项目的access访问日志下使用redis的不同key值?

暂时还没想好咋解决这个问题

1236

1236

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?