1、近邻成分分析(NCA)算法

以上内容转载自:http://blog.csdn.net/chlele0105/article/details/13006443

2、度量学习

在机器学习中,对高维数据进行降维的主要目的是找到一个合适的低维空间,在该空间中进行学习能比原始空间性能更好。每个空间对应了在样本属性上定义的一个距离度量,而寻找合适的空间,本质上就是寻找一个合适的距离度量。度量学习(metric learning)的基本动机就是去学习一个合适的距离度量。

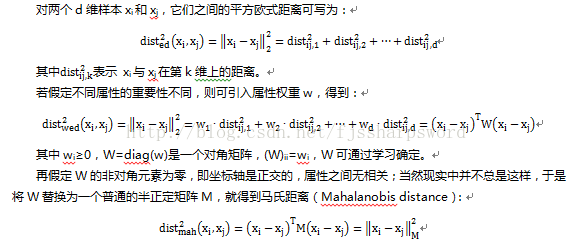

降维的核心在在于寻找合适空间,而合适空间的定义就是距离度量,所以学习合适的距离度量就是度量学习的目的。要对距离度量进行学习,要有一个便于学习的距离度量表达形式。

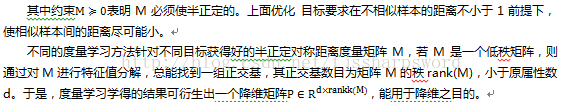

其中M称为度量矩阵,度量学习就是对M进行学习。为保持距离非负且对称,M须是半正定对称矩阵,即必有正交基P使得M能写为M=PPT。

至此,已构建了学习的对象是M这个度量矩阵,接下来就是给学习设定一个目标从而求得M。假定是希望提高近邻分类器的性能,则可将M直接嵌入到近邻分类器的评价指标中去,通过优化该性能指标相应地求得M,以近邻成分分析(Neighbourhood Component Analysis,NCA)进行讨论。

近邻分类器判别时通常采用多数投票法,领域中的每个样本投1票,领域外的样本投0票。将其替换为概率投票法,对任意样本xj,它对xi分类结果影响的概率为:

2011

2011

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?