简介:本项目基于JavaScript语言,旨在开发一个将文本信息转换为语音输出的应用程序,方便视障人士和需要多任务操作的用户。它利用Web Speech API的 SpeechSynthesis 接口实现语音合成,并通过HTML、CSS和JavaScript文件提供完整的功能。开发者需处理用户交互、多语言支持以及性能优化等多个方面,确保应用程序的易用性和高效率。

1. 语音文本阅读器概念介绍

在数字化时代,我们每天都会处理大量的文本信息,其中不乏长篇的报告、学术文章或是电子书籍。这些内容如果通过传统的阅读方式消化,会消耗我们宝贵的时间和精力。为了应对这一挑战,语音文本阅读器应运而生。它不仅能够将文字内容转化为语音,还能够为用户提供一个方便、快捷、无障碍的信息获取方式。语音文本阅读器通过先进的语音合成技术,让文本内容“活”了起来,特别适用于视力受限的用户、需要多任务操作的司机、或是希望在锻炼、通勤时“听”书的忙碌都市人。在本章中,我们将概述语音文本阅读器的基本概念,探索它在现代生活中的应用价值,并剖析其背后的核心技术。接下来的章节中,我们会逐步深入探讨如何利用JavaScript实现这一技术,并将其应用到实际项目中。

2. JavaScript语音合成技术

2.1 语音合成技术概述

2.1.1 语音合成的发展历程

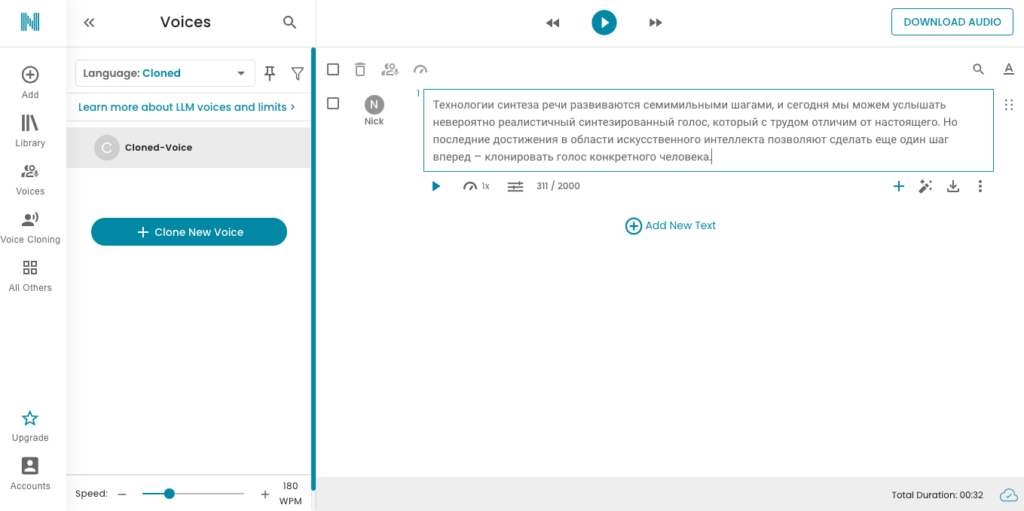

语音合成,即Text-to-Speech (TTS),是将文本信息转换为可听的语音输出的过程。早在1939年,AT&T贝尔实验室就展示了世界上第一个语音合成系统——Voder,它可以模拟人类说话的方式。随着时间推移,语音合成技术经历了从早期的规则合成、拼接合成到现在的统计参数模型、深度学习合成的演变。

在这一发展过程中,语音合成技术主要经历了以下关键阶段: - 早期合成技术: 依靠预录制的语音片段或合成规则来生成语音,如Voder。 - 数字化合成: 80年代出现的数字化合成技术,例如波形拼接和参数合成。 - 统计参数模型: 以隐马尔可夫模型(HMM)为代表,基于大量语音数据来预测发音参数。 - 深度学习合成: 以端到端的深度神经网络为基础,代表技术包括Tacotron和WaveNet,提升了语音的自然度和质量。

2.1.2 语音合成的原理与分类

语音合成技术可以按照其工作原理分为以下几个类别: - 拼接合成: 通过存储大量的语音片段,根据需要将这些片段拼接起来形成语音。 - 参数合成: 使用声学模型来生成语音参数,如基频、共振峰等,再通过声码器转换为语音波形。 - 直接波形合成: 直接从文本生成波形,不需要中间的语音参数。 - 端到端深度学习模型: 利用深度神经网络直接从文本到语音波形的映射,无需手动设计的声学参数。

2.2 JavaScript语音合成的实现原理

2.2.1 Web Speech API简介

Web Speech API是Web开发中的一套API,使网页能够接收和处理语音输入以及产生语音输出。Web Speech API包含两个主要部分:语音识别接口 ( SpeechRecognition ) 和语音合成接口 ( SpeechSynthesis )。

- 语音识别(SpeechRecognition): 允许网页访问用户的麦克风输入,并将语音转换为文本。

- 语音合成(SpeechSynthesis): 也称为TTS,能够将文本转换为语音输出。

Web Speech API在支持度方面,主要的现代浏览器如Chrome、Edge和Firefox都提供了良好的支持。这使得开发者能够通过简单的JavaScript代码,在网页上实现语音输入和输出的功能。

2.2.2 JavaScript中的语音合成技术

在JavaScript中使用语音合成技术,开发者主要依赖于Web Speech API中的 SpeechSynthesis 接口。以下是一个简单的例子:

// 创建一个SpeechSynthesisUtterance实例

var utterance = new SpeechSynthesisUtterance('Hello, world!');

// 发音器实例开始发言

speechSynthesis.speak(utterance);

上述代码展示了如何使用 SpeechSynthesisUtterance 对象,创建一个语音合成实例,并使其发声。在实际应用中,我们经常需要处理不同的事件和状态,例如:

utterance.onstart = function(event) {

console.log('语音合成开始');

};

utterance.onend = function(event) {

console.log('语音合成结束');

};

utterance.onerror = function(event) {

console.error('语音合成出错:', event.error);

};

2.3 语音合成技术的关键挑战

2.3.1 语音质量与自然度的提升

语音合成技术发展的一个核心目标就是提升语音输出的质量和自然度。尽管深度学习技术的发展极大地提升了语音合成的效果,但挑战依然存在,特别是在语言模型的训练和优化上。

- 优化声学模型: 通过更复杂的网络结构和更大的训练数据集来提升语音的自然度。

- 改进语言处理: 深入理解语法和语义,减少发音错误,提高对不同语音场景的适应能力。

2.3.2 语速、音调的控制方法

为了提供更为自然和可控的语音输出,开发者需要掌握如何调整语速和音调:

// 设置语速

utterance.rate = 1.5;

// 设置音调

utterance.pitch = 1.2;

在Web Speech API中,可以使用 rate 属性来调整语速, pitch 属性来调整音调。这些调整可以应用于 SpeechSynthesisUtterance 实例,并立即反映在语音合成中。开发者需要根据具体的应用场景和用户需求进行调整。

通过以上二级章节,我们深入了解了JavaScript语音合成技术的原理、挑战及解决方案。在后续章节中,我们将探讨如何利用Web Speech API实现具体的应用功能,包括文本到语音的转换、语音合成的参数配置以及与用户交互的相关技术细节。

3. Web Speech API的 SpeechSynthesis 接口应用

在现代的Web应用程序中,文本到语音转换(TTS)技术是增强用户交互体验的重要组成部分。Web Speech API为开发者提供了这种能力,其 SpeechSynthesis 接口是实现语音合成功能的核心。本章节将详细探讨 SpeechSynthesis 接口的介绍、应用以及其高级功能。

3.1 SpeechSynthesis接口介绍

3.1.1 接口的基本功能和使用场景

SpeechSynthesis 接口允许网页程序调用浏览器的内置语音合成引擎,将文本转换为语音输出。这在为视觉障碍用户提供的无障碍功能或在创建语言学习应用时尤为重要。该接口提供了一系列的事件、属性和方法,开发者可以通过简单的API调用来控制文本的语音输出。

3.1.2 接口的兼容性与跨浏览器支持

虽然 SpeechSynthesis 接口受到了现代浏览器的良好支持,但为了确保跨浏览器兼容性,开发者应使用功能检测技术来检查接口是否存在。此外,需要为不支持 SpeechSynthesis 的浏览器提供回退方案。通过在接口上调用 SpeechSynthesisUtterance 对象的 .constructor.name 属性,可以有效地检测浏览器是否支持该接口。

if ('speechSynthesis' in window) {

// 浏览器支持 Web Speech API

} else {

// 浏览器不支持 Web Speech API,实现替代方案

}

3.2 使用SpeechSynthesis实现语音合成

3.2.1 文本到语音的转换流程

要实现文本到语音的转换,首先需要创建一个 SpeechSynthesisUtterance 实例,然后通过 speechSynthesis.speak() 方法将其传递给浏览器进行语音合成。

let utterance = new SpeechSynthesisUtterance('Hello, World!');

speechSynthesis.speak(utterance);

这段代码创建了一个包含文本 Hello, World! 的语音合成实例,并指示浏览器开始语音合成过程。

3.2.2 语音合成的参数配置

SpeechSynthesisUtterance 对象允许开发者调整语音合成的多个参数,包括语言选择、语音速率、音量和音调。例如,可以为一个英文文本指定美式英语发音。

utterance的语言属性设为'en-US'

utterance.rate = 1; // 标准语速

utterance.volume = 1; // 标准音量

utterance.pitch = 1; // 标准音调

通过设置这些参数,开发者可以根据用户偏好或特定的应用需求来调整语音合成的输出。

3.3 SpeechSynthesis接口的高级功能

3.3.1 语音的排队和取消机制

SpeechSynthesis 接口支持语音排队机制,允许开发者将多个语音合成请求排队等待执行。通过调用 pause() 和 resume() 方法,可以控制语音合成的暂停与继续。 cancel() 方法可以取消当前正在播放的语音。

// 开始语音排队

speechSynthesis.speak(utterance1);

speechSynthesis.speak(utterance2);

// 暂停语音播放

speechSynthesis.pause();

// 继续语音播放

speechSynthesis.resume();

// 取消当前播放的语音

speechSynthesis.cancel();

3.3.2 语音合成的暂停与继续

SpeechSynthesis 接口提供了两个关键的事件 pause 和 resume ,这使得在语音合成暂停和继续时执行特定操作成为可能。这些事件可以用于控制应用程序中与语音合成相关的其他功能,例如更新用户界面。

speechSynthesis.addEventListener('pause', function(event) {

// 当语音合成暂停时执行的代码

});

speechSynthesis.addEventListener('resume', function(event) {

// 当语音合成继续时执行的代码

});

通过上述章节的介绍,我们可以看到 SpeechSynthesis 接口为实现Web应用程序中的文本到语音功能提供了强大的支持。下一章节将介绍如何通过用户界面设计原则来实现交互功能,进一步增强用户体验。

4. 用户交互与控制功能实现

在本章节中,我们将深入探讨用户交互与控制功能的实现。这涉及到用户如何与语音文本阅读器应用进行互动,包括文本输入、语音控制、合成状态控制等。为了打造一个用户友好且功能全面的应用程序,我们需要注重以下几个方面:

4.1 用户界面设计原则

4.1.1 界面简洁性与操作直观性

用户界面(UI)的直观性和简洁性是用户体验(UX)设计的基石。它们直接影响用户对产品的第一印象及持续使用的好感度。为了实现这一点,我们需要遵循一些基本的设计原则:

- 简洁性 :避免不必要的元素,减少用户在界面上需要处理的信息量。尽可能保持设计的简洁,突出主要功能。

- 一致性 :在整个应用中保持元素的视觉和操作逻辑一致性,如按钮大小、颜色和位置等。

- 反馈 :为用户提供即时的视觉和听觉反馈,以确认他们的操作已被系统识别和处理。

- 可用性 :确保用户可以轻松完成他们想要的操作,例如,一键式文本朗读、调整语速和音量等。

- 适应性 :设计应适应不同尺寸的屏幕和设备,保持布局和功能的可用性。

4.1.2 响应式设计与适配性

响应式设计允许我们的应用在不同设备上提供一致的用户体验。随着移动设备的普及,我们无法忽视在小屏幕上的用户体验。

- 媒体查询 :利用CSS的媒体查询针对不同屏幕尺寸定义样式规则,确保内容能够合理地适应不同设备。

- 流式布局 :使用百分比、em或rem单位代替固定宽度单位,让布局更具流动性。

- 弹性图片 :使用max-width属性保证图片不会超出其容器宽度,而高度自动调整。

- 视口元标签 :在HTML中添加视口(viewport)元标签,以确保布局在移动设备上被正确地缩放和呈现。

4.2 用户交互功能的实现

4.2.1 文本输入与编辑

用户交互功能的起点是从文本输入开始。用户需要有一个简单易用的方式来输入或粘贴他们想要朗读的文本。

- 文本框 :提供一个大型的文本输入框,让用户可以方便地输入或粘贴文本。

- 预览功能 :允许用户查看将要朗读的文本,包括文本样式和格式。

- 拼写检查 :集成一个基本的拼写检查器,以减少用户可能的输入错误。

- 文本管理 :用户应能够保存、编辑和删除文本片段。

4.2.2 语音控制与反馈

语音控制为用户提供了一种无需手动输入即可与应用程序交互的方式。为了实现这一点,我们可以使用Web Speech API的 SpeechRecognition 接口。

const recognition = new webkitspeechRecognition();

recognition.continuous = false;

recognition.interimResults = false;

recognition.lang = 'en-US';

recognition.onresult = function(event) {

// 将识别出的文本显示在文本输入框中

document.getElementById('text-input').value = event.results[0][0].transcript;

}

// 开始监听用户的语音指令

recognition.start();

在上述代码块中,我们实例化了一个语音识别对象,并设置了语言。当用户开始语音输入时,通过 onresult 事件处理函数将识别的文本更新到文本输入框中。

4.3 用户控制功能的实现

4.3.1 语音合成的开始与暂停控制

用户需要控制语音合成的开始和暂停,以便根据自己的阅读进度进行操作。

- 播放/暂停按钮 :提供明显的播放/暂停按钮,用户可以通过它们来控制语音的朗读。

- 状态监控 :监控语音合成状态,并在界面上显示相应的图标或状态信息。

4.3.2 语速、音量的实时调整

为了进一步提升用户体验,用户应能够实时调整语速和音量。

- 滑动条控件 :提供滑动条供用户调节语速和音量。

- 事件监听与应用 :当用户调整滑动条时,即时更新语音合成的参数。

let synth = window.speechSynthesis;

// 更新语速和音量的函数

function setVoiceProperties(pitch, rate, volume) {

synth.voicePitch = pitch;

synth语音合成语速 = rate;

synth.volume = volume;

}

// 示例:调整为默认语速、音量和音高

setVoiceProperties(1.0, 1.0, 1.0);

在上面的代码块中,我们使用 window.speechSynthesis 对象提供的属性来调整语音合成的语速( rate )、音量( volume )和音高( pitch )。通过监听滑动条的变化事件,我们可以调用 setVoiceProperties 函数来动态调整这些参数。

通过以上这些策略和代码示例,我们可以确保语音文本阅读器应用不仅在技术层面具有强大的语音合成能力,还在用户交互层面提供直观、易用的体验。这将大大增强用户对产品的满意度,提高其日常工作的效率和舒适度。

5. 语音合成状态监听与事件处理

5.1 语音合成状态监听

语音合成状态监听是确保应用流程控制和用户体验质量的关键部分。它允许开发者实时获取语音合成的过程和状态变化,进而执行相应的操作。

5.1.1 语音合成过程的状态机

语音合成过程可以被视为一个状态机,包含多种状态,如“开始合成”、“正在合成”、“合成完成”、“发生错误”等。这些状态可以根据 SpeechSynthesis 接口的事件属性进行监控。

const synth = speechSynthesis;

// 监听开始和结束事件

synth.onstart = () => {

console.log('SpeechSynthesis.onstart');

};

synth.onend = () => {

console.log('SpeechSynthesis.onend');

};

// 监听暂停、继续和取消事件

synth.onpause = () => {

console.log('SpeechSynthesis.onpause');

};

synth.onresume = () => {

console.log('SpeechSynthesis.onresume');

};

synth.oncancel = () => {

console.log('SpeechSynthesis.oncancel');

};

// 监听错误事件

synth.onerror = (event) => {

console.log(`SpeechSynthesis.onerror: ${event.error}`);

};

5.1.2 状态变化的监听方法

在JavaScript中,通过监听 SpeechSynthesis 对象的事件,可以及时响应合成过程中的状态变化。例如,开始合成时,我们可能需要准备一些UI反馈给用户,如显示一个表示正在播放的图标;合成完成时,可以提示用户语音播放已经结束。

5.2 事件处理机制

语音合成的事件处理机制不仅包括了状态变化的监听,还包括了其他各种事件的响应。

5.2.1 常见事件类型与应用场景

语音合成相关的事件类型包括但不限于以下几种:

-

start: 语音合成开始时触发。 -

end: 语音合成结束时触发。 -

error: 语音合成发生错误时触发。 -

pause: 语音合成暂停时触发。 -

resume: 语音合成继续时触发。 -

cancel: 语音合成被取消时触发。

// 使用事件处理函数来处理状态变化

const speak = (text) => {

const utterance = new SpeechSynthesisUtterance(text);

synth.speak(utterance);

// 确保有适当的事件监听器来处理事件

utterance.onend = () => {

console.log(`The speech synthesis of "${text}" is finished.`);

};

utterance.onerror = (event) => {

console.log(`An error occurred while synthesizing speech: ${event.error}`);

};

};

5.2.2 事件处理的优化策略

为了优化事件处理过程,可以采取如下策略:

- 减少事件处理函数的执行时间,确保不会阻塞主执行流程。

- 使用事件委托或者事件缓存的方式减少事件监听器的数量,提升性能。

- 在合适的时机添加和移除事件监听器,避免不必要的事件触发。

5.3 异常处理与用户体验

异常处理是保障用户体验的关键,它涉及到了错误捕获、错误提示、以及整体的用户体验优化。

5.3.1 异常捕获与错误提示

对于语音合成过程中可能出现的异常,需要及时捕获并给出清晰的错误提示。例如,如果文本太长而无法合成,或者文本包含不支持的语言,应通过界面友好地提示用户。

5.3.2 用户体验的优化措施

为了提升用户体验,应该在设计时考虑如下措施:

- 明确的错误提示和建议的解决方案。

- 在错误发生时,提供快速重试的按钮或选项。

- 优化用户界面,确保在错误发生时不会导致用户困惑。

// 异常捕获示例

const handleTextToSpeech = (text) => {

try {

const utterance = new SpeechSynthesisUtterance(text);

synth.speak(utterance);

} catch (error) {

// 提供给用户适当的错误处理和反馈

alert(`An error occurred: ${error.message}`);

}

};

这些措施帮助确保用户在遇到问题时不会感到沮丧,并能够迅速了解问题所在,并找到合适的解决途径。

6. 错误处理和多语言支持

在任何复杂的应用程序中,错误处理和多语言支持都是提升用户体验至关重要的两个方面。本章节将深入探讨这两个话题,并向您展示如何在JavaScript中实现这些功能以增强语音文本阅读器的健壮性和可访问性。

6.1 错误处理策略

错误处理是软件开发中的一个关键组成部分,它可以帮助开发者捕捉和处理在应用程序执行过程中可能发生的异常情况。在实现语音合成功能时,需要考虑的错误类型以及如何处理它们是确保应用稳定运行和提供良好用户体验的前提。

6.1.1 常见错误类型及处理方式

在使用Web Speech API进行语音合成时,开发者可能会遇到以下几种常见错误类型:

- Network errors (网络错误) :当Web Speech API无法连接到语音服务时,可能会产生网络错误。处理此类错误时,可以显示一个重试按钮或提示用户检查网络连接。

- Synthesis errors (合成错误) :当提供的文本无法被合成时,例如因为语言或格式问题,可能会产生合成错误。开发者应提供清晰的错误信息,并提供修改文本的选项。

- Timeout errors (超时错误) :如果语音合成过程超过了设定的时间限制,可能会产生超时错误。在这种情况下,应允许用户取消或重新开始语音合成。

6.1.2 日志记录与分析

在处理错误时,日志记录是一个非常有用的工具。它可以帮助开发者追踪和分析错误发生的原因。一个有效的日志记录系统应包括以下特性:

- Timestamps (时间戳) :记录错误发生的具体时间,有助于跟踪问题的频率和模式。

- Error level (错误级别) :如警告、错误或严重错误,以便于快速识别问题的严重性。

- Contextual information (上下文信息) :提供尽可能多的错误发生时的上下文信息,比如错误发生时的用户操作和系统状态。

- Error messages (错误信息) :显示清晰的错误信息,并提供可能的解决方案或操作步骤。

6.2 多语言支持实现

随着全球化趋势的发展,软件应用的多语言支持变得越来越重要。本节将介绍如何实现Web Speech API的多语言支持,使语音文本阅读器能够适应不同地区的用户。

6.2.1 国际化(i18n)与本地化(l10n)基础

国际化(i18n)和本地化(l10n)是实现多语言支持的两个核心概念。国际化指的是设计和开发软件时采用的方法,让软件支持多种语言和区域。本地化则是指将软件翻译成特定语言并适应特定文化的流程。

实现国际化通常包括以下几个步骤:

- 语言选择 :为应用程序提供语言选择功能,以便用户可以根据自己的偏好选择语言。

- 数据格式化 :根据地区格式化日期、时间和数字等数据。

- 文本国际化 :使用国际化的资源管理,如使用

i18next或angular-translate等库来管理多语言文本。

本地化过程通常需要翻译团队的参与,包括:

- 文本翻译 :将所有用户界面的文本翻译成目标语言。

- 文化适配 :确保翻译符合目标文化的习惯和规范。

6.2.2 多语言文本处理与资源管理

多语言文本的处理和资源管理是多语言支持的核心。在JavaScript中,可以通过以下方式管理多语言资源:

- JSON文件 :使用JSON文件存储不同语言的文本资源,然后根据当前选择的语言动态加载相应的资源。

- 国际化库 :利用国际化库来实现翻译功能,这不仅可以提高翻译效率,还可以避免重复的代码。

以下是一个使用 i18next 库的例子:

import i18n from 'i18next';

// 初始化i18next

i18n

.use(initReactI18next) // 将i18next与React集成

.init({

resources: {

en: {

translation: {

"key1": "Hello, World!",

},

},

es: {

translation: {

"key1": "¡Hola, Mundo!",

},

}

},

lng: 'en', // 默认语言

fallbackLng: 'en',

});

// 使用翻译函数

const translate = (key, options) => i18n.t(key, options);

// 翻译文本

const translatedText = translate('key1');

console.log(translatedText); // 输出:Hello, World!

6.3 语言模型和文本规范化

文本规范化是多语言支持的另一重要组成部分。它涉及到语言模型的选择和优化,以及文本的预处理步骤。这可以帮助提高语音合成的质量和准确性。

6.3.1 语言模型的选择与优化

语言模型是理解和生成自然语言文本的基础。在语音合成中,选择合适的语言模型对于生成流畅、自然的语音至关重要。以下是一些选择和优化语言模型的策略:

- 选择合适的语言模型 :不同的语言模型可能更适合不同的语言或口音。例如,对于英语,可以使用CMU Sphinx或MaryTTS的英语模型。

- 优化语言模型 :可以通过调整语言模型的参数或使用更先进的深度学习模型来优化语音合成的质量。

6.3.2 文本预处理与规范化流程

在将文本传递给语音合成器之前,需要进行一些预处理和规范化工作。这些步骤有助于提高语音合成的准确性和自然度。以下是一些常见的文本预处理步骤:

- 去除特殊字符 :移除文本中的表情符号、特殊字符等,以免影响语音合成的准确性。

- 格式转换 :将数字和日期等格式统一转换为语音合成器容易识别的格式。

- 缩写和简写扩展 :将常用的缩写和简写展开成完整的形式,以减少歧义。

// 示例:文本预处理函数

function preprocessText(text) {

// 移除特殊字符

let cleanedText = text.replace(/[^a-zA-Z0-9\s]/g, '');

// 格式转换示例:将数字转换为文字

cleanedText = cleanedText.replace(/\b\d+\b/g, (word) => wordToWords(word));

// 返回处理后的文本

return cleanedText;

}

// 将数字转换为文字的辅助函数

function wordToWords(word) {

const numWords = {

0: 'zero', 1: 'one', 2: 'two', 3: 'three', 4: 'four',

5: 'five', 6: 'six', 7: 'seven', 8: 'eight', 9: 'nine'

};

return numWords[word];

}

通过对错误处理和多语言支持的深入理解,开发者可以显著提升语音文本阅读器的健壮性和用户满意度。而语言模型和文本规范化是确保语音合成质量和自然度的关键步骤。通过结合上述技术和策略,开发者可以创建一个国际化、高质量和用户友好的语音文本阅读器应用。

7. 语音文本阅读器项目实战流程

7.1 项目需求分析与规划

在着手开发一个语音文本阅读器之前,首先需要进行细致的需求分析与项目规划。这包括确定目标用户群体、明确使用场景、梳理功能需求,并最终选择合适的技术栈。

7.1.1 确定目标用户群体与使用场景

目标用户群体的确定将直接影响产品设计和功能开发的方向。例如,针对视力受限的用户,界面应该简洁,操作尽可能直观。对于经常需要进行多任务处理的用户,语音控制功能可能更为重要。一旦确定了目标用户群体,我们就可以开始梳理他们可能的使用场景,如阅读电子邮件、文章或者在线教程等。

7.1.2 功能需求梳理与技术选型

在功能需求梳理方面,除了核心的文本到语音转换功能外,还需要考虑用户自定义语音设置、保存语音配置、支持多语言朗读等功能。技术选型则需要基于当前的Web标准和用户需求,选择适合的技术方案。对于Web Speech API,了解其兼容性和局限性是必要的。对于多语言支持,可能需要集成第三方翻译服务或自建语言模型。

7.2 开发环境搭建与工具选择

一个良好的开发环境能够提高开发效率,降低开发过程中的错误率。

7.2.1 开发工具与环境配置

推荐使用现代的集成开发环境(IDE),如Visual Studio Code,它支持代码高亮、智能代码补全等。在项目初始化阶段,需要配置好Node.js环境,安装必要的依赖,如构建工具Webpack、包管理器NPM,以及其他开发过程中可能用到的插件和库。

7.2.2 依赖管理和版本控制

使用NPM或Yarn来管理项目依赖能够帮助团队成员同步依赖版本,确保开发环境的一致性。版本控制是任何项目中不可或缺的部分,Git是目前使用最广泛的版本控制系统,它支持分布式开发流程,并提供代码分支管理、合并冲突解决等功能。

7.3 功能开发与测试

开发过程中,合理的代码组织和模块化设计能够提高代码的可读性和可维护性。同时,测试工作同样不容忽视,它是保证产品质量的关键。

7.3.1 分模块开发与代码组织

在开发过程中,应该将项目分解为多个模块,例如文本处理模块、语音合成模块、用户界面控制模块等。每个模块负责一组特定的功能,这样有助于团队协作和代码维护。使用ES6模块系统或者更高级的模块打包工具如Webpack,可以帮助开发者组织和打包JavaScript代码。

// 示例代码块,展示如何使用ES6模块导出和导入功能

// export.js

export const myFunction = () => {

// 功能实现

};

// import.js

import { myFunction } from './export';

7.3.* 单元测试与集成测试策略

单元测试能够测试代码中的最小可测试部分,通常是指一个函数或一个类。而集成测试则是在模块与模块之间进行交互测试,确保它们能够作为一个整体正确地工作。测试框架如Jest提供了丰富的API来编写和执行测试用例,并且可以利用其模拟功能来测试依赖于外部资源的模块。

// 示例代码块,展示如何使用Jest进行单元测试

test('add function adds numbers correctly', () => {

const result = add(2, 3);

expect(result).toBe(5);

});

7.4 项目部署与后续维护

项目开发完成后,需要进行部署,这通常包括将应用部署到一个Web服务器或者云服务平台上。

7.4.1 部署流程与环境准备

在部署之前,应确保有一个安全、稳定且可扩展的服务器环境。可以使用传统的云服务提供商,如AWS、Google Cloud或Azure,或者使用容器化平台如Docker和Kubernetes。部署流程可能需要设置CI/CD(持续集成/持续部署)管道,以便自动化构建和部署过程。

7.4.2 用户反馈收集与产品迭代

用户反馈是产品改进的重要来源。通过收集用户反馈,可以了解产品的优点和不足,针对性地进行改进和优化。通过迭代开发,不断提供新的功能和修复已知的bug,持续提升产品的用户体验和满意度。

在产品上线后,应该提供清晰的反馈渠道,如用户调查问卷、客户服务渠道等。对收集到的数据进行分析,可以为产品的进一步迭代提供数据支持和方向。

简介:本项目基于JavaScript语言,旨在开发一个将文本信息转换为语音输出的应用程序,方便视障人士和需要多任务操作的用户。它利用Web Speech API的 SpeechSynthesis 接口实现语音合成,并通过HTML、CSS和JavaScript文件提供完整的功能。开发者需处理用户交互、多语言支持以及性能优化等多个方面,确保应用程序的易用性和高效率。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?