CAMEL:通过角色扮演,实现大模型自主合作的多智能体框架

- 提出背景

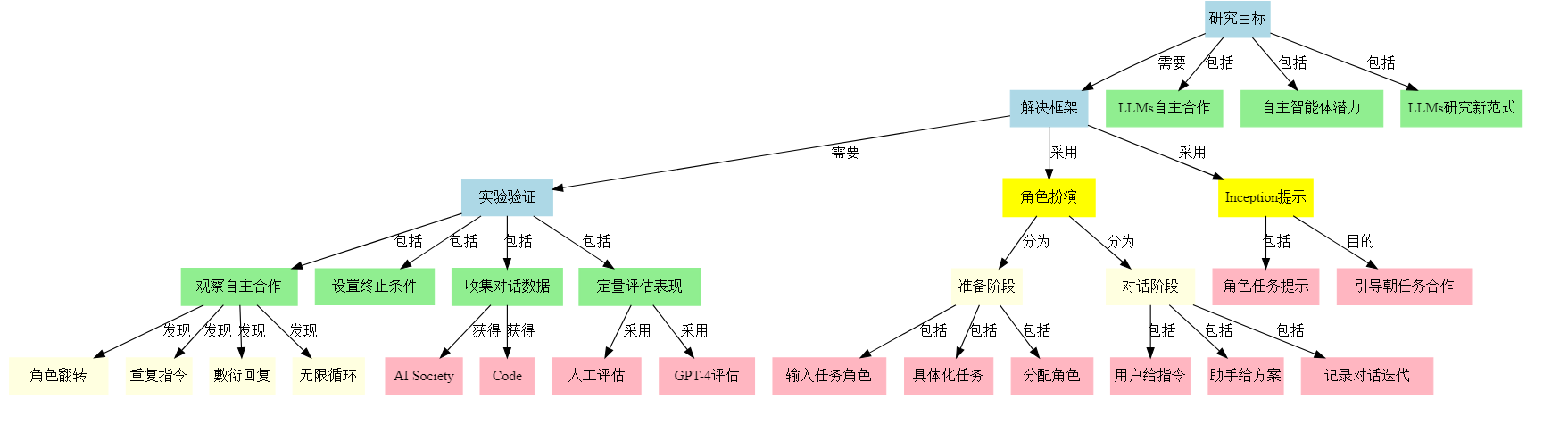

- 秒懂大纲

- 解法拆解

- 类比

- 全流程分析

- CAMEL 对比 AutoGen、MetaGPT

- 为什么通过角色扮演和对话,就能实现大模型的自主合作,探索自主交互智能体在复杂任务求解中的潜力?

论文: CAMEL: Communicative Agents for “Mind” Exploration of Large Language Model Society

代码: https://github.com/camel-ai/camel?tab=readme-ov-file#readme

提出背景

CAMEL框架的提出背景主要有以下几个方面:

- 解决的问题类别:

CAMEL旨在解决大语言模型(LLMs)在复杂任务求解中的自主合作问题。 - 具体解决的问题:

(1) 减少人工干预:当前LLMs在解决复杂任务时,仍然高度依赖人类输入来引导对话。

这需要用户根据自己的意图和聊天代理的反馈提供相关和精确的提示,这可能很具有挑战性、耗时,有时甚至是不可能的。

(2) 实现自主合作:探索如何让对话代理能够自主地引导对话朝着任务完成的方向发展,而只需最少的人工监督。

(3) 研究多代理系统:理解多个代理如何相互交互对于预测人工智能的未来很重要。

合作或竞争的代理动态在决定AI系统成功方面起着关键作用。

(4) 提高任务完成能力:通过让多个专业代理合作,提高系统在复杂任务上的整体表现。

(5) 生成高质量数据:提供一种可扩展的方法来生成对话数据,用于研究对话语言模型的行为和能力。

- 背景动机:

(1) LLMs的快速发展使得复杂任务求解成为可能,但仍需要大量人工引导。

(2) 需要研究如何让AI代理更好地自主合作,以减少对人类干预的依赖。

(3) 多代理系统的研究对于理解和预测未来AI系统的行为至关重要。

(4) 需要可扩展的方法来生成高质量的对话数据,以推动对话系统的研究。

该框架主要由两部分组成:角色扮演框架和Inception Prompting技术。

角色扮演框架是一个总体的方法论,分为准备阶段和对话阶段。

在准备阶段,人类首先输入任务构想和所需角色,然后任务指定agent将任务进一步具体化,并为助手和用户agent分配相应角色。

在对话阶段,用户agent给出指令,助手agent根据指令给出解决方案,同时记录对话历史并迭代,直到任务完成。

Inception Prompting技术是该框架的关键,它通过设计精巧的角色提示和任务指定提示,在对话过程中引导agent朝着任务完成的方向进行合作。

这种提示方式有助于克服自主合作过程中可能出现的问题,如角色翻转、助手重复用户指令、助手给出敷衍回复以及无限对话循环等。

秒懂大纲

该概念图进一步阐述了CAMEL论文中提出的角色扮演框架的具体内容和实现过程。整个框架可分为准备阶段和对话阶段两大部分。

在准备阶段,首先由人类输入任务构想和所需角色。接着,一个专门的任务指定agent会将任务进一步具体化,并为助手agent和用户agent分配对应的角色。

这一阶段的目的是明确任务定义,设定agent的身份和职责。

进入对话阶段后,用户agent会根据任务给出指令,助手agent则提供相应的解决方案。

在这个交互的过程中,他们的对话历史会被记录下来,用于后续的数据分析。

通过这种不断迭代的方式,agent可以协作完成任务,而研究者也能够收集到丰富的对话数据,用于研究LLMs的行为模式和能力水平。

为了引导agent进行有目的性的对话,CAMEL引入了一种名为Inception Prompting的关键技术。

该技术由角色提示和任务指定提示两部分组成,旨在为agent设定明确的身份定位和任务导向,从而帮助他们在对话中朝着任务完成的方向不断推进。

总的来说,CAMEL的角色扮演框架为实现LLMs的自主合作提供了一种全新的思路。

通过为agent赋予不同的角色,并运用Inception Prompting技术加以引导,该框架使得多个LLMs能够进行有目的、有逻辑的任务式对话,为相关领域的研究带来了新的契机。

同时,该框架在实践中所积累的海量对话数据,也将为后续研究LLMs的行为和能力提供宝贵的素材。

解法拆解

目的:探索自主交互智能体在复杂任务求解中的潜力,为研究大型语言模型的行为和能力提供新范式。

问题:

- LLMs在自动化复杂任务求解中依赖人工输入指导对话

- 实现LLMs自主合作面临诸多挑战,如对话偏离、角色反转、聊天终止条件等

解法:角色扮演框架 = 准备阶段(因为需要明确任务和角色)+ 对话阶段(因为需要实现自主对话合作)+ Inception Prompting技术(因为需要在对话中引导agent朝任务方向合作)

举例:AlphaFold2 = 特征提取(因为需要理解氨基酸序列特征)+ 结构预测(因为需要得出最终蛋白质结构)+ 注意力机制(因为需要建模长程残基交互作用)

- 子解法之间的逻辑关系可以表示为一个链条:

准备阶段 -> 对话阶段 -> Inception Prompting技术

其中,准备阶段的输出(明确的任务和角色)是对话阶段的输入,而Inception Prompting技术贯穿对话阶段的始终,引导agent的对话方向。

- 隐性特征分析:

通过仔细分析论文中的解法步骤,可以发现一个隐性的关键特征和方法:逐步推进和迭代优化。

这个隐性特征体现在对话阶段中,agent通过逐轮对话的方式,不断细化任务、优化方案,直至任务完成。

每一轮对话都基于之前的对话历史,是一个渐进的过程。这种通过迭代对话逐步推进的方式,可以帮助agent在一开始信息不完整的情况下,通过交互来丰富信息,优化结果。

虽然论文中没有明确定义"逐步推进和迭代优化"这一方法,但它确实是CAMEL框架能够完成复杂任务的一个关键所在。

类比

目的:准确诊断患者的疾病,并提供有效的治疗方案。

问题:患者出现了某些异常症状,需要判断这些症状对应的疾病是什么,以及如何治疗。

解法 = 子解法1(因为症状特征) + 子解法2(因为体征特征) + 子解法3(因为检查结果特征) + 子解法4(因为病史特征)

子解法1:询问患者的主诉和症状

- 之所以用询问症状的子解法,是因为患者的异常感受是诊断的起点和线索。

子解法2:为患者进行体格检查

- 之所以用体格检查的子解法,是因为客观体征能够验证和补充患者主诉,为鉴别诊断提供依据。

子解法3:开具必要的辅助检查

- 之所以用辅助检查的子解法,是因为检验、影像、内镜等结果能够深化病因分析,确定诊断。

子解法4:了解患者的既往史、个人史、家族史等

- 之所以了解病史的子解法,是因为疾病的恶化过程、个人生活习惯、家族遗传倾向等信息有助于诊断和治疗。

举例:一位患者出现了持续性的腹痛,医生首先询问了发病的时间、位置、性质、伴随症状等(子解法1),接着为患者进行了腹部触诊、叩诊等体格检查(子解法2),考虑到病情原因尚不明确,医生开具了血常规、腹部CT等辅助检查(子解法3),同时详细了解了患者过去两年的慢性胃炎病史及家族胃癌史(子解法4)。

综合以上信息,医生初步诊断该患者为胃溃疡,并给予相应治疗。

- 这些子解法的逻辑链可以用下面的决策树展示:

问诊

├── 症状

│ └── 询问患者主诉

├── 体征

│ └── 进行体格检查

├── 检查

│ ├── 实验室检验

│ ├── 医学影像学检查

│ └── 特殊检查(如内镜等)

└── 病史

├── 既往史

├── 个人史

└── 家族史

可以看出,这是一个链式结构,各个子解法环环相扣,共同作用,最终形成诊断结论。

- 分析隐性特征:

在医学问诊的步骤中,一个容易被忽视但十分关键的隐性特征是"临床思维"。

医生在问诊过程中,并非机械地收集各种信息,而是时刻运用自己的医学知识和经验,在头脑中形成一系列假设,并有目的地搜集佐证或排除的信息。

这种假设驱动的分析综合能力,对于缩小诊断范围、避免无谓的检查至关重要。

比如上例中,当患者提到腹痛时,一个有经验的医生会迅速联想到胃炎、溃疡、胰腺炎、结石等可能,然后通过体检、问询病史等方式,逐一验证这些假设。

这样,诊断就不是毫无头绪的"大海捞针",而是有的放矢、步步深入的过程。

因此,隐藏在问诊步骤背后的"临床思维"能力,可以定义为一种关键特征。

它以医生的知识库为基础,以逻辑推理为手段,以假设验证为策略,有效提高了诊断的针对性和效率。

全流程分析

CAMEL的解法流程可以分为以下步骤:

- 明确研究目标 (问题)

1.1 实现大型语言模型(LLMs)的自主合作

1.2 探索自主交互智能体在复杂任务求解中的潜力

1.3 为研究LLMs的行为和能力提供新范式 - 提出解决框架 (解法)

2.1 角色扮演框架 (总体方法)

2.1.1 准备阶段 (任务和角色设定)

- 人类输入任务构想和角色

- 任务指定agent将任务具体化

- 为助手/用户agent分配角色

2.1.2 对话阶段 (自主对话合作)

- 用户agent给出指令

- 助手agent给出解决方案

- 记录对话历史并迭代

2.2 Inception Prompting技术 (关键技术)

- 角色提示和任务指定提示

- 引导agent朝任务方向合作

- 实验验证 (解法评估)

3.1 观察自主合作过程 (现象分析)

- 角色翻转、重复指令、敷衍回复、无限对话循环等问题

3.2 设置终止条件 (优化措施)

3.3 收集对话数据集 (数据积累) - AI Society数据集

- Code数据集

3.4 定量评估agent表现 (效果评估) - 人工评估

- GPT-4评估

- 全流程优化

多题一解的情况:

- 共用特征: 不同的复杂任务可能共享相似的子任务或问题结构。

- 共用解法: 将任务分解为多个agent的协作,通过角色扮演和对话推进任务解决。这种解法称为"Multi-agent Collaboration via Role-playing",适用于有明确目标、可分解为子任务、需要多角度思考的复杂问题。

一题多解的情况:

- 多个特征: 复杂任务可能涉及多个领域知识、多种问题类型、多个推理步骤等。

- 多种解法: CAMEL框架提供了一个通用的解决思路,但在具体实现时可以针对任务的不同特点,灵活设计角色、优化提示、调整算法,从而得到多种适应性强的解法。

优化思路:

- 角色设计优化: 根据任务的特点,设计最合适的角色组合,明确每个角色的知识背景和职责边界,促进角色间的高效协作。

- 提示优化: 通过实验不断迭代和优化任务描述和角色提示的内容与格式,使其更精准地引导agent进行目标导向的对话,减少无效互动。

- 终止条件优化: 针对不同任务设置个性化的对话终止条件,及时判断问题是否解决,避免不必要的计算资源浪费。

- 数据积累: 在应用过程中持续收集和丰富不同领域、不同类型任务的对话数据,用于优化模型和算法。

- 引入外部知识: 将领域知识库、检索系统等外部知识源引入对话过程,为agent提供更丰富、更可靠的信息支持。

- 人机协作: 在关键节点引入人工参与,对agent的对话质量进行评估和反馈,提高系统的可解释性和可控性。

CAMEL 对比 AutoGen、MetaGPT

为什么通过角色扮演和对话,就能实现大模型的自主合作,探索自主交互智能体在复杂任务求解中的潜力?

5 Why分析:

Why 1: 为什么角色扮演和对话能实现LLMs的自主合作?

- 原因:角色扮演为LLMs提供了明确的身份定位和行为模式,而多轮对话则提供了信息交换和协作的渠道。

Why 2: 为什么明确的身份定位、行为模式和信息交换渠道能促进自主合作?

- 原因:身份定位和行为模式为LLMs的互动行为提供了基本框架和约束,减少了无效或无目标的互动。信息交换渠道则让LLMs能够就任务达成共识,并协调行动。

Why 3: 为什么互动框架、行为约束和协调行动能促进复杂任务的求解?

- 原因:复杂任务往往需要多个智能体各司其职,分工协作。明确的互动框架和行为约束确保了智能体能够聚焦在各自的子任务上,而有效的协调行动则让子任务能够整合为一个完整的解决方案。

Why 4: 为什么聚焦子任务和整合解决方案能体现自主交互智能体的潜力?

- 原因:自主交互智能体的一大潜力在于通过分布式的并行处理和协同求解,高效地应对复杂问题。聚焦子任务体现了并行处理的优势,整合解决方案则体现了协同求解的效能。

Why 5: 为什么并行处理和协同求解是自主交互智能体的根本潜力?

- 原因:并行处理和协同求解是智能体之间高效分工与合作的基础。这种分工与合作模式,正是大规模多智能体系统应对复杂开放环境的根本优势所在。角色扮演对话,本质上是为LLMs搭建并行协作的基础设施。

5 So分析:

So 1: 基于以上分析,我们可以通过进一步优化角色设计、完善对话机制,来增强LLMs的自主合作能力。

So 2: 角色设计和对话机制的优化,将促使LLMs形成更稳定、更高效的协作关系。这将提升它们应对复杂任务的表现。

So 3: LLMs协作能力和复杂任务表现的提升,将加速构建强大的开放域对话系统、智能任务规划系统等。

So 4: 高能力的开放域对话和任务规划系统的出现,将大大拓展人工智能的应用场景和服务边界,为人类用户带来更智能、更个性化的交互体验。

So 5: 最终,我们希望看到的是,大规模自主交互智能体系统能够与人类形成紧密的协同与互补,在开放环境下共同应对各种复杂挑战。

角色扮演对话,正是通向这一目标的关键一步。

总结起来,之所以角色扮演对话能有效促进LLMs的自主合作与复杂任务求解,根本原因在于这种范式为智能体搭建了明确的分工协作框架,激发了它们并行处理和协同求解的潜力。

而这正是构建大规模自主智能系统,实现人机协同和共同进化的重要基石。

优化角色设计和对话机制,提升LLMs的协作效能,我们就能进一步挖掘自主交互智能体的巨大潜力,创造更加智能美好的未来。

604

604

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?