1.CART树

CART算法流程:

- 若满足停止分裂条件(样本个数小于预定阈值,或Gini指数小于预定阈值(样本基本属于同一类,或没有特征可供分裂),则停止分裂;

- 否则,选择最小Gini指数进行分裂;

- 递归执行1-2步骤,直至停止分裂。

2.算法原理

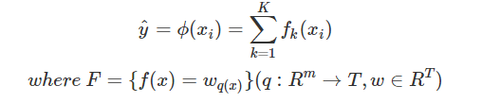

xgboost对应就是一堆CART树。算法思想就是不断地添加树,不断地进行特征分裂来生长一棵树,每次添加一个树,其实是学习一个新函数,去拟合上次预测的残差。当我们训练完成得到k棵树,我们要预测一个样本的分数,其实就是根据这个样本的特征,在每棵树中会落到对应的一个叶子节点,每个叶子节点就对应一个分数,最后只需要将每棵树对应的分数加起来就是该样本的预测值。

3.损失函数

![]()

第一项为训练误差,第二项为正则化项,用来刻画模型的复杂程度。具体形式将在(5.正则化)中介绍。

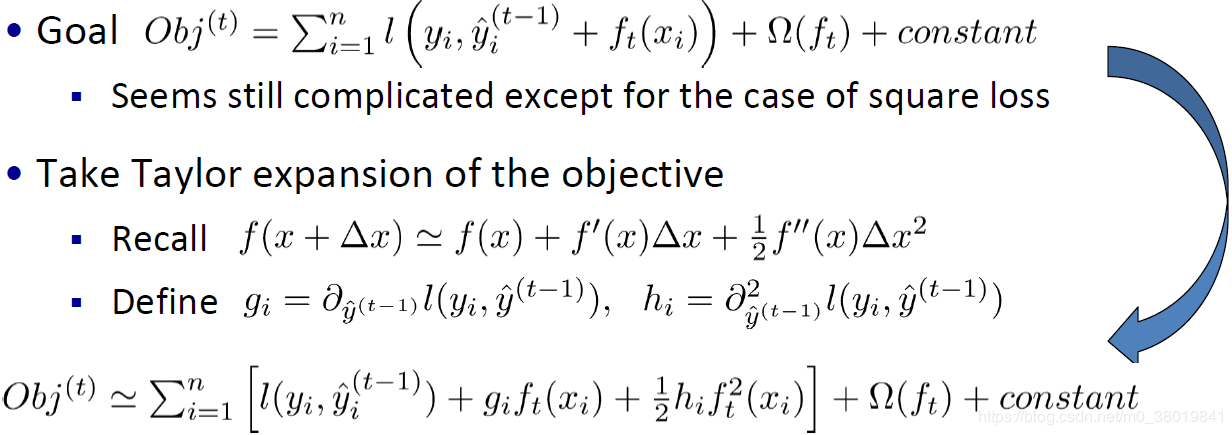

XGBoost度损失函数进行了二阶泰勒展开:

4.分裂节点算法

基于空间切分去构造一颗决策树是一个NP难问题,我们不可能去遍历所有树结构,因此,XGBoost使用了和CART回归树一样的想法,利用贪婪算法,遍历所有特征的所有特征划分点,不同的是使用上式目标函数值作为评价函数。具体做法就是分裂后的目标函数值比单子叶子节点的目标函数的增益,同时为了限制树生长过深,还加了个阈值,只有当增益大于该阈值才进行分裂。

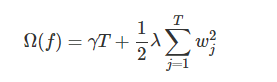

5.正则化

注意:这里出现了γ和λ,这是xgboost自己定义的,在使用xgboost时,你可以设定它们的值,显然,γ越大,表示越希望获得结构简单的树,因为此时对较多叶子节点的树的惩罚越大。λ越大也是越希望获得结构简单的树。

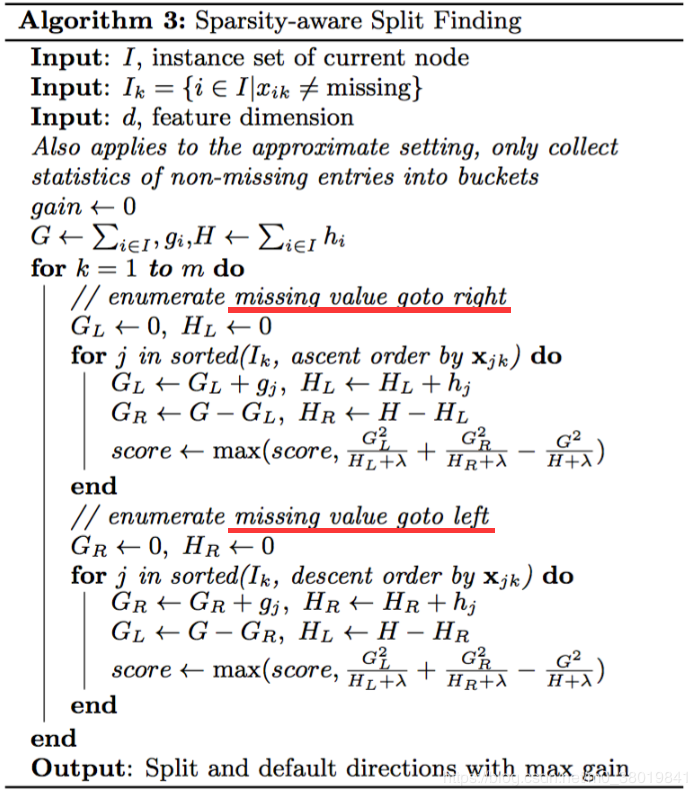

6.对缺失值的处理

XGB训练数据的时候,它使用没有缺失的数据去进行节点分支。然后我们将特征上缺失的数据尝试放左右节点上,看缺失值应当分到那个分支节点上。我们把缺失值分配到的分支称为默认分支。这能大大提升算法的效率。

7.优缺点

优点:

xgboost在目标函数中显示的加上了正则化项,基学习为CART时,正则化项与树的叶子节点的数量T和叶子节点的值有关。

GB中使用Loss Function对f(x)的一阶导数计算出伪残差用于学习生成fm(x),xgboost不仅使用到了一阶导数,还使用二阶导数。

上面提到CART回归树中寻找最佳分割点的衡量标准是最小化均方差,xgboost寻找分割点的标准是最大化,lamda,gama与正则化项相关

缺点:

算法采用贪心策略,较为耗时。

8.应用场景

分类,回归

9.sklearn参数

objective [ default=reg:linear ]

定义学习任务及相应的学习目标,可选的目标函数如下:

“reg:linear” –线性回归。

“reg:logistic” –逻辑回归。

“binary:logistic” –二分类的逻辑回归问题,输出为概率。

“binary:logitraw” –二分类的逻辑回归问题,输出的结果为wTx。

“count:poisson” –计数问题的poisson回归,输出结果为poisson分布。 在poisson回归中,max_delta_step的缺省值为0.7。(used to safeguard optimization)

“multi:softmax” –让XGBoost采用softmax目标函数处理多分类问题,同时需要设置参数num_class(类别个数)

“multi:softprob” –和softmax一样,但是输出的是ndata * nclass的向量,可以将该向量reshape成ndata行nclass列的矩阵。没行数据表示样本所属于每个类别的概率。

’eval_metric’ 评估指标:对于回归问题,默认值是rmse,对于分类问题,默认值是error。

“rmse”: 均方根误差

“logloss”: 负对数似然函数值

“error”: 二分类错误率(阈值为0.5)

“merror”: 多分类错误率

“mlogloss”: 多分类logloss损失函数

“auc”: ROC曲线下面积

"mae":平均绝对误差

lambda [default=0]

L2 正则的惩罚系数

alpha [default=0]

L1 正则的惩罚系数

lambda_bias

在偏置上的L2正则。缺省值为0

eta [default=0.3]

为了防止过拟合,更新过程中用到的收缩步长。在每次提升计算之后,算法会直接获得新特征的权重。 eta通过缩减特征的权重使提升计算过程更加保守。缺省值为0.3 。取值范围为:[0,1]

max_depth [default=6]

数的最大深度。缺省值为6 ,取值范围为:[1,∞]

min_child_weight [default=1]

孩子节点中最小的样本权重和。如果一个叶子节点的样本权重和小于min_child_weight则拆分过程结束。在现行回归模型中,这个参数是指建立每个模型所需要的最小样本数。该成熟越大算法越conservative 。取值范围为: [0,∞]

tree_method[default=’auto’]

可选 {‘auto’, ‘exact’, ‘approx’} 贪心算法(小数据集)/近似算法(大数据集)

参考:https://www.cnblogs.com/harvey888/p/7203256.html

1297

1297

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?