1.Windows安装CUDA和cuDNN

官方教程

CUDA: Installation Guide Windows :: CUDA Toolkit Documentation

cuDNN: Installation Guide :: NVIDIA Deep Learning cuDNN Documentation

1.下载并安装CUDA

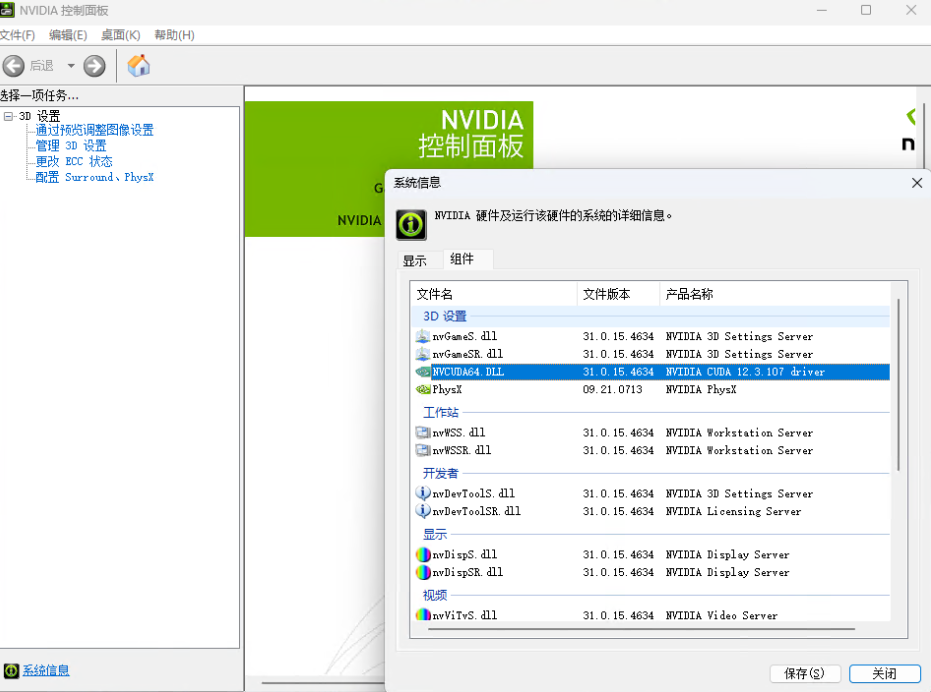

1.查看要版本

2.下载CUDA

下载连接: kCUDA Toolkit Archive | NVIDIA Developer

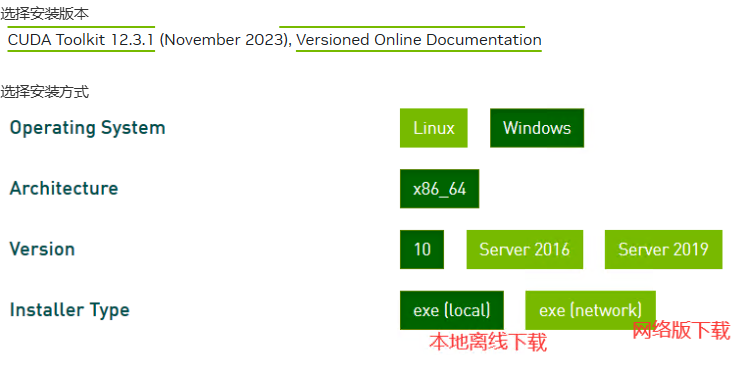

选择安装版本

选择安装方式

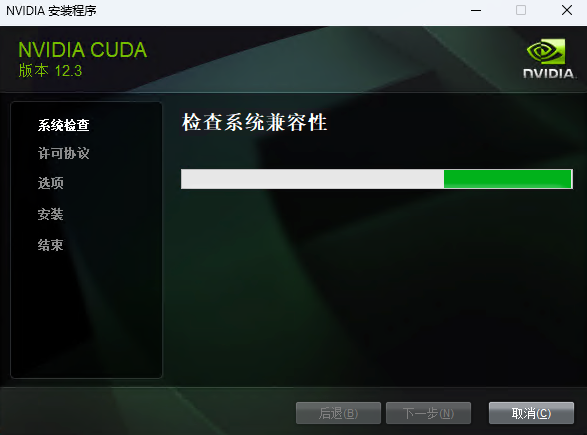

3.安装CUDA

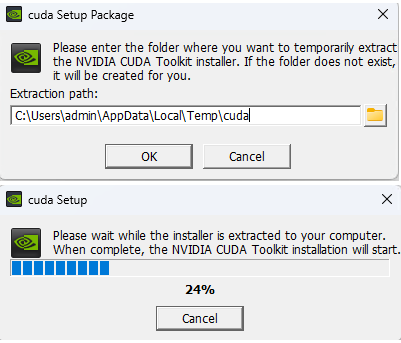

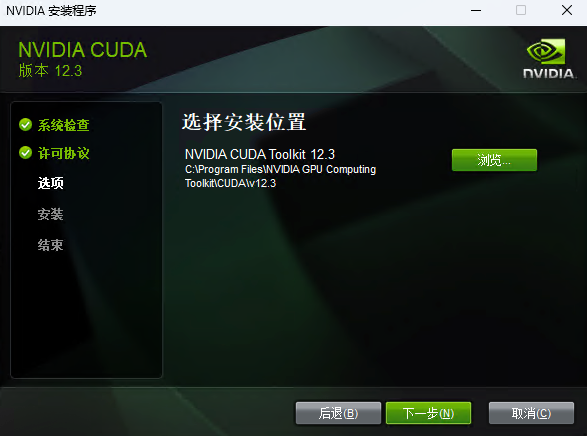

安装cuda时,第一次会让设置临时解压目录,第二次会让设置安装目录;

临时解压路径,建议默认即可,也可以自定义。安装结束后,临时解压文件夹会自动删除;

安装目录,建议默认即可;

注意:临时解压目录千万不要和cuda的安装路径设置成一样的,否则安装结束,会找不到安装目录的!!!

1)选择自定义安装

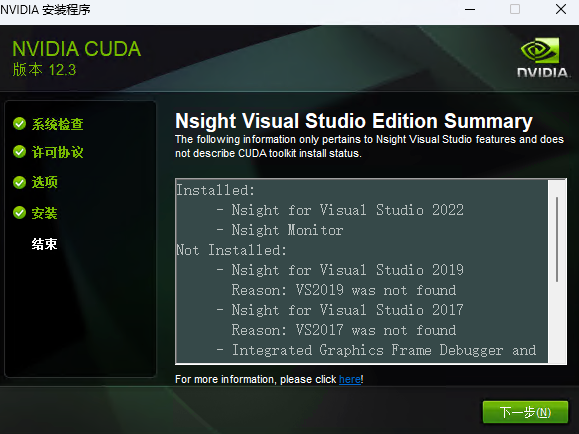

2)安装完成后,配置cuda的环境变量;

3)命令行中,测试是否安装成功;

双击“exe文件”,选择下载路径(推荐默认路径)

同意并继续

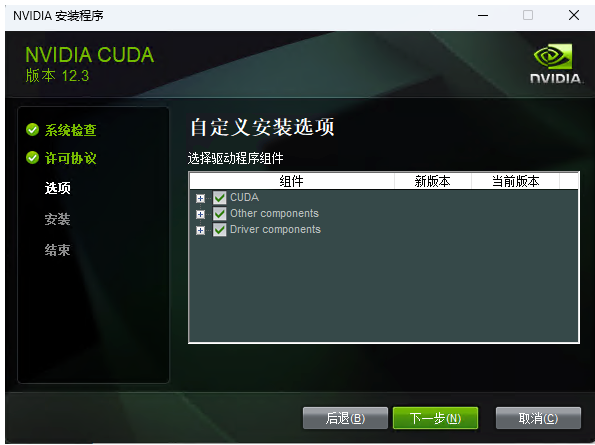

自定义安装,精简版本是下载好所有组件,并且会覆盖原有驱动,所以在这里推荐自定义下载

如果你是第一次安装,尽量全选如果你是第n次安装,尽量只选择第一个,不然会出现错误

点击下一步即可

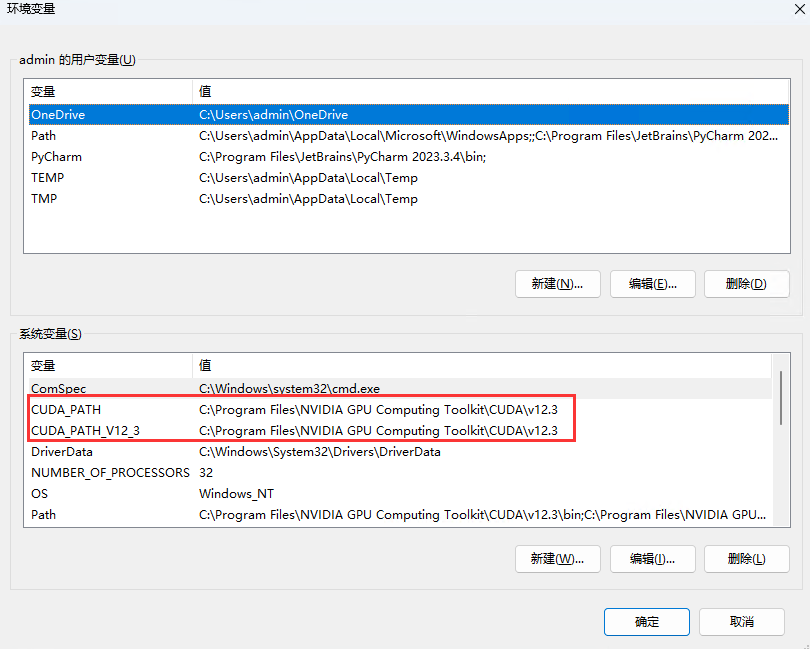

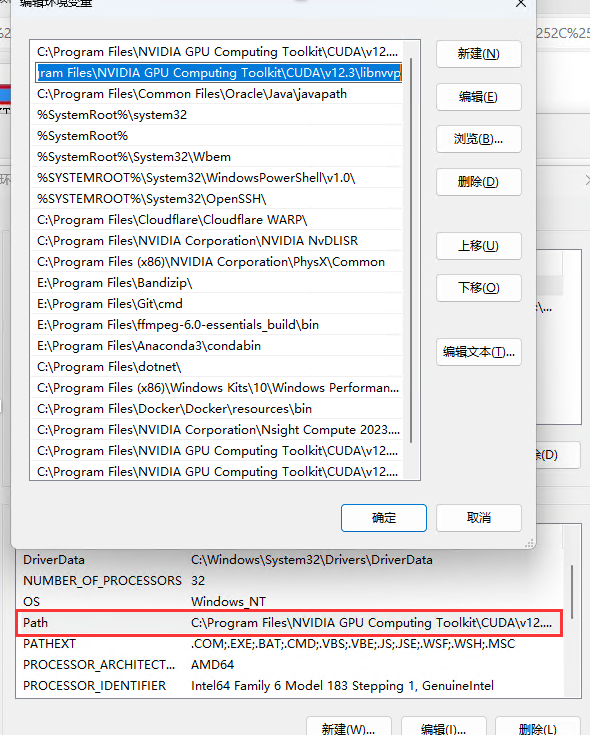

查看环境变量

点击设置-->搜索高级系统设置-->查看环境变量

如果没有需要自己添加

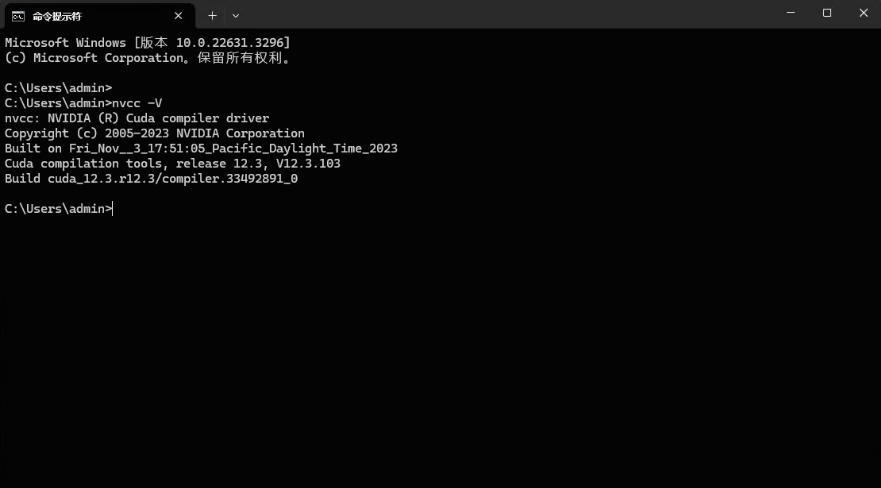

验证是否安装成功

nvcc -V

2.下载并安装cuDNN

1.cuDNN下载

cuDNN下载地址: https://developer.nvidia.com/rdp/cudnn-download(需要注册账号)

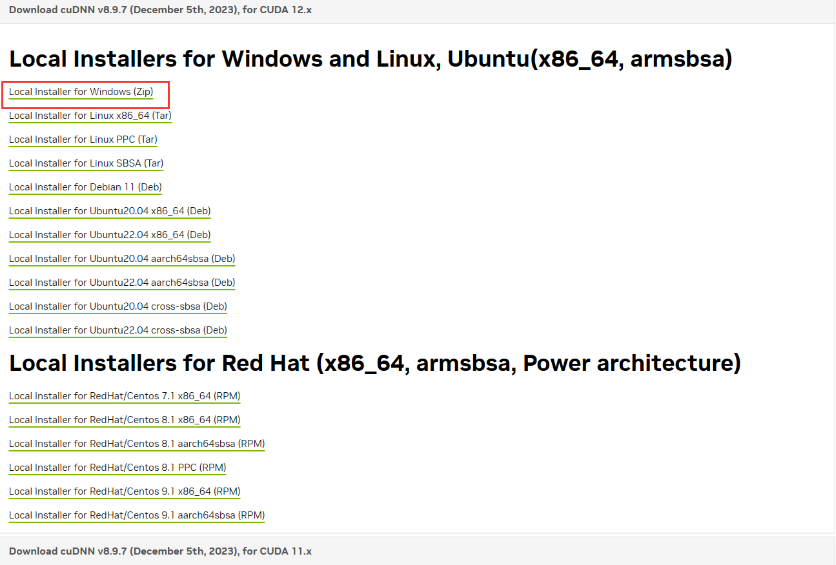

查看与CUDA适配的版本 cuDNN Archive | NVIDIA Developer根据CUDA版本选择cuDNN

2.cuDNN配置

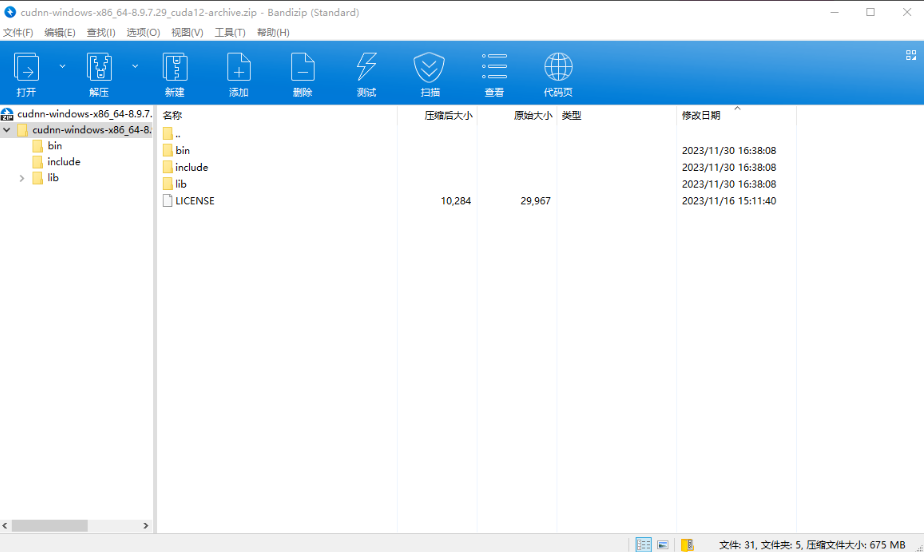

·

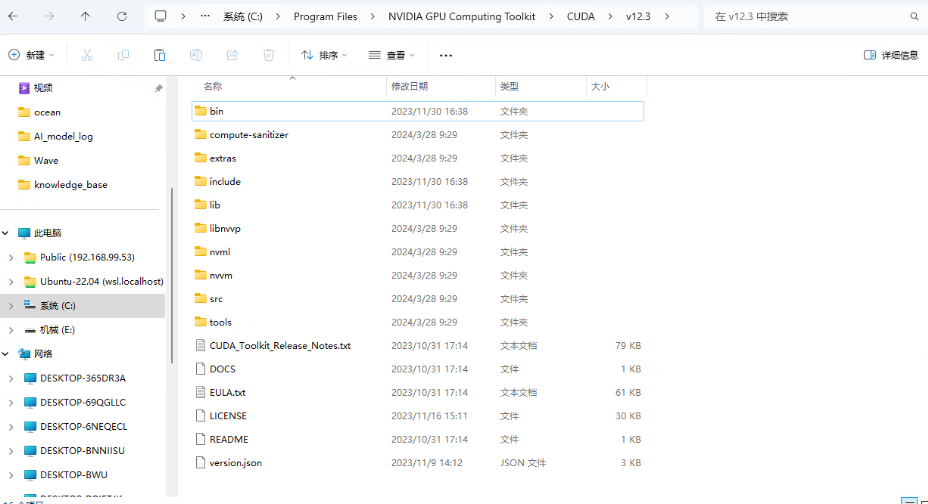

解压到CUDA的安装目录内

添加环境变量

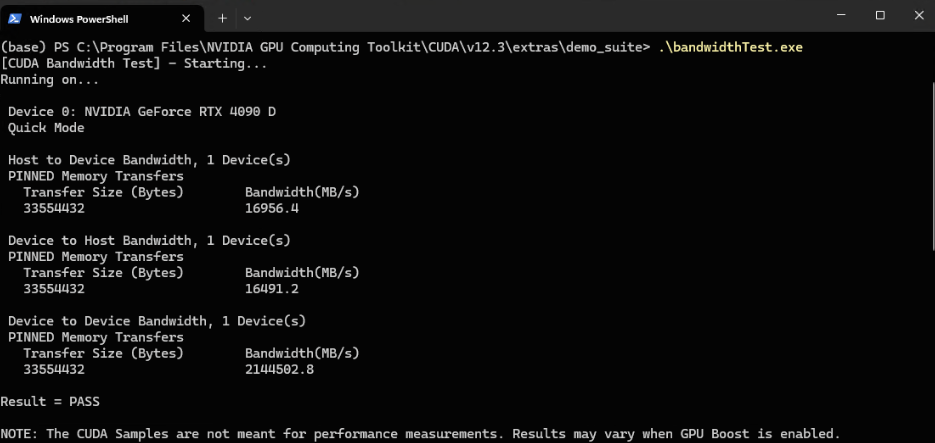

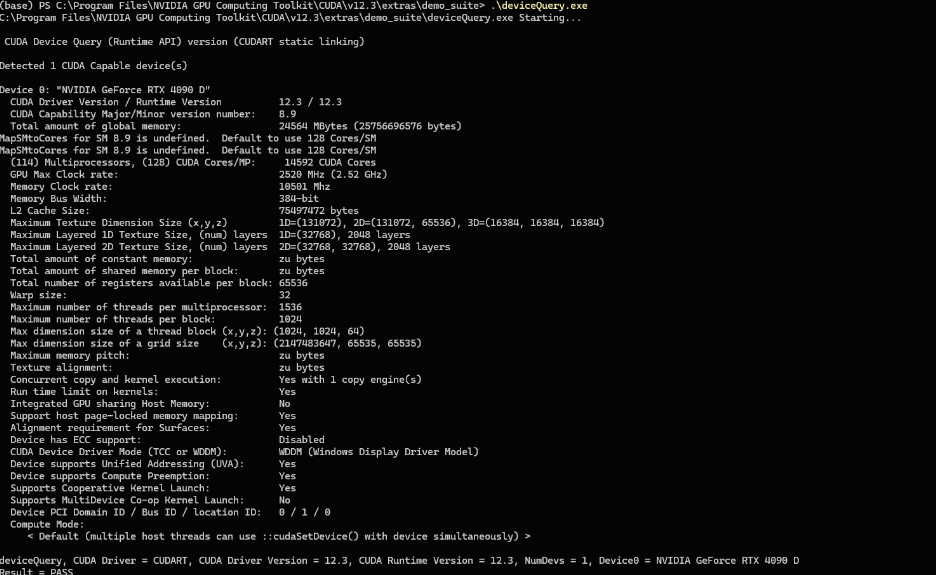

配置完成后,验证是否配置成功,主要使用CUDA内置的deviceQuery.exe 和 bandwidthTest.exe

首先win+R启动cmd,cd到安装目录下的 …\extras\demo_suite,然后分别执行bandwidthTest.exe和deviceQuery.exe(进到目录后需要直接输“bandwidthTest.exe”和“deviceQuery.exe”),应该得到下图:

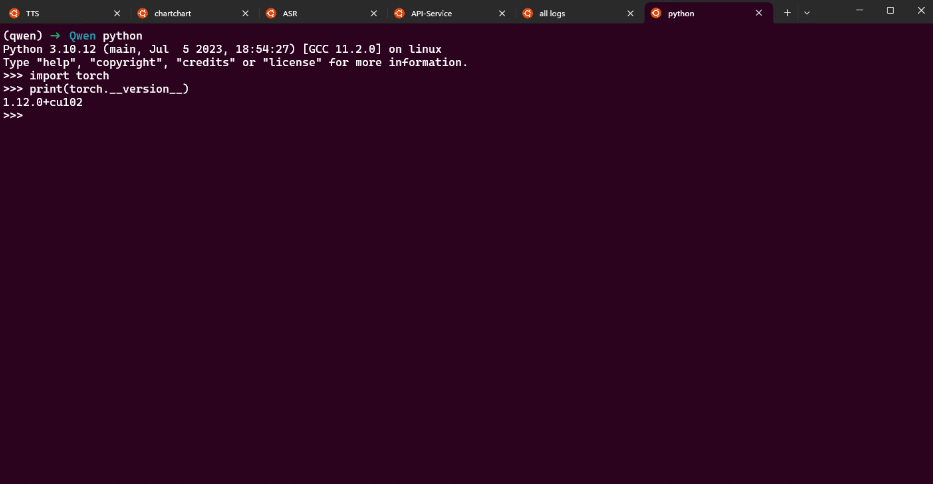

2.创建虚拟环境

3.安装依赖

4.初始化

5.启动

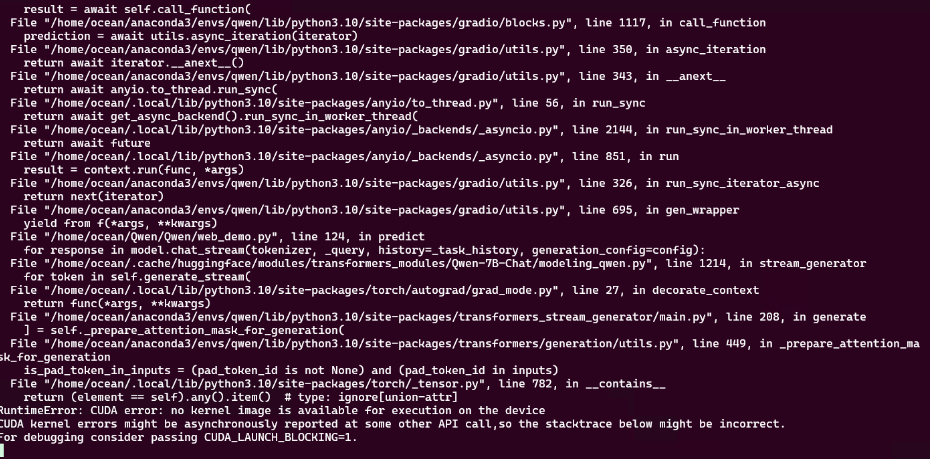

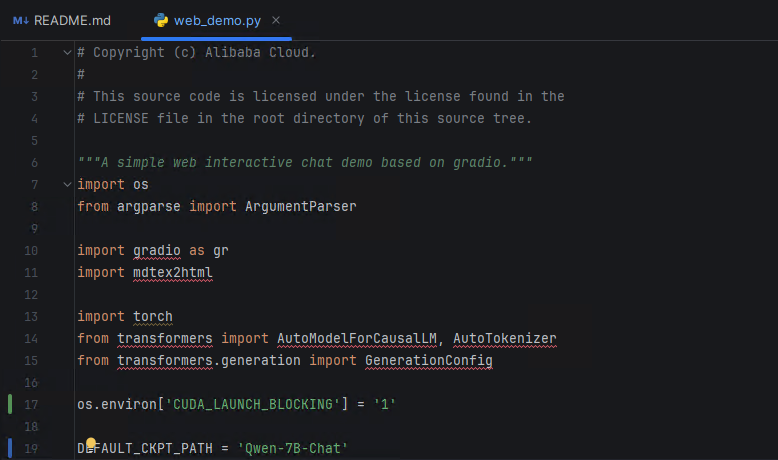

如果出现CUDA错误,修改 web_demo.py

2696

2696

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?