简介:本项目展示了如何使用条件生成对抗网络(CGAN)在CIFAR数据集上生成高真实性图像。CGAN作为GAN的变种,增加了条件信息(如类别标签)以引导生成过程,提高了生成图像的质量与多样性。通过该项目,开发者可以深入理解CGAN的工作原理,掌握从架构设计到训练优化的整个流程,并通过实际操作提高模型的泛化能力。

1. 条件生成对抗网络(CGAN)简介

生成对抗网络(GAN)作为深度学习领域的一个里程碑技术,已经广泛应用于图像、视频、音频等多种媒体的生成。条件生成对抗网络(CGAN)在此基础上加入了条件信息,使得生成结果更加可控。本章首先介绍CGAN的基本概念,并分析其工作原理,为后续章节内容打下理论基础。

1.1 生成对抗网络的起源与发展

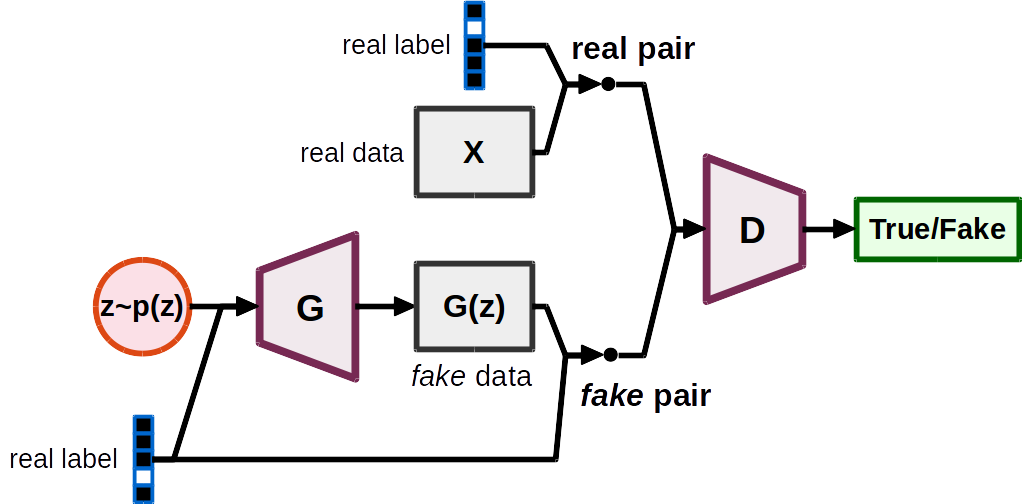

GAN由Ian Goodfellow等人于2014年提出,由一个生成器(Generator)和一个判别器(Discriminator)组成,这两个网络相互竞争,生成器生成假数据,判别器区分真假数据。随着研究的深入,GAN家族不断壮大,CGAN就是其中一种变体,它在原始GAN框架中引入了额外的条件信息,实现了在特定条件约束下的数据生成。

1.2 条件生成对抗网络的工作原理

CGAN在标准GAN的基础上,通过将标签或条件信息作为生成器和判别器的输入之一,使得生成结果能够根据指定的条件信息具有一定的指导性。例如,在生成人脸图片时,可以指定性别、表情等条件,生成器将根据这些条件信息生成符合要求的图像,而判别器则需要判断图像是否真实且满足给定的条件。

1.3 CGAN的应用前景与挑战

CGAN因其强大的生成能力和条件控制特性,在多个领域展示出巨大的应用潜力,如艺术创作、数据增强、隐私保护等。然而,它也面临一些挑战,包括训练难度大、模式崩溃、难以评估生成质量等问题。后续章节将逐步探讨这些问题,并提供解决方案。

2. CIFAR数据集介绍与数据预处理

2.1 CIFAR数据集概述

2.1.1 数据集的来源和特点

CIFAR数据集全称为加拿大高级研究所(Canadian Institute For Advanced Research)的数据集,它由Alex Krizhevsky、Vinod Nair和Geoffrey Hinton收集整理。这个数据集是计算机视觉和机器学习领域中使用最广泛的数据集之一,主要用于图像识别和分类任务。它分为两个版本,分别是CIFAR-10和CIFAR-100。CIFAR-10包含10个类别的60000张32x32彩色图像,每类有6000张图像;而CIFAR-100则是CIFAR-10的扩展,包含了100个类别,每类有600张图像。

CIFAR数据集的特点在于其规模适中、标签清晰,且包含多样的类别,能够训练和测试算法在真实世界场景下识别不同对象的能力。此外,由于图像尺寸较小,它便于快速实现算法原型,同时作为深度学习模型训练的入门级数据集被广泛采用。

2.1.2 数据集的分类和应用场景

CIFAR-10和CIFAR-100数据集中的图像被分为多个类别,CIFAR-10包括了诸如飞机、汽车、鸟、猫、鹿、狗、青蛙、马、船和卡车等日常物体;而CIFAR-100则在10个大类的基础上进一步细化到100个更具体的类别,比如“甜菜根”、“水母”、“台灯”等。

该数据集被广泛应用于图像识别、图像分类、特征学习、迁移学习、卷积神经网络(CNN)的验证和训练等研究领域。由于其包含的类别多,它也常用于多标签分类和细粒度分类的研究。

2.2 数据预处理技术

2.2.1 数据归一化与标准化

数据预处理是机器学习和深度学习中的重要步骤,它可以提高模型的收敛速度和准确度。在CIFAR数据集上进行预处理的一个关键步骤是进行数据归一化与标准化。归一化通常指的是将数据缩放到0和1之间,以消除不同特征之间的量纲影响;而标准化则指的是将数据转换成均值为0,标准差为1的分布,使得数据具有单位方差。

在图像处理中,归一化可以通过以下公式实现: [x_{\text{norm}} = \frac{x - x_{\text{min}}}{x_{\text{max}} - x_{\text{min}}}]

标准化则是: [\mu = \frac{1}{N}\sum_{i=1}^{N}x_i] [\sigma = \sqrt{\frac{1}{N}\sum_{i=1}^{N}(x_i - \mu)^2}] [x_{\text{norm}} = \frac{x_i - \mu}{\sigma}]

其中,(x_i) 是图像的像素值,(x_{\text{min}}) 和 (x_{\text{max}}) 分别是图像中的最小值和最大值,(\mu) 和 (\sigma) 分别是数据集的均值和标准差。

2.2.2 数据增强方法

数据增强是一种通过人为地增加数据集的多样性的方法,可以减少模型过拟合并提高模型泛化能力。对于图像数据,常见的数据增强方法包括随机裁剪、旋转、缩放、水平或垂直翻转等。在CIFAR数据集上,可以使用这些方法来增加数据的多样性,提高模型对于不同图像变换的鲁棒性。

例如,随机水平翻转可以通过以下方式实现:

import torch torchvision.transforms as transforms

transform = ***pose([

transforms.RandomHorizontalFlip(), # 随机水平翻转

# 其他数据增强操作

])

使用数据增强后,模型在训练过程中能够接触到更多的图像变化,这样有助于减少过拟合的风险,使模型在真实世界的应用中表现得更好。

2.3 数据集的分割与加载

2.3.1 训练集、验证集和测试集的划分

为了有效地评估模型在未知数据上的性能,需要将数据集分割为训练集、验证集和测试集。通常的划分比例是70%的训练数据、15%的验证数据和15%的测试数据。在使用Keras等深度学习库时,可以简单地用一行代码来完成这一过程:

from sklearn.model_selection import train_test_split

# 假设X是图像数据,y是标签

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

X_train, X_val, y_train, y_val = train_test_split(X_train, y_train, test_size=0.***, random_state=42)

2.3.2 数据加载器的构建

构建高效的数据加载器是加快训练过程的关键。在PyTorch中,可以使用 DataLoader 类来创建一个可迭代的批数据加载器,这对于大数据集来说尤其重要,因为它可以边训练边加载数据,避免内存溢出。

from torch.utils.data import DataLoader

train_data = MyDataset(X_train, y_train) # MyDataset是自定义的数据集类

val_data = MyDataset(X_val, y_val)

test_data = MyDataset(X_test, y_test)

train_loader = DataLoader(train_data, batch_size=64, shuffle=True)

val_loader = DataLoader(val_data, batch_size=64, shuffle=False)

test_loader = DataLoader(test_data, batch_size=64, shuffle=False)

在上面的代码中, batch_size 指定了每个批次加载多少个样本, shuffle=True 表示在每个epoch结束时重新洗牌。数据加载器会自动处理数据的批处理和洗牌,大大提高了训练效率。

接下来,我们将详细探讨CGAN模型架构的设计以及如何实现训练过程。

3. CGAN模型架构设计与训练过程实现

在研究CGAN模型时,架构设计和训练过程的实现是核心话题之一。模型的设计决定了生成数据的质量和多样性,而训练过程则关系到模型性能的优化和最终效果的达成。本章节将深入探讨CGAN模型架构设计的关键要素,以及如何在训练过程中有效地实现模型的优化与监控。

3.1 CGAN模型架构设计

3.1.1 CGAN的基本结构和组成

CGAN(条件生成对抗网络)是在传统GAN的基础上增加了条件信息,以此来控制生成数据的类型。基本的CGAN架构由两部分组成:生成器(Generator)和判别器(Discriminator)。生成器负责根据输入的噪声向量和条件信息生成目标数据。而判别器则尝试区分真实数据和生成数据,以此来为生成器提供学习的反馈。在CGAN中,判别器同时接收生成数据、噪声向量和条件信息作为输入,以判断数据的真实性。

3.1.2 生成器和判别器的设计原则

在设计生成器时,需要考虑如何有效地将条件信息融合到生成的数据中。这通常涉及到深度网络中信息的编码和解码。设计原则之一是保证生成器的网络结构能够足够捕捉到条件信息的特征,并且能够将这些特征映射到数据空间中去。另一个重要原则是保持生成器的灵活性,使其能够从噪声中生成多样的数据样本。

判别器的设计则需要能够对数据的真实性和条件信息的准确性进行有效判断。它不仅需要识别出数据是否来自于真实分布,还需要能够判断给出的条件信息是否与数据匹配。设计判别器时,常用的技术包括深度卷积网络,它们在视觉任务中表现出色。

3.2 训练过程中的关键要素

3.2.1 损失函数的选择与应用

CGAN的训练是一个极小极大游戏(minimax game),其中损失函数扮演了至关重要的角色。对于生成器,常用的损失函数是交叉熵损失(Cross-Entropy Loss),它鼓励生成器产生的数据被判别器判定为真实数据。对于判别器,损失函数需要能够准确地反映真实数据与生成数据之间的差异。损失函数的选择直接影响到训练过程的稳定性和生成数据的质量。

3.2.2 优化器的选择与调整

在训练CGAN时,选择一个适当的优化器同样重要。优化器负责更新网络参数以最小化损失函数。常用的优化器包括SGD、Adam和RMSprop。Adam优化器结合了RMSprop和Momentum的优点,能够自适应地调整学习率,因此在许多情况下是不错的选择。调整优化器的超参数,如学习率和动量,对于训练过程的稳定性至关重要。

3.3 训练策略与技巧

3.3.1 训练过程的监控与日志记录

在训练CGAN时,实时监控和记录训练过程是发现问题和优化模型的关键。监控的指标可能包括生成器和判别器的损失值、生成数据的质量评估以及训练进度等。通过记录这些信息,可以更容易地发现训练中的异常情况并及时调整策略。例如,如果发现生成器的损失值始终很高,可能意味着生成器的网络结构不足以捕捉数据的复杂性,或者训练过程中的优化策略需要调整。

3.3.2 避免过拟合与正则化技术

过拟合是深度学习模型训练中常见的问题,它意味着模型在训练数据上表现良好,但在未见过的数据上表现不佳。为避免过拟合,可以采取多种正则化技术,如Dropout、权重衰减(L2正则化)和数据增强等。这些技术可以增加模型的泛化能力,使模型在新的数据上也能有良好的性能。在CGAN中,这些技术同样适用。例如,可以在训练判别器时使用Dropout来防止过拟合。

总结

本章节深入探讨了CGAN模型的架构设计和训练实现,从基本的结构组成到具体的训练策略和技术。作为生成对抗网络的一个重要分支,CGAN通过引入条件信息,增强了模型在特定任务上的应用能力。设计和训练CGAN模型需要精细的考量和权衡,包括损失函数和优化器的选择,以及监控策略和正则化技术的应用。接下来的章节将详细介绍如何将条件信息嵌入到模型中,并探讨如何通过可视化技术评估生成图像的质量。

4. 条件信息嵌入与图像生成的可视化评估

4.1 条件信息嵌入方法

4.1.1 条件信息的编码方式

在条件生成对抗网络(CGAN)中,条件信息的编码是至关重要的。通常,这些信息可以是类别标签、图像属性或任何其他可以用来指导生成过程的信号。例如,在图像到图像的转换任务中,条件信息可能是某个特定的图像风格标签。

条件信息的编码方式通常分为两类:独热编码(One-Hot Encoding)和嵌入编码(Embedding Encoding)。独热编码适用于类别数量较少且不连续的情况,例如图像分类标签。而在面对连续或类别较多的情况时,嵌入编码更为合适。嵌入编码通过训练一个嵌入层来将每个类别转换成一个连续空间中的向量,使模型能够学习到类别间的相似性。

# 示例代码:使用独热编码作为条件信息

import tensorflow as tf

# 假设我们有一个类别标签

category_label = tf.constant([1]) # 类别0至9

# 使用tf.one_hot函数进行独热编码

one_hot_encoded = tf.one_hot(category_label, depth=10)

# 输出独热编码结果

print(one_hot_encoded)

在这个例子中,我们创建了一个常量 category_label 作为类别标签,并使用 tf.one_hot 函数将其转换为独热编码的形式。对于嵌入编码,通常需要在模型训练过程中对嵌入层进行学习。

4.1.2 条件信息与模型的结合

条件信息需要与CGAN中的生成器和判别器进行有效的结合。在生成器中,条件信息可以被直接输入到网络中,或者通过条件批归一化(Conditional Batch Normalization)技术间接地影响生成过程。而在判别器中,条件信息则用来判断生成的图像是否满足给定的条件。

为了将条件信息与模型结合,我们通常使用一个共享的网络部分来处理输入的噪声和条件信息,然后再通过不同的网络层分别对噪声和条件信息进行进一步的特征提取。

# 示例代码:在生成器中结合条件信息

import tensorflow as tf

# 假设noise为随机噪声,condition为条件信息

noise = tf.random.normal([1, 100]) # 随机噪声向量

condition = tf.one_hot(category_label, depth=10) # 类别标签的独热编码

# 定义生成器网络结构

def generator(noise, condition):

# 将噪声和条件信息拼接

input = tf.concat([noise, condition], axis=-1)

# 经过网络层处理

x = tf.keras.layers.Dense(128, activation='relu')(input)

x = tf.keras.layers.Dense(256, activation='relu')(x)

generated_image = tf.keras.layers.Dense(784, activation='sigmoid')(x) # 生成784维数据,对应28x28的图像

return generated_image

# 调用生成器函数

generated_image = generator(noise, condition)

在这个示例中,我们定义了一个简单的生成器网络结构,该结构将噪声和条件信息的独热编码进行拼接,并通过一系列全连接层来生成图像。通过这种方式,模型能够学习到如何根据条件信息生成对应的图像。

4.2 图像生成的可视化技术

4.2.1 可视化工具和方法

在进行CGAN图像生成的可视化评估时,我们通常会使用一些可视化工具来展示生成图像样本,并对比真实图像。常用工具包括matplotlib、seaborn等Python库,这些工具可以生成图像的散点图、直方图和热力图等,用以展示数据的分布和特性。

在某些情况下,我们还会用到专门的可视化库,如TensorBoard,这是TensorFlow自带的可视化工具,可以帮助我们更好地监控训练过程,例如损失曲线、权重分布和生成图像的实时更新。

# 示例代码:使用matplotlib进行图像生成的可视化展示

import matplotlib.pyplot as plt

import numpy as np

# 假设我们有生成的图像样本和真实的图像样本

generated_images = np.random.rand(5, 28, 28, 1) # 生成的图像样本(5张28x28图像)

true_images = np.random.rand(5, 28, 28, 1) # 真实的图像样本

# 创建一个子图,展示生成的图像和真实的图像对比

fig, axs = plt.subplots(1, 2, figsize=(10, 5))

# 展示生成的图像样本

axs[0].imshow(np.squeeze(generated_images[0]), cmap='gray')

axs[0].set_title('Generated Image')

# 展示真实的图像样本

axs[1].imshow(np.squeeze(true_images[0]), cmap='gray')

axs[1].set_title('True Image')

plt.show()

这段代码使用matplotlib绘制了生成图像和真实图像的对比图。通过这种对比,我们可以直观地评估CGAN生成图像的质量和真实性。

4.3 图像生成质量评估

4.3.1 定量评估指标与方法

图像生成质量的定量评估通常依赖于一系列指标,如Inception Score(IS)、Fréchet Inception Distance(FID)等。IS通过评估生成图像与真实图像分布的多样性和质量,来量化生成图像的质量;而FID则是通过计算生成图像和真实图像在Inception模型特征空间中的分布差异来进行评估。

计算FID的Python代码示例如下:

import numpy as np

from scipy.linalg import sqrtm

# 假设我们有真实图像特征和生成图像特征

real_features = np.random.rand(100, 2048) # 100张真实图像的特征

fake_features = np.random.rand(100, 2048) # 100张生成图像的特征

# 计算协方差矩阵

real_cov = np.cov(real_features, rowvar=False)

fake_cov = np.cov(fake_features, rowvar=False)

# 计算均值向量

real_mean = np.mean(real_features, axis=0)

fake_mean = np.mean(fake_features, axis=0)

# 计算FID

fid_value = np.real(sqrtm((real_mean - fake_mean).dot((real_mean - fake_mean).T), real_cov.dot(fake_cov)))

print("FID:", fid_value)

在这段代码中,我们首先假设了真实图像特征和生成图像特征,然后分别计算它们的协方差矩阵和均值向量。最后,使用 sqrtm 函数计算FID值,以评估生成图像的质量。

4.3.2 定性评估标准与案例分析

除了定量评估指标,定性评估也是图像生成质量评估的重要方面。定性评估依赖于专家的经验和用户的反馈,通过主观判断来评估图像的真实性、多样性和有用性。通常,定性评估会通过问卷调查或用户测试的方式进行。

案例分析法则是通过具体案例来展示CGAN在实际应用中的表现。例如,可以展示CGAN在进行图像转换时的具体效果,以及它在艺术风格转换或图像修复上的实际表现。这可以通过选择一组输入和输出图像样本,结合应用场景和专家意见来进行深入分析。

在实际操作中,定性评估往往涉及到更多的人为因素,因此也需要更加谨慎地设计评估流程,以确保评估结果的公正性和准确性。

通过结合定量和定性评估,我们可以获得一个关于CGAN图像生成质量的全面评价,从而为模型优化提供依据。

5. CGAN在图像生成中的应用实践

在CGAN的发展过程中,我们看到了它在图像生成领域的广泛应用以及对优化策略的不断探索。本章将重点探讨CGAN在实际应用中的场景分析,并且讨论如何优化CGAN模型以及它未来的发展趋势与挑战。

5.1 CGAN在图像生成中的应用场景分析

CGAN不仅提供了一种新的图像生成方式,其在多个领域的应用也开辟了新的可能性。下面将通过两个具体的应用场景来展示CGAN的实用价值。

5.1.1 图像到图像的转换

CGAN的图像到图像的转换能力,使得它在图像编辑、风格转换以及医学图像处理等领域大放异彩。与传统的图像转换方法不同,CGAN可以生成更加自然和精确的结果。

一个典型的例子是将卫星图像转换成地图形式,或者将素描转换成现实主义绘画。通过训练CGAN,模型能够学习到从一种图像风格到另一种风格的映射关系,实现高质量的转换。

5.1.2 图像修复与风格迁移

另一个重要的应用场景是图像修复。在历史照片的数字化和修复工作中,CGAN能够填补图像中的缺失部分,修复破损或模糊的区域。此外,它还能进行风格迁移,将一张图像的风格应用到另一张图像上,从而产生具有艺术效果的新图像。

例如,利用CGAN可以将一张现代风格的建筑物照片转换成类似复古油画的风格,这在电影特效和游戏场景设计中非常有用。

5.2 CGAN应用的优化与改进策略

尽管CGAN在很多方面表现出了极强的能力,但实际应用过程中仍然需要进行细致的调优和优化。

5.2.1 模型的调优与参数探索

在CGAN模型的实际应用中,模型的调优通常涉及到生成器和判别器之间的平衡。参数探索和调整是提高生成图像质量和多样性的关键。

例如,可以通过改变生成器中噪声向量的维度,观察生成图像的差异,进而调整到最佳配置。除此之外,判别器的深度和宽度也是重要的可调参数,适当的调整可以避免过拟合和提高模型的泛化能力。

5.2.2 模型泛化能力的提升方法

CGAN模型的泛化能力是其在真实世界应用中能否成功的关键。为了提升模型的泛化能力,可以采取如下策略:

- 数据集扩充:通过图像合成、风格迁移等方法扩充训练数据集,增加模型对于不同场景和风格的适应性。

- 多任务学习:通过让CGAN学习多种图像转换任务,提高模型对不同任务的适应性。

- 迁移学习:利用在大规模数据集上预训练的模型作为起点,调整模型以适应新的图像生成任务。

5.3 CGAN未来的发展趋势与挑战

CGAN自从提出以来,经历了快速的发展,但其在未来的发展中仍然面临一些挑战。

5.3.1 CGAN技术的最新进展

近年来,CGAN领域的最新进展主要集中在以下几个方面:

- 结构创新:研究者们开发了诸如InfoGAN、ACGAN等CGAN的变体,以改进信息的编码和模型的稳定性。

- 多模态生成:在生成模型中融合多种类型的数据,如文本和图像的联合生成,这为复杂场景下的图像生成带来了新的可能性。

5.3.2 CGAN面临的主要挑战及其解决方案

CGAN领域目前面临的挑战包括:

- 训练稳定性:CGAN训练过程的不稳定性是影响其应用的重要因素。为解决这一问题,研究者提出了如Wasserstein损失等新的损失函数。

- 计算成本:随着生成图像质量和复杂度的提高,计算成本显著增加。轻量级模型设计和高效算法将是降低计算成本的关键。

- 法律和伦理问题:生成的图像可能被误用,造成版权侵犯、假新闻等问题。建立合适的法律框架和伦理标准是确保CGAN技术正向发展的必要条件。

通过持续的技术创新和应对挑战,我们可以期待CGAN在未来为图像生成领域带来更大的变革。

简介:本项目展示了如何使用条件生成对抗网络(CGAN)在CIFAR数据集上生成高真实性图像。CGAN作为GAN的变种,增加了条件信息(如类别标签)以引导生成过程,提高了生成图像的质量与多样性。通过该项目,开发者可以深入理解CGAN的工作原理,掌握从架构设计到训练优化的整个流程,并通过实际操作提高模型的泛化能力。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?