1.export

1> 执行导出命令

可使用-D命令自定义参数,此处限定表名、列族、开始结束RowKey、以及导出到HDFS的目录

hbase org.apache.hadoop.hbase.mapreduce.Export -D hbase.mapreduce.scan.column.family=0 -D hbase.mapreduce.scan.row.start=aaaaaaaaaaaaaaaaaaa00010078 -D hbase.mapreduce.scan.row.stop=jjjjjjjjjjjjjjjjjjj00010078 TESTA /tmp/hbase_export

可选的-D参数配置项

Usage: Export [-D ]* [ [ []] [^[regex pattern] or [Prefix] to filter]]

Note: -D properties will be applied to the conf used.

For example:

-D mapred.output.compress=true

-D mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec

-D mapred.output.compression.type=BLOCK

Additionally, the following SCAN properties can be specified

to control/limit what is exported..

-D hbase.mapreduce.scan.column.family=

-D hbase.mapreduce.include.deleted.rows=true

For performance consider the following properties:

-Dhbase.client.scanner.caching=100

-Dmapred.map.tasks.speculative.execution=false

-Dmapred.reduce.tasks.speculative.execution=false

For tables with very wide rows consider setting the batch size as below:

-Dhbase.export.scanner.batch=10

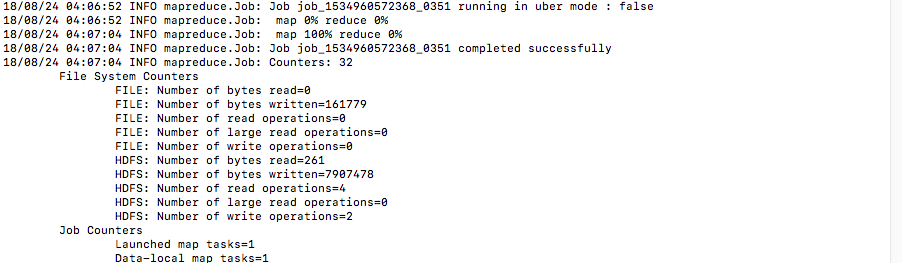

2> MR执行导出

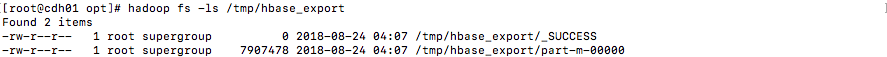

3> 查看HDFS

2.import

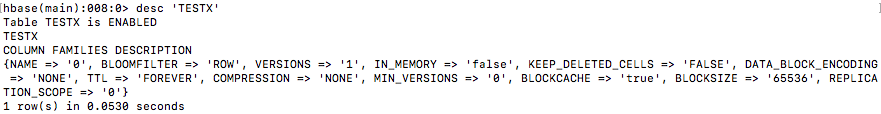

1> 预先建表

在hbase中预先建立一个名称为TESTX的表,其包含一个名称为0的列族。若表事先不存在将报错

create 'TESTX','0'

2> 运行导入命令

可使用-D命令自定义参数,此处不多做限制

hbase org.apache.hadoop.hbase.mapreduce.Import TESTX hdfs://cdh01/tmp/hbase_export/

可选的-D参数配置项

Usage: Import [options]

By default Import will load data directly into HBase. To instead generate

HFiles of data to prepare for a bulk data load, pass the option:

-Dimport.bulk.output=/path/for/output

To apply a generic org.apache.hadoop.hbase.filter.Filter to the input, use

-Dimport.filter.class=

-Dimport.filter.args=

NOTE: The filter will be applied BEFORE doing key renames via the HBASE_IMPORTER_RENAME_CFS property. Futher, filters will only use the Filter#filterRowKey(byte[] buffer, int offset, int length) method to identify whether the current row needs to be ignored completely for processing and Filter#filterKeyValue(KeyValue) method to determine if the KeyValue should be added; Filter.ReturnCode#INCLUDE and #INCLUDE_AND_NEXT_COL will be considered as including the KeyValue.

For performance consider the following options:

-Dmapred.map.tasks.speculative.execution=false

-Dmapred.reduce.tasks.speculative.execution=false

-Dimport.wal.durability=

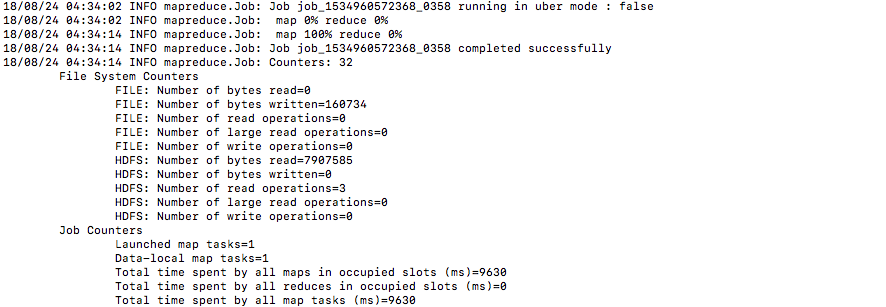

3> MR执行导入

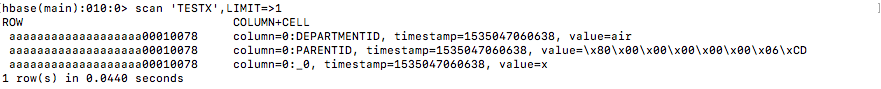

4> HBase查看导入数据

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?