如今,“神经网络”早已不是陌生词汇——手机里的人脸识别、购物软件的精准推荐、AI生成的创意图片,背后都有它的身影。作为人工智能的核心技术之一,神经网络模拟人脑神经元的连接方式处理信息,但它并非单一形态,而是一个庞大的“家族”。今天,我们就用通俗的语言拆解这个家族的分类逻辑,带你看清不同神经网络的“分工”与应用。

一、分类的核心逻辑是什么?

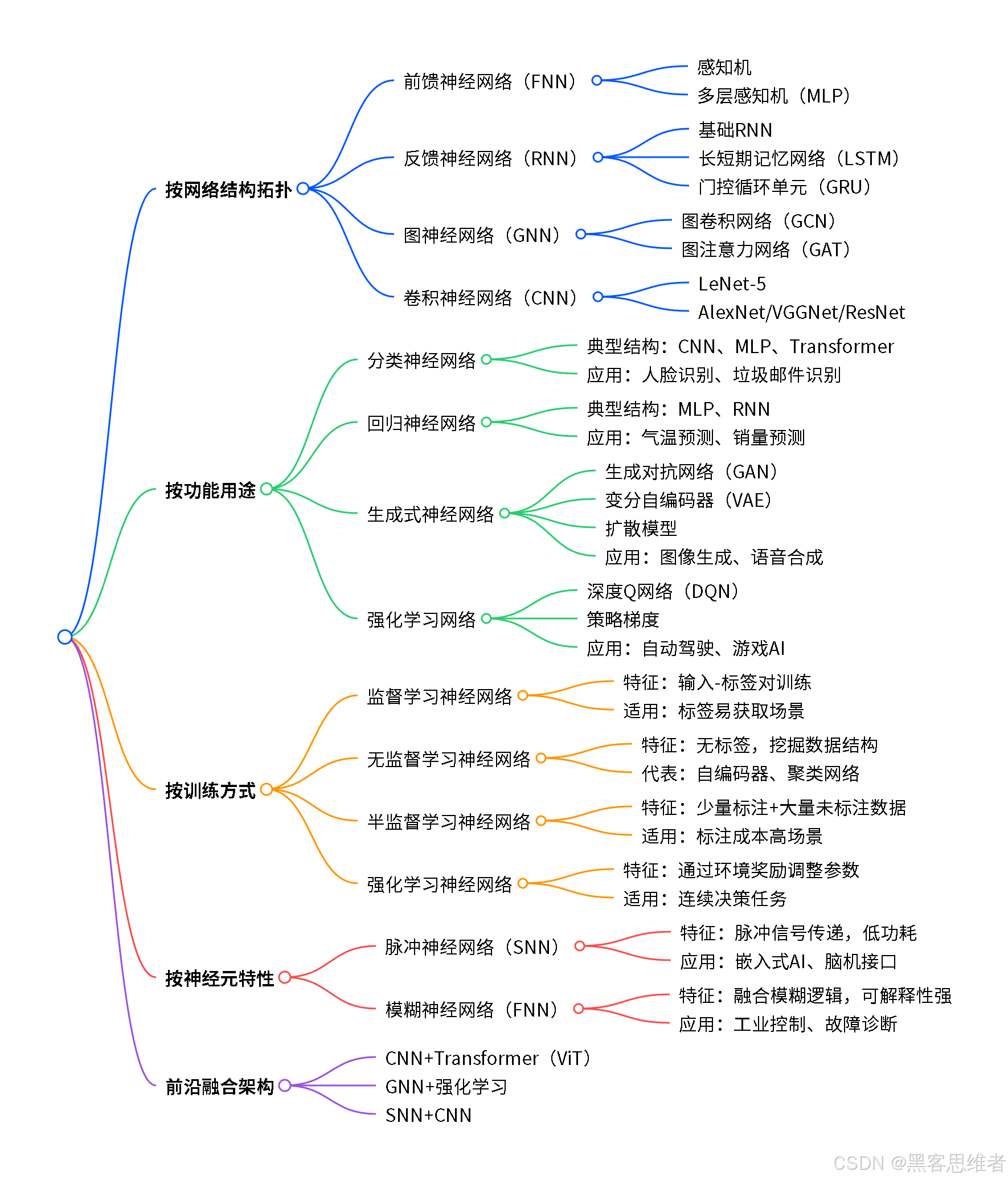

就像我们给生物分类(界、门、纲、目)有明确标准一样,神经网络的分类也有清晰维度。最核心的划分依据主要有四类:

- 网络结构拓扑(神经元怎么连接)

- 功能用途(要解决什么问题)

- 训练方式(怎么“学习”)

- 神经元特性(怎么传递信息)

不同维度的分类相互补充,能帮我们更全面地理解神经网络的应用场景。

二、按“结构”划分:神经网络的“骨架”有哪些?

结构是神经网络的基础,不同的连接方式决定了它处理信息的能力。这就像不同的建筑有不同的骨架,适配不同的使用需求。

1. 前馈神经网络FNN:信息“单向通行”的基础款

这是最基础的神经网络结构,信息只能从输入层经过隐藏层,单向传递到输出层,没有回头路。就像工厂的流水线,原料从一端进,经过多道工序后从另一端出。常见的有两种:一是“感知机”,相当于单层流水线,只能处理简单的线性问题(比如判断一个数大于还是小于5);二是“多层感知机(MLP)”,增加了多层隐藏层,能处理复杂的非线性问题(比如预测房价)。它是很多复杂神经网络的“雏形”,广泛用于简单的分类和回归任务。

2. 反馈神经网络RNN:有“记忆”的时序处理高手

和前馈网络不同,它存在“反馈连接”——神经元的输出会重新传回自己或前层神经元,就像给流水线加了一个“记忆模块”,能记住之前的信息。这让它特别擅长处理时序数据(按时间顺序排列的数据),比如语言、语音、股票走势。常见的有基础RNN、长短期记忆网络(LSTM)和门控循环单元(GRU)。其中LSTM和GRU解决了基础RNN“记不住长序列”的问题,是自然语言处理(比如语音转文字、机器翻译)的核心技术。

3. 图神经网络GNN:擅长处理“关系网”的专家

生活中很多数据是“网状结构”的,比如社交网络(人与人的连接)、分子结构(原子与原子的连接)。图神经网络就是为这类数据而生的,它能通过聚合“邻居节点”的信息,分析每个节点的特征。比如判断社交网络中两个用户是否可能成为好友,预测某类分子是否具有药用价值。常见的有图卷积网络(GCN)和图注意力网络(GAT),后者能像人一样“关注”重要的邻居节点,精度更高。

4. 卷积神经网络CNN:视觉处理的“火眼金睛”

专门为图像、视频等空间数据设计,核心优势是“高效提取空间特征”。它靠三个核心设计实现:一是“局部感受野”,只关注图像的局部区域(就像我们看书逐字逐句看,不是一眼看全页);二是“权值共享”,重复使用同一组参数,减少计算量;三是“池化操作”,压缩数据规模,保留关键信息。从早期的手写数字识别模型LeNet-5,到后来的AlexNet、ResNet,卷积神经网络一次次突破图像识别的精度极限,如今手机的人脸识别、自动驾驶的目标检测,都离不开它。

三、按“用途”划分:神经网络的“工作内容”有哪些?

如果说结构是“骨架”,用途就是神经网络的“使命”。不同的任务,对应不同的网络类型。

1. 分类神经网络:给数据“贴标签”

核心任务是把输入数据分到指定类别里,比如判断邮件是“垃圾邮件”还是“正常邮件”,识别照片里的动物是“猫”还是“狗”。前面提到的卷积神经网络(图像分类)、多层感知机(简单分类)、Transformer(文本分类)都属于这类。在医疗领域,它还能帮助医生判断肿瘤是良性还是恶性,提高诊断效率。

2. 回归神经网络:预测“连续数值”

和分类任务的“离散标签”不同,回归任务输出的是连续数值,比如预测明天的气温、下个月的销量、股票的走势。多层感知机、反馈神经网络(时序回归)是这类任务的常用模型。比如电商平台会用它预测某款商品的销量,提前做好库存准备。

3. 生成式神经网络:AI界的“创意大师”

它的核心能力是“模仿”——学习真实数据的规律,生成全新的、逼真的样本。比如根据文字描述生成图像、把文字转换成语音、给老照片上色。常见的有生成对抗网络(GAN)、变分自编码器(VAE)和扩散模型。我们熟悉的Stable Diffusion就是扩散模型的代表,能生成高质量的创意图片;GAN则常被用于数据增强,帮其他模型提升训练效果。

4. 强化学习网络:会“决策”的智能体

这类网络通过和环境交互“学习”,目标是找到最优决策策略,最大化奖励。比如自动驾驶汽车根据路况调整车速和方向,游戏AI打赢人类玩家。典型的有深度Q网络(DQN)和策略梯度,其中AlphaGo就是靠强化学习网络击败了围棋世界冠军,成为人工智能发展的重要里程碑。

四、按“训练方式”划分:神经网络怎么“学本领”?

就像人类学习有“老师教”和“自己悟”的区别,神经网络的训练方式也分不同类型,核心差异在于是否有“标签指导”。

1. 监督学习神经网络:有“老师”指导的学习

训练数据既有输入,也有对应的“正确答案”(标签),就像学生做有参考答案的练习题。网络通过对比自己的输出和正确答案,不断调整参数。前面提到的分类、回归网络大多是监督学习。这种方式的优点是学习效果稳定,缺点是需要大量标注好的数据,标注成本可能很高。

2. 无监督学习神经网络:自己“找规律”的学习

训练数据没有标签,网络全靠自己挖掘数据的内在结构,比如把相似的数据归为一类(聚类)、压缩数据保留关键信息(降维)。自编码器、聚类神经网络是这类的代表,常被用于异常检测(比如识别工业设备的故障信号)、数据压缩。它的优点是不需要标注数据,缺点是学习效果的评估相对复杂。

3. 半监督学习神经网络:“少量老师+大量自学”

结合了监督学习和无监督学习的优点:用少量标注数据做“老师指导”,再用大量未标注数据“自学”,平衡标注成本和模型性能。比如医疗影像分析中,标注一张专业的病灶影像成本很高,就可以用这种方式——少量标注影像指导,大量未标注影像辅助学习,提升诊断精度。

4. 强化学习神经网络:在“实践”中学习

没有预设的标签,网络通过和环境交互获得“奖励”或“惩罚”,不断调整策略。比如机器人尝试抓取物体,成功抓取得到奖励,失败则得到惩罚,慢慢学会最优的抓取姿势。这种方式适合连续决策任务,但训练过程相对复杂,需要设计合理的奖励机制。

五、按“神经元特性”划分:信息怎么“传递”?

神经元是神经网络的“基本单元”,不同特性的神经元,传递信息的方式也不同,这也构成了特殊的网络类型。

1. 脉冲神经网络(SNN):模仿人脑的“低功耗高手”

传统神经网络用连续数值传递信息,而脉冲神经网络模仿生物神经元的“脉冲放电”特性,用离散的脉冲信号传递信息。它的最大优点是低功耗、高鲁棒性,特别适合嵌入式设备(比如智能手表、传感器)和脑机接口(比如用意念控制假肢)。

2. 模糊神经网络(FNN):能处理“模糊信息”的专家

融合了模糊逻辑和神经网络的优点,能处理不确定、模糊的信息。比如工业生产中,“温度偏高”“压力不足”这类模糊描述,传统神经网络难以处理,而模糊神经网络能精准建模。它的可解释性比传统神经网络强,常被用于工业过程控制、故障诊断。

六、前沿趋势:不同神经网络的“融合创新”

如今,神经网络的发展趋势是“跨界融合”——把不同类型的网络优势结合起来,解决更复杂的问题。比如:

-

CNN+Transformer(ViT):把卷积神经网络的视觉特征提取能力和Transformer的全局注意力能力结合,在图像分类、目标检测任务中取得更好效果;

-

GNN+强化学习:用图神经网络处理网状结构数据,用强化学习做决策,比如优化物流路径(物流网络是网状结构,路径规划是决策任务);

-

SNN+CNN:结合脉冲神经网络的低功耗特性和CNN的视觉处理能力,面向边缘端AI芯片设计,让智能设备更节能。

总结:神经网络分类的核心价值

神经网络的分类不是“非此即彼”的划分,而是帮我们理解不同模型的适用场景——面对图像任务,优先考虑卷积神经网络;处理时序数据,反馈神经网络更合适;需要生成创意内容,就选生成式神经网络。随着技术的发展,不同类型的网络不断融合,能力也越来越强大。希望这篇文章能帮你理清神经网络的“家族关系”,下次再听到相关技术时,能快速明白它的核心作用~

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?