【搬运自同人博客】

变分自编码器Latent Loss推导blog.csdn.net

找中文资料不太好找,原论文里面有简略的推导,我稍微把论文里略过的补充了一下,对有需要的同学仅供参考。

都是从pdf截图,因为这是以前在word里写好的,就不再重写一遍了。

参考文献:Auto-Encoding Variational Bayes,authors:Diederik P Kingma, Max Welling

一、问题来源

在看Hand on ML with Sklearn and TensorFlow书,变分自编码器这一节时候,看到代码里有一个Latent Loss,细节上没有解释,我搜了很多中文资料也没找到,最后花了一些时间差不过搞清楚了,不敢保证下面的证明没有纰漏,分享给有需要的同学。

二、问题描述

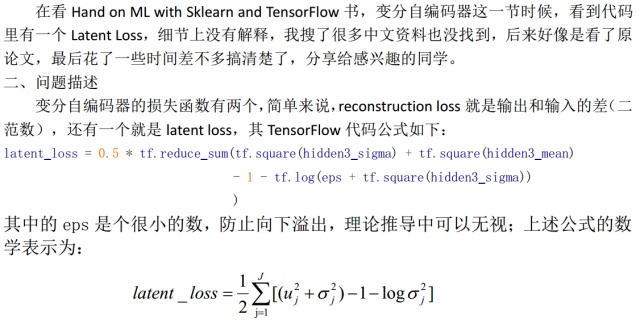

变分自编码器的损失函数有两个,简单来说,reconstruction loss就是输出和输入的重构误差(比如二范数,印象中见过其他类型的衡量标准。不过这个好理解,本文不讨论这个),还有一个就是latent loss,其TensorFlow代码公式如下:

latent_loss <

【搬运自同人博客】变分自编码器Latent Loss推导blog.csdn.net找中文资料不太好找,原论文里面有简略的推导,我稍微把论文里略过的补充了一下,对有需要的同学仅供参考。都是从pdf截图,因为这是以前在word里写好的,就不再重写一遍了。参考文献:Auto-Encoding Variational Bayes,authors:Diederik P Kingma, Max Wellin...

【搬运自同人博客】变分自编码器Latent Loss推导blog.csdn.net找中文资料不太好找,原论文里面有简略的推导,我稍微把论文里略过的补充了一下,对有需要的同学仅供参考。都是从pdf截图,因为这是以前在word里写好的,就不再重写一遍了。参考文献:Auto-Encoding Variational Bayes,authors:Diederik P Kingma, Max Wellin...

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1164

1164

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?