Softmax loss

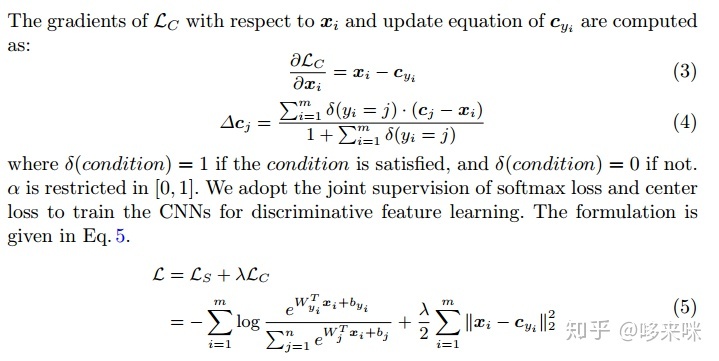

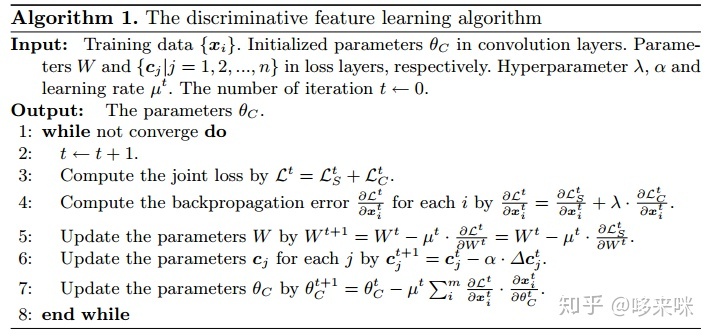

Center loss (很少用了)

核心思想:提出了center loss以最小化类内距离,与softmax loss联合训练

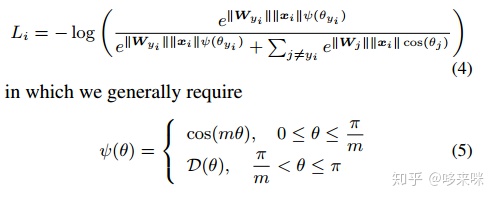

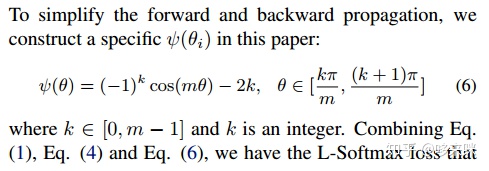

L-Softmax loss 作者:北大Weiyang Liu

Large-Margin Softmax Loss for Convolutional Neural Networksarxiv.org核心思想:我理解就是一种class-aware的softmax loss,softmax loss的值与类别相关。对不同类别的loss通过m施加margin。ψ(θ)函数的构造比较巧妙。

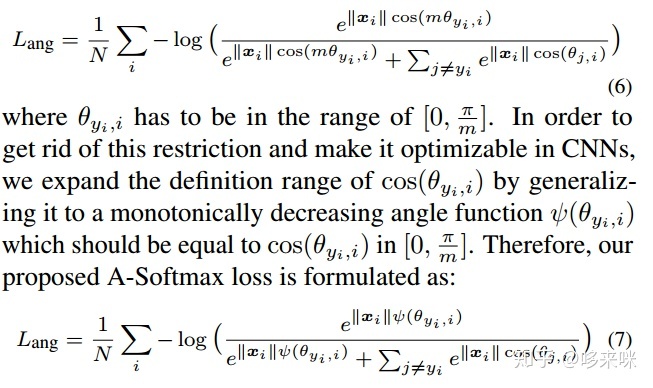

Angular Softmax(A-Softmax loss) 作者:北大Weiyang Liu

SphereFace: Deep Hypersphere Embedding for Face Recognitionarxiv.org核心思想:在L-Softmax loss的基础上将W归一化了。由于SphereFace的margin以乘积的形式施加在theta上,导致target logit curve变化比较剧烈,使训练不太稳定,

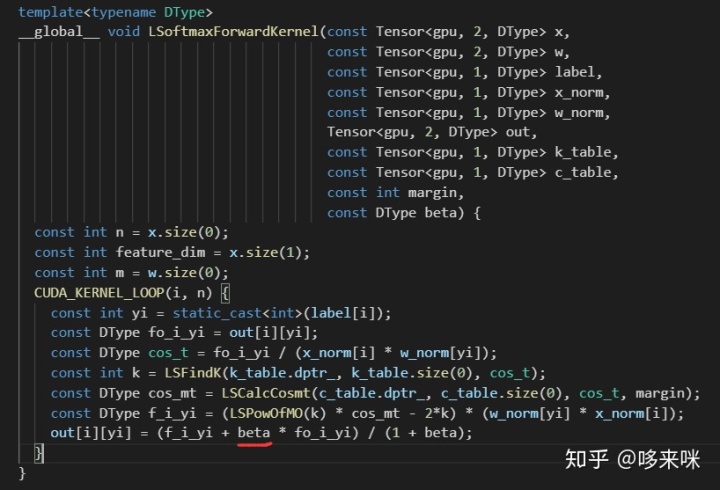

因此实际上训练时使用的hybrid loss的形式(增加了softmax loss来辅助)。如下图中截取的代码段中的beta,beta初始化为1000,训练过程逐渐衰减到不小于5。

可见beta的值其实比较大,在训练过程中事实上softmax loss domintates了。

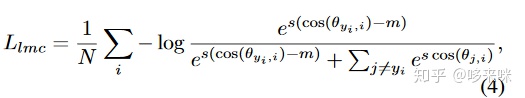

AM-Softmax loss

两篇文献几乎同时提出了AM-Softmax loss:

CosFace: Large Margin Cosine Loss for Deep Face Recognition (腾讯AI Lab的Hao Wang等CVPR2018)

Additive Margin Softmax for Face Verification (Weiyang Liu二作)

核心思想:之前L-Softmax loss和A-Softmax为了加一个margin构造分段函数的方法太复杂了,这里直接把margin加到余弦值后面。

ArcFace(的loss) 作者:伦敦帝国理工学院邓建康

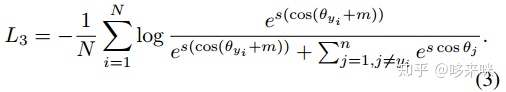

ArcFace: Additive Angular Margin Loss for Deep Face Recognitionarxiv.org核心思想:直接在角度上加margin约束

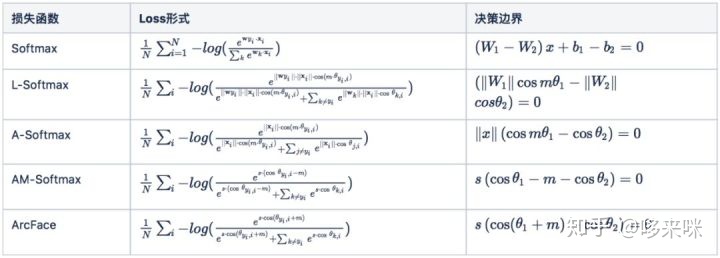

总结表格:

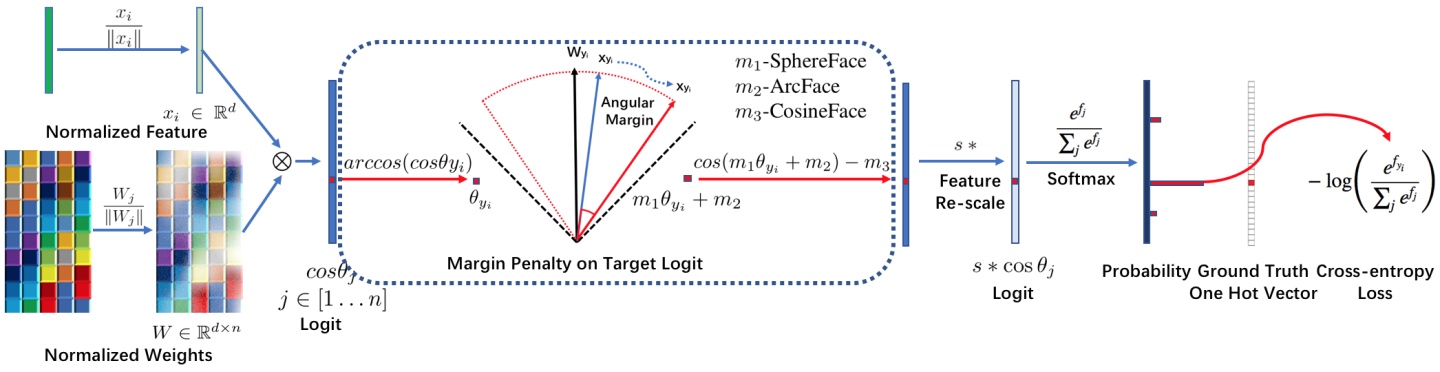

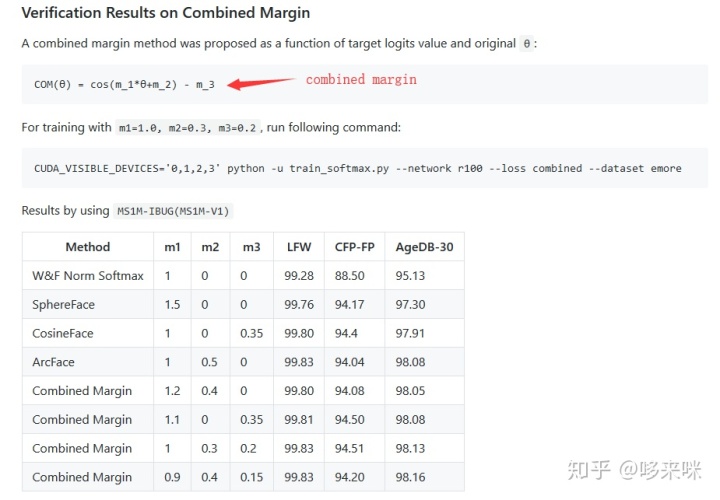

combined margin

来自arcface的开源库insightface

ref:

https://zhuanlan.zhihu.com/p/38855840

人脸识别中Softmax-based Loss的演化史

本文探讨了人脸识别中各类Softmax-based Loss函数的发展历程,包括Softmaxloss、Centerloss、L-Softmaxloss、AngularSoftmax (A-Softmaxloss)、AM-Softmaxloss及ArcFace等,并对比了它们的核心思想和技术特点。

本文探讨了人脸识别中各类Softmax-based Loss函数的发展历程,包括Softmaxloss、Centerloss、L-Softmaxloss、AngularSoftmax (A-Softmaxloss)、AM-Softmaxloss及ArcFace等,并对比了它们的核心思想和技术特点。

7380

7380

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?