逻辑回归(Logistic Regression)是机器学习最经典的方法之一,且它属于一种有监督学习(Supervised Learning)方法。它的输出为概率,并依据概率将样本归类,其中包括二分类问题与多分类问题。二分类逻辑回归模型输出一个值,该值用于表示样本属于其中一类的概率,多分类逻辑回归模型的输出结果为所有类别的概率分布。本文将分别对二分类逻辑回归模型与多分类逻辑回归进行公式推导。

1. 二分类逻辑回归 (Binary Logistic Regression)

(1) 模型介绍

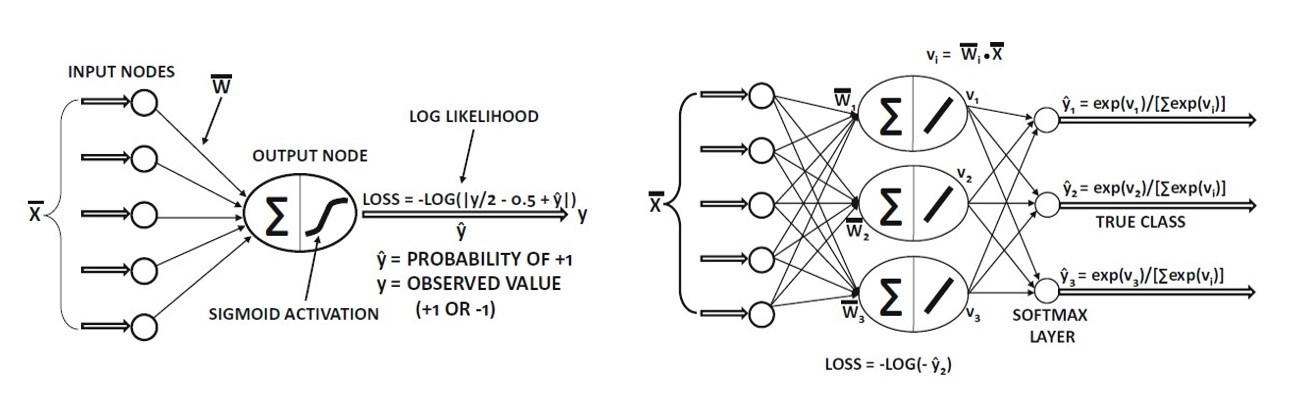

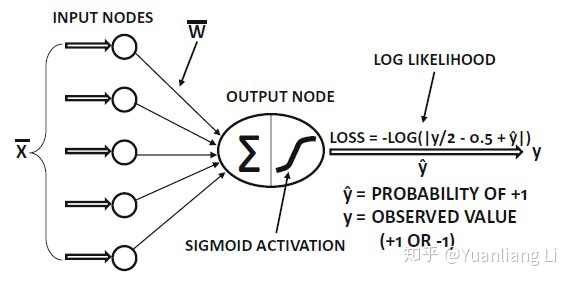

二分类逻辑回归模型的示意图如图所示,输入为特征向量,先将特征向量的各元素加权求和,然后输入Sigmoid激活函数,最后得到一个0到1之间的值,该值用于表示样本属于其中一类的概率。逻辑回归训练的过程是通过创造基于极大似然估计原理的损失函数(Loss Function),并利用梯度下降法更新模型中的权重,使得损失函数达到最小。

假设有给定

(2) 损失函数介绍

对于逻辑回归模型,我们希望找到一个权重向量

(2)中连乘符号可以通过取对数的方式变为求和符号,因此一般采用对数似然函数

这里我们添加一个负号,将原来的最大化变为最小化,因此上式(3)就是逻辑回归中需要最小化的损失函数,通过梯度下降法寻找一个

(3) 梯度下降法迭代计算权重

逻辑回归的训练过程的意图是希望得到权重向量

这里的0被加粗,表明损失函数对所有权重的导数值都为0。 显然损失函数(3)是一个较为复杂的非线性函数,我们很难采用解析的方式求得上式的解或解集,因此采用计算机比较青睐的数值求解法,及采用机器学习领域中最重要的数值求解方法之一,梯度下降法(SGradient Descent),其表达式如下

其中

因此,根据(5),得权重更新的表达式为

2. 多分类逻辑回归 (Multinomial Logistic Regression)

(1) 模型介绍

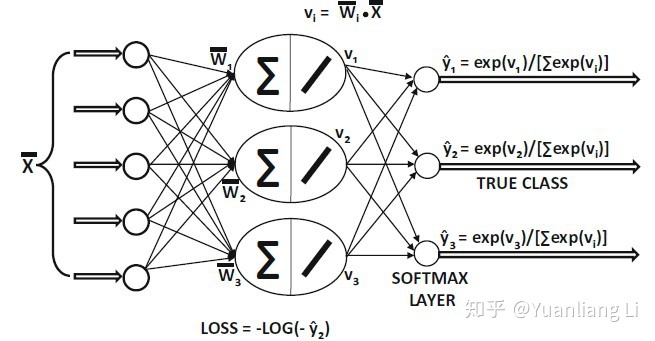

多分类逻辑回归的示意图如图所示,与二分类逻辑回归不同的是,其输出是一个概率分布,用于表示每个类别的概率;此外,多分类逻辑回归不使用Sigmoid函数作为激活函数,而是采用了Softmax函数将特征的加权求和结果映射到概率分布中。

假设有给定

通过对所有类别调用Softmax函数,可求得概率分布,并且满足

(2) 损失函数介绍

这里同样采用极大似然估计先建立似然函数表达式

接着通过取对数获得损失函数表达式

(3) 梯度下降法迭代计算权重

我们仍然采用梯度下降法来更新权重。 首先我们设

上式第二行,我们能够将

因此,权重向量

3. 小结

- 二分类逻辑回归模型的输入为特征向量,输出为0到1之间的值,用于表示该样本属于某一类的概率;多分类逻辑回归模型的输入为特征向量,输出为各个类别的概率分布。

- 二分类逻辑回归模型使用Sigmoid函数将特征向量与权重向量的向量积映射到0到1之间,而多分类逻辑回归模型则使用Softmax函数将将特征向量与权重向量的向量积映射到概率分布中。

- 不管是二分类逻辑回归还是多分类逻辑回归,都需构建一个合理的损失函数,并采用梯度下降法来更新模型参数。

参考资料

- 机器学习与深度学习

- 逻辑回归 logistics regression 公式推导

296

296

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?