深度立体匹配(deep stereo matching)算法能够取得较好的性能,一是来源于卷积神经网络强大的特征提取能力,二是得益于大规模双目仿真数据集,例如:Sceneflow [1] 是一个包含三万多对双目图像的带标签的合成数据集,Carla [2] 是一个开放的城市驾驶模拟器,可以用来生成大规模城市双目仿真数据。这些合成数据集使得深度模型能够得到充分地训练。然而,由于合成数据和真实数据存在很大的领域偏差(domain gap),在合成数据上预训练的模型在真实数据上泛化性能较差。

另一方面,真实场景下的数据往往难以获得密集且准确的标注信息。比如LiDAR等设备价格高昂,体型笨重,而且只能收集稀疏的深度信息;基于结构光的设备在室外场景难以捕捉准确的深度信息。近年来,更多的研究关注域自适应立体匹配(domain adaptation stereo matching)。希望在不获取,或者少获取真实场景标注信息的情况下,实现深度模型从仿真场景到真实场景的自适应。本文主要梳理了近两年CVPR上关于域自适应立体匹配的研究工作。

1,ZOLE

- 论文标题:Zoom and Learn: Generalizing Deep Stereo Matching to Novel Domains(CVPR 2018)

- 论文链接:Zoom and Learn: Generalizing Deep Stereo Matching to Novel Domains

Motivation

这篇论文希望通过无监督域自适应,将合成数据上训练的模型泛化到新的真实场景中,比如手机拍摄的生活环境,或者自动驾驶的城市街景。作者观察到两个现象:

- 泛化故障:合成图像上预训练的模型在真实图像上性能不好,原因在于视差图的边缘很模糊,并且在病态区域的视差估计是错误的;

- 尺度多样化:如果将一对双目图像上采样一定比例,再输入到预训练的模型中,那么预测出来的视差具有更丰富的细节信息,例如更锐化的目标边缘,更高频的场景信息。

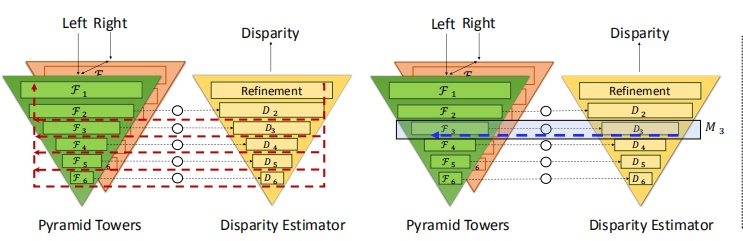

第一点观察是存在的问题,作者借鉴图论的知识,对视差图做图拉普拉斯正则化约束,采用迭代优化的策略在真实场景上进行自适应。而第二点是优势,这种精细化的视差图可以作为原尺度输入图像的视差标签,从而实现自监督学习。这实际上一种放大学习(zoom and learn),因此本文的方法被称为ZOLE。

Method

给定一个由深度网络预测的视差图D,图拉普拉斯正则化定义为:令视差图上的图像块(patch)为

那么如何从视差图上构造出这个图G呢?作者将视差图划分为M个正方形小块,并将其切片,这样每个小块

其中

其中

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

653

653

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?