最近在学习一些降维方法,想从最基本的PCA开始复习。看了西瓜书上的推导公式后,觉得跳跃性有点大,可能是我本人数学较渣,有些公式的推导总是犯迷糊。所以想着把有些关键公式的推导过程记录下来,数学大佬可以不用看这篇文章了哈,哈哈哈哈哈哈开个玩笑哈。希望这些推导过程能对同样看到这一步有疑惑的同学有帮助。当然了,如果有同样对数学感兴趣,或者就是数学专业的朋友,请一定一定私信我,我真的对数学很感兴趣,我渴望找一位志同道合的朋友沟通问题。

好了,废话不多说了,直接看公式。

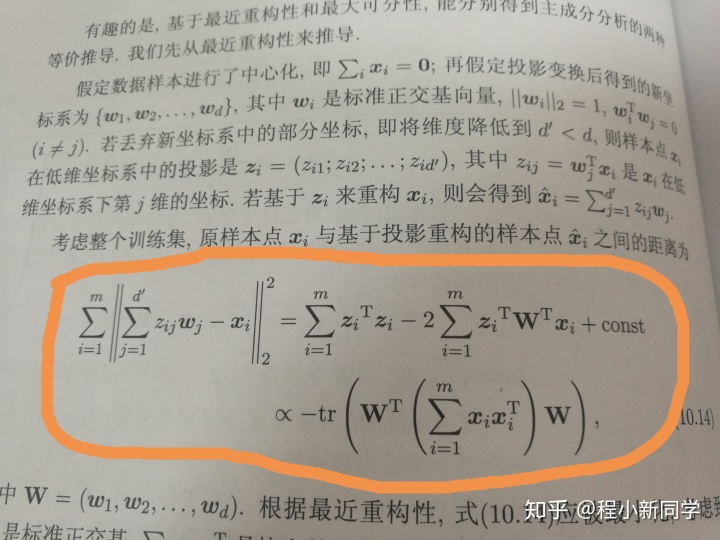

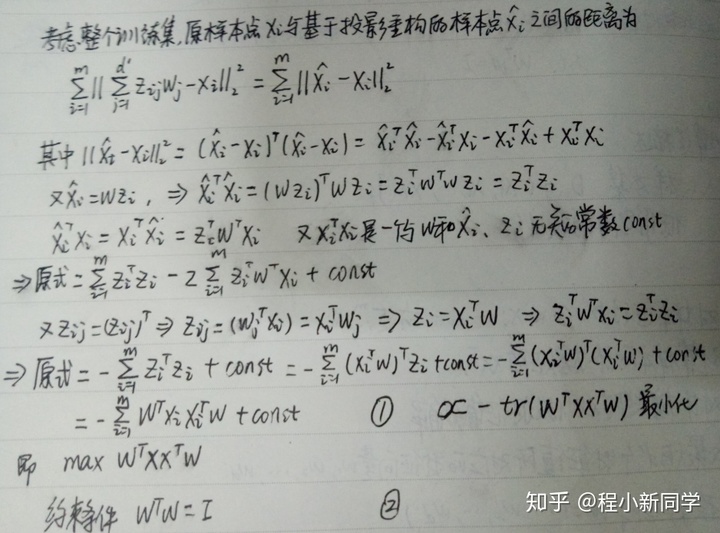

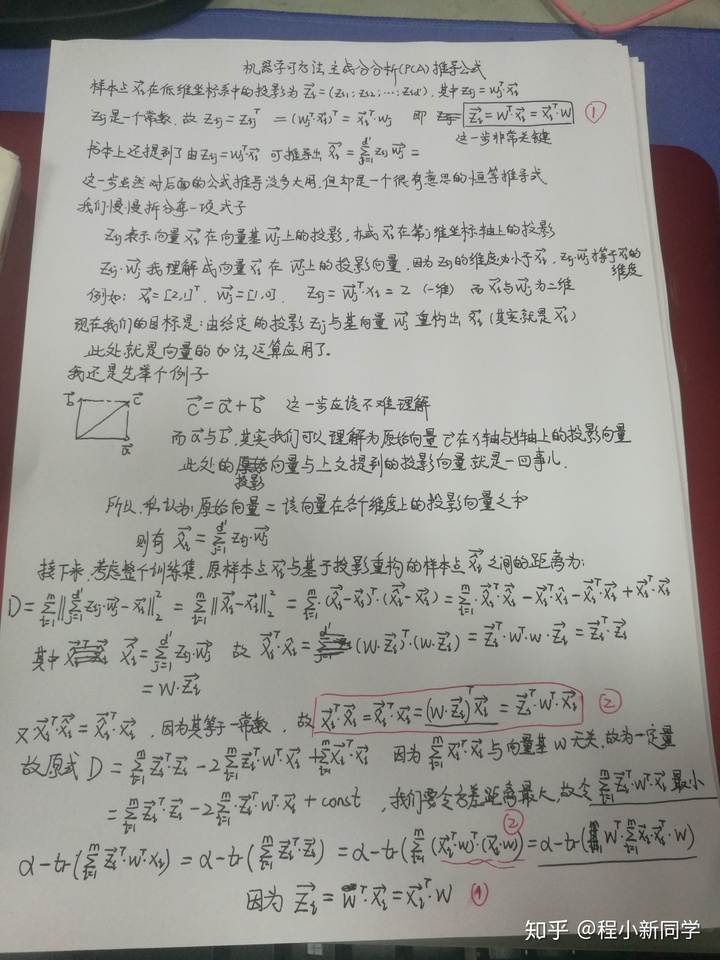

其实就是这两步,包括上面投影坐标

下面我想就两处地方做重要解释。

1 投影向量与原始向量的互相转换

上文公式有:

其中

也就有:

请各位一定要记住这个公式(2),它将会在后面的推导中发挥着重要的作用,很重要很重要。接下来我们要理解的就是如何通过投影

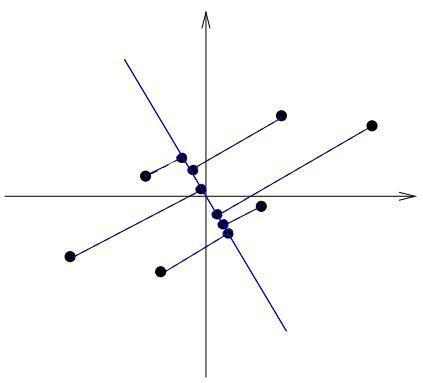

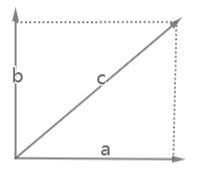

我这儿会给出两种方法来解答。首先看以下这幅图片:

这是很简单的向量加法,即:

另外一种方法是将公式(2)等式左右两边分别左乘基向量矩阵w,即:

好了,我们接着往下看。下面才是PCA方法的核心部分。PCA方法的核心是:原始样本点在一组基向量矩阵中表示的新样本应比较分散,即所有点之间的方差较大。书本上是求原始样本点

我们展开就是:

好,每一项表示出来了,我们接下来只要把这里面的四个乘法公式给转换一下结果就出来了。

计算

易知:

而

故原式可表示为:

我们要令方差最大,其实就是令D的值最大,也就是令

所以最终可以表示为:

到这一步就很舒服了,后面的求解过程就很好理解了。我们要求的就是w基向量矩阵,其实发现它就是原始样本矩阵X的特征向量组合,至于原理什么的我就不讲啦,网上很多资料,我这里推荐一位博主的文章,写的很通俗易懂啦!:)其实是我写到这儿实在是不想写啦!!!最后附上我的手稿小小沉醉一下哈哈哈哈哈哈哈。

推导过程中如果有不对的地方还望不吝指出!!!

2019/12/4 补充

书上后面还给了拉格朗日乘子法来求最大值,这一步我以为我懂了,今天在推算的时候才发现还是不懂。于是今天查阅了一些资料才终于弄懂了,此处要着重感谢Datawhale公众号整理的文章,真的很详细,太棒了的一项工作。解释一下:这个不是我的公众号哈:)

关于拉格朗日乘子法的介绍,我看到了另一篇马同学写的文章,也是写的很棒,推荐给大家看,我就不班门弄斧了。

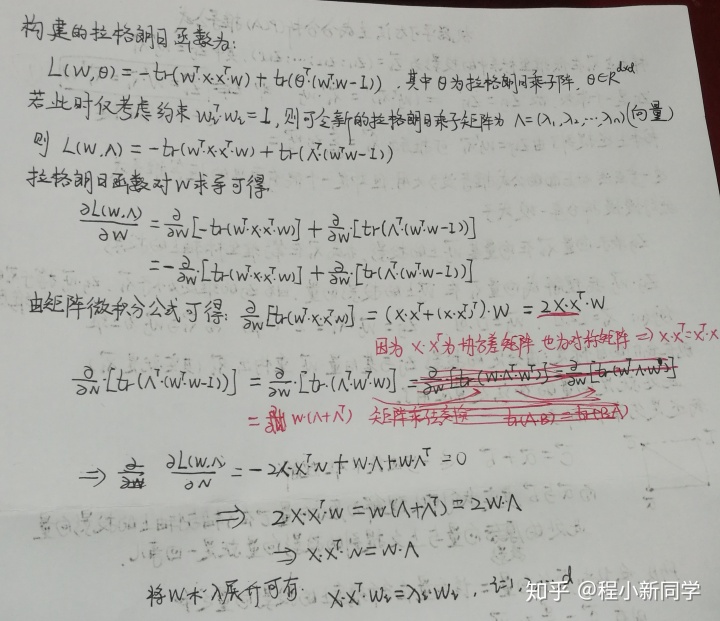

直接来构建拉格朗日函数,如下所示:

其中,

公式(1)则可以表示为:

接着拉格朗日函数对w求导可得:

由公式(3)还可简化,因为

其实此处的难点是矩阵微分运算了,我们要把公式(4)内的两个表达式给化简。矩阵微分运算中有两步很常用的求导公式很实用。

由公式(5)和(6)就可对公式(4)化简了,即:

令公式(7)等于0,我们很容易得到以下不等式:

将w和

以上证毕,最后还是要附上手稿小小得意以下,嘻嘻。

1405

1405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?