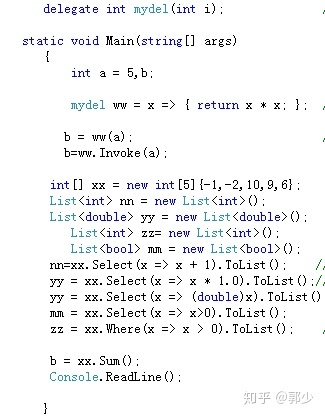

1、lamda =>委托应用。(1)定义委托类型 mydel(类似定义 int);(2)说明方法的实现内容 ww=x=>{return x*x} (类似定义变量 int a);(3)调用委托 ww(a) ,(类似使用变量a=3)。因为委托可以理解为一种方法的定义和使用,所以要定义方法的类型,说明方法的内容(可能要引入具体简单变量),让后才使用方法。

共有三句:(1) delegate int mydel(int i); 定义类型

(2) mydel ww=x=>{return x*x}; 说明方法

(3)ww(a); 调用

2、lamda在集合中的应用

(1) 数组xx[],的方法select内部可以接收委托。

yy=xx.Select(x=>x+1).ToList。数组xx中每一个元素都实现+1功能。

也可以*1.0 ,或者(double)操作每一个数组元素,进行转换为浮点类型。

而不必邀使用 for或者foreach对每一个元素处理。

mm=xx.Select(x=>x>0).ToList();结果是true和false的数组或者list。

(3)数组还有where查找符合条件的元素,以及求和xx.sum()功能,C#的功能蛮强大的。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?