#CLIP系列模型如何补短板再升级

CLIP(Contrastive Language–Image Pre-training)模型自推出以来,在图像-文本跨模态理解和生成领域取得了显著成果。然而,经典模型CLIP还是存在许多短板,对此,学界对CLIP模型的改造与增强还在持续进行中,希望通过改造CLIP模型架构、添加某些模块来弥补CLIP的能力短板,不断提升其在跨模态、少样本任务中的泛化性能与适用性。具体如下:

- 细化CLIP的视觉识别颗粒度

- 即提升其识别图像中细微差异和局部特征的能力,可以在视觉编码器部分引入更精细的特征提取机制。

- 可以采用多尺度特征融合策略,通过并行处理不同尺度的图像输入,并将多尺度特征进行有效融合,以捕捉图像中的多层次信息。

- 还可以引入注意力机制,使模型能够自动聚焦于图像中的关键区域或特征点。

- 结合弱监督学习或自监督学习方法,利用图像中的自然标注(如颜色、纹理等)或自生成标签(如聚类结果)来指导特征学习,也是提升视觉识别颗粒度的有效途径。

- 延长CLIP处理的文本长度并细化CLIP提取的文本信息

- 可以通过增加网络层数或采用更复杂的网络结构(如Transformer)来扩展文本编码器的容量,以支持更长的文本输入。

- 可以引入文本分段或分层处理机制,将长文本划分为多个子序列或段落,并分别进行编码和表示学习,最后再将各部分的表示进行有效融合。

- 为了细化文本信息的提取,可以设计更精细的文本表示学习方法,如基于词嵌入的向量表示、基于句法结构的图表示或基于语义角色的框架表示等。

- 对CLIP的图像文本输入做数据增强

- 对于图像数据增强,可以采用旋转、缩放、裁剪、翻转、颜色变换等传统方法,以及基于生成模型的对抗性样本生成等高级方法。

- 对于文本数据增强,则可以采用同义词替换、回译、随机删除、句子重组等方法来生成多样化的文本样本,或生成伪字幕改善输入数据的质量。

- 其他方法如, 通过文本到图像的扩散模型生成反馈来实现CLIP的自监督学习、增强模块以提升CLIP在某一少样本分类任务上的泛化能力等,还有的方法将CLIP输入扩展到视频……

本期推送再次盘点了CLIP模型架构还能如何改造,让我们一起来看看吧!

GroupViT: 从文本监督中实现语义分割

文章介绍了一个名为GroupViT(Grouping Vision Transformer)的模型,它是为了实现仅通过文本监督进行语义分割的任务而设计的。GroupViT通过一个分层的Transformer架构进行视觉概念的逐步分组,从较小的图像片段合并成较大的任意形状的语义段。GroupViT首先将输入图像划分为多个不重叠的小patch,并将每个patch线性投影到潜在空间,形成输入的image token。在每个分组阶段,image token和group token通过Transformer层进行信息传播,通过自注意力机制(self-attention)聚合全局信息。每个分组阶段的末尾都有一个grouping block,负责将相似的image token合并为更大的语义段(segment)。Grouping block通过计算group token和segment token之间的相似性矩阵来实现合并。在Grouping Block中,使用Gumbel-Softmax操作和直通技巧(straight through trick)来进行硬分配,使得segment tokens能够明确地分配给不同的group tokens。为了训练GroupViT执行分层分组,模型采用了特别设计的对比损失函数,包括原始的图像-文本对比损失和多标签对比损失。

相对于CLIP,GroupViT引入了分组机制,允许模型自动地将图像区域分组为语义段,而CLIP是一个基于对比学习的模型,主要用于图像和文本的联合表示学习,并没有显式的分组机制。GroupViT还采用了分层的Transformer架构,能够处理任意形状的图像段,而CLIP通常处理的是固定大小的图像patch。此外,GroupViT特有的Grouping Block模块,用于将图像tokens合并为更大的语义段。最后,GroupViT使用了多标签对比损失,通过从文本中提取名词并使用句子模板生成额外的文本标签,增强了模型对视觉分组的学习能力。

FFF:在对比性预训练中修复有缺陷的基础产生的视觉语言模型

文章提出了一种改进的对比性预训练方法,称为FFF(Fixing Flawed Foundations),旨在通过解决现有视觉-语言模型训练中的两个关键问题来增强模型性能:错误分配的负对(false negative pairs)和低质量及多样性不足的字幕(captions)。

- 在对比学习中,通常假设每个样本只有一个正对(positive pair),但实际中,由于图像和/或字幕在语义上的相似性,一些负对(negative pairs)可能被错误地标记。这导致训练过程和模型质量受限。为了解决这个问题,文章提出了一种基于图像-文本、图像-图像和文本-文本相似性的算法,用于发现并纠正这些错误分配的负对,并挖掘新的真正例(true positives)。

- 现有的网络收集的数据集往往包含质量低下、描述简短或不相关的字幕,这不利于训练。文章通过使用最先进的图像字幕技术生成伪字幕(pseudo-captions),作为给定图像的新真正例,从而提高字幕的质量和描述性。为了进一步提升训练数据的多样性,文章提出了批量文本增强策略。在同一个批次中,为每个训练图像生成多个伪字幕(例如,通过束搜索选择的五个字幕),这样可以有效增加字幕的多样性。

- 由于上述方法导致每个图像的正对数量可能不同,文章提出使用sigmoid loss作为训练损失函数。这种损失函数允许每个样本的正对数量动态变化,且对挖掘过程中的潜在错误具有鲁棒性。

文章展示了FFF方法在图像识别(在11个数据集上平均提高了约6%)和图像检索(在Flickr30k上提高了约19%,在MSCOCO上提高了约15%)方面的显著性能提升。总之,FFF方法通过解决负对分配错误和提升字幕质量与多样性,显著提高了视觉-语言模型的预训练效果,并通过使用sigmoid loss作为训练损失函数,有效地利用了多个正对进行训练。

DreamLIP:带有长字幕的语言图像预训练

文章提出的DreamLIP模型实现了从长标题中动态采样子标题,并与图像的局部区域进行细粒度对齐。

- DreamLIP首先使用预训练的多模态大型语言模型(MLLM)为30M图像重新生成详细的描述性长标题,这些长标题比现有的数据集更丰富、更详尽。进而从长标题中动态采样子标题(subcaptions),以构建多个正对(positive pairs)。每个子标题可能描述图像的一个部分,例如一个物体或者场景的一个方面。引入分组损失来匹配每个子标题的文本嵌入与相应的局部图像块。这种损失函数在自我监督的方式下工作,意味着它不需要外部标注来指导子标题和图像块之间的对齐。

- 采用多正对对比学习框架(Multi-Positive Contrastive Learning),将文本嵌入与图像嵌入进行对齐,使得来自同一图像的多个子标题能够与图像的不同部分形成正对。通过分组损失实现细粒度对齐,确保每个子标题的文本特征与图像中相应的局部特征精确匹配,从而提高模型对图像细节的理解。将多正对对比损失和细粒度对齐损失结合起来,形成DreamLIP的整体训练目标函数,通过这个函数来优化模型。

在多种下游任务上进行实验,包括图像-文本检索、语义分割等,证明了DreamLIP模型相较于现有方法在细粒度表示能力上的一致优越性。通过这种方法,DreamLIP能够充分利用长标题中的信息,提高模型对图像内容的理解和表示能力,尤其是在零样本学习的场景下,展现出了强大的性能。

DIVA:扩散反馈帮助 CLIP 看得更清楚

对比语言-图像预训练 (CLIP) 擅长跨领域和模态抽象开放世界表示,已成为各种视觉和多模态任务的基础。然而,最近的研究表明,CLIP存在严重的视觉缺陷,例如几乎无法区分方向、数量、颜色、结构等。这些视觉缺陷也限制了基于 CLIP 构建的多模态大型语言模型 (MLLM) 的感知能力。主要原因可能是用于训练 CLIP 的图像-文本对具有固有的偏见,因为缺乏文本的独特性和图像的多样性。这项工作提出了一种简单的CLIP模型后训练方法,该方法通过自监督扩散过程在很大程度上克服了其视觉缺陷。我们介绍了 DIVA,它使用 DIffusion 模型作为 CLIP 的视觉助手。具体来说,DIVA利用来自文本到图像扩散模型的生成反馈来优化CLIP的表征,仅使用图像(没有相应的文本),从而实现了自监督学习。

- DIVA使用一个预训练的条件扩散模型,该模型能够根据条件生成详细的图像。扩散模型通过一个逐步添加高斯噪声的过程来学习图像的概率分布,这个过程可以逆转,从而从噪声中重建图像。DIVA利用文本到图像扩散模型的生成能力,将CLIP模型编码的视觉特征作为扩散模型的条件输入。这意味着CLIP的视觉特征被用来指导扩散模型生成图像。通过最大化图像似然度,使用扩散损失来优化CLIP模型的表示。具体来说,扩散模型尝试预测每一步中添加的噪声,并通过这种方式来优化CLIP的权重,使其学习到更丰富的视觉细节。

- DIVA引入了一种视觉密集重述策略(Visual Dense Recap Scheme),通过结合局部区域的视觉特征(patch tokens)和类别标记(class token)来增强条件信息的丰富性,从而提高CLIP模型的优化能力。

- 尽管进行了优化,DIVA框架仍然保持了CLIP模型原有的零样本(zero-shot)能力,在多种图像分类和检索基准测试中表现出色。

通过在MMVP-VLM基准测试上的实验,DIVA显著提升了CLIP模型在细粒度视觉能力上的表现,并在多模态理解和分割任务上提高了MLLMs和视觉模型的性能。总的来说,DIVA模型通过一个简单而有效的自监督框架,使用扩散模型的生成反馈来优化CLIP的视觉表示,使其在视觉细节的感知上有了显著的提升,同时保留了CLIP的原有优势。

CLIP-FSAR:小样本动作识别的原型调制方法

本文的目标是迁移CLIP强大的多模态知识,以解决由于数据稀缺而导致的原型估计不准确的问题,这是少样本动作识别(Few-shot Action Recognition, FSAR)中一个关键问题。文章提出了一种名为CLIP-FSAR的原型调制框架,该框架由两个关键组件组成:视频-文本对比物镜(Video-text Contrastive Objective)和原型调制(Prototype Modulation)。

- 视频-文本对比物镜的目的是缩小CLIP和少样本视频任务之间的差异。通过对比视频特征和对应的类别文本描述,框架能够学习如何将视频内容与文本描述相匹配。使用CLIP的视觉编码器(Visual Encoder)提取视频帧的特征,同时使用文本编码器(Text Encoder)提取文本描述的特征。然后通过全局平均池化(Global Average Pooling, GAP)和余弦相似度函数来计算视频特征和文本特征之间的匹配概率。最后应用交叉熵损失函数来优化视频-文本匹配概率,使得匹配对的相似度最大化,不匹配对的相似度最小化。

- 原型调制是为了解决少样本情况下视觉信息不足导致的原型估计不准确问题,原型调制组件利用CLIP中的文本语义先验来优化视觉原型。首先在支持集(Support Set)的视觉特征基础上,将文本特征沿时间维度堆叠,并使用时间Transformer来自适应地融合文本和视觉特征。时间Transformer能够处理支持视频和查询视频的特征,使得融合后的特征在共同的特征空间中进行匹配,以计算查询视频与支持视频之间的距离。采用动态时间规整(Dynamic Time Warping, DTW)或其他时间对齐度量来计算查询视频和支持视频之间的距离,并通过少数样本度量目标(Few-shot Metric Objective)来进行分类。

CLIP-FSAR框架通过这两个组件的协同工作,能够充分利用CLIP模型中的丰富语义信息,生成可靠原型,并在少样本分类任务中实现精确分类。通过视频-文本对比物镜,CLIP-FSAR适应于视频任务,并通过原型调制增强了对视频中动作类别的识别能力。

MA-CLIP:CLIP的多模态自适应用于小样本动作识别

将大规模预训练的视觉模型(如 CLIP)应用于小样本动作识别任务可以提高性能和效率。利用“预训练,微调”范式可以避免从头开始训练网络,这可能既耗时又耗费资源。但是,这种方法有两个缺点。首先,用于小样本动作识别的标记样本有限,因此需要尽量减少可调参数的数量以减轻过拟合,这也会导致微调不足,从而增加资源消耗并可能破坏模型的广义表示。其次,视频的超时域维度挑战了小样本识别的有效时间建模,而预训练的视觉模型通常是图像模型。为了解决这些问题,本文提出了一种名为CLIP多模态适应(MA-CLIP, Multimodal Adaptation of CLIP)的新方法。

- 轻量级适配器(Lightweight Adapters)被添加到CLIP模型中,目的是最小化可学习的参数数量,从而减少过拟合的风险,并允许模型快速适应新任务。适配器的设计允许它们结合视频和文本信息,进行面向任务的时空建模。MA-CLIP利用视频的时空信息和文本的语义信息,通过适配器进行有效的多模态信息融合。这种融合方法可以提高模型对动作类别的识别能力,尤其是在小样本学习场景下。

- 模型不仅关注视频帧内的空间特征,还关注帧之间的时间关系,这对于理解动作的发展和变化至关重要。面向任务的时空建模(Task-oriented Spatiotemporal Modeling)使得MA-CLIP能够捕捉到动作的本质特征,提高识别的准确性。

- 文本引导的原型构建模块(TPCM, Text-guided Prototype Construction Module)基于注意力机制设计,用于增强视频原型的表示。通过利用文本描述,TPCM能够更好地理解视频内容,从而提高类别原型的质量,这对于小样本学习中的类别匹配和识别非常关键。

MA-CLIP设计为可以与任何不同的小样本动作识别时间对齐度量(如视频匹配器)一起使用,这增加了模型的通用性和灵活性。由于适配器的轻量级特性和参数数量的减少,MA-CLIP在训练时更加快速和高效,同时降低了训练成本。总的来说,MA-CLIP通过精心设计的适配器和文本引导的原型构建模块,有效地结合了视觉和语言信息,提高了小样本动作识别的性能,同时保持了模型的快速适应性和低训练成本。

APE:并非所有特征都重要:通过自适应先验优化增强CLIP的少样本泛化能力

现有的CLIP少样本泛化方法要么表现出有限的性能,要么存在过多的可学习参数。本文提出了 APE(Adaptive Prior rEfinement),这是一种为CLIP模型的预训练知识进行适应性细化的方法,旨在提高CLIP在下游任务中的性能,特别是在小样本学习场景下。

- APE通过先验细化模块(Prior Refinement Module)分析下游数据中的类间差异性,目的是将领域特定的知识与CLIP模型中已经提取的缓存模型进行解耦,从而选择最有意义的特征通道。利用两个标准——类间相似度(inter-class similarity)和方差(variance)——来选择最具区分性的特征通道,减少冗余信息并降低缓存大小,以减少内存成本。

- APE提供了两种模型变体:(1)无需训练的APE(Training-free APE):直接利用细化后的缓存模型进行推理,探索测试图像、细化的缓存模型和文本表示之间的三边亲和性,实现无需训练的稳健识别。(2)需要训练的APE-T:在APE的基础上,增加了一个轻量级的类别残差模块(category-residual module),该模块只需对类别残差进行训练,而不需要对整个缓存模型进行昂贵的微调。这个模块进一步更新细化的缓存模型,并在模态之间共享以确保视觉-语言的对应关系。

- APE模型探索了测试图像、先验缓存模型和文本表示之间的三边关系,通过这种关系来增强小样本学习的性能。

APE和APE-T在保持高计算效率的同时,实现了在多个基准测试中的最先进性能,特别是在16次拍摄的ImageNet分类任务中,APE和APE-T分别以少于第二佳方法+1.59%和+1.99%的平均准确率,并且具有×30更少的可学习参数。

#SAM2-Adapter

SAM2无法分割一切?首次让SAM2适应一切!

SAM2-Adapter是一种新型适配方法,旨在充分利用Segment Anything 2(SAM2)模型的高级功能,以应对特定的下游分割任务。

2023年,Meta提出了SAM,在图像分割领域取得了突破的进展。但是,研究人员也发现了SAM在医学图像领域、伪装物体等领域效果不佳,因此,我们在SAM发布后两周提出了SAM-Adapter,它成功地将Segment Anything (SAM) 模型应用于特定的复杂任务中,如伪装物体检测、阴影识别和医学图像分割,展现出完美的表现。SAM-Adapter不仅为科研人员提供了强大的工具,还在学术界和工业界产生了深远的影响,成为处理高难度分割任务的首选方案。随着Segment Anything 2 (SAM2) 的出现,这一升级版的模型在架构和数据训练规模上进行了大幅度的增强,为更复杂的图像分割任务提供了新的可能性。SAM2的发布带来了更强大的基础能力,但也提出了新的挑战:如何将这些增强的功能应用于具体的下游任务中。令人振奋的是,我们在新工作中展示了,SAM-Adapter的微调方法在SAM2上再次取得了成功。通过SAM2-Adapter的引入,研究人员将SAM2的潜力充分释放,在各类复杂任务中继续实现最先进(SOTA)的性能。这一成果不仅延续了SAM-Adapter的影响力,还证明了其方法的通用性和强大效能,推动了图像分割技术的进一步发展。论文和代码均已开源。

单位:魔芯科技、浙大等

项目页面: http://tianrun-chen.github.io/SAM-Adaptor

论文: https://arxiv.org/abs/2408.04579

开源代码(已开源): https://github.com/tianrun-chen/SAM-Adapter-PyTorch

1. 研究背景

在人工智能(AI)的研究领域,基础模型的引入已经显著地重塑了研究的版图,特别是在这些模型经过大规模数据集训练后。最近,Segment Anything(SAM)模型因其在图像分割领域的杰出成就而受到广泛关注。然而,尽管SAM在图像分割任务中表现出色,但先前的研究也指出了它在处理某些复杂低层次结构分割任务时的性能限制。为了应对这些挑战,研究人员在SAM模型发布不久之后,便开发了SAM-Adapter,目的是通过增强SAM的功能来提升其在这些任务上的表现。SAM-Adapter的设计架构在下图中进行了详细展示。

随着技术的发展,一个更为强大和通用的模型——Segment Anything 2 (SAM2)应运而生。SAM2在SAM的基础上对网络架构进行了优化,并在更广泛的视觉数据上进行了训练,引起了科研界的广泛关注。这引发了两个关键问题:

1. SAM在下游任务中遇到的挑战是否同样存在于SAM2?

2. 是否能够借鉴SAM-Adapter的成功经验,利用SAM2的先进预训练编码器和解码器,在这些任务中达到新的最前沿(SOTA)水平?

2. SAM2-Adapter

本研究的实验结果对这两个问题都给出了肯定的答案。尽管基础模型的固有局限性仍然存在,例如训练数据无法完全覆盖所有可能的场景,但通过引入SAM2-Adapter,研究者成功地在多个任务中实现了SOTA性能。SAM2-Adapter不仅继承了SAM-Adapter的核心优势,还引入了显著的改进,SAM2-Adapter有效地利用了SAM2的多分辨率和分层特性,实现了更为精确和鲁棒的分割效果。

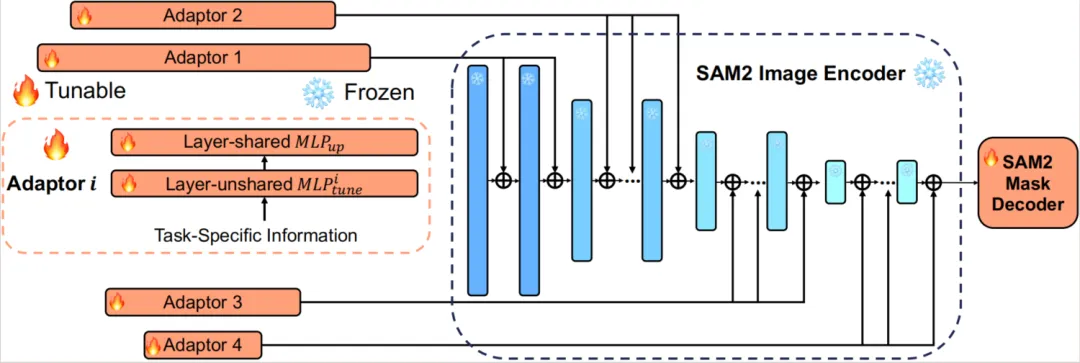

SAM2-Adapter 的核心基于SAM2模型的强大图像编码器和掩码解码器组件。具体来说,利用从 SAM2 中预训练的 MAE Hiera 图像编码器,并冻结其权重以保留从大规模数据集预训练中学到的丰富视觉表示。此外,研究团队使用了原始 SAM2 模型的掩码解码器模块,初始化其权重为预训练的 SAM2 参数,然后在训练适配器过程中进行微调。这个方法没有为原始 SAM2 掩码解码器提供任何额外的提示作为输入。

与 SAM-Adapter 的成功方法类似,通过适配器学习并注入任务特定的知识F^i到网络中。这个方法采用提示的概念,这利用了基础模型(如 SAM2)已在大规模数据集上训练的事实。使用适当的提示来引入任务特定的知识可以增强模型在下游任务上的泛化能力,尤其是在标注数据稀缺的情况下。

这个方法旨在保持适配器设计的简单和高效。因此选择使用一个仅由两个 MLP 和一个激活函数组成的适配器。值得注意的是,与 SAM 不同,SAM2 的图像编码器具有四个层次的分层分辨率。因此,本方法初始化了四个不同的适配器,并将四个适配器插入每个阶段的不同层中。

3. 实验验证

在实验中,研究团队选择了两个具有挑战性的低级结构分割任务和一个医学成像任务来评估SAM2-Adapter的性能:伪装物体检测、阴影检测和息肉分割。

3.1 伪目标检测

研究团队首先评估了SAM在伪装物体检测这一具有挑战性的任务中的表现,这项任务的调整在于前景物体通常与视觉上相似的背景图案融合在一起。实验表明,SAM在该任务中表现不佳。如图所示,SAM无法检测到多个隐藏物体。定量结果进一步确认了这一点,表明SAM在所有评估指标上的表现显著低于现有的最先进方法,而SAM2本身的表现最低,无法产生任何有意义的结果。实验结果证明,通过引入SAM2-Adapter,这个方法显著提高了模型的性能。该方法成功识别了隐藏的物体。

3.2 阴影检测

研究团队进一步评估了SAM在阴影检测中的表现。SAM2-Adapter的表现与SAM-Adapter一样出色,提供了可比的结果。

3.2 息肉分割

研究团队还展示了SAM2-Adapter在医学图像分割中的应用,特别是息肉分割。息肉在结肠镜检查过程中被识别并通过息肉切除术移除。准确快速地检测和移除息肉对于预防结直肠癌至关重要。在没有适当提示的情况下,SAM2模型无法产生有意义的结果。SAM2-Adapter解决了这个问题,并且优于原始的SAM-Adapter。根据定量分析和可视化结果,强调了SAM2-Adapter在提高息肉检测准确性和可靠性方面的有效性。

4. 总结与展望

SAM2-Adapter是一种新型适配方法,旨在充分利用Segment Anything 2(SAM2)模型的高级功能,以应对特定的下游分割任务。基于SAM-Adapter的成功,SAM2-Adapter针对SAM2的多分辨率分层Transformer架构进行了优化,成功克服了SAM的局限性,在伪装物体检测、阴影检测和息肉分割等挑战性任务中实现了新的最先进(SOTA)性能。实验结果表明,SAM2-Adapter不仅保留了其前身的优势,如泛化性和可组合性,还通过与SAM2的高级架构无缝集成进一步增强了这些能力。这使得SAM2-Adapter在各种数据集和任务中设定了新的基准,超越了之前的方法。从SAM到SAM2的持续挑战反映了基础模型在多样化现实场景中的复杂性。尽管如此,SAM2-Adapter有效解决了这些问题,展示了其作为高质量分割工具的潜力,适用于多种应用领域。研究人员和工程师被鼓励采用SAM2结合SAM2-Adapter,以提升分割任务的性能,推动图像分割领域的发展。这项工作不仅扩展了SAM2的能力,还为未来的大规模预训练模型在专门应用中的创新奠定了基础。

#文远知行

文远知行上市基石曝光:博世认购部分,IPO作价50亿美元

50亿美元,这就是国产通用型自动驾驶公司,文远知行刚刚曝光的IPO作价。

据文远知行更新的招股书信息,明确了IPO将增发的股票数量,以及每股价格,公司估值随之曝光。

其中超过91%的公开增发股份,将由百年Tier 1巨头博世认购。

博世之前已经参与了文远知行的融资,并且双方还落地了L2+方案的合作,而现在博世更进一步以基石投资者身份,帮文远冲击纳斯达克。

此外,首次公开募股的同时,文远知行还将开启私募,总计将获得折合人民币超31.5亿元的资金。

文远知行的IPO,已经到了最后100米冲刺。

360亿,文远知行估值曝光

文远知行向美监管机构提交的最新文件显示,文远知行此次IPO将发行6452000股ADS(美国存托股),每份ADS价格为15.5-18.5美元,1份ADS相当于3份普通股。

即此次增发股份的融资金额为1-1.2亿美元,折合人民币约为7.17-8.56亿元。

此次增发股份后,文件显示文远知行将拥有总共814132531股普通股。

若按最高股价计算,则文远知行的市值将冲上50.2亿美元,折合人民币约为359.83亿元。

这个作价,实际与2022年11月D+轮融资后,文远知行投后超50亿美元的估值相比,变化并不大。

或许也是文远知行对于这次上市务实求真的态度,没有追求更高的溢价。

而且此次公开增发的股份,将由Tier 1巨头博世认购绝大部分。

文件显示,博世购买的ADS数量为5882353份,约占增发ADS总数的91.2%。

博世与文远知行渊源颇深,既是文远知行的投资者,也是文远知行的高阶智驾合作方。

2022年3月,博世和广汽等参与了文远知行的D轮融资,融资金额为4亿美元,当时折合人民币约为25.2亿元。

也差不多是这一轮融资,文远知行的估值达到了44亿美元。

两个月后,博世与文远知行达成合作,将联合开发L2+级ADAS,自此文远知行搭上了第一Tier 1的快车,走上了一条令供应商艳羡的道路。

△左二为时任博世中国执行副总裁、现任总裁徐大全博士,右二为文远知行联合创始人兼CTO李岩博士

经过18个月的努力,双方合作方案成功落地,上车奇瑞星纪元ES,可实现高速NOA,包括超车变道、避让施工区域、自动上下匝道等。

博世此次认购超91%的发行股份,可视为双方合作关系的进一步深化,也说明文远的实力得到了博世的认可。

如此比例的认购,实际也不算多见,全球第一Tier 1帮文远冲刺通用型自动驾驶第一股。

除了增发股份之外,文远知行还表示完成IPO的同时,还会以私募方式,出售价值3.205亿美元(折合人民币约为23亿元)的A类普通股。

相关投资者有Alliance Ventures、广汽资本、Beijing Minghong、Kechuangzhixing等。

其中Alliance Venture是雷诺日产三菱联盟旗下的战略风投部门,是文远知行的早期投资者。

曾在2018年领投A轮,后又在2021年参与了C轮融资,此次将认购9700万美元,折合人民币约为6.95亿元的A类普通股。

文远知行和雷诺日产等也有合作关系。

2022年11月,文远知行联合日产在苏州落地了Robotaxi,并亮相当年的进博会。

今年5月,雷诺和文远知行合作的无人小巴在法网提供接驳服务。

广汽也是文远知行过去的投资者,曾在2021年底参与文远知行的战略投资,以及2022年3月的D轮融资,此次将认购2000万美元(折合人民币约为1.43亿元)的A类普通股。

简单计算一下可知,文远知行此次将通过IPO和私募等途径,累计获得约4.4亿美元,折合人民币超31.5亿元的资金。

文远知行在文件对资金的用途做了说明:

- 约35%用于自动驾驶技术、产品和服务的研发。

- 约30%用于自动驾驶车队的商业化和运营,拓展市场的营销活动。

- 约25%用于资本支出,包括购买测试车辆、研发设施和行政支出。

- 剩余10%用于公司一般用途。

所以,文远知行靠什么撑起了50亿美元的估值,能够收获博世等合作伙伴的青睐?

文远知行靠什么值50亿美元

文远知行成立于2017年,目前在7个国家30座城市开展自动驾驶的研发、测试和运营,是唯一同时拥有中国、美国、阿联酋和新加坡四地自动驾驶牌照的科技企业。

提供L2和L4级自动驾驶产品与服务,不久前向美国证监会提交招股书,冲刺纳斯达克。

在招股书中,文远知行披露了最近三年半的财务指标。

其中2021年的营收为1.38亿元,2022年暴涨至5.28亿元,实现281.7%的同比增长。

2023年营收略有下滑,为4亿元。

截止2024年上半年,文远知行营收为1.5亿元,对比2023年同期仍然略有下降。

目前公司尚未实现盈利,三年累计净亏损13.31亿元。

从图中可以看到,文远知行的亏损在扩大,这和研发投入逐年增高有关系。

文远知行共有员工2227名,其中约91%都是研发人员。

2021年研发投入为4.43亿元,2022年几乎翻了一番,增长至7.59亿元,2023年继续增长至10.58亿元。

今年上半年的研发投入,已达5.17亿元。

研发投入远大于营收,对亏损起到了一定影响。

但目前公司的现金储备还比较充足,截止2024年上半年末,文远知行现金及其等价物约为18.28亿元。

所以,亏损中的文远知行,有什么技术和业务,撑起了50亿美元的估值?

文远知行的核心平台是WeRide One,基于此打造L2和L4级自动驾驶技术,落地乘用车、Robotaxi、无人小巴和自动驾驶厢货车和无人清扫车。

同时押注两条路线,落地产品范围广,这也是为什么,文远知行被称为通用自动驾驶第一股。

从文远知行的营收组成变化来看,文远知行的业务正在发生转变。

招股书显示,文远的营收来源主要分为产品和服务两大部分。

2021年的营收中,前者占了大头,带来1.01亿元的营收,占比高达73.5%。而服务则只有0.37亿元的收入,占比26.5%。

而到了2023年,公司产品收入为0.54亿元,占比降至13.5%,服务收入增长至3.48亿元,占比升至89.9%。

这表明,文远知行的商业化模式,正在经历转折:

从一个运营Robotaxi车队,或给运营商卖车辆硬件的“重资产”模式,走向提供技术、提供后续服务的轻资产模式。

短期内,文远营收会受到博世智驾推广覆盖速度的影响。

但长期来看,博世的方案就是全行业的方案,是可持续产生营收的现金奶牛项目。

文远知行还将坚持L4自动驾驶,其判断2024年和2025年随着Robotaxi的大规模投放,来自服务的收入占比将会进一步提升。

最后,简单介绍一下文远知行的两位主要创始人:

CEO韩旭,伊利诺伊大学香槟分校计算机工程博士,历任密苏里大学的助理教授,密苏里大学博士生导师、终身教授,计算机视觉和机器学习实验室主任。

创业前曾担任百度美研自动驾驶事业部首席科学家。

联合创始人兼CTO李岩,卡内基梅隆大学电气与计算机工程学博士,曾在Facebook和微软担任核心工程师。

相比两位创始人,文远知行也因为脱口秀演员赵晓卉的加盟而出圈。

不过赵晓卉在文远知行,担任的是项目经理,与其演员身份有着明确区隔,也没有对文远做过多的公众宣传。

此前其在综艺节目上曾透露,正在负责无人小巴接驳车的部分功能。

相比赵晓卉之于文远知行,文远知行带给这位“打工人”则价值更大。文远知行不仅给了汽车科班出身赵晓卉业务能力认可,如今也在上市IPO进展中,印证了赵晓卉当初眼光的长远。

毕竟相比李诞的笑果文化和脱口秀行业,自动驾驶确实前途光明多了。

One More Thing

招股书之外,近日文远知行还预告了新动向:10月15日将发布新一代Robotaxi车型。

与马斯克和特斯拉,也就前后脚吧。

实际上,随着自动驾驶技术正在实现的技术和商用运营突破,自动驾驶不论是产品还是资本运作,都来到了新周期。

文远知行IPO,只是浪潮中的浪花一朵,同样在潮尖之上的,还有M公司、P公司…以及刚刚通过港股聆讯的H公司。

一个新的周期,已经来到了公众面前。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?