大家好,我是木易,一个持续关注AI领域的互联网技术产品经理,国内Top2本科,美国Top10 CS研究生,MBA。我坚信AI是普通人变强的“外挂”,所以创建了“AI信息Gap”这个公众号,专注于分享AI全维度知识,包括但不限于AI科普,AI工具测评,AI效率提升,AI行业洞察。关注我,AI之路不迷路,2024我们一起变强。

1848年,美国加州的一名木匠在建造锯木厂时意外在河里发现了黄金,这一消息迅速传开,引发了全世界的淘金热。无数怀揣着发财梦的淘金客从世界各地涌向加利福尼亚,希望从金矿中挖掘到属于自己的财富。旧金山的人口在短时间内从1847年的500人激增至1870年的15万,整个地区陷入了一片淘金的狂热之中。

然而,在这场淘金热潮中,大多数直接参与淘金的人都没有像预期那样发财。由于淘金者之间的竞争激烈,加之美国西部艰苦的条件,许多人最终并没有赚到太多的钱。那么,真正赚钱的是谁?是那些提供必要服务和工具的商家。那些卖水、食品、住宿以及挖金所需的铲子和其他工具的人,由于需求的大幅增加,获得了意想不到的收益。这其中最出名的莫过于卖牛仔裤的德国移民李维·斯特劳斯,最终成立了李维斯公司,也就是现在的Levi's。

放眼现在,在当下这场AI的“淘金”浪潮中,英伟达(NVIDIA)无疑是最靓的仔,是那个“卖铲子”的人。

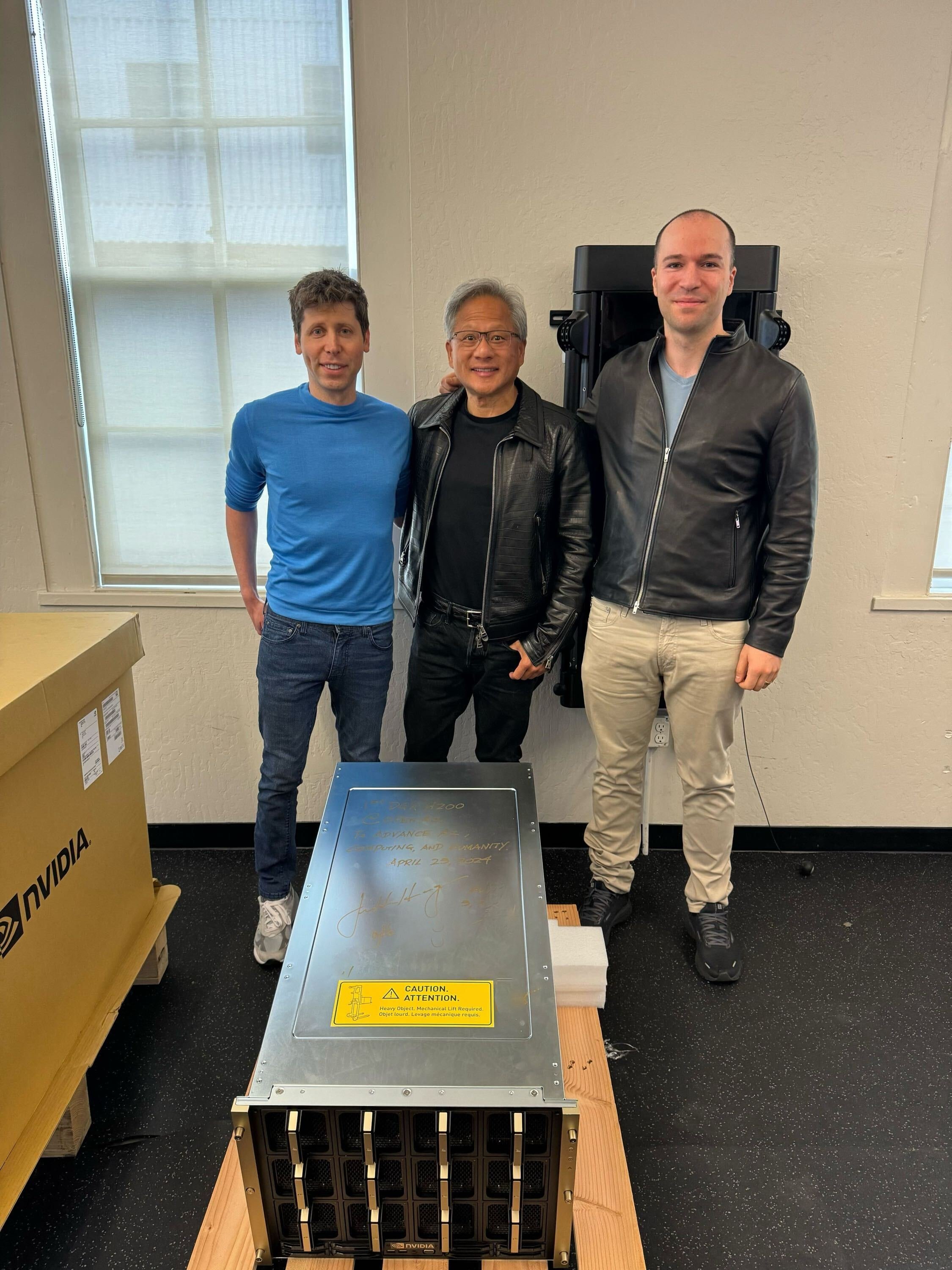

2024年4月24日,英伟达创始人兼CEO黄仁勋亲自向OpenAI交付了全球首台NVIDIA DGX H200 AI加速服务器。这一交付仪式在OpenAI位于旧金山的办公室举行,OpenAI的CEO Sam Altman和联合创始人兼总裁Greg Brockman出席了交接仪式。

NVIDIA DGX H200是何方大神

NVIDIA DGX H200是由英伟达设计的一款高性能AI超级计算机,专门针对需要处理大规模数据集和复杂AI模型的企业级应用而打造。DGX H200结合了英伟达多项先进技术,包括其最新的H200 Tensor Core GPU,以及高速NVLink互连技术,以提供前所未有的算力和效率,支持AI和高性能计算(HPC)工作负载。

值得一提的是,H200和DGX H200是两个不同的概念。H200指的是单个的Tensor Core GPU,它是英伟达推出的一款高性能 GPU,专为AI和HPC工作负载设计,具有大量的内存和高内存带宽。而黄仁勋亲自送往OpenAI的这台DGX H200则指的是包含H200 GPU的整个AI超级计算机系统。换句话说,DGX H200是一个集成了多个H200 GPU、高速网络互连、以及专为AI优化的软件栈的完整解决方案。

NVIDIA DGX H200关键特性:

-

H200 Tensor Core GPU:DGX H200采用了基于NVIDIA Hopper架构的H200 GPU,这是首款提供高达141 GB HBM3e内存的GPU,内存带宽达到4.8 TB/s。

-

超大的内存和性能:与前代产品相比,DGX H200提供了几乎500倍的GPU共享内存,专门用于处理大型推荐系统、生成式AI和图形分析领域的TB级模型训练。

-

互连技术:DGX H200支持通过NVLink Switch系统将Grace Hopper超级芯片连接到同一个GPU中,实现了大规模的GPU间直接互连,提供了更高的带宽和更低的互连功耗。

-

AI 超级计算机:DGX H200被设计为能够处理万亿级参数AI模型的加速服务器,提供高达1 exaflop的性能和144 TB的共享内存。

算力和GPU?

我们从去年起常听到的“算力”是什么?为什么当下算力的主流来源是GPU?接下来我们聊一聊算力和GPU的关系。

算力

算力,即计算能力(Computing Power),是指计算机执行复杂计算和数据处理任务的能力。对于算力的理解可以分为狭义和广义两种。在狭义的理解中,算力就是对数学问题进行的运算,如简单的加法运算。广义上,任何对信息进行处理并得到结果的过程都可以称为“计算”,比如,人类的思考也可以视作一种计算过程。

作为衡量计算能力的指标,算力根据应用场景和需求可以被划分为以下几种类型。通用算力主要基于CPU的计算能力,能够处理广泛的计算任务,是日常计算需求的主力军。而当涉及到AI应用时,如深度学习和模式识别等,智能算力便显得尤为重要,通常由GPU、TPU(张量处理单元)等专用加速器提供,以应对复杂的机器学习算法。此外,超算算力涉及高性能计算集群,这些集群拥有巨大的计算能力,适用于执行科学研究和大规模计算密集型任务。最后,边缘算力指的是在网络的边缘位置进行的数据处理和计算,适合需要即时响应的应用,例如物联网(IoT)设备的数据预处理。

GPU

GPU,即图形处理单元(Graphics Processing Unit),是专门设计来处理图形和视觉计算任务的微处理器。GPU由数百个小的核心组成,这些核心能够进行并行处理,非常适合执行复杂的算法和大量数据操作。基于这个特性,GPU最初被用于加速图形渲染,目前被广泛应用于科学计算、数据分析、密码破解、金融建模等领域。

GPU在设计目标和工作方式上,与我们常听到的CPU有着显著的区别。CPU,中央处理器(Central Processing Unit),是一种通用处理器,被设计用于处理一系列复杂的指令,执行逻辑运算、控制任务和处理复杂的计算序列。CPU的核心较少但功能强大,每个核心都具备较高的计算能力,并且能够执行复杂的控制任务。相比之下,GPU则包含大量的较小、较简单的核心,这些核心设计用于同时处理许多较小的计算任务,从而实现高吞吐量。也正因此,GPU在图形渲染和某些科学计算任务中表现出色。

加速算力的选择:GPU VS CPU

在AI和机器学习领域,GPU之所以成为提供加速算力的主流选择,而不是CPU,主要原因就是上面提到的GPU的并行处理能力。AI和机器学习算法通常涉及大量的矩阵运算和数据并行处理,这些任务可以被分解为成千上万个小任务,由GPU的多个核心同时执行。这种高度并行化的计算模式可以显著提高计算效率和速度。

除了并行处理能力,GPU还有独立的显存,可以提供更高的内存带宽。AI和机器学习算法通常需要处理大规模数据集,对内存带宽要求很高。GPU的高带宽显存可以加速数据的读写和传输,进一步提升计算性能。相比之下,CPU与系统内存共享带宽,在处理大型数据集时容易遇到内存瓶颈。

当然,需要指出的是,GPU并非在所有AI和机器学习任务中都是最优选择。对于某些小规模的、计算不密集的任务,使用CPU可能更简单高效。而且,GPU编程对开发者的要求较高,需要使用CUDA等专门的编程框架,优化难度大。相比之下,CPU编程可以使用通用编程语言,开发门槛相对较低。

Ilya去哪儿了?

作为OpenAI联合创始人兼首席科学家,Ilya Sutskever消失在公众的视野中已长达数月。所以当OpenAI发布与黄仁勋的合照后,热心的网友们不禁发问:Ilya是不是藏在旁边的箱子里呢?

更是有网友表示:修复了OpenAI发的照片,这下它完整了。

精选推荐

都读到这里了,点个赞鼓励一下吧,小手一赞,年薪百万!😊👍👍👍。关注我,AI之路不迷路,原创技术文章第一时间推送🤖。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?