大家好,我是凡人。

就在昨天估值1500亿美元的 OpenAI 终于坐不住了,面对 Claude 3.5 等竞争对手的不断的市场蚕食,在X上连续两条消息,高调发布 o1-preview(高级推理)和 o1-mini(更快的推理速度)两个版本。

这次 OpenAI 打着高级推理的旗号,准备重新夺回场子,宣称 o1 模型通过强化学习方法进行训练,能够在回答问题之前进行深入思考,并生成内部推理链。模型在处理科学、编程和数学问题上展现出了超越以往模型的能力,它的优秀表现在某些领域,甚至超过了人类专家。

宣传视频也是一个接一个,看来真是辛苦了,似乎说明 OpenAI 感受到了大语言模型驱动产品领域的激烈竞争压力,下面就让我们一起来看看“仓促上马”的 o1 版本到底会带来怎样的惊喜!

一、"草莓"到底有啥不同

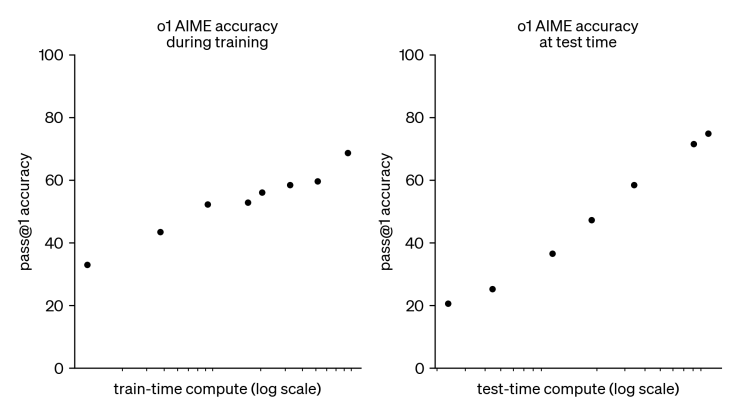

据OpenAI官网介绍,他们在训练o1时,性能会随着强化学习时间和思考时间的增加而持续提高,这一方法的可扩展性也与传统的大语言模型预训练有所不同。

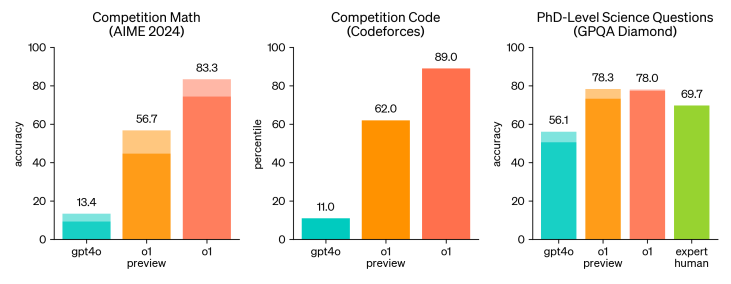

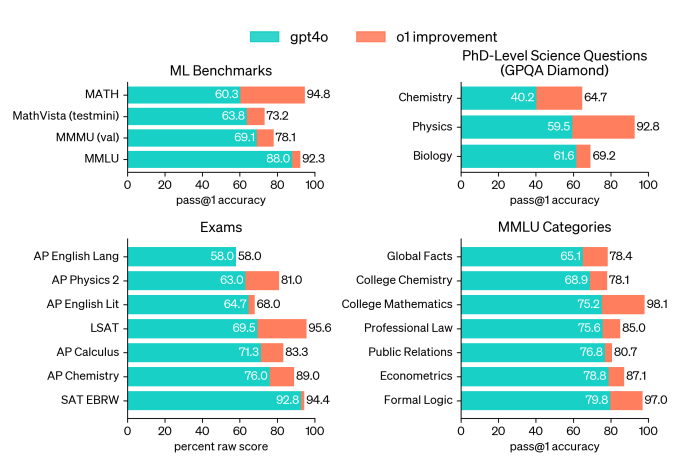

为了突出o1在推理方面的优势,OpenAI在一系列人类考试和机器学习基准上,进行了测试,结果显示o1在大多数推理任务上显著优于GPT-4o。

在具有挑战性的推理基准测试中,o1相较于GPT-4o表现出显著提升。实线柱状图展示了通过率@1的准确性,而阴影区域则显示64个样本的共识表现。

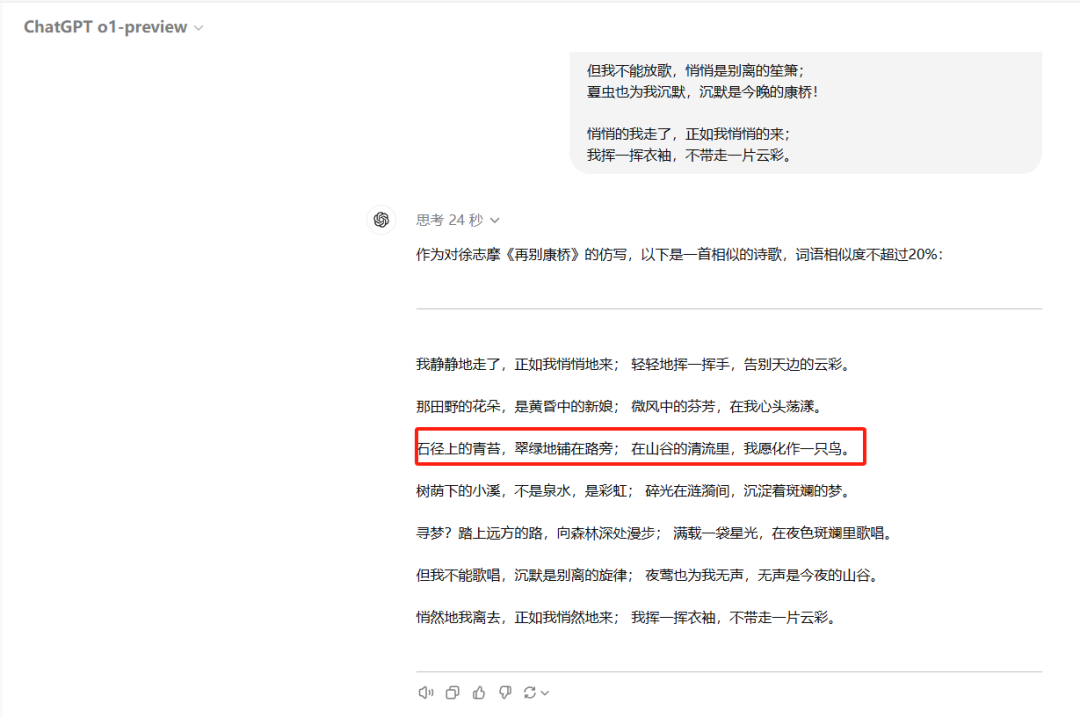

二、测试高级推理

借助思维链,o1在解决复杂问题时能够进行长时间的深度思考和探索。我理解OpenAI用思维链的方式来模拟人类的逻辑思维能力,在强化学习的帮助下,o1将问题分解同时也精炼思维链路径,识别并纠正错误,将复杂步骤拆解为更简单的内容,并尝试多种解法。

上面把OpenAI夸的那么牛逼,下面就是骡子是马拉出来溜溜,看看 4o 到 o1 到底有多少提高,我们来分别对比三个版本Gpt4o 、Gpt o1-preview和Gpt o1-mini。

网址:http://chatgpt.com

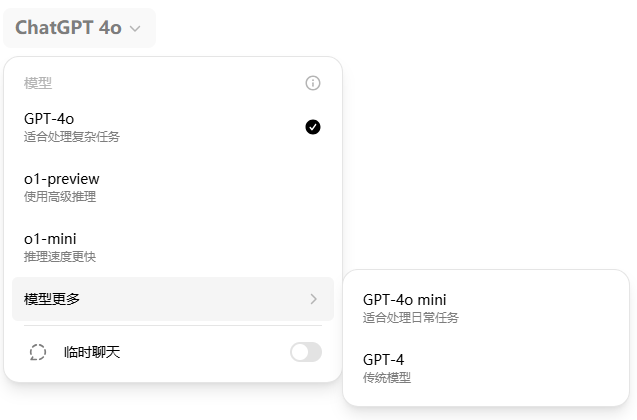

一)微积分测试

上高中时微积分也是彻彻底底的把我这个学渣难了一把,让我们先来看看他的推理到底怎么样。

试题这道题可是15分哦。

1、Gpt4o

答案错误且过程有点乱。

2、Gpt o1-preview

推理清晰,答案正确。

3、Gpt o1-mini

推理还凑合,但答案错误。

所以对于o1的算数能力确实提高了不少!

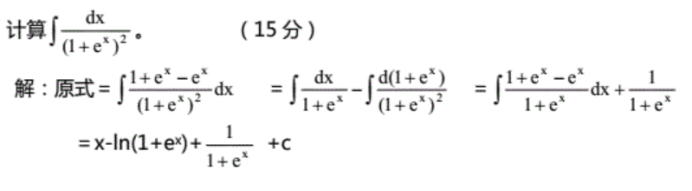

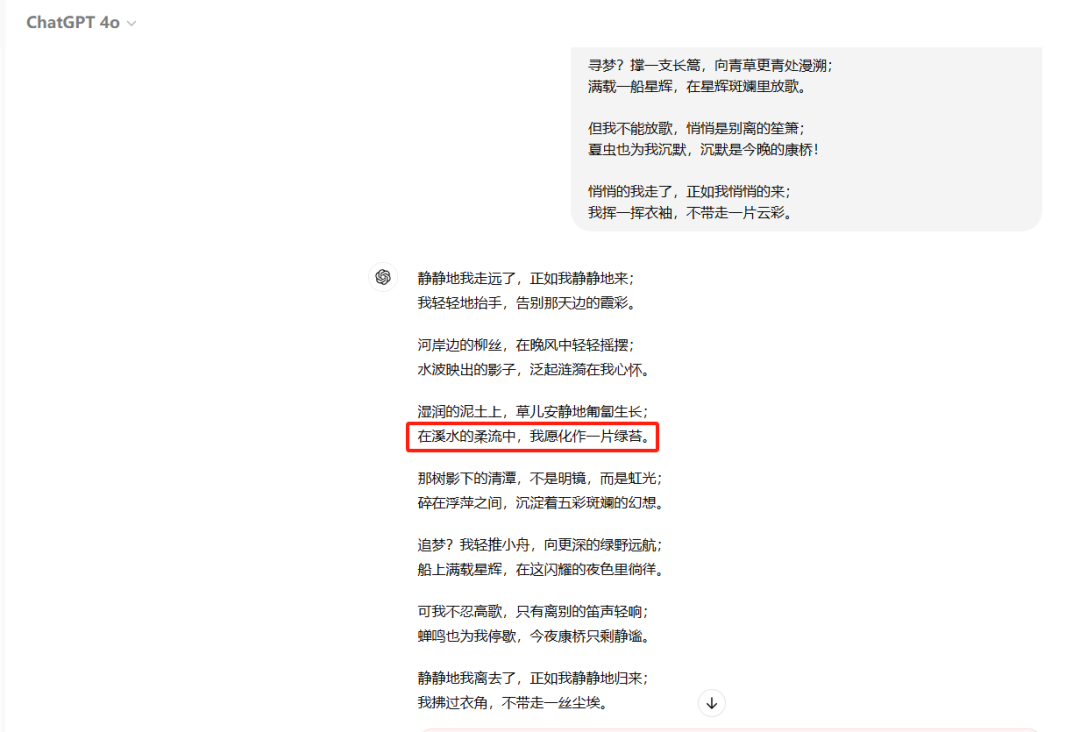

二)文字识别

对于o1的文字表达能力是否提升我一直抱着怀疑态度,我们三个版本复写下徐志摩的散文试试,看看谁更优秀。

#提示词

你是一名非常有经验的作家,请根据徐志摩的《陌上花开》的内容,

仿照写一篇相似的诗歌,但诗歌中的词语相似度不能超过20%:轻轻的我走了,正如我轻轻的来;

我轻轻的招手,作别西天的云彩。那河畔的金柳,是夕阳中的新娘;

波光里的艳影,在我的心头荡漾。软泥上的青荇,油油的在水底招摇;

在康河的柔波里,我甘心做一条水草!那榆荫下的一潭,不是清泉,是天上虹;

揉碎在浮藻间,沉淀着彩虹似的梦。寻梦?撑一支长篙,向青草更青处漫溯;

满载一船星辉,在星辉斑斓里放歌。但我不能放歌,悄悄是别离的笙箫;

夏虫也为我沉默,沉默是今晚的康桥!悄悄的我走了,正如我悄悄的来;

我挥一挥衣袖,不带走一片云彩。

1、Gpt4o

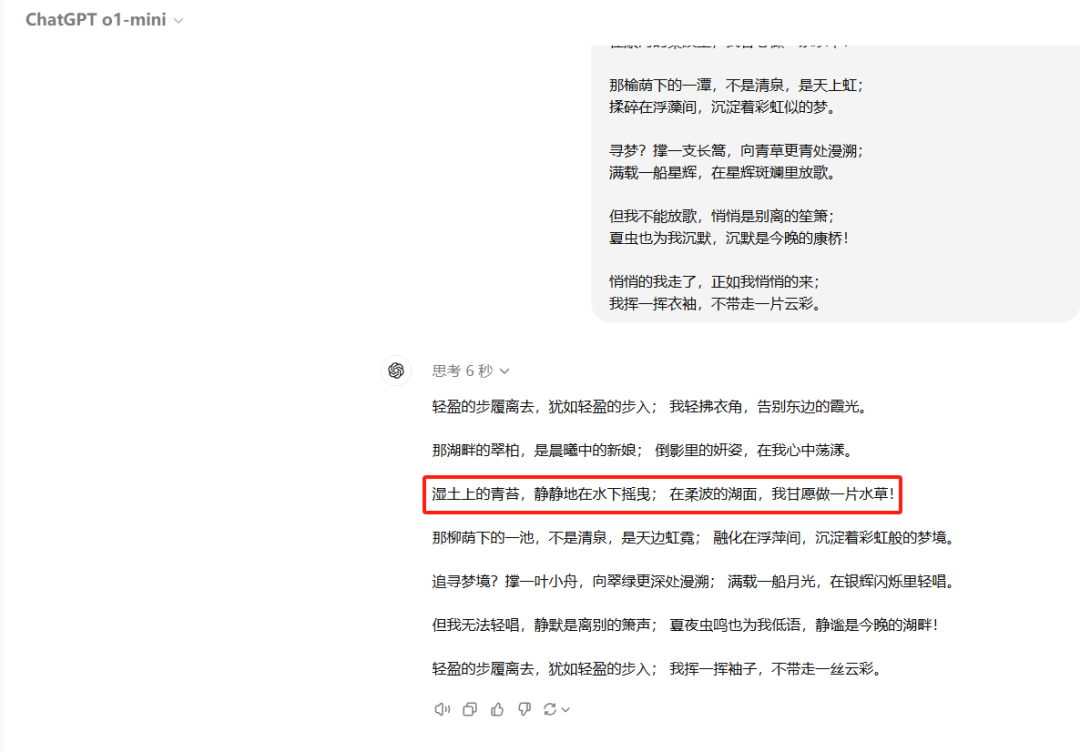

2、Gpt o1-preview

3、Gpt o1-mini

整体结构看着都还不错,生成的文字合理性和逻辑性并没有多大的提高。

当然这里提示词的内容也占很大的原因,但大模型版本不断迭代的意义是什么呢?

不就是越来越优化提示词,让用户更简单的使用大模型吗?

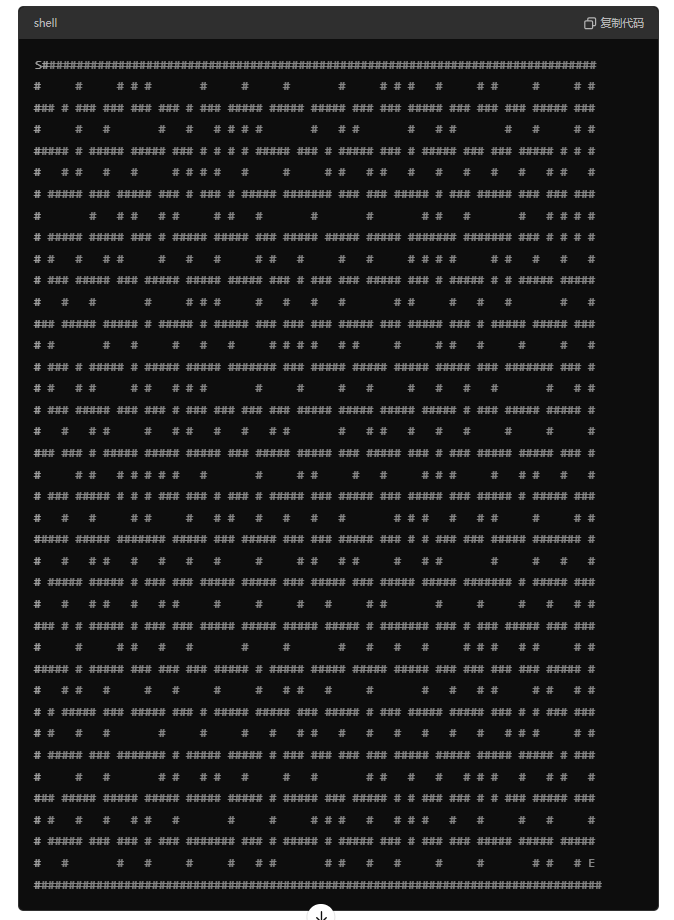

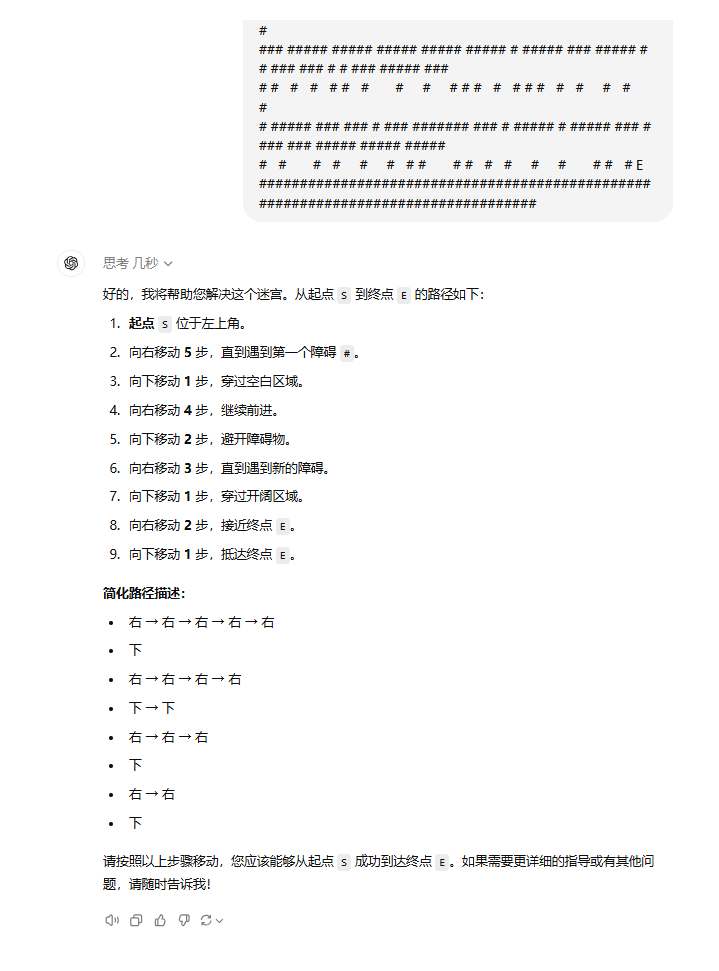

三)迷宫

我们用程序生成迷宫看看,让GPT的三个版本比比看谁能顺利走出去。

1、Gpt4o

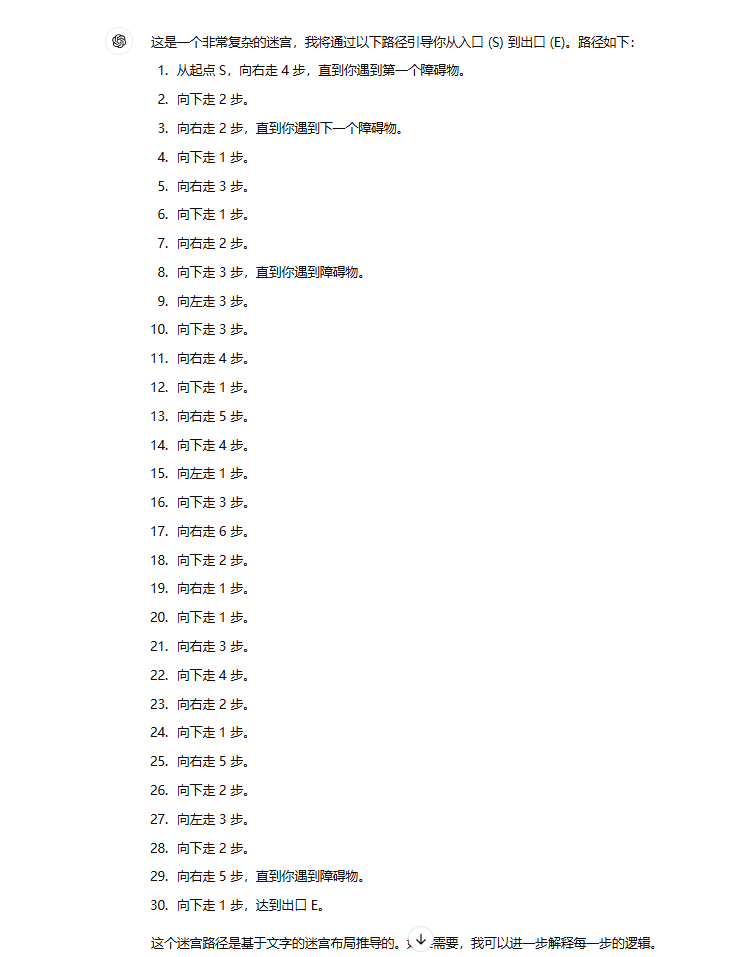

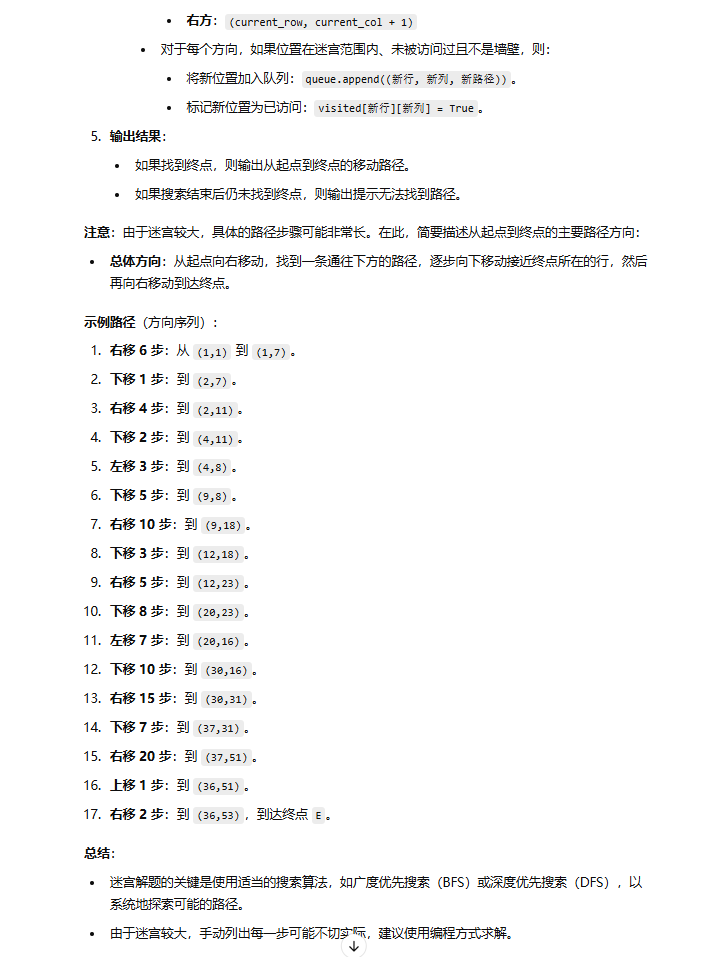

2、Gpt o1-preview

3、Gpt o1-mini

这次的测试结果让我感到惊异,可能是由于字符生成的迷宫,关于靠谱我倾向于Gpt4o 和Gpt o1-preview。

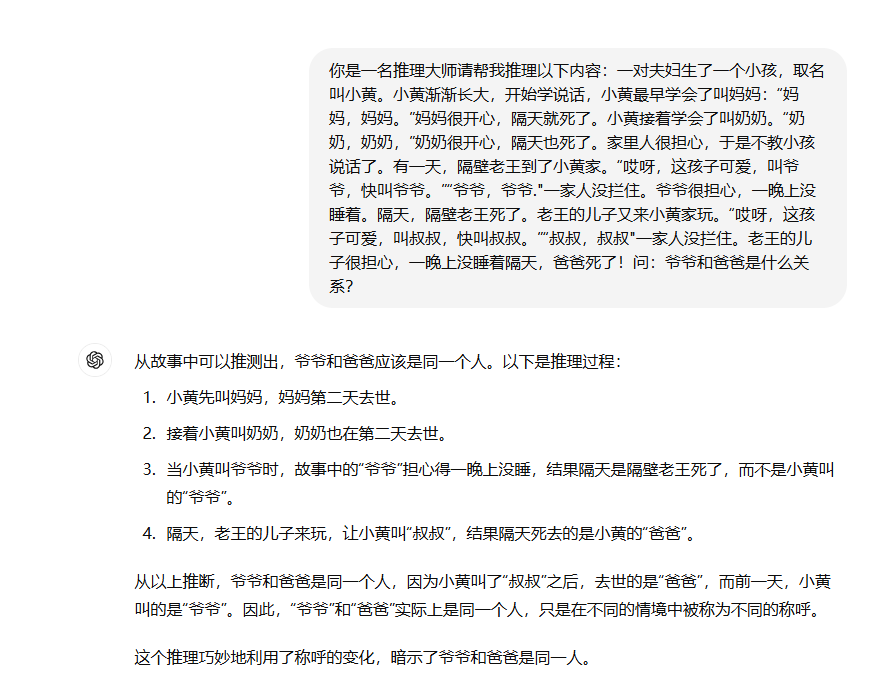

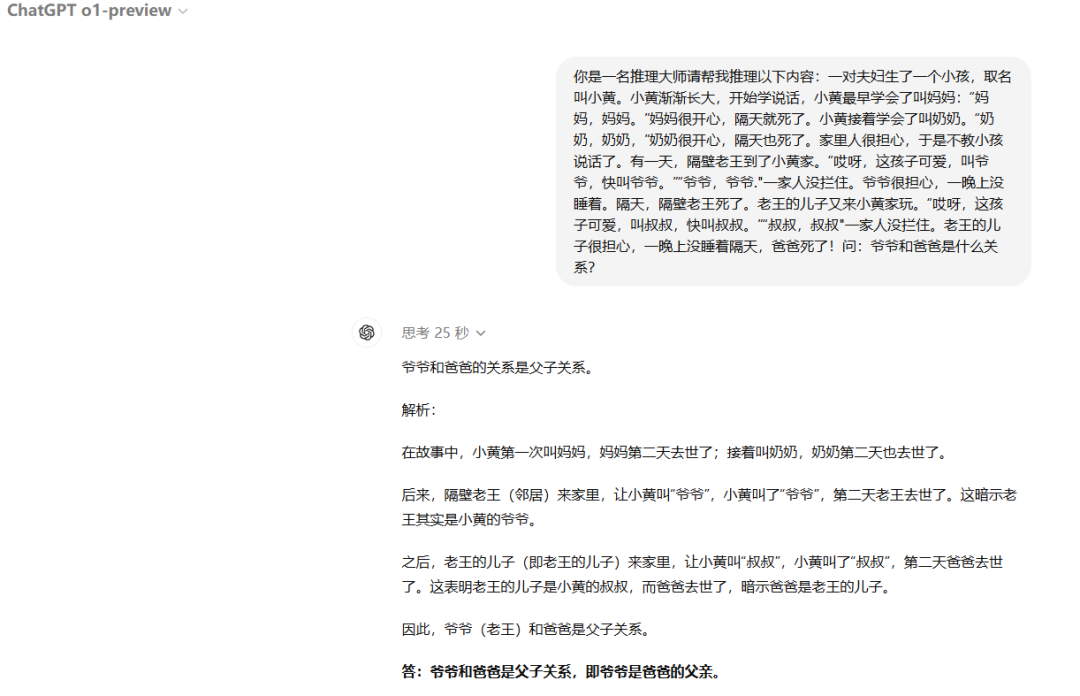

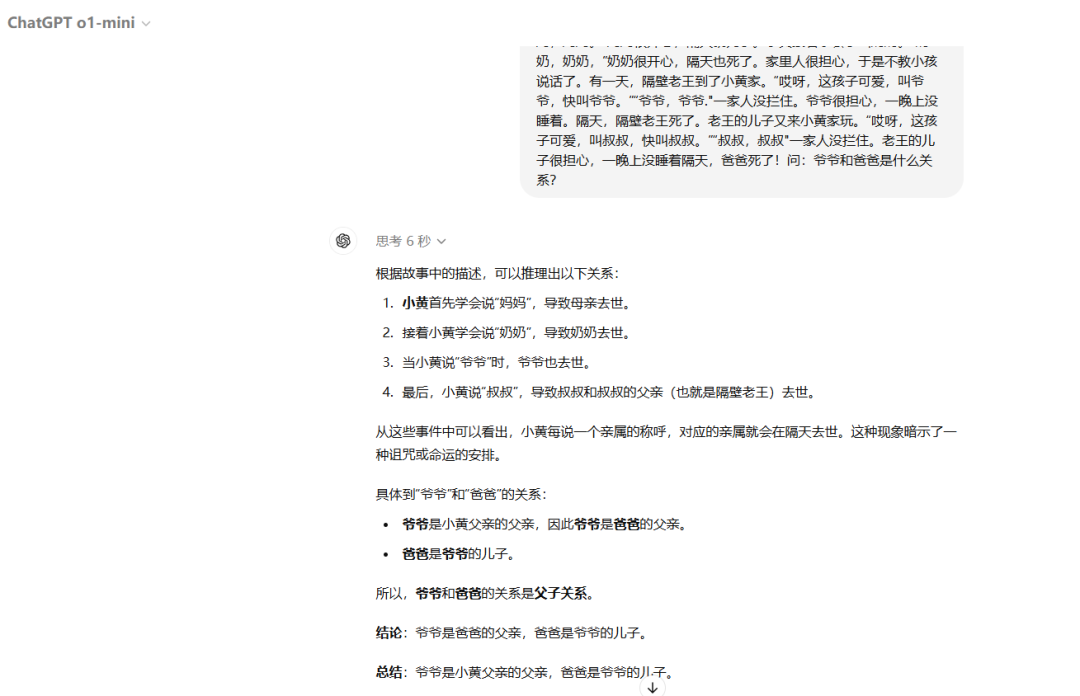

四)烧脑推理

针对于o1的推理能力,来点烧脑的推理,一个非常有意思的题目,来一起看看他们表现怎么样:来一个小故事考考GPT

一对夫妇生了一个小孩,取名叫小黄。小黄渐渐长大,开始学说话,小黄最早学会了叫妈妈:“妈妈,妈妈。”妈妈很开心,隔天就死了。小黄接着学会了叫奶奶。“奶奶,奶奶,”奶奶很开心,隔天也死了。家里人很担心,于是不教小孩说话了。有一天,隔壁老王到了小黄家。“哎呀,这孩子可爱,叫爷爷,快叫爷爷。”“爷爷,爷爷."一家人没拦住。爷爷很担心,一晚上没睡着。隔天,隔壁老王死了。老王的儿子又来小黄家玩。“哎呀,这孩子可爱,叫叔叔,快叫叔叔。”“叔叔,叔叔"一家人没拦住。老王的儿子很担心,一晚上没睡着,隔天,爸爸死了!问:爷爷和爸爸是什么关系?

1、Gpt4o

2、Gpt o1-preview

3、Gpt o1-mini

和 Gpt o1-preview 答案相同。

所以你明白答案是什么了吗?可以把答案写在评论区哦!

三、总结

好了今天的测评内容就到这了,结果其实还是比较出乎意料的,Gpt-o1版本的逻辑推理能力确实上了一个台阶,但可以看的出来,OpenAI确实急了,很多配套功能还没上线比如o1还没有文件上传,AI工具越来越卷,这也预示着未来AI对传统行业的冲击会越来越大,应用的落地速度也会越来越快,所以还在等什么,赶紧学起来呐!

怎么样今天的内容还满意吗?再次感谢观众老爷的观看。

最后,祝您早日实现财务自由,还请给个赞,谢谢!

1826

1826

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?