文章目的:只为记录常用kafka 工作中常用的命令

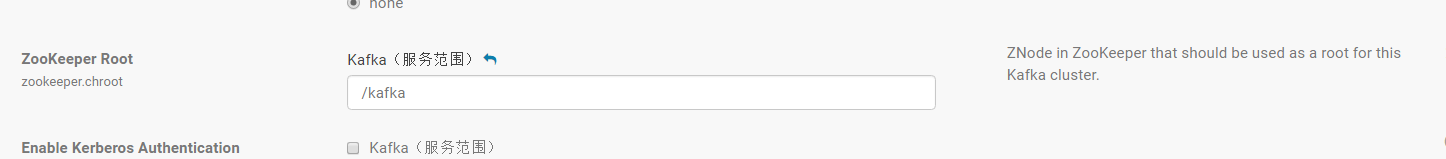

解释:因为选择zk 记录kafka 的元数据 并且指定路径为 /kafka 所以指定zk 命令单独加上/kafka 路径

1、查看当前kafka 服务中的所有topic

kafka-topics --zookeeper ZW0416-hadoop-2-59:2181/kafka --list

2、在当前kafka 服务中创建topic 指定分区和备份份数

kafka-topics --zookeeper ZW0416-hadoop-2-59:2181/kafka --create --topic test --partitions 6 --replication-factor 2

注意:其中初始创建topic 时指定分区数的大小直接影响后续性能 和集群broke 的个数有关系 一般整数倍

3、删除topic

kafka-topics --delete --zookeeper hadoop01:2181/kafka --topic CustomerContacts

注意:需要server.properties中设置delete.topic.enable=true否则只是标记删除或者直接重启。

4、通过shell命令发送消息

kafka-console-producer.sh --broker-list kafka01:9092/kafka --topic test

5、通过shell消费消息

kafka-console-consumer.sh --zookeeper hadoop01:2181/kafka --from-beginning --topic test

注意:–from-beginning 参数指定消费的策策略(是否从开始进行消费)

6、查看消费位置

kafka-run-class kafka.tools.ConsumerOffsetChecker --zookeeper zk01:2181/kafka --group testGroup

7、查看某个Topic的详情

bin/kafka-topics.sh --topic test --describe --zookeeper hadoop01:2181/kafka

8、对分区数进行修改(现在只知道分区只能增加,不建议删除分区)

kafka-topics --zookeeper zk01/kafk --alter --partitions 15 --topic utopic

9、查看当前topic的消费进度

kafka-run-class kafka.tools.ConsumerOffsetChecker --zookeeper zk01:2181 --group nt1 --topic master5

10、查看分区的情况:

bin/kafka-topics.sh --describe --zookeeper hadoop01:2181 --topic ConsumerAAAA

11、查看topic某分区偏移量最大(小)值

kafka-run-class kafka.tools.GetOffsetShell --topic t_cdr --time -1 --broker-list node1:9092 --partitions 2

kafka-run-class kafka.tools.ConsumerOffsetChecker

注: time为-1时表示最大值,time为-2时表示最小值

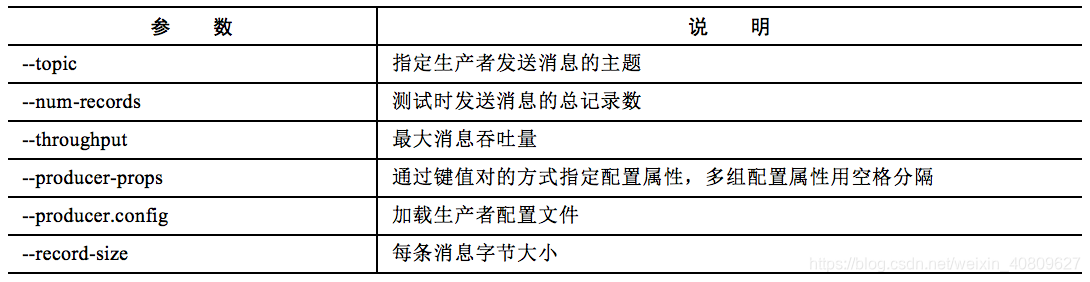

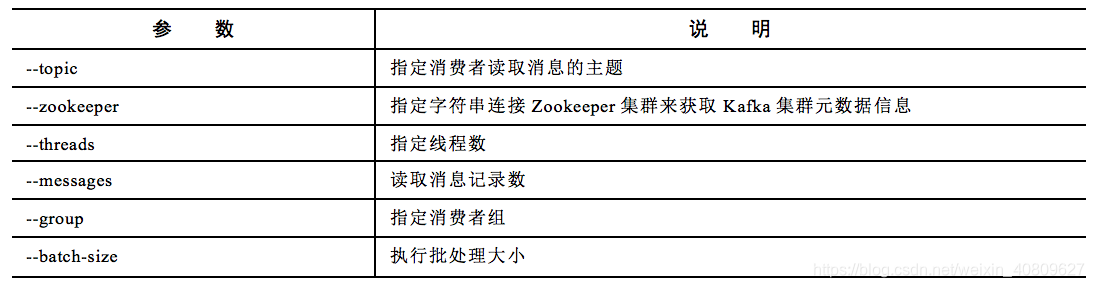

12、kafka-producer-perf-test和kafka-consumer-perf-test kafka 性能测试工具通过该工具可以对生产者性能和消费者性能进行测试,获取一组最佳的参数值,进而提升生产者的发送效率和消费者的读取效率。这里如果需要实现带有线程参数功能的工具,可以修改工具源代码。

(1)生产者测试参数

(2)、消费者测试参数

具体的事例为:

kafka-producer-perf-test --payload-file /log_center/we-schedule/192.168.1.23_catalina.out.2018-03-27 --topic we-schedule-test --throughput 100000 --num-records 100000 --producer-props bootstrap.servers=ZW0804-hadoop-89,ZW0804-hadoop-91,ZW0804-hadoop-90 acks=all --record-size 1000

kafka-producer-perf-test --payload-file /log_center/we-schedule/schedule.log --topic we-schedule-test --throughput 100000 --num-records 100000 --producer-props bootstrap.servers=ZW0804-hadoop-89,ZW0804-hadoop-91,ZW0804-hadoop-90 acks=all

kafka-producer-perf-test --payload-file /home/hdfs/flume/schedule1.log --topic log --throughput 100000 --num-records 100000 --producer-props bootstrap.servers=node1:9092,node2:9092,node3:9090

cm 中配置一分钟内 某个具体topic 收到和发出的具体数据条数:

操作步骤:

再kafka构建图表中select kafka_messages_received_1min_rate, kafka_bytes_fetched_1min_rate WHERE kafkaTopicName=“p2p-web”

733

733

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?