构建医疗AI编程可控价值观罗盘需从以下多维度进行深度融合,结合伦理、技术、社会及治理等多方面考量,确保AI系统的开发与应用符合人类价值观并具备动态适应性:

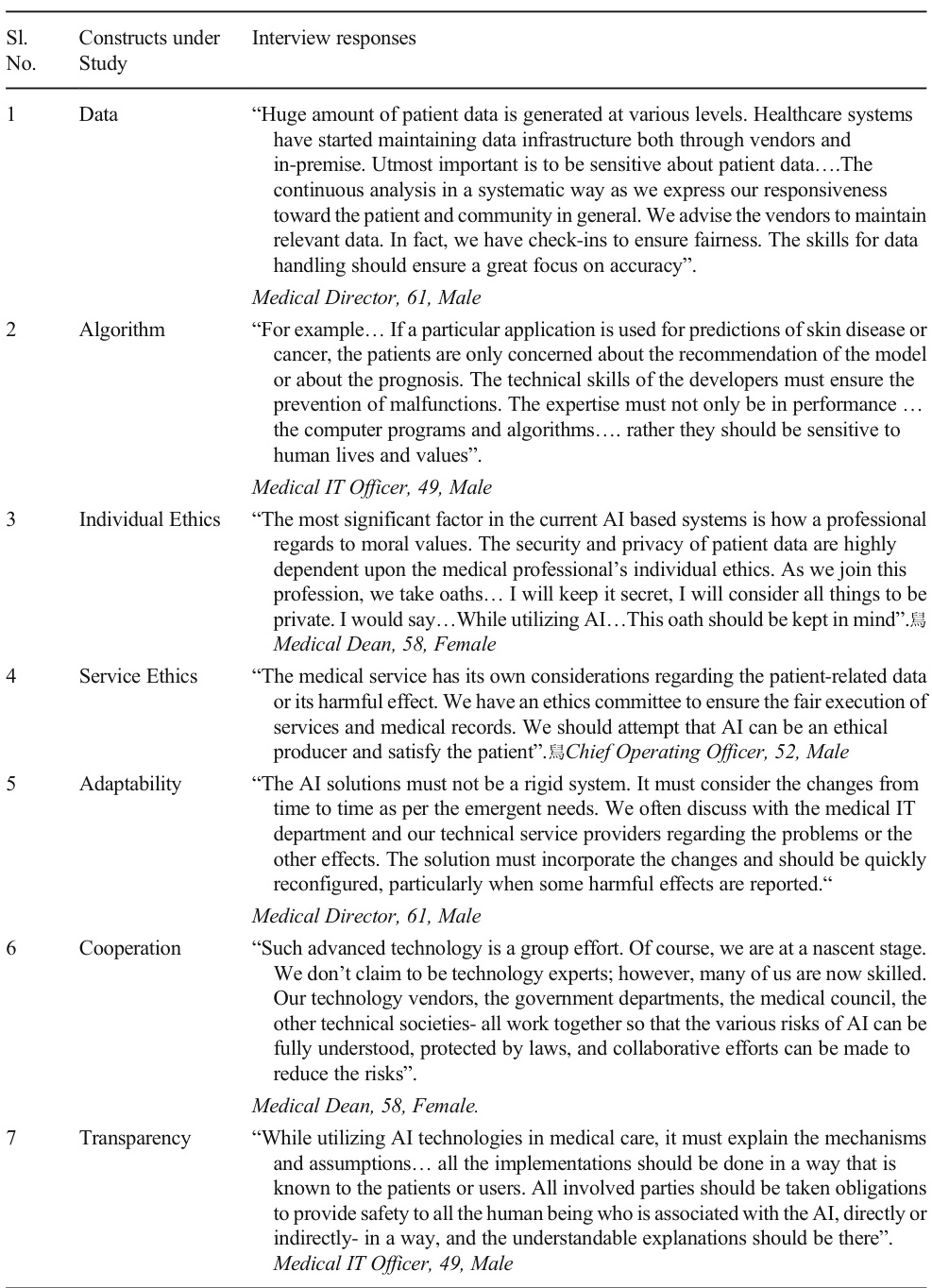

1. 伦理价值维度

-

数据隐私与安全

确保患者数据的敏感性,采用加密、去识别化技术,并建立数据保留与定期审查机制。

-

算法公正性

防止算法偏见,确保模型在种族、性别、社会经济地位等维度上的公平性,需引入对抗性训练和公平性验证。

-

透明性与可解释性

要求AI决策过程可追溯,向患者和医生提供清晰的解释逻辑,例如通过可视化工具展示诊断依据。 -

非伤害原则

设计时嵌入风险监控机制,如实时预警系统对潜在误诊或副作用进行干预。

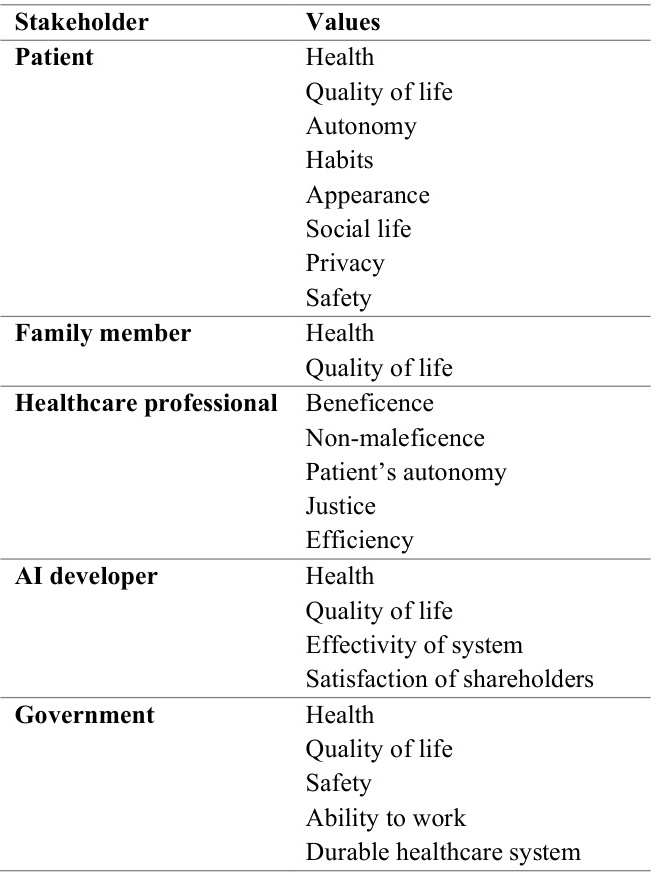

2. 患者中心化维度

- 自主权与共同决策

开发患者友好型界面,支持患者参与治疗选择,例如通过交互式问卷反映其生活目标和价值观。 - 文化敏感性

考虑患者文化背景对医疗决策的影响,如宗教信仰对治疗方式的接受度,需在模型中引入多语言和本土化适配。 - 情感支持

整合对话式AI提供心理疏导,结合情感分析技术监测患者情绪波动并调整沟通策略。

3. 技术治理维度

- 动态适应性

系统需支持实时更新,根据新出现的伦理问题(如基因编辑争议)或临床指南变化进行模型迭代。 - 多目标优化

采用算法平衡效率、成本、公平性等冲突目标,例如资源分配时结合患者生存率与社会效益。 - 可审计性

建立全生命周期监控框架,记录数据输入、模型决策及结果反馈,便于事后追溯与责任界定。

4. 协作与治理维度

- 跨学科合作

组建伦理学家、临床医生、AI开发者的联合团队,在开发初期即嵌入伦理审查流程。 - 利益相关者参与

通过设计研讨会收集患者、家属、医疗机构的多方需求,并将其转化为系统需求。 - 全球化标准对齐

参照联合国可持续发展目标(SDGs)和欧盟AI伦理准则,确保系统符合国际健康公平原则。

5. 实施与评估机制

- 伦理委员会监督

设立独立委员会审查AI应用的伦理风险,例如在临终关怀场景中评估算法建议的合理性。 - 冲突解决机制

当患者家属与AI决策冲突时,预设协商流程(如多轮讨论、第三方调解)以达成共识。 - 持续验证与改进

结合临床反馈与社区调研,定期评估AI对健康不平等的影响,并调整模型参数。

6. 社会价值融合

- 健康公平性

优先覆盖资源匮乏地区,通过移动健康技术减少城乡医疗差距,并主动识别边缘群体需求。 - 社会责任嵌入

要求开发者超越股东利益,在模型中纳入公共卫生指标(如传染病防控优先级)。 - 长期价值引导

设计AI辅助反思工具,帮助用户思考治疗与生活质量的平衡,例如临终关怀中的价值观澄清。

案例:资源分配AI的价值观罗盘实现

- 数据输入:整合患者生存概率、治疗成本、家庭支持度等多元指标。

- 算法层:使用多目标优化(如NSGA-II)平衡效率与公平&#x

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?