参数共享技术在深度学习和机器学习中具有广泛的应用,其主要目的是通过共享模型的参数来减少模型的复杂度、提高训练效率和泛化能力。以下是参数共享技术在深度学习和机器学习中的应用、优缺点及未来发展方向的详细分析:

应用

- 卷积神经网络(CNN)

参数共享在CNN中尤为重要,尤其是在卷积层中。通过共享卷积核的参数,模型可以在图像的不同位置检测相同的特征,从而显著减少参数数量并提高计算效率。这种技术使得CNN能够处理大规模数据集,并在图像识别、目标检测等任务中表现出色。 - 多任务学习(MTL)

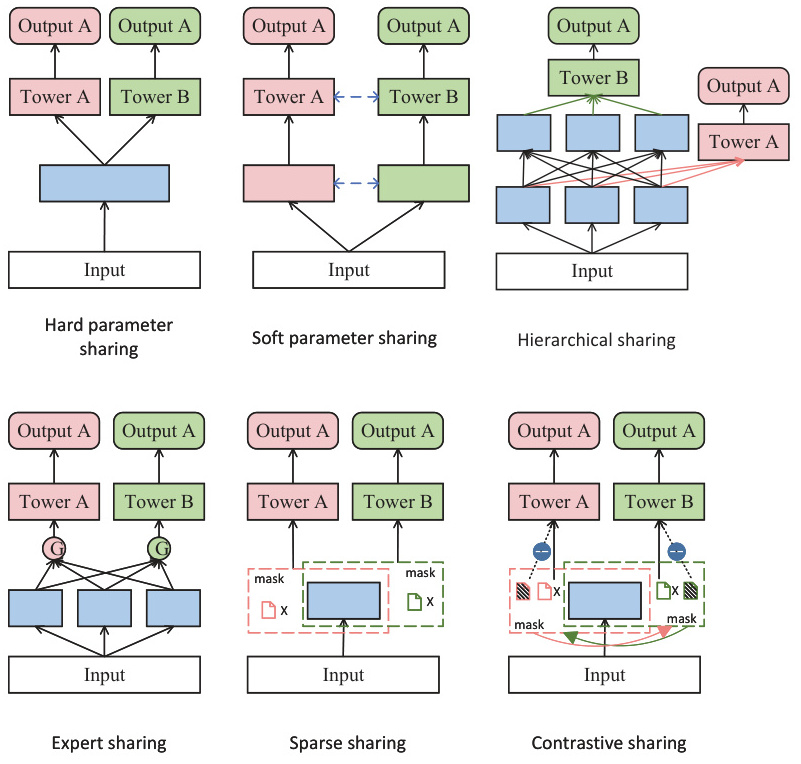

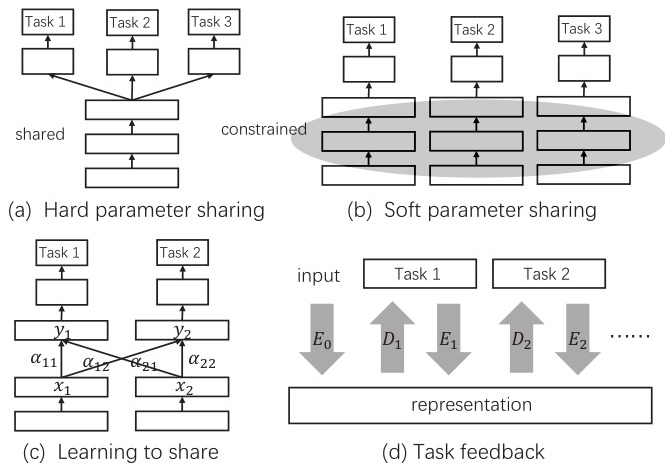

参数共享是MTL中的核心策略之一,通过共享底层参数或部分参数,多个任务可以协同学习,从而提高整体性能。硬参数共享和软参数共享是两种常见的方法。硬参数共享将所有任务的参数绑定在一起,而软参数共享则允许部分参数共享,同时保留其他参数的独立性。

- 神经架构搜索(NAS)

参数共享在NAS中用于创建可微的搜索空间,通过联合优化参数和超参数,提高搜索效率。例如,DARTS方法通过定义一个超网络实现参数共享,但可能会导致高GPU内存消耗。 - 转移学习

参数共享在转移学习中也得到广泛应用。通过加载预训练模型并共享其参数,可以在新任务上快速适应并加速训练过程。 - 时序数据处理

在循环神经网络(RNN)中,参数共享可以通过时间步共享的方式实现,使得模型能够捕捉时间序列数据中的长期依赖关系。

优点

- 减少参数数量

参数共享显著减少了模型的参数数量,从而降低了存储需求和计算资源的消耗。 - 提高训练效率

减少的参数数量意味着更少的梯度计算和更新,从而加快了模型的训练速度。 - 增强泛化能力

参数共享通过利用任务间的相似性或特征的局部性假设,增强了模型的泛化能力。 - 平移不变性

在CNN中,参数共享使得模型对输入的平移具有等变性,即输入的平移会导致输出的相应平移。

缺点

- 负迁移

在多任务学习中,硬参数共享可能导致负迁移,即一个任务的性能下降影响其他任务的表现。 - 优化困难

参数共享可能导致优化问题,例如梯度消失或梯度爆炸,特别是在深度网络中。 - 灵活性受限

参数共享可能限制模型对特定任务的适应能力,特别是在任务间存在显著差异时。

未来发展方向

- 自适应参数共享

研究者正在探索如何动态调整参数共享的程度,以平衡任务间的协同学习和独立性。例如,自适应硬参数共享方法通过设置阈值来优化网络结构,减少负迁移的影响。 - 结合其他技术

参数共享与其他技术(如稀疏连接、矩阵分解、量化等)结合使用,以进一步提高模型的效率和压缩率。 - 多模态学习

参数共享在多模态学习中的应用正在逐步增加,通过共享跨模态的特征表示,提升模型在多种数据类型上的表现。 - 自动化设计

自动化设计工具将帮助研究人员更高效地设计和优化参数共享策略,以适应不同的应用场景。

参数共享技术在深度学习和机器学习中具有重要的应用价值,尽管存在一些挑战,但其在未来的发展潜力巨大。通过不断优化和结合其他先进技术,参数共享有望在更多领域发挥更大的作用。

参数共享技术在多任务学习中通过减少模型复杂度和训练时间来提高效率,但同时也可能引入负迁移问题,即在一个任务上的改进会损害另一个任务的性能。为了减少负迁移的影响,研究者们提出了多种参数共享机制:

- 硬参数共享:在所有子任务之间共享隐藏层参数,附加特定任务层。这种方法可以使用包含在相关任务中的域信息来提升整个模型的泛化能力,但需要为每个子任务分配特定权重,并且一个单层的表示需要满足所有子任务的需求,这可能导致负担过重。

- 软参数共享:每个任务都有自己的参数和模型结构,可以选择哪些共享哪些不共享,最后通过正则化的方式拉近模型参数之间的距离,例如使用L2正则化。

- 专家参数共享:如MoE(Mixture of Experts)网络,通过门控激活实现灵活的参数共享,解决了负迁移问题。

- 稀疏参数共享:为每个任务从基网络中抽取出部分重叠的子网络,使强相关任务的子网络参数重叠率高,弱相关任务的子网络参数重叠率低。这种方法在联合训练时,相似任务倾向于更新相同参数,差异较大的任务则更新隔离参数,从而避免负迁移。

- 动态任务优先级:通过动态调整任务的优先级来提升多任务学习性能,减少不同任务之间的冲突。

- 混合专家模型:利用MoE结构实现更灵活的参数共享模式,任务特定和任务共享专家各司其职,从而缓解负迁移问题。

- 特征选择方法:如CFS和MultiSFS引入了专家或任务特定的特征选择,以减少任务间的冲突。

自适应参数共享方法的最新研究进展是什么?

自适应参数共享方法的最新研究进展主要集中在以下几个方面:

-

多任务学习中的自适应软参数共享:

- 2024年,王红霞等人提出了一种基于多任务深度学习的自适应软参数共享方法。该方法通过引入自适应软参数共享机制,能够动态调整参数共享程度,以适应不同任务的需求,从而提高模型的泛化能力和计算效率。实验结果表明,该方法在多个基准数据集上的性能优于现有方法。

-

多智能体强化学习中的部分参数共享与动态网络路由:

- 2024年,一篇论文总结了多智能体强化学习(MARL)领域中参数共享和网络路由的最新研究进展。文章探讨了适应性参数共享(AdaPS)、稀疏训练框架(MAST)、理论保证下的部分参数共享(FP3O)等创新方法,旨在提高MARL算法的性能和效率。

-

任务自适应参数共享(TAPS):

- 2023年,Ravichandran等人提出了一种任务自适应参数共享(TAPS)方法,通过自适应地修改一个小的、特定于任务的层子集来调整基本模型以适应新任务。这种方法不仅保持了高准确性,还显著减少了资源消耗,并避免了灾难性的遗忘和任务之间的竞争。

-

点击率预估中的自适应参数生成网络(APG):

- 阿里巴巴在2023年提出了一种名为APG的自适应参数生成网络,旨在优化神经网络中的参数生成,以提升点击率预测的准确性。APG通过状态向量生成适应性参数,动态捕捉不同样本的特性,并采用低秩参数化和参数共享技术,显著提高了推理性能。

-

机器学习中的表示遗忘与参数自共享:

- 2024年,悉尼科技大学的研究人员提出了一种参数自共享的结构优化方法(RFU-SS),用于同时优化遗忘和记忆目标。该方法通过动态调整遗忘和记忆目标之间的权重,减少了反学习过程中的模型准确性损失。

-

自适应任务融合网络架构(AdaTT):

- Facebook的研究人员在2023年提出了一种新的自适应多任务学习框架——AdaTT,通过残差机制和门控机制实现任务间的自适应融合,学习共享知识和特定任务知识。实验结果表明,AdaTT在公共基准和工业推荐数据集上显著优于现有基线模型。

参数共享与稀疏连接、矩阵分解、量化等技术结合的案例研究有哪些?

参数共享与稀疏连接、矩阵分解、量化等技术结合的案例研究如下:

-

稀疏共享在多任务学习中的应用:

- 研究背景:多任务学习通过联合多个任务的学习来增强模型表示和泛化能力,而参数共享是实现多任务学习的关键手段。然而,现有的硬共享、软共享和分层共享机制在处理不同相关性任务时存在局限性。

- 稀疏共享机制:复旦大学邱锡鹏团队提出了一种新的参数共享机制——稀疏共享。该机制为每个任务从基网络中抽取部分子网络,这些子网络部分重叠,以适应不同相关性任务。算法分为两阶段:首先为每个任务生成子网络,使用彩票假设中的迭代数量级剪枝方法;其次,从生成的子网络中选择表现最佳的子网络进行多任务联合训练。

- 实验结果:稀疏共享在序列标注任务上超越了单任务学习、硬共享、软共享和分层共享的效果,且所需参数量最少。此外,稀疏共享在避免负迁移方面表现出色,即使在弱相关任务组合中也能有效避免性能损失。

-

混合专家架构中的参数共享与稀疏性:

- 研究背景:在大模型研究中,混合专家(Mixture of Experts, MoE)模型是一种应用参数共享思想的例子。该模型通过将一些参数作为各个专家的共享参数,而另一些参数在激活时通过路由(router)来择优选用。

- 技术特点:混合专家模型作为一种稀疏的模型,其优势在于可训练参数较少,预训练环节的成本较低,时间也更短。由于每次推理只激活部分专家,推理效率更高。

-

卷积神经网络中的参数共享与稀疏连接:

- 研究背景:卷积神经网络(CNN)通过参数共享和稀疏连接来提高效率。参数共享允许同一特征在图像的不同区域重复使用,如垂直边缘检测,这不仅节省了计算资源,还提高了模型的泛化能力。稀疏连接则意味着输出仅依赖于输入特征的局部区域,减少了不必要的计算,提高了模型的简洁性和效率。

- 具体应用:例如,在LeNet-5、AlexNet、VGG、ResNet和Inception等经典CNN架构中,参数共享和稀疏连接被广泛应用于图像识别任务中。

-

深度学习模型优化中的参数共享与低秩分解:

- 研究背景:为了使模型在设备上高效运行,通常需要对模型进行各种优化。参数共享和低秩分解是其中两个常见的优化技术,它们能够有效地减少模型的参数量和计算量。

- 技术细节:参数共享通过在不同层之间共享部分参数,减少参数数量;低秩分解则将大规模的矩阵分解成多个低秩矩阵,从而减少计算和存储成本。这两种方法常用于卷积神经网络(CNN)和其他深度学习模型中,以实现模型的轻量化和高效运行。

在多模态学习中,参数共享技术如何提升模型对多种数据类型的表现?

在多模态学习中,参数共享技术通过在不同模态之间共享模型参数,显著提升了模型对多种数据类型的表现。以下是参数共享技术如何实现这一目标的详细解释:

- 减少参数冗余和计算资源:

在传统的多模态学习框架中,每个模态通常拥有独立的参数集,这导致了大量参数冗余和计算资源的浪费。例如,在Meta-Transformer模型中,每个模态都有自己的参数矩阵,这不仅增加了模型的复杂性,还降低了训练效率。通过参数共享,不同模态可以复用相同的参数矩阵,从而减少了参数数量和计算资源的消耗。 - 提高模型的泛化能力:

参数共享使得不同模态之间的特征可以进行交互和融合,从而提高了模型的泛化能力。例如,Meta-Transformer通过共享网络参数,实现了对多种模态信息的统一学习,无需额外训练即可处理12种不同类型的模态信息。这种跨模态的知识迁移有助于模型在不同任务和数据类型之间更好地泛化。 - 促进共同语义结构的学习:

参数共享还可以促进不同模态之间的共同语义结构(如注意力模式)的学习。例如,MS-CLIP架构通过共享参数,将不同模态的语义相似概念拉得更近,并促进了共同语义结构的学习。这种共同语义结构的建立有助于模型更好地理解和处理多模态数据。 - 提高模型效率:

通过共享参数,模型可以在保持或提升性能的同时,减少参数数量。例如,跨层参数共享技术通过在不同层之间共享参数,减少了模型的参数总量,加速了训练过程,并在有限的硬件资源下提供了更好的性能。这种策略不仅降低了模型的训练和部署成本,还促进了模型的创新和多样性。 - 避免过拟合:

共享参数可以减少模型对特定数据类型的依赖,从而避免过拟合。例如,MMOE(多模态输出融合)模型通过在相似任务之间共享参数和模式,以及在不相似任务之间独立学习,平衡了共享和不共享参数的极端情况,从而避免了过拟合和增加计算量的问题。 - 统一多模态框架:

参数共享技术还可以创建统一的多模态框架,使模型能够处理多种模态数据。例如,VLMO模型使用参数共享的方式,创建了统一的多模态框架,实现了对多种模态数据的有效处理。这种统一框架不仅简化了模型设计,还提高了模型在多模态任务中的表现。

自动化设计工具在参数共享策略优化中的应用案例有哪些?

根据提供的信息,无法回答问题“自动化设计工具在参数共享策略优化中的应用案例有哪些?”。

虽然有多个证据提到自动化设计工具和参数共享的概念,但没有具体提到任何实际的应用案例。例如, 提到了使用 Scipy.Optimize 中的 CURVE_FIT 进行共享参数优化,但没有提供具体的应用案例。 和 分别讨论了 AutoML 系统设计和 Transformer 模型中的参数共享,但也没有提到具体的自动化设计工具应用案例。

719

719

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?