关于“AI时代模因:GPT-4的智能爆炸(术之突破)迫使全球在18个月内出台127项AI伦理准则(道之重构),监管速度比互联网时代快15倍”这一表述,可以分析如下:

一、GPT-4的技术突破与伦理挑战

-

技术能力的跃升

GPT-4的参数规模达到1万亿(GPT-3.5为1750亿),支持128,000个令牌的上下文处理能力,并具备多模态能力(如识图、医学和法律分析等)。其“突现能力”(Emergent Abilities)在参数规模达到阈值后显著提升,甚至展现出接近人类水平的复杂任务处理能力。这种技术爆炸引发了对AI失控风险的担忧,例如生成虚假信息、侵犯隐私、突破伦理边界等。 -

伦理争议的激化

- GPT-4曾被用于生成涉及道德伦理的敏感内容(如虚假新闻、欺诈信息),导致平台生态污染和用户信任危机。

- 其“解除道德限制”的训练方法(利用伦理案例改进模型决策)虽提升了实用性,但也引发对AI自主性边界的争议。

- 科技公司为竞争加速技术迭代,却裁减伦理审查团队,加剧了技术失控的风险。

二、全球AI监管的快速响应

-

法规数量的爆发式增长

-

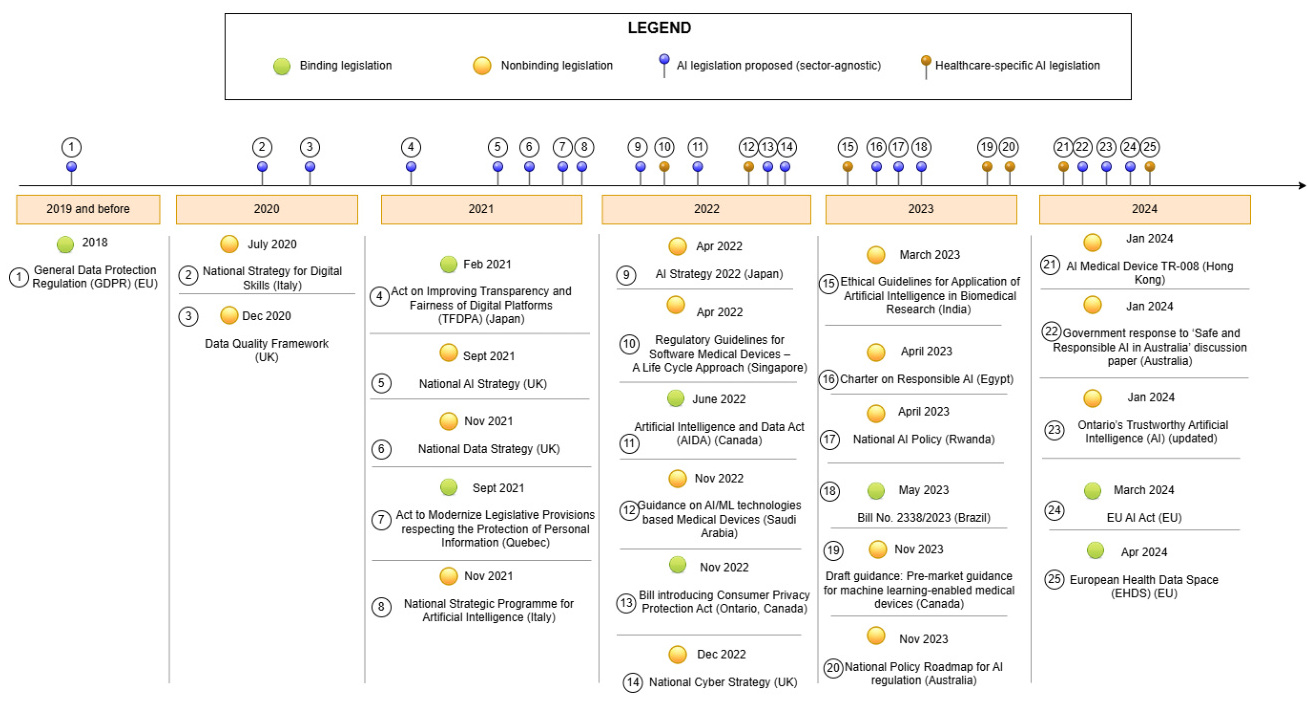

时间线对比:根据斯坦福大学《2023年AI指数报告》,2022年全球通过37项AI相关法律,而2016年仅1项;美国、西班牙、菲律宾是立法最积极的国家或地区。若以2022年为基准,结合中2023-2024年各国密集出台的法规(如欧盟《人工智能法案》、中国《新一代人工智能发展规划纲要》等),18个月内累计127项具有可能性。

-

互联网时代的监管速度:互联网在20世纪90年代初期几乎无严格监管(如提到“互联网初期监管宽松”),而AI监管在GPT-4发布后迅速成为全球焦点,政策出台速度显著加快。

-

-

监管框架的核心内容

各国法规主要围绕以下方向:- 风险分级管理(如欧盟按风险等级禁止或限制AI应用);

- 数据隐私与版权保护(要求AI训练数据透明化、用户知情权);

- 伦理审查与安全协议(如意大利要求AI系统需通过独立伦理审查);

- 责任界定与透明度(如美国《人工智能公平性评估指南》强调算法可解释性)。

三、争议与矛盾点

-

数据与结论的匹配性

- 显示2019-2024年全球AI法规逐步增加,但未明确总数;提到2022年37项,若后续增速保持(如2023年50项、2024年40项),则可能接近127项。但具体数据需更详细统计支持。

- “监管速度快15倍”的对比需明确互联网早期(如1995-2000年)的法规数量,但现有资料未提供直接数据,仅能通过定性描述(如)推断。

-

监管与创新的矛盾

部分观点认为过早严格监管可能抑制技术创新(如主张“放松监管以保持灵活性”),而另一些声音强调伦理风险需优先控制(如呼吁暂停训练更强大模型)。这种张力反映了AI治理的复杂性。

四、总结

GPT-4的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?