在大数据领域,Hadoop已成为处理和存储海量数据的主要框架。作为一个分布式系统,Hadoop需要在多台机器上协调工作,以确保数据的高效处理和存储。因此,监控Hadoop集群的性能和健康状况至关重要。通过监控关键指标,管理员可以及时发现和解决问题,确保系统的稳定运行。本文将深入探讨Hadoop的重要监控指标,详细介绍每个指标的意义、监控方法及其在实际操作中的应用。

1.概述

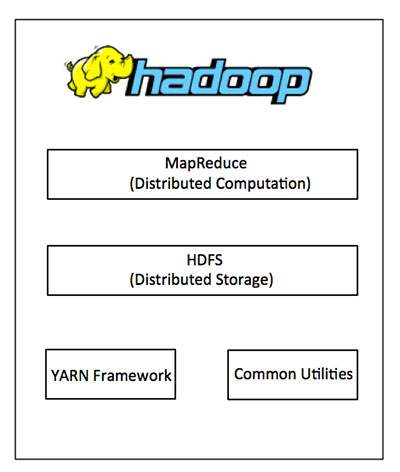

Hadoop是一个开源的大数据处理框架,主要由HDFS(Hadoop分布式文件系统)和MapReduce计算引擎组成。在Hadoop集群中,有多个节点协同工作,这使得集群的监控变得尤为重要。通过监控集群中的关键指标,管理员可以及时发现和解决性能瓶颈、故障节点和其他潜在问题,确保系统的高效稳定运行。

2. Hadoop的重要监控指标

2.1 HDFS监控指标

2.1.1 NameNode指标

NameNode是HDFS的核心组件,负责管理文件系统的元数据。监控NameNode的健康状况对于确保HDFS的正常运行至关重要。

- Heap Memory Usage:NameNode的堆内存使用情况,反映了NameNode的内存消耗。过高的内存使用可能导致垃圾回收频繁,从而影响性能。

- Live Nodes:集群中正常工作的DataNode数量。如果数量突然下降,可能表示有DataNode失效或网络问题。

- Dead Nodes:集群中失效的DataNode数量。持续增加的Dead Nodes数量需要引起注意,可能需要检查网络连接、硬件故障等问题。

- Under-Replicated Blocks:副本数量低于设定值的块数量。过多的Under-Replicated Blocks可能影响数据的可靠性和可用性。

2.1.2 DataNode指标

DataNode负责存储实际的数据块,其健康状况直接影响HDFS的存储性能和可靠性。

- Disk Usage:DataNode磁盘使用情况。监控磁盘使用率可以防止磁盘空间耗尽,从而影响数据存储和写入操作。

- Block Reports:DataNode定期向NameNode发送的块报告,反映了DataNode上的数据块状态。监控Block Reports的频率和延迟可以帮助检测DataNode与NameNode之间的通信问题。

- Xceiver Count:DataNode上正在处理的请求数量。过高的Xceiver Count可能表示DataNode负载过重,需要进行负载均衡。

2.2 MapReduce监控指标

2.2.1 JobTracker指标

JobTracker负责管理MapReduce作业的调度和执行,其性能直接影响作业的执行效率。

- Running Jobs:当前正在运行的作业数量。监控Running Jobs的数量可以帮助管理员了解集群的负载情况。

- Running Tasks:当前正在执行的任务数量。过高的Running Tasks数量可能表示任务分配不均或资源不足。

- Failed Tasks:失败的任务数量。持续增加的Failed Tasks数量需要引起注意,可能表示作业配置不当或资源不足。

2.2.2 TaskTracker指标

TaskTracker负责执行Map和Reduce任务,其健康状况直接影响任务的执行效率。

- Map Tasks:正在执行的Map任务数量。监控Map Tasks的数量可以帮助管理员了解Map任务的执行情况。

- Reduce Tasks:正在执行的Reduce任务数量。监控Reduce Tasks的数量可以帮助管理员了解Reduce任务的执行情况。

- Task Failures:任务失败的数量。持续增加的Task Failures数量需要引起注意,可能表示任务配置不当或资源不足。

2.3 YARN监控指标

YARN(Yet Another Resource Negotiator)是Hadoop的新一代资源管理框架,负责集群资源的调度和管理。

2.3.1 ResourceManager指标

ResourceManager负责管理集群资源,其性能直接影响资源的分配和调度。

- Cluster Metrics:集群的整体资源使用情况,包括总内存、总CPU、已分配内存、已分配CPU等。

- Application Metrics:当前正在运行和已完成的应用程序数量。监控应用程序的数量可以帮助管理员了解集群的负载情况。

2.3.2 NodeManager指标

NodeManager负责管理单个节点上的资源,其健康状况直接影响节点上任务的执行效率。

- Node Metrics:节点的资源使用情况,包括已分配内存、已分配CPU等。

2.4 集群健康状况监控

除了上述具体指标外,集群的整体健康状况也是监控的重点。以下是一些关键的集群健康状况监控指标:

- Job Completion Rate:作业的完成率,反映了集群的整体运行效率。

- Task Latency:任务的延迟时间,反映了任务的执行效率。

- System Uptime:系统的运行时间,反映了系统的稳定性。

3. 监控工具和方法

3.1 Ganglia

Ganglia是一种分布式监控系统,广泛应用于Hadoop集群的监控。它可以收集和展示集群中各个节点的性能数据,包括CPU、内存、磁盘和网络等指标。

3.2 Nagios

Nagios是一种开源的监控工具,可以用于监控Hadoop集群的运行状况。通过设置监控插件,Nagios可以实时监控Hadoop集群的关键指标,并在发现异常时发送警报。

3.3 Ambari

Ambari是Hortonworks推出的一款开源的Hadoop管理工具,提供了集群安装、配置、管理和监控的功能。Ambari可以实时监控Hadoop集群的关键指标,并提供图形化的展示和警报功能。

4. 实践中的监控策略

在实际操作中,管理员需要根据具体的业务需求和集群规模,制定合理的监控策略。以下是一些实践中的监控策略建议:

- 设置合理的警报阈值:根据集群的实际运行情况,设置合理的警报阈值,避免频繁的误报和漏报。

- 定期检查和优化:定期检查监控指标和系统日志,及时发现和解决问题。同时,定期优化集群配置,提高系统性能。

- 使用多种监控工具:结合使用多种监控工具,全面监控集群的运行状况,提高监控的覆盖范围和准确性。

5. 结论

Hadoop作为一种广泛应用的大数据处理框架,其性能和稳定性对于企业的数据处理和存储至关重要。通过监控关键指标,管理员可以及时发现和解决系统中的问题,确保Hadoop集群的高效稳定运行。本文详细介绍了Hadoop的重要监控指标及其监控方法,希望能为企业的Hadoop集群管理提供有价值的参考。

996

996

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?